La carrera por liderar la nueva generación de modelos de lenguaje no se mide ya solo en precisión, sino también en eficiencia, coste y capacidad de contexto. En este terreno, xAI ha lanzado Grok 4 Fast, una versión optimizada de su serie Grok 4 que combina una ventana de contexto monumental de 2 millones de tokens, velocidad de inferencia, y eficiencia en coste por token.

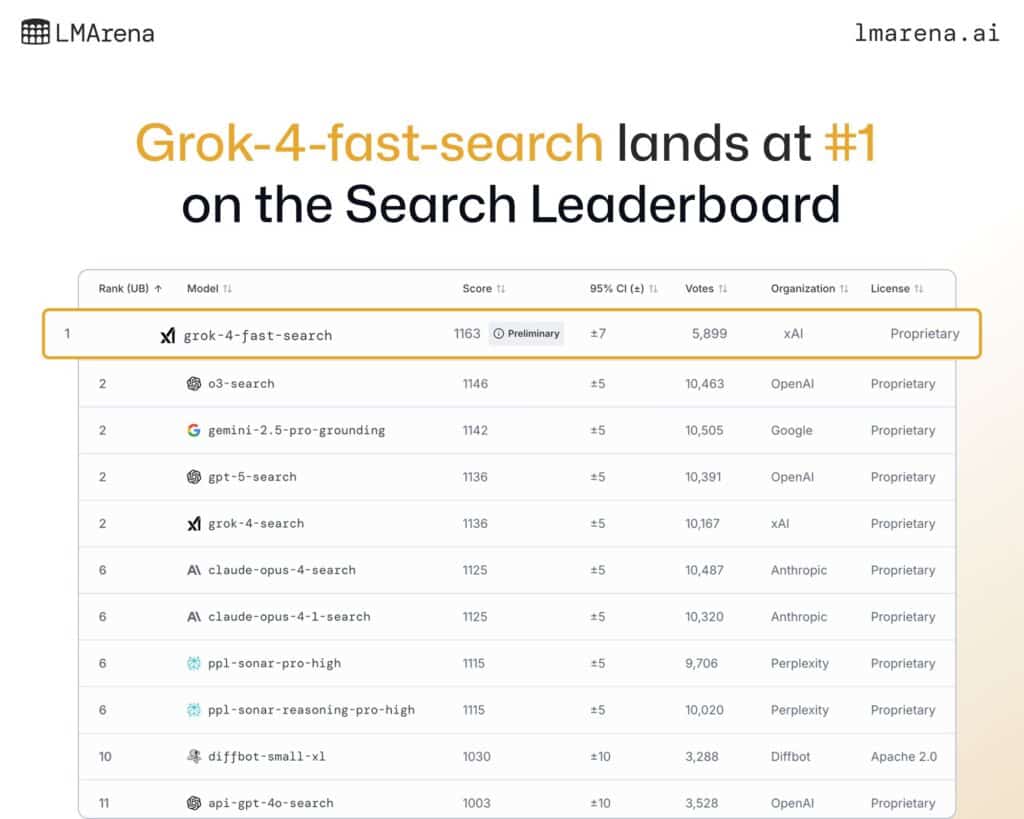

En pruebas públicas y benchmarks comunitarios como LMArena, Grok 4 Fast ya ha mostrado credenciales: #1 en el Search Leaderboard y Top 10 en Text Arena, superando a rivales de peso como OpenAI y Anthropic en tareas clave.

Un modelo pensado para hacer más con menos

- Token efficiency: Grok 4 Fast logra rendimientos similares a Grok 4 consumiendo 40 % menos “thinking tokens”, lo que se traduce en un 98 % de reducción de coste en benchmarks de frontera.

- Contexto masivo: hasta 2M de tokens en una sola consulta, lo que le permite procesar manuales, bases documentales enteras o libros completos como Moby Dick sin pérdida de coherencia.

- Velocidad: optimizado para responder rápido en consultas simples y desplegar razonamiento detallado en casos complejos, gracias a su arquitectura unificada.

Benchmarks clave

En pruebas académicas y de razonamiento:

- AIME 2025 (no tools): Grok 4 Fast = 92 %, comparable a GPT-5 High (94,6 %) y superior a Claude Opus-4 (≈ 91 %).

- HMMT 2025: Grok 4 Fast = 93,3 %, empatando con GPT-5 High y superando a Claude.

- GPQA Diamond: Grok 4 Fast = 85,7 %, en línea con GPT-5 High y Grok 4.

En búsqueda y navegación, Grok 4 Fast sobresale en:

- BrowseComp (zh): 51,2 %, superando a GPT-5 Search y Claude.

- X Bench Deepsearch (zh): 74 %, frente a 66 % de Grok 4 y 27 % de modelos previos.

Comparativa con GPT-5 y Claude Opus

| Característica | Grok 4 Fast (xAI) | GPT-5 High (OpenAI) | Claude Opus 4 (Anthropic) |

|---|---|---|---|

| Ventana de contexto | 2M tokens | 1M tokens (ext.) | 1M tokens (con extensión) |

| Velocidad de inferencia | Muy alta (optimizado “fast”) | Alta, pero más costoso | Alta, con enfoque en seguridad |

| Eficiencia de tokens | 40 % menos thinking tokens vs Grok 4 | Alto consumo | Moderado-alto |

| Coste relativo | Hasta 98 % menos que Grok 4 para mismo rendimiento | Premium, $ por millón tokens más alto | Premium, centrado en confianza y uso empresarial |

| Benchmarks matemáticos | 92–93 % (AIME, HMMT) | 94–95 % (AIME, HMMT) | 91–92 % (AIME, HMMT) |

| Búsqueda y navegación | Frontier agentic search (web + X) | Sólido, pero menos optimizado en búsquedas multihop | Limitado en navegación activa |

| Arquitectura | Unificada (razonamiento y no razonamiento en un mismo modelo) | Múltiples variantes (GPT-5, GPT-5 Mini) | Variantes Opus, Sonnet, Haiku |

| Posicionamiento en LMArena | #1 en Search, #8 en Text | Top 3 en Search/Text | Top 5–10 en Search/Text |

Contexto de mercado

- OpenAI (GPT-5): mantiene liderazgo en precisión bruta y ecosistema de herramientas, pero con costes más altos y sin llegar aún a los 2M tokens de contexto.

- Anthropic (Claude Opus): destaca en fiabilidad, alineamiento y contexto ampliado, con fuerte adopción en entornos corporativos, pero menor desempeño en búsquedas complejas.

- xAI (Grok 4 Fast): se posiciona como el modelo “fast & efficient”, ideal para aplicaciones de búsqueda, análisis documental masivo y entornos donde la velocidad y el coste importan tanto como la precisión.

Conclusión

Con Grok 4 Fast, xAI demuestra que se puede competir al máximo nivel sin necesidad de modelos más lentos y costosos. Su ventana de 2M tokens, unida a la eficiencia en coste y velocidad, lo convierten en un candidato ideal para:

- Empresas que necesitan analizar grandes corpus de información.

- Usuarios finales que buscan velocidad en consultas y razonamiento avanzado en tareas complejas.

- Aplicaciones de búsqueda en tiempo real, donde ya se coronó como #1 en LMArena.

En el nuevo mapa de la IA, GPT-5 lidera en precisión, Claude Opus en seguridad y alineamiento, pero Grok 4 Fast brilla en eficiencia y contexto, abriendo la puerta a una democratización real de modelos de frontera.

Preguntas frecuentes (FAQ)

¿Qué significa que Grok 4 Fast tenga 2M de tokens de contexto?

Que puede procesar hasta dos millones de tokens en una sola entrada, lo que equivale a miles de páginas de texto sin cortes ni fragmentación.

¿Es más preciso que GPT-5 o Claude?

En precisión bruta, GPT-5 sigue ligeramente por delante. Sin embargo, Grok 4 Fast logra resultados similares con mucho menos coste y más velocidad.

¿Dónde ha destacado especialmente Grok 4 Fast?

En benchmarks de búsqueda y navegación (Search Arena de LMArena), donde superó a OpenAI y Google, y en razonamiento matemático, donde iguala a GPT-5.

¿Qué modelo conviene más: GPT-5, Claude Opus o Grok 4 Fast?

Depende del caso: GPT-5 si se busca máxima precisión, Claude si se prioriza alineamiento y confianza, Grok 4 Fast si se necesita velocidad, contexto masivo y costes bajos.

Más información: Nota de prensa de xAI.