La nueva generación de modelos de inteligencia artificial más avanzados ya tiene una arquitectura clara favorita: Mixture of Experts (MoE). Y NVIDIA quiere ser el motor sobre el que se ejecuten. Su sistema GB200 NVL72, un diseño a escala de rack pensado para IA generativa masiva, está logrando hasta 10 veces más rendimiento en inferencia para modelos MoE punteros como Kimi K2 Thinking, DeepSeek-R1 o Mistral Large 3 frente a la generación anterior H200, cambiando la economía de la IA en los grandes centros de datos.

Qué aporta realmente la arquitectura Mixture of Experts

Durante años, la industria siguió una lógica sencilla: para tener modelos más inteligentes, había que hacerlos más grandes. Modelos densos con cientos de miles de millones de parámetros que se activan al completo en cada token generado. El resultado: una capacidad enorme… y un coste computacional y energético difícilmente sostenible.

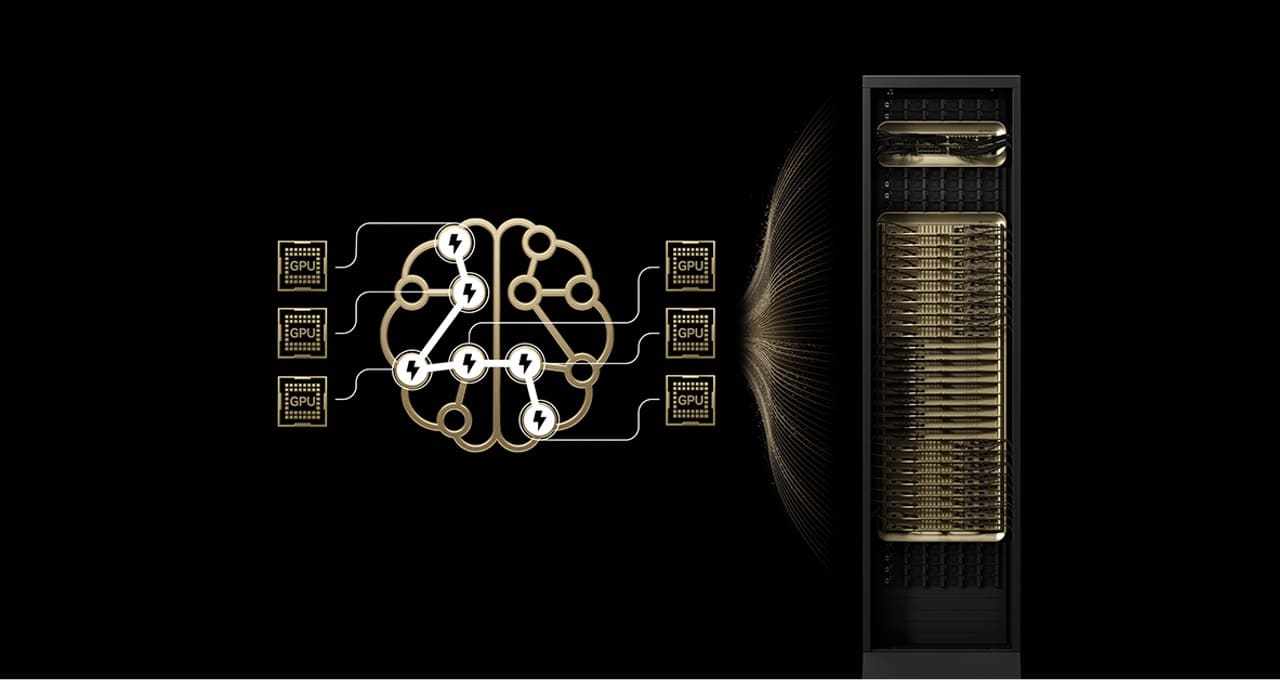

Los modelos Mixture of Experts rompen este esquema. En lugar de activar todo el modelo, organizan la red en “expertos” especializados. Un router decide qué subconjunto de expertos se activa para cada token, de forma similar a cómo el cerebro utiliza distintas áreas según la tarea que tiene que resolver.

Esto permite combinar una cifra total de parámetros descomunal con un número de parámetros activos por token mucho más reducido. La consecuencia práctica es clara: más inteligencia y capacidad de razonamiento con un coste por token muy inferior y una eficiencia energética muy superior.

No es una anécdota: en el ranking de Artificial Analysis, los 10 modelos abiertos más avanzados —incluyendo DeepSeek-R1, Kimi K2 Thinking o Mistral Large 3— utilizan arquitecturas MoE, un indicador de que este enfoque se ha convertido en estándar de facto para los modelos “frontera”.

El problema: escalar MoE en producción no es trivial

El lado menos visible es que estos modelos son muy difíciles de llevar a producción a gran escala. Los cuellos de botella principales son conocidos:

- Limitaciones de memoria: cada token obliga a cargar dinámicamente parámetros de los expertos seleccionados en memoria HBM, presionando al máximo el ancho de banda de cada GPU.

- Comunicación all-to-all: los expertos, repartidos entre muchas GPU, deben intercambiar información en milisegundos para generar una única respuesta coherente. Cuando la comunicación se hace por red de propósito general, la latencia se dispara.

En plataformas como NVIDIA H200, llevar el paralelismo de expertos más allá de 8 GPU obliga a salir a redes de interconexión externas, con más latencia y menor rendimiento global. Ahí es donde entra la propuesta de NVIDIA con GB200 NVL72.

GB200 NVL72: 72 GPU Blackwell como si fueran una sola

GB200 NVL72 es un sistema a escala de rack que agrupa 72 GPU NVIDIA Blackwell conectadas mediante NVLink Switch en un único dominio de interconexión de alta velocidad, con 1,4 exaflops de rendimiento de IA y 30 TB de memoria compartida de alta velocidad.

En la práctica, para los modelos MoE esto significa:

- Menos expertos por GPU: al poder repartirlos entre 72 GPU, la presión sobre la memoria de cada acelerador se reduce drásticamente y se libera capacidad para manejar más usuarios concurrentes y contextos más largos.

- Comunicación ultrarrápida entre expertos: la interconexión NVLink ofrece un tejido de hasta 130 TB/s dentro del rack, de forma que los intercambios all-to-all entre expertos se hacen sin salir a redes de mayor latencia.

- Cálculo dentro del propio switch: NVLink Switch puede realizar operaciones de reducción y agregación en red, acelerando la combinación de resultados de los distintos expertos.

Sobre esta base de hardware, NVIDIA añade una capa de optimización de pila completa: el formato NVFP4 para mantener la precisión con menor coste, el orquestador NVIDIA Dynamo para separar fases de prefill y decode, y el soporte nativo en marcos abiertos de inferencia como TensorRT-LLM, SGLang o vLLM, que ya implementan estas técnicas específicas para MoE.

10x más rendimiento para modelos frontera como Kimi K2 y Mistral Large 3

El impacto es medible. Según datos de la propia compañía y análisis externos, modelos MoE como Kimi K2 Thinking, DeepSeek-R1 o Mistral Large 3 logran hasta 10 veces más rendimiento al ejecutarse sobre GB200 NVL72 frente a sistemas H200 de la generación previa.

Ese salto 10x no es solo un número de laboratorio: se traduce en:

- Mucho más throughput de tokens por segundo con la misma potencia eléctrica.

- Reducción del coste por token, que mejora de forma directa la rentabilidad de los servicios de IA.

- Menor latencia, clave para aplicaciones interactivas, asistentes conversacionales o agentes que encadenan múltiples llamadas al modelo.

Proveedores de servicios de IA y nubes especializadas como CoreWeave, Together AI o grandes tecnológicas están empezando a incorporar el diseño a escala de rack GB200 NVL72 precisamente para este tipo de cargas, desde traducción avanzada (caso de DeepL) hasta plataformas de agentes inteligentes para empresas.

Más allá del MoE: hacia fábricas de IA con expertos compartidos

Aunque GB200 NVL72 se ha presentado como el sistema de referencia para MoE, el enfoque encaja con la dirección general de la IA moderna:

- Los modelos multimodales combinan expertos para texto, visión, audio o vídeo, activando solo los necesarios según la tarea.

- Los sistemas agentic coordinan múltiples agentes especializados (planificación, búsqueda, herramientas externas, memoria a largo plazo), que colaboran para resolver problemas complejos.

En ambos casos, la idea central es la misma que en MoE: disponer de un conjunto de capacidades especializadas y enrutar cada parte del problema hacia el “experto” adecuado.

Con infraestructuras a escala de rack como GB200 NVL72, los proveedores pueden ir un paso más allá: construir auténticas “fábricas de IA” en las que un gran pool de expertos compartidos atienda simultáneamente a muchas aplicaciones y clientes, maximizando la utilización del hardware y reduciendo el coste unitario de cada tarea de IA.

Preguntas frecuentes sobre MoE y NVIDIA GB200 NVL72

¿En qué se diferencia un modelo Mixture of Experts de un modelo denso tradicional?

En un modelo denso, todos los parámetros se activan para cada token que se genera. En un modelo Mixture of Experts, el modelo se divide en múltiples “expertos” y solo se activan unos pocos para cada token, seleccionados por un router. Esto permite combinar una enorme capacidad total (cientos de miles de millones o incluso billones de parámetros) con un coste computacional por token mucho más bajo.

¿Qué aporta exactamente GB200 NVL72 frente a generaciones anteriores como H200?

GB200 NVL72 agrupa 72 GPU Blackwell en un único dominio de alta velocidad con NVLink, ofreciendo 1,4 exaflops de potencia y 30 TB de memoria compartida. Esto elimina cuellos de botella clásicos en MoE (memoria y comunicación all-to-all), permitiendo repartir expertos entre muchas GPU sin penalización de latencia y logrando hasta 10x más rendimiento en inferencia para modelos como Kimi K2 Thinking, DeepSeek-R1 o Mistral Large 3.

¿Qué tipo de organizaciones se beneficiarán más de esta combinación MoE + GB200 NVL72?

Principalmente grandes proveedores de nube, plataformas de IA como servicio, empresas que entrenan y sirven modelos frontera y organizaciones que desarrollan asistentes avanzados, agentes autónomos o servicios multimodales con altos volúmenes de tráfico. Para estos actores, reducir el coste por token y la energía consumida por cada petición es crítico para que los modelos de última generación sean económicamente viables.

¿Sustituirá MoE por completo a los modelos densos?

No necesariamente. Los modelos densos siguen siendo útiles en entornos con restricciones de memoria, en dispositivos de borde o para tareas especializadas. Sin embargo, para grandes modelos frontera que exigen mucha capacidad de razonamiento y deben servir a millones de usuarios, el enfoque Mixture of Experts combinado con infraestructuras como GB200 NVL72 está ganando terreno como opción más eficiente y escalable.