Intel ha dado un paso clave en su estrategia para posicionarse en el mercado de la inteligencia artificial empresarial con el lanzamiento de LLM Scaler v1.0, la primera gran actualización de software para Project Battlematrix. La nueva versión promete mejoras de rendimiento de hasta un 80 %, optimizaciones específicas para modelos de lenguaje de gran tamaño (LLMs), soporte ampliado para IA multimodal y nuevas herramientas de gestión empresarial.

Un proyecto que avanza según la hoja de ruta

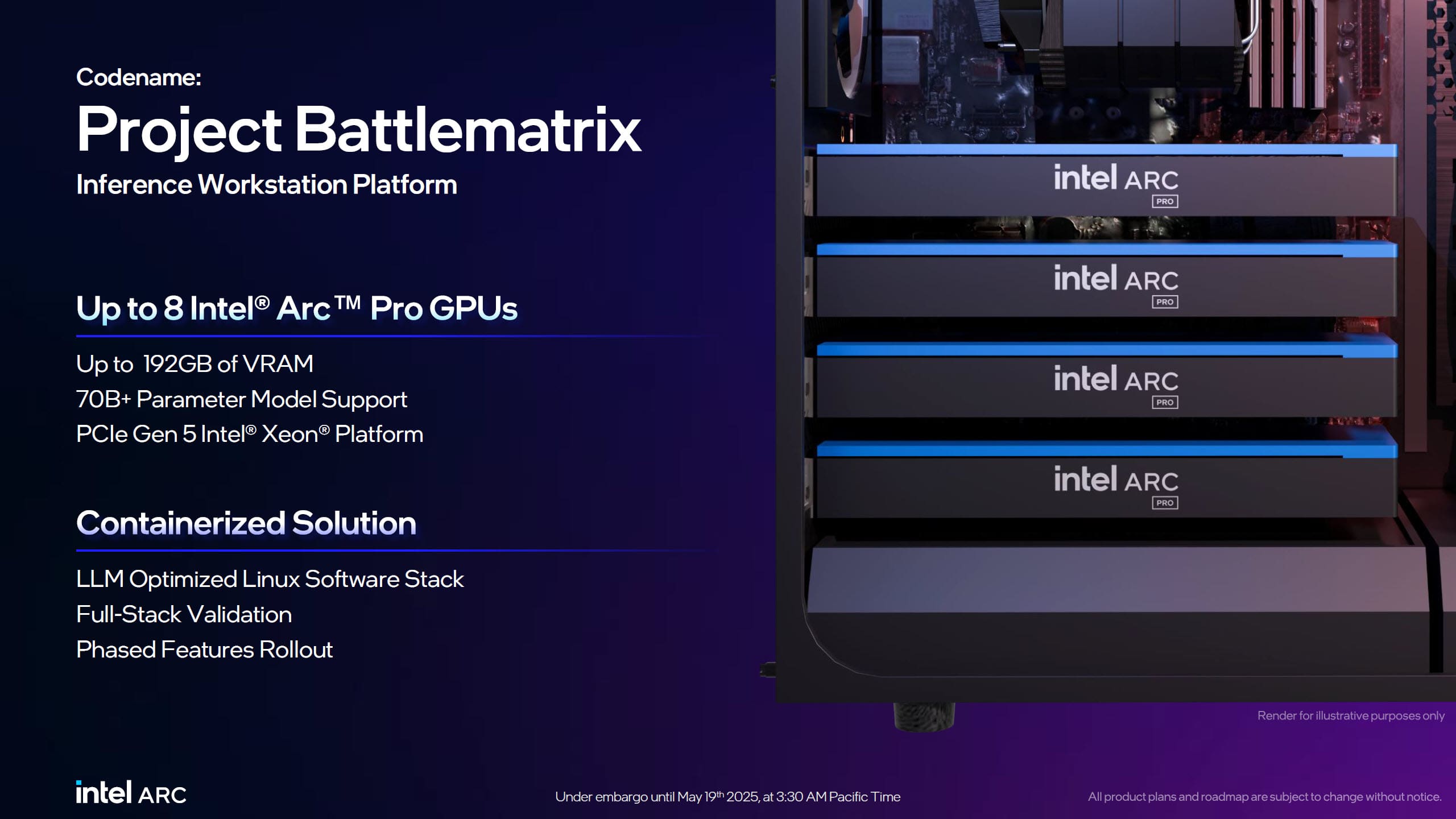

Presentado en Computex 2025, Project Battlematrix fue concebido como una solución integral para la inferencia de IA en estaciones de trabajo y entornos multi-GPU basados en Intel Arc Pro. Intel se comprometió a lanzar en el tercer trimestre un contenedor “Inference Optimized” con soporte para vLLM, telemetría básica y gestión simplificada.

Con LLM Scaler v1.0, ese hito se ha cumplido, incorporando:

- Escalado multi-GPU optimizado para entornos de inferencia exigentes.

- Transferencias PCIe P2P que reducen latencias y mejoran la eficiencia.

- Funciones de fiabilidad empresarial como ECC, SR-IOV, telemetría avanzada y actualizaciones de firmware remotas.

Principales mejoras de LLM Scaler v1.0

El nuevo contenedor, optimizado para Linux y compatible con estándares de la industria, integra avances significativos en rendimiento y gestión:

Optimización de vLLM

- TPOP acelerado para secuencias largas (>4K), con hasta 1,8x más rendimiento en modelos KPI de 32B y hasta 4,2x en modelos de 70B (40K tokens).

- +10 % de rendimiento en modelos de 8B a 32B frente a la versión anterior.

- Cuantización por capa en línea, reduciendo drásticamente el consumo de memoria de GPU.

- Soporte experimental para pipeline parallelism (PP), torch.compile y decodificación especulativa.

- Compatibilidad con modelos de embedding y reranking.

- Soporte ampliado para modelos multimodales.

- Detección automática de longitud máxima y paralelismo de datos.

XPU Manager

- Monitorización en tiempo real del consumo energético de GPU.

- Actualizaciones de firmware de GPU directamente desde el entorno de gestión.

- Diagnósticos avanzados y pruebas de ancho de banda de memoria.

Herramientas de benchmarking

- OneCCL benchmark tool para pruebas de rendimiento en entornos distribuidos y multi-GPU.

Impacto en rendimiento: salto competitivo para la IA corporativa

Intel asegura que LLM Scaler v1.0 ofrece hasta un 80 % de mejora de rendimiento gracias a la optimización en el escalado multi-GPU y a las mejoras en la transferencia de datos entre dispositivos. Esto convierte a Project Battlematrix en una alternativa viable y competitiva para cargas de trabajo con LLMs de gran escala, especialmente en entornos empresariales donde el coste y el consumo energético son factores críticos.

Lo que viene: despliegue progresivo en 2025

La hoja de ruta de Intel para Project Battlematrix marca tres fases:

- Q3 2025 — Contenedor “Inference Optimized” (ya disponible con LLM Scaler v1.0).

- Finales de Q3 2025 — Versión más robusta, con mejoras adicionales en rendimiento y servicio de vLLM.

- Q4 2025 — Lanzamiento de la versión completa con todas las funcionalidades previstas.

Intel frente a NVIDIA y AMD en la carrera por la inferencia

Con este lanzamiento, Intel busca competir directamente con los ecosistemas de NVIDIA y AMD, ofreciendo una alternativa más asequible para entornos de inferencia profesional que no requieren el coste de GPUs de centro de datos como las NVIDIA H100 o las AMD Instinct MI300.

La propuesta se dirige a:

- Centros de datos corporativos con limitaciones de espacio y energía.

- Laboratorios de investigación que desarrollan y afinan modelos de IA.

- Estaciones de trabajo de alto rendimiento para ingeniería, ciencia de datos y diseño.

Enfoque empresarial y visión de futuro

Más allá del rendimiento, Project Battlematrix integra herramientas de gestión y monitorización que permiten a los departamentos de TI mantener un control granular sobre la infraestructura de IA. Esto incluye la gestión remota, actualizaciones seguras y la optimización de recursos para maximizar el retorno de inversión en hardware.

Intel pretende posicionar LLM Scaler como el núcleo de un ecosistema abierto que permita escalar soluciones de IA de forma modular, desde una estación de trabajo hasta implementaciones distribuidas en clústeres empresariales.

Preguntas frecuentes (FAQs)

1. ¿Qué es Project Battlematrix?

Es la plataforma de Intel para optimizar la inferencia de modelos de IA en entornos multi-GPU con Arc Pro, pensada para uso empresarial y científico.

2. ¿Qué mejoras incluye LLM Scaler v1.0?

Aumenta el rendimiento hasta un 80 %, optimiza el uso de memoria, mejora el soporte para IA multimodal y añade nuevas técnicas experimentales de paralelismo y decodificación.

3. ¿Dónde puedo descargarlo?

Está disponible en el repositorio oficial de Intel en GitHub: LLM Scaler v1.0.

4. ¿Es una alternativa a NVIDIA y AMD?

Sí, busca competir en el segmento profesional ofreciendo un mejor equilibrio entre coste, eficiencia energética y capacidades de gestión.