Google Cloud ha presentado Ironwood, su séptima generación de TPUs, junto con nuevas instancias Axion basadas en ARM Neoverse —N4A (en vista previa) y C4A metal (bare metal ARM, “próximamente” en vista previa)—, en un movimiento que confirma el cambio de ciclo en la Inteligencia Artificial: del protagonismo del entrenamiento a la presión por ofrecer inferencias rápidas, baratas y orquestadas en flujos agenticos. La compañía defiende que ese salto de productividad solo es posible con silicio a medida y co-diseño de sistema (hardware, redes y software trabajados como una sola pieza), bajo su paraguas de supercomputación AI Hypercomputer.

En la práctica, Ironwood llega para servir modelos de última generación con latencia mínima y elasticidad de data center completo, mientras que Axion amplía el músculo de computación general con mejor precio-rendimiento para el “backbone” que sostiene esas aplicaciones: microservicios, ingestión y preparación de datos, APIs, bases de datos y control de orquestación.

Ironwood: una TPU pensada para la inferencia masiva (sin renunciar al entrenamiento a gran escala)

Ironwood se presenta como la TPU más potente y eficiente de Google hasta la fecha. La compañía habla de una mejora de hasta 10× en rendimiento pico frente a TPU v5p, y de más de 4× de rendimiento por chip tanto en entrenamiento como en inferencia frente a TPU v6e (Trillium). El mensaje es inequívoco: servir modelos generativos y agentes a gran escala exige un salto en ancho de banda, memoria efectiva y conectividad entre chips.

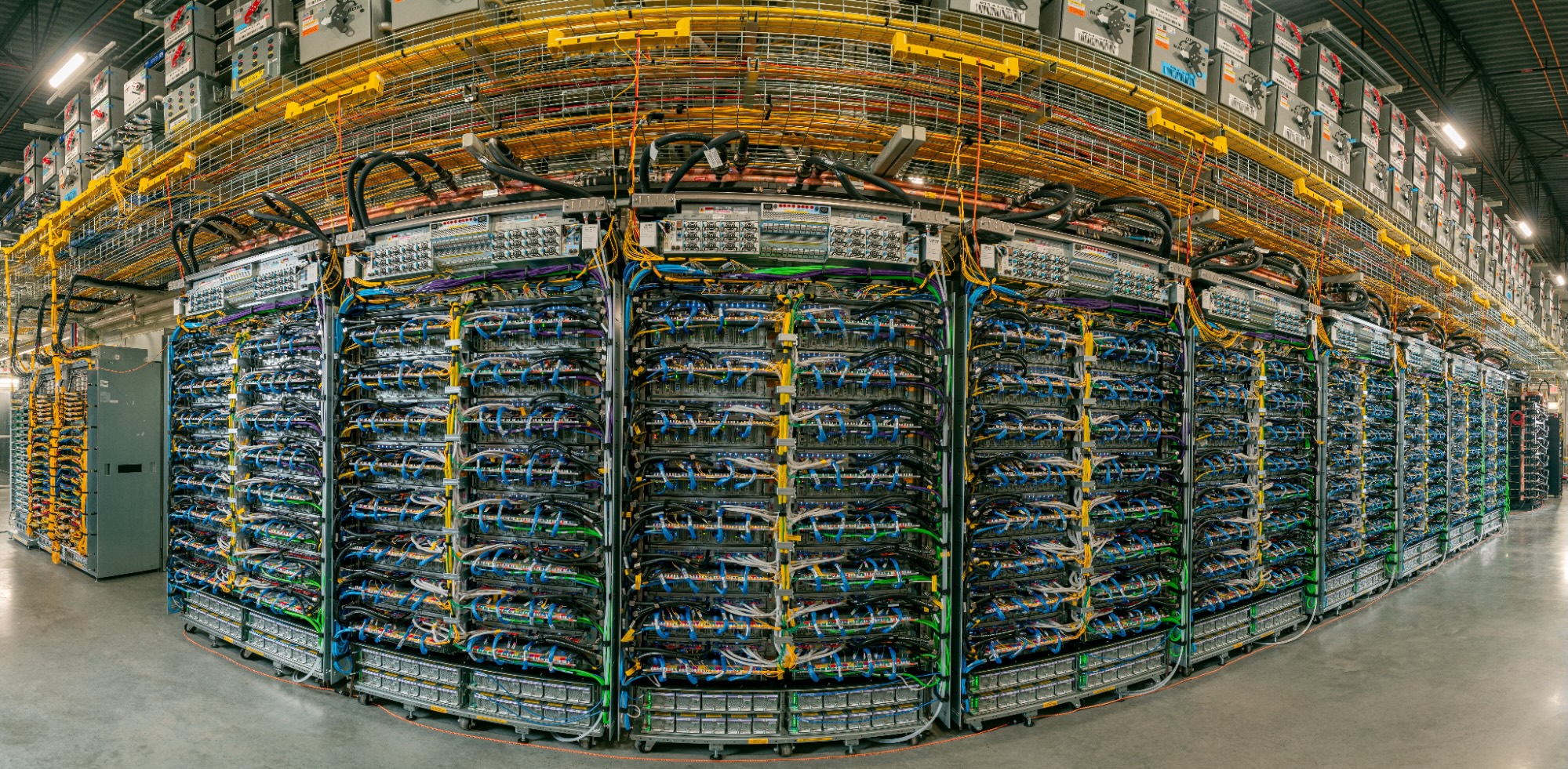

El diseño de Ironwood parte de la idea de “sistema primero”. Cada despliegue agrupa TPUs en pods, que a su vez se ensamblan en superpods interconectados con ICI (Inter-Chip Interconnect) a 9,6 Tb/s. En esa topología, un superpod puede unir hasta 9.216 TPUs en un dominio único con 1,77 PB de HBM compartida, reduciendo cuellos de botella para modelos de gran tamaño. Por encima, la red Jupiter permite coser superpods en clusters de cientos de miles de TPUs cuando la carga lo exige.

Para la resiliencia, Google añade conmutación óptica (OCS) como tejido reconfigurable que reencamina el tráfico ante interrupciones sin detener el servicio. Y, en la capa física, apoya el conjunto con refrigeración líquida a gran escala, una pieza ya habitual en sus centros de datos, que sostiene densidades elevadas con disponibilidad media “cinco nueves” desde 2020.

Más allá de la potencia bruta, lo determinante es cómo se usa. Ironwood convive con un software co-diseñado para exprimir la arquitectura y simplificar la vida de ingeniería:

- GKE con Cluster Director aporta mantenimiento avanzado y planificación consciente de topología para clusters más resilientes.

- MaxText, el framework abierto de alto rendimiento para LLM, incorpora mejoras para afinados supervisados (SFT) y optimizaciones de RL como GRPO.

- vLLM soporta ya TPU, con la posibilidad de alternar entre GPU y TPU con cambios mínimos en configuración.

- GKE Inference Gateway introduce un plano de balanceo inteligente entre servidores TPU que, según Google, puede reducir el “time-to-first-token” hasta un 96 % y bajar el coste de serving hasta un 30 %.

El objetivo último es cerrar el círculo entrenar → ajustar → servir bajo una experiencia operativa coherente, en la que datos, modelo y serving convivan con más eficiencia y menos fricción.

Primeras señales del mercado: de Anthropic a Lightricks y Essential AI

Las referencias tempranas ayudan a entender la ambición del lanzamiento. Anthropic —que viene escalando su familia Claude— planea acceder hasta 1.000.000 de TPUs, y sitúa a Ironwood como palanca para acelerar el salto del laboratorio al servicio de millones de usuarios. Lightricks valora especialmente el potencial en calidad y fidelidad de imagen y vídeo para productos creativos; Essential AI subraya la facilidad de incorporación de la plataforma para poner a trabajar a sus equipos sin demoras. En todos los casos, el hilo conductor es la relación precio-rendimiento y la capacidad de escalar sin sacrificar fiabilidad.

Axion: CPU ARM para el “trabajo cotidiano” que hace posible la IA

La otra pata del anuncio es Axion, la línea de CPU ARM Neoverse de Google Cloud. La ampliación llega por duplicado:

- N4A (vista previa): la VM más eficiente en precio-rendimiento de la serie N hasta la fecha, con hasta 64 vCPU, 512 GB de memoria DDR5 y 50 Gbps de red. Es compatible con Custom Machine Types y almacenamiento Hyperdisk Balanced/Throughput, y apunta a microservicios, contenedores, bases de datos open-source, batch y analytics, además de entornos de desarrollo y sirvientes web. Google asegura hasta 2× mejor precio-rendimiento frente a VMs x86 actuales.

- C4A metal (bare metal ARM, vista previa próximamente): hasta 96 vCPU, 768 GB de DDR5, Hyperdisk y hasta 100 Gbps de red. Pensada para hipervisores, desarrollo nativo ARM (incluido Android/automoción), software con licenciamiento estricto o granjas de test y simulaciones complejas.

Junto a la ya conocida C4A (VM) —hasta 72 vCPU, 576 GB DDR5, 100 Gbps de red, Titanium SSD local de hasta 6 TB y controles avanzados de mantenimiento—, el porfolio Axion cubre tanto cargas sensibles a latencia como necesidades de capacidad sostenida, con un hilo conductor: ajustar recursos a la carga real para bajar la factura sin tocar el modelo operativo.

Las primeras pruebas de clientes refuerzan la tesis. Vimeo habla de un +30 % de rendimiento en su transcodificación frente a VMs x86 comparables; ZoomInfo reporta +60 % en precio-rendimiento en Dataflow y servicios Java en GKE; y Rise combina C4A e Hyperdisk para recortar consumo de cómputo y latencia en su plataforma publicitaria, además de probar N4A en cargas críticas que requieren flexibilidad.

La combinación que importa: aceleradores para IA + CPU eficientes para todo lo demás

El panorama actual, marcado por arquitecturas de modelos que cambian cada pocos meses, técnicas emergentes (con agentes que planifican y actúan en entornos complejos) y picos de demanda imprevisibles, obliga a elegir bien qué corre dónde. El enfoque de Google apuesta por un maridaje:

- Aceleradores especializados (Ironwood TPU) para entrenar y servir modelos avanzados con ancho de banda y memoria suficientes, y un plano de red capaz de escalar con resiliencia.

- CPU Axion para todo lo demás: aplicaciones, API, ingestión/preparación de datos, ETL, colas, servicios web y microservicios que orquestan flujos de IA. Esa capa generalista determina gran parte del coste total y, si es eficiente, libera presupuesto para la aceleración donde sí hace falta.

Para equipos de plataformas, esto se traduce en flexibilidad operativa: poder mezclar aceleradores y CPU según la fase (pre-entrenamiento, afinado, inferencia) y el perfil de cada carga. Con el apoyo de GKE, vLLM y MaxText, la promesa es minimizar cambios de código y fricción al mover cargas entre GPU y TPU, o al reacomodar componentes en Axion.

Preguntas clave para tomar decisiones

Aunque el anuncio marca una dirección nítida, las organizaciones deberían aterrizarlo con una checklist pragmática:

- Disponibilidad por región y cuotas: ¿en qué regiones se podrá reservar Ironwood? ¿qué límites y SLO acompañan a N4A y C4A metal en vista previa?

- Compatibilidad y portabilidad: ¿qué tooling (vLLM, MaxText, frameworks populares) viene soportado de serie? ¿qué cambios requiere migrar de GPU a TPU?

- Costes y empaquetado: ¿cómo se presupuestan los superpods y las ventanas de uso intensivo? ¿cómo encaja Hyperdisk con perfiles de IOPS y tamaño en Axion?

- Resiliencia y gobernanza: ¿cómo se observa y audita el plano de OCS y Jupiter? ¿qué métricas de TTFT, MTTR y coste por token ofrece el stack de serving?

- Ruta de adopción: ¿qué pilotos de bajo riesgo permiten validar mejoras (p. ej., pasar un servicio de inferencia a Ironwood o mover un pipeline de datos a N4A) antes de comprometer inversiones mayores?

Responder con números propios —no solo con fichas técnicas— será la diferencia entre una promesa atractiva y una ventaja competitiva real.

Qué significa para el sector

El anuncio coloca a Google en el centro de un debate que ya no es “quién entrena más grande”, sino “quién sirve mejor y más barato” en producción. Ironwood ataca de frente el cuello de botella del serving con interconexión masiva, memoria compartida y balanceo inteligente; Axion apunta a la contención de costes en el día a día, donde se decide buena parte de la rentabilidad de productos de IA. Para el cliente, la ventaja no está solo en los watios por token, sino en la disciplina de sistema: cómo se orquesta un pipeline que pasa sin sobresaltos del experimento al servicio global.

Si la co-optimización se mantiene y el ecosistema de software acompaña, esta combinación puede convertirse en una plantilla operativa para muchos equipos de plataforma: TPU para lo que de verdad necesita ancho de banda y memoria, ARM para lo que mueve el negocio a diario. La apuesta, en definitiva, no es por una pieza concreta, sino por el conjunto.

Preguntas frecuentes (FAQ)

¿Qué es exactamente Ironwood y para qué tipo de cargas está pensado?

Es la séptima generación de TPU de Google, diseñada para entrenamiento de modelos grandes, refuerzo (RL) y, especialmente, inferencia y serving a gran escala con latencia muy baja. Su fuerza está en la interconexión de miles de chips (hasta 9.216 en un superpod) y el acceso a 1,77 PB de HBM compartida para evitar cuellos de botella.

¿Qué diferencias hay entre N4A, C4A y C4A metal de Axion?

N4A prioriza precio-rendimiento y flexibilidad (hasta 64 vCPU, 512 GB y 50 Gbps), ideal para microservicios, bases de datos OSS y analytics. C4A (VM) ofrece rendimiento sostenido (hasta 72 vCPU, 576 GB, 100 Gbps y Titanium SSD local). C4A metal es bare metal (hasta 96 vCPU, 768 GB, hasta 100 Gbps) para hipervisores, desarrollo nativo ARM y workloads con requisitos de licenciamiento o acceso al hardware.

¿Cómo ayuda el software (GKE, vLLM, MaxText) a aprovechar Ironwood?

GKE incorpora Cluster Director para planificación y mantenimiento conscientes de la topología. vLLM facilita migrar o mezclar GPU/TPU con cambios mínimos. MaxText acelera afinados y técnicas de RL. Además, GKE Inference Gateway puede reducir TTFT y costes de serving de forma notable al balancear de manera inteligente en servidores TPU.

¿Cuándo estarán disponibles Ironwood y las nuevas Axion?

Ironwood llegará a disponibilidad general en las próximas semanas, mientras que N4A está en vista previa y C4A metal entrará en vista previa próximamente. La disponibilidad por región y los cupos se irán ampliando de forma escalonada.

vía: cloud.google