La startup asegura que su tecnología será hasta 10 veces más rápida y eficiente que la memoria HBM en cargas de inferencia, un cambio de paradigma en la relación entre cómputo y memoria.

La memoria de gran ancho de banda (HBM) se ha convertido en el estándar de facto para la inteligencia artificial y la computación de alto rendimiento. Utilizada por gigantes como NVIDIA, AMD o Intel, su diseño de módulos apilados permite alcanzar cifras de ancho de banda impensables con memorias convencionales. Pero quizá no sea la solución definitiva para todas las tareas.

La startup d-Matrix cree haber encontrado un sustituto más adecuado para uno de los cuellos de botella actuales de la IA: la inferencia. Su propuesta, bautizada como 3D Digital In-Memory Compute (3DIMC), promete ser hasta 10 veces más rápida y 10 veces más eficiente que HBM en este tipo de cargas de trabajo.

De entrenar modelos a ejecutarlos: un desafío distinto

Mientras que HBM es crítica para el entrenamiento de modelos de IA, donde se requieren enormes cantidades de memoria y ancho de banda, la inferencia —la fase en la que los modelos ya entrenados procesan datos en tiempo real— tiene necesidades diferentes.

Según d-Matrix, la inferencia está “estrangulada por la memoria”, más que por la potencia bruta de cálculo (FLOPs). “Los modelos crecen a una velocidad increíble, y los sistemas HBM tradicionales son cada vez más costosos, intensivos en energía y limitados en ancho de banda”, explicó Sid Sheth, fundador y CEO de la compañía.

La solución: acercar el cómputo a la memoria y ejecutar operaciones directamente en ella.

Cómo funciona 3DIMC

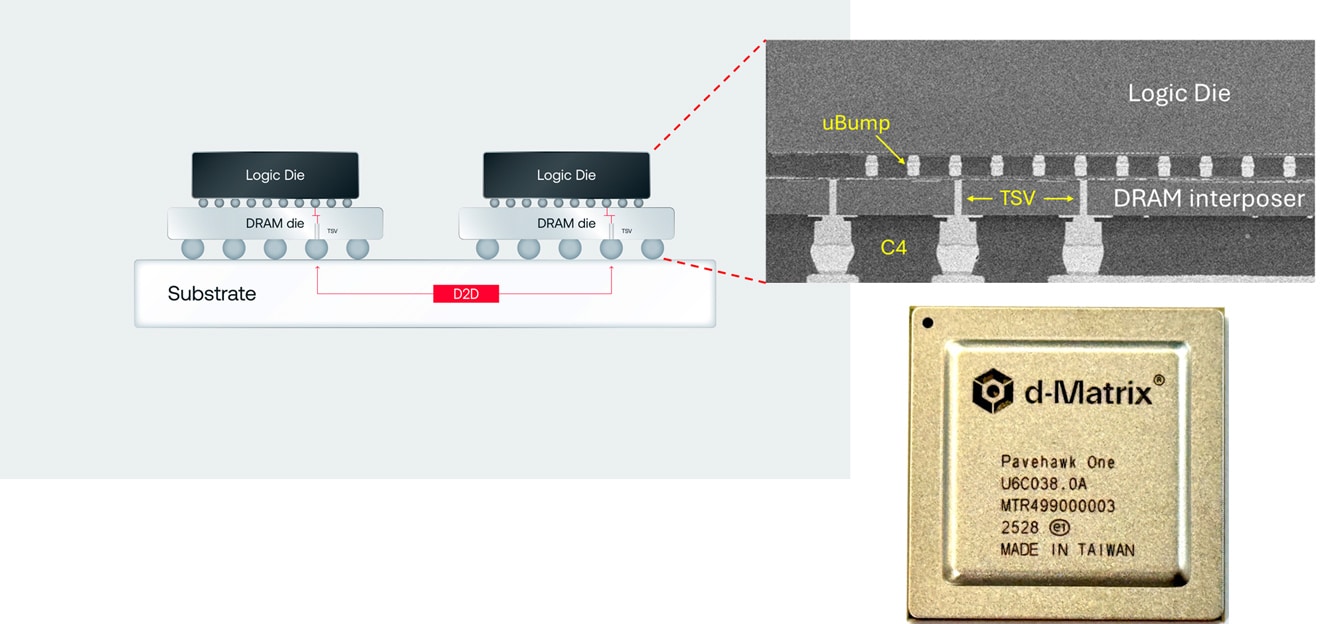

En su chip Pavehawk, actualmente en pruebas de laboratorio, d-Matrix combina memorias LPDDR5 con chiplets DIMC apilados en 3D a través de un interposer. Estos chiplets incorporan lógica especializada en multiplicación matriz-vector, una operación recurrente en modelos de IA basados en transformadores.

La clave está en que las operaciones se realizan dentro de la memoria misma, reduciendo drásticamente la latencia, aumentando el ancho de banda y, en teoría, mejorando la eficiencia energética hasta en un 90% respecto a HBM.

La compañía ya trabaja en la siguiente generación, llamada Raptor, que buscará superar definitivamente a HBM en cargas de inferencia.

Implicaciones económicas y estratégicas

HBM es actualmente un recurso limitado y caro. Solo tres fabricantes dominan el mercado: SK hynix, Samsung y Micron, y se espera que su precio siga aumentando. SK hynix estima un crecimiento anual del 30% en el mercado HBM hasta 2030, lo que significa una presión creciente para los centros de datos y proveedores cloud que dependen de estas memorias.

En este contexto, una alternativa como 3DIMC resulta atractiva. Un diseño especializado para inferencia podría abaratar costes y liberar a los grandes clientes —hiperescalares y empresas de IA— de la dependencia de unos pocos proveedores. Sin embargo, algunos analistas advierten que esta especialización podría ser “demasiado estrecha” y arriesgada, en un sector que ya muestra síntomas de sobreinversión o “burbuja” tecnológica.

¿Revolución o nicho?

La apuesta de d-Matrix se enmarca en una tendencia más amplia: diseñar hardware específico para cada fase del ciclo de vida de la IA. Si el entrenamiento y la inferencia tienen perfiles tan distintos, ¿por qué forzar a una misma tecnología de memoria a cubrir ambas necesidades?

La respuesta llegará en los próximos años, a medida que hyperscalers como Google, Microsoft o Amazon evalúen si merece la pena incorporar un ecosistema paralelo de memorias para la inferencia. Por ahora, d-Matrix busca demostrar que su propuesta no es solo un prototipo de laboratorio, sino una alternativa viable en el mercado real.

Preguntas frecuentes (FAQ)

¿Qué diferencia a 3DIMC de la memoria HBM?

Mientras HBM se limita a transferir datos rápidamente entre memoria y procesador, 3DIMC realiza cálculos dentro de la memoria, reduciendo la necesidad de mover datos y mejorando la eficiencia en tareas de inferencia.

¿Es 3DIMC un sustituto directo de HBM?

No en todos los casos. Está orientada a inferencias de IA, no al entrenamiento de modelos, donde HBM sigue siendo más adecuada.

¿Qué ventajas económicas ofrece 3DIMC?

Podría reducir la dependencia de los grandes fabricantes de HBM y abaratar los costes de infraestructura, sobre todo en centros de datos que procesan grandes volúmenes de inferencia.

Cuándo podría estar disponible comercialmente?

Por ahora, d-Matrix solo tiene Pavehawk funcionando en laboratorio. El próximo chip, Raptor, será el que busque validación real frente a HBM en los próximos años.

vía: d-matrix.ai