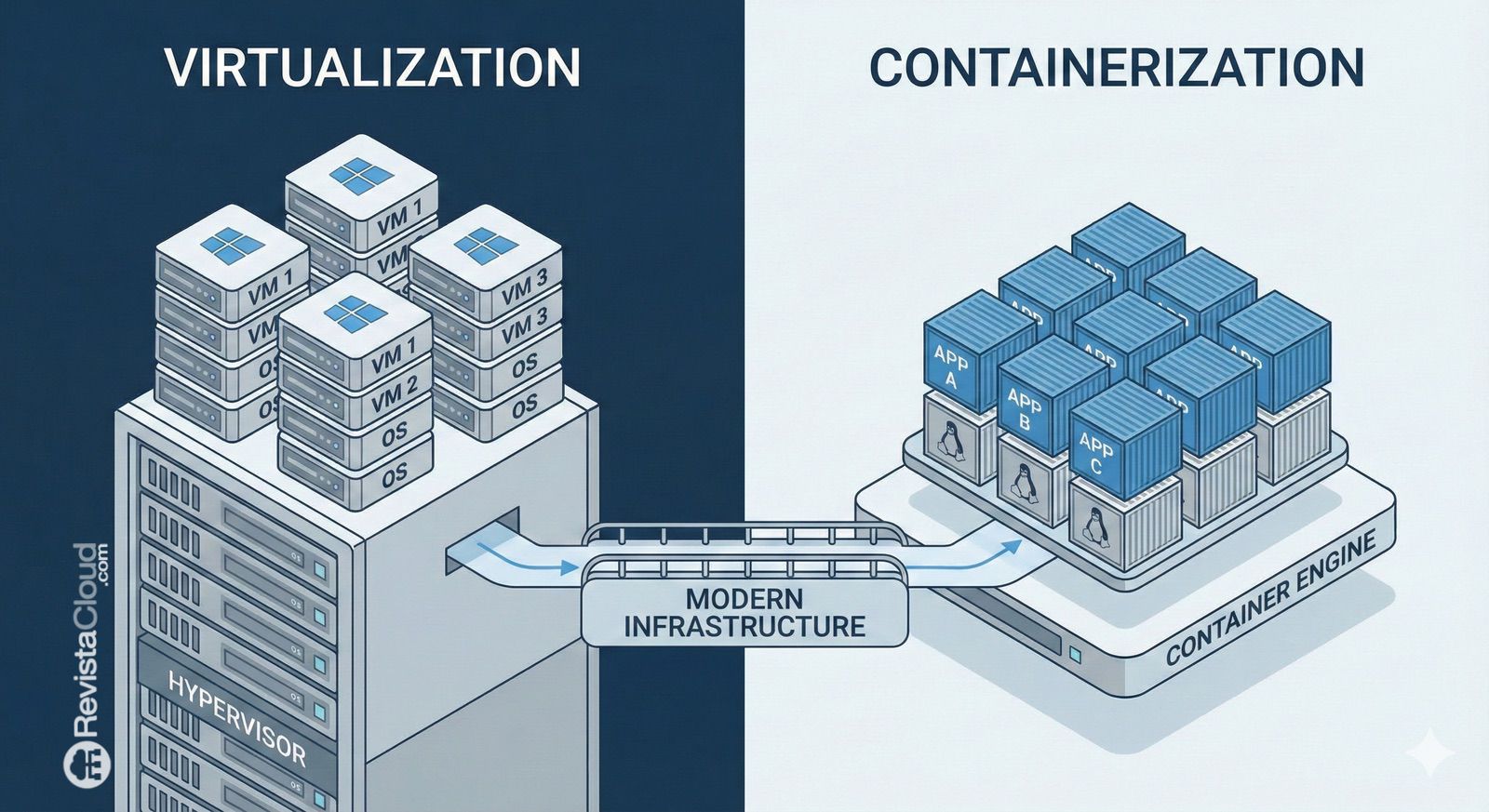

La virtualización, durante años el “suelo firme” sobre el que se construían centros de datos y nubes privadas, ha entrado en una fase de revisión profunda. No se trata únicamente de cambiar un hipervisor por otro, sino de replantear el modelo operativo completo: dónde viven las cargas, cómo se gestionan, cómo se protegen y, sobre todo, cómo se preparan para una nueva realidad marcada por la Inteligencia Artificial, la presión sobre el rendimiento y la imprevisibilidad de costes.

Esa es la tesis central de una nueva investigación publicada por HPE: más de dos tercios de las empresas planean cambios materiales en su estrategia de virtualización en los próximos dos años, pero solo el 5% afirma estar plenamente preparado para ejecutarlos. El dato dibuja un mercado en ebullición y, al mismo tiempo, una brecha de ejecución que preocupa a CIOs y equipos de IT: la intención de transformar está ahí, pero no siempre se acompaña de planes, recursos y capacidades suficientes.

Del plan al movimiento: 12 a 24 meses decisivos

HPE sitúa los próximos 12 a 24 meses como un punto de inflexión: el paso de la “planificación” a la “transformación activa”. La encuesta —realizada sobre casi 400 organizaciones globales— retrata un entorno en el que la virtualización ya no es una decisión estática, sino un componente que debe evolucionar al ritmo del negocio y de la adopción de la Inteligencia Artificial.

En ese “gran reinicio”, el informe apunta a una idea que rompe con el relato simplista de los últimos trimestres: el coste de licencias no sería el único motor. De hecho, solo el 4% de las empresas encuestadas lo cita como el catalizador principal. El empuje más fuerte vendría de la preparación para IA, la necesidad de flexibilidad híbrida y el encaje entre rendimiento, operaciones y seguridad en entornos cada vez más complejos.

Las barreras: presupuesto, complejidad y riesgo de migración

La transformación suena bien en presentaciones, pero se vuelve difícil cuando hay que mover cargas críticas. HPE identifica los principales frenos: restricciones presupuestarias (28%), complejidad técnica (24%) y riesgo de migración (21%), seguidos de cerca por la brecha de habilidades (20%).

El mensaje implícito es directo: muchas organizaciones saben que deben cambiar, pero temen el coste real del cambio —no solo económico, también operacional— y la posibilidad de interrupciones. La virtualización, al final, es el “corazón” de demasiados servicios como para abordarla con prisas.

No es un simple “swap” de hipervisor: es un cambio de modelo operativo

Otro dato relevante es el enfoque: el 57% de las empresas asegura que adoptará una estrategia por fases para “blindar” su infraestructura de futuro. En ese recorrido, el informe describe el modelo híbrido como el destino preferente, especialmente para atender demandas de rendimiento ligadas a IA.

Además, el estudio ofrece una foto del reparto de aprovisionamiento en distintos entornos (no excluyentes entre sí): 78% en nube pública, 61% en clústeres virtualizados, 48% en nube privada y 32% en el edge. La lectura es clara: el “dónde” importa, pero el “cómo se opera” importa todavía más cuando las cargas se reparten entre múltiples dominios.

Seguridad, observabilidad y protección de datos: lo que sube al podio

Si el hipervisor deja de ser el único protagonista, ¿qué entra en el foco? HPE señala tres pilares que las empresas consideran esenciales en su estrategia moderna de virtualización:

- Backup unificado y ciber-recuperación (70%).

- Gobernanza multiplataforma (61%).

- Observabilidad integrada y AIOps (55%).

En otras palabras: la conversación se desplaza hacia resiliencia, visibilidad y control transversal. Es coherente con la presión que impone la IA: más datos, más servicios, más dependencias y un coste mayor cuando algo falla.

Brian Gruttadauria, CTO de Hybrid Cloud en HPE, resume esa tensión al afirmar que las compañías están “reevaluando supuestos de IT” para equilibrar predictibilidad de costes, preparación para IA y rendimiento, y que no se trata de una sustitución acelerada, sino de un giro hacia un modelo más flexible y simplificado.

Morpheus, Danfoss y el discurso de “estabilidad para la era IA”

El comunicado de HPE también incorpora testimonios de clientes y socios. Danfoss, por ejemplo, plantea el cambio de estrategia como una oportunidad para preparar operaciones para un modelo cloud más sencillo y para la era de la IA, dentro del marco de HPE Private Cloud Enterprise con HPE Morpheus. Aunque estos casos suelen formar parte del posicionamiento comercial, aportan contexto: el mercado ya no habla solo de consolidar máquinas virtuales, sino de construir una base operativa “estable” donde la virtualización sea un medio, no el fin.

El ángulo europeo: alternativas abiertas y proveedores que empujan Proxmox

En paralelo a estos movimientos, el “reinicio” de la virtualización está abriendo espacio a alternativas de ecosistema abierto. Entre ellas, Proxmox VE aparece cada vez más en conversaciones de CIOs y responsables de infraestructura por su combinación de virtualización, gestión y enfoque comunitario/empresarial.

En Europa, proveedores como Stackscale (Grupo Aire) están aprovechando esa tendencia: por un lado, difundiendo el salto hacia Proxmox VE como vía para ganar flexibilidad y reducir dependencia de un único fabricante; por otro, ofreciendo acompañamiento en migraciones y despliegues sobre infraestructura bare-metal orientada a entornos Proxmox.

Este punto conecta con la idea central del informe de HPE: el mercado no busca solo “otro hipervisor”, sino una manera de recuperar control —de costes, de operación y de resiliencia— sin frenar la innovación. Y ahí encajan, precisamente, las capacidades que las empresas priorizan: backup y recuperación, gobernanza cruzada, observabilidad y automatización.

Un “reset” que exige método

La conclusión que se desprende del estudio es tan sencilla como exigente: 2026 y 2027 podrían marcar un antes y un después en virtualización, pero el éxito dependerá menos del producto elegido y más del método. Inventariar dependencias, medir riesgo, formar equipos, planificar por fases, reforzar ciber-recuperación y construir observabilidad real son decisiones que pesan más que el logo del hipervisor.

Porque si solo cambia el software, pero no cambia el modelo de operación, el reinicio se queda a medias.

Preguntas frecuentes

¿Qué es el “Great Virtualization Reset” y por qué afecta a tantas empresas en 2026?

Es el proceso por el que las organizaciones replantean su estrategia de virtualización para adaptarse a cambios de licencias, presión de costes y, sobre todo, a nuevas exigencias de rendimiento y operación ligadas a la Inteligencia Artificial y a modelos híbridos.

¿Cuáles son los mayores riesgos al migrar máquinas virtuales a otra plataforma de virtualización?

Los principales riesgos suelen concentrarse en interrupciones de servicio, compatibilidad de red y almacenamiento, dependencias de herramientas de backup/monitorización y falta de habilidades internas; por eso muchas empresas optan por migraciones por fases y entornos piloto.

¿Qué capacidades debería priorizar una empresa al modernizar su virtualización para IA?

Más que el hipervisor, destacan la ciber-recuperación y backup unificado, la gobernanza multiplataforma y la observabilidad con automatización/AIOps, para operar cargas distribuidas con control y resiliencia.

¿Por qué Proxmox aparece como alternativa en el “reinicio” de la virtualización?

Porque ofrece un enfoque abierto y flexible que puede encajar en estrategias híbridas, y está ganando tracción en proyectos europeos donde se busca reducir dependencia de un único proveedor y reforzar control operacional.