La fiebre de la Inteligencia Artificial ha abierto un nuevo capítulo en el mundo de las infraestructuras digitales: las llamadas “fábricas de IA”, enormes centros de datos diseñados para ejecutar modelos de inferencia a escala industrial. Pero más allá del avance tecnológico, lo que realmente interesa a analistas e inversores es la economía que hay detrás.

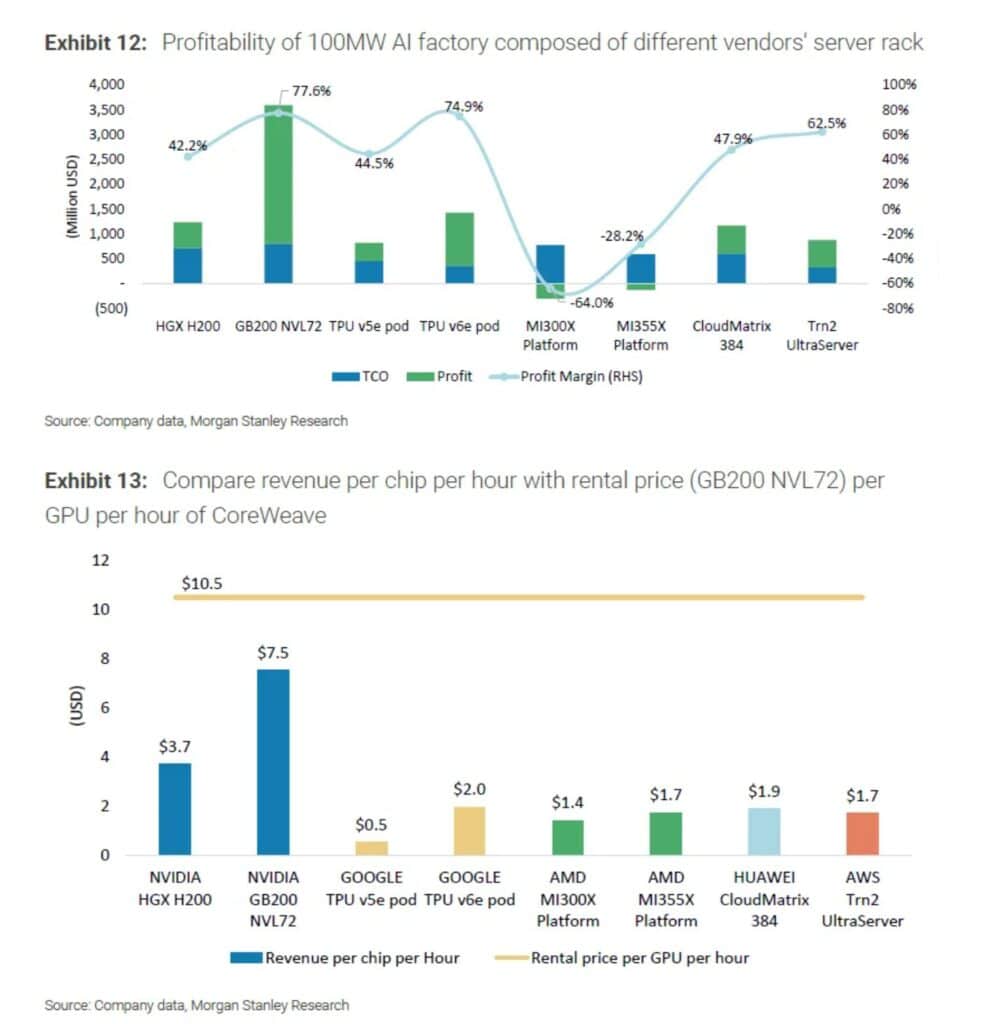

Un reciente informe de Morgan Stanley ha puesto cifras sobre la mesa y sus conclusiones son claras: NVIDIA lidera con un margen de beneficio operativo del 77,6 % gracias a sus racks GB200 NVL72, mientras que competidores como Google, Amazon y Huawei también consiguen beneficios sólidos. En cambio, AMD registra pérdidas significativas, con márgenes negativos de hasta el -64 % en sus plataformas más recientes.

Qué es una “fábrica de IA”

El término “AI Factory” no es un recurso metafórico: se trata de un modelo estandarizado de centro de datos de 100 MW de potencia, pensado para medir la rentabilidad de la inferencia a gran escala.

Morgan Stanley ha creado un marco de análisis denominado “100MW AI Factory Model”, que toma como referencia tres pilares:

- Unidad estandarizada de cómputo: 100 MW de consumo eléctrico, equivalentes a unos 750 racks de servidores de alta densidad.

- Libro detallado de costes: incluye el gasto de construcción (660 millones de dólares, depreciados en 10 años), la compra de hardware (entre 367 millones y 2.273 millones, depreciados en 4 años) y los costes operativos en electricidad y refrigeración.

- Fórmula de ingresos de mercado: vinculada a la producción de tokens en los modelos de lenguaje. El precio medio tomado como referencia es de 0,20 dólares por millón de tokens, ajustado a un 70 % de utilización real de los equipos.

Con esta metodología, Morgan Stanley calcula que una fábrica de IA típica tiene un coste total de propiedad (TCO) anual de entre 330 y 807 millones de dólares, dependiendo del hardware elegido.

NVIDIA: la inversión más cara, pero la más rentable

Cada rack NVIDIA GB200 NVL72 integra 72 GPUs B200 y 36 CPUs Grace, interconectadas mediante NVLink 5 de alta velocidad. Su precio es de 3,1 millones de dólares por rack, frente a los 190.000 dólares de un rack H100 de generación previa.

Pese a ese enorme diferencial de inversión, los cálculos financieros son contundentes:

- Margen operativo: 77,6 %.

- TCO en 100 MW: 806,58 millones de dólares.

- Ingresos: la eficiencia en inferencia multiplica el rendimiento por GPU y permite obtener una rentabilidad récord.

El liderazgo de NVIDIA no solo se debe a la potencia bruta de sus chips, sino a la integración de todo un ecosistema de software (CUDA, TensorRT, frameworks optimizados) que asegura que cada dólar invertido en hardware se traduzca en más tokens procesados y, por tanto, en más ingresos.

Google, Amazon y Huawei: beneficios sólidos

El estudio de Morgan Stanley muestra que otros gigantes tecnológicos también logran rentabilidad positiva, aunque con matices:

- Google TPU v6e pods: 74,9 % de margen. No se conoce su precio exacto, pero se estima que alquilarlos cuesta entre un 40 % y 50 % menos que un rack NVL72. Su fuerza reside en la integración vertical con Google Cloud y la optimización software-hardware.

- AWS Trn2 UltraServer: 62,5 % de margen. Amazon apuesta por hardware propio para reducir costes de alquiler y ofrecer inferencia optimizada en su nube.

- Huawei Ascend CloudMatrix 384: 47,9 % de margen. Aun sin alcanzar los niveles de NVIDIA o Google, representa una alternativa rentable y con proyección en Asia, especialmente tras las restricciones a la exportación de chips estadounidenses.

AMD: las pérdidas que nadie esperaba

El “agua fría” del informe llega con AMD. Sus plataformas MI300X y MI355X, llamadas a competir en el segmento de IA de alto rendimiento, muestran márgenes de -28,2 % y -64 %, respectivamente.

La razón es simple:

- Costes iniciales muy altos, comparables a los de NVIDIA.

- Eficiencia en inferencia muy por debajo, lo que reduce la producción de tokens y los ingresos.

El TCO anual de un MI300X llega a los 774 millones de dólares, apenas por debajo de los 806 millones del GB200 de NVIDIA. La diferencia es que, mientras NVIDIA genera ingresos suficientes para multiplicar el margen, AMD no logra cubrir los costes.

Esto supone un duro golpe para las expectativas que muchos inversores tenían en AMD como alternativa viable en el mercado de la IA.

Un nuevo modelo de negocio: la inferencia como fábrica

La gran conclusión de Morgan Stanley es que la inferencia de IA ya no es solo un reto tecnológico, sino un modelo de negocio medible y repetible, con fórmulas claras de inversión y retorno.

Las fábricas de IA podrían convertirse en la próxima clase de infraestructura del billón de dólares, al nivel de las plantas de generación eléctrica o las redes de telecomunicaciones.

Esto abre preguntas urgentes:

- ¿Cómo asegurarán los arquitectos de centros de datos suficiente potencia eléctrica para soportar GPUs de 1.200W o más?

- ¿Podrán las utilities aumentar su capacidad de generación y transmisión al ritmo que crece la demanda de IA?

- ¿Cómo equilibrar velocidad de despliegue, refrigeración líquida y permisos regulatorios con el objetivo de maximizar beneficios?

Ecosistemas y la próxima batalla

El informe también advierte de que la próxima guerra no será solo de chips, sino de ecosistemas de conectividad.

En el campo no NVIDIA, AMD impulsa UALink, un estándar abierto de baja latencia para interconectar GPUs. En paralelo, compañías como Broadcom defienden Ethernet como alternativa flexible. El desenlace de esta disputa podría definir si emerge un ecosistema abierto capaz de competir con NVLink, la interconexión propietaria de NVIDIA.

Mientras tanto, NVIDIA avanza con su hoja de ruta. Su próximo salto, la plataforma “Rubin”, está previsto para 2026, y promete elevar aún más las exigencias para sus rivales.

Conclusión: rentabilidad desigual en la carrera por la IA

Los números de Morgan Stanley ponen en evidencia una divergencia brutal:

- NVIDIA y Google marcan el ritmo con márgenes cercanos al 80 %.

- Amazon y Huawei demuestran que es posible ser rentable en un mercado hipercompetitivo.

- AMD, en cambio, se descuelga con pérdidas que ponen en duda su estrategia en IA.

La inferencia de IA, que representa el 85 % del mercado futuro según el informe, ya no es solo cuestión de chips potentes, sino de economía precisa y escalabilidad industrial.

El mensaje es claro: las fábricas de IA no solo producirán tokens y modelos, producirán también márgenes de beneficio sin precedentes para quienes logren dominar la ecuación tecnológica y financiera.

Preguntas frecuentes (FAQ)

¿Qué es exactamente una “fábrica de IA”?

Una fábrica de IA es un modelo conceptual que describe centros de datos optimizados para ejecutar cargas de inferencia a gran escala de manera estandarizada. Morgan Stanley utiliza como referencia un centro de 100 MW de potencia eléctrica, con unos 750 racks de servidores de alta densidad, para medir rentabilidad y costes de inversión. En estas instalaciones, la producción se mide en tokens procesados por segundo, convirtiendo la inferencia en un negocio calculable y repetible, similar a una línea de producción industrial.

¿Por qué los racks NVIDIA GB200 NVL72 son más caros pero más rentables que otras opciones?

Cada rack NVL72 cuesta alrededor de 3,1 millones de dólares, mucho más que un rack basado en H100 o en plataformas de AMD. Sin embargo, la clave está en la eficiencia de inferencia: las GPUs B200 de NVIDIA, junto con las CPUs Grace y la interconexión NVLink 5, permiten procesar muchos más tokens por vatio consumido. Esto multiplica los ingresos, lo que se traduce en un margen de beneficio del 77,6 %, el más alto del sector.

¿Cuál es la posición de Google, Amazon y Huawei en este mercado?

- Google TPU v6e: logra un 74,9 % de margen, muy cerca de NVIDIA, gracias a la integración hardware-software y su despliegue en Google Cloud.

- Amazon AWS Trn2 UltraServer: alcanza un 62,5 % de margen, apoyado en chips propios y en el efecto escala de AWS.

- Huawei Ascend CloudMatrix 384: con un 47,9 % de margen, demuestra que es posible ser rentable fuera del ecosistema estadounidense, convirtiéndose en una alternativa estratégica para Asia y mercados con restricciones de acceso a GPUs NVIDIA.

¿Por qué AMD registra márgenes negativos en inferencia?

El problema de AMD radica en la relación entre costes y eficiencia. Sus plataformas MI300X y MI355X tienen un TCO muy alto —similar al de NVIDIA, rondando los 774 millones de dólares anuales en un centro de 100 MW—, pero generan muchos menos tokens por segundo. Esa baja productividad implica ingresos insuficientes, con pérdidas estimadas del -28,2 % y hasta -64 % en los escenarios de Morgan Stanley.

¿Qué papel juegan la energía y la refrigeración en la rentabilidad de una fábrica de IA?

La rentabilidad no depende solo del hardware, sino de la infraestructura energética. Los chips de última generación consumen cantidades crecientes de energía: las GPUs H200 ya alcanzaban los 700W por chip, las B200 superan los 1.200W, y la próxima generación Rubin podría ir más allá. Esto obliga a los operadores a invertir en alta densidad de potencia eléctrica, sistemas avanzados de refrigeración líquida y acuerdos con utilities para garantizar suministro estable. Un fallo en estos aspectos puede disparar costes operativos y erosionar márgenes.

¿Son sostenibles estos márgenes a largo plazo?

Morgan Stanley advierte que si la inferencia sigue generando beneficios cercanos al 80 %, estaremos ante uno de los ciclos de infraestructura más rentables y rápidos de la década. Sin embargo, la sostenibilidad de estos márgenes dependerá de:

- La capacidad de los proveedores de electricidad de aumentar generación y transmisión.

- La evolución de los precios de la energía a nivel global.

- La rapidez con la que las empresas desplieguen nuevas generaciones de hardware y optimicen software.

- El equilibrio entre la oferta y la demanda de cómputo, que podría presionar los precios de mercado por token.

¿Qué impacto tendrá la competencia por estándares de interconexión?

Más allá de los chips, la gran batalla está en los estándares de conectividad entre GPUs. NVIDIA domina con NVLink, pero AMD impulsa UALink como alternativa abierta, mientras que otros actores defienden Ethernet de alta velocidad como solución flexible. El estándar que logre imponerse determinará si en el futuro habrá un ecosistema abierto capaz de competir con el dominio cerrado de NVIDIA.

¿Podrán las fábricas de IA expandirse más allá de los grandes centros de datos?

Sí. Aunque los informes actuales se centran en despliegues hiperescalables, el modelo de edge data centers —instalaciones más pequeñas y distribuidas— podría crecer para soportar LLMs especializados en sectores como banca, salud o industria. Esto abriría nuevas oportunidades económicas y técnicas, pero con desafíos adicionales: menor espacio físico, limitaciones de energía local y mayores necesidades de optimización de modelos.

vía: LinkedIN