NVIDIA y OpenAI han dado un nuevo salto en el rendimiento de la inteligencia artificial con el lanzamiento de los modelos gpt-oss-20b y gpt-oss-120b de código abierto y pesos abiertos, optimizados para la arquitectura Blackwell. Según datos de la compañía, el modelo más grande alcanza hasta 1,5 millones de tokens por segundo (TPS) en un sistema NVIDIA GB200 NVL72, lo que equivaldría a dar servicio a unos 50.000 usuarios concurrentes.

Estos modelos, centrados en el razonamiento textual, integran capacidad de chain-of-thought y llamadas a herramientas, apoyándose en una arquitectura Mixture of Experts (MoE) con activaciones SwigGLU. Incorporan capas de atención con RoPE para contextos de hasta 128.000 tokens, alternando entre atención completa y una ventana deslizante de 128 tokens.

Ambas versiones están disponibles en precisión FP4, lo que permite que incluso el modelo de 120B parámetros activos se ejecute en una única GPU de centro de datos con 80 GB de memoria, aprovechando de forma nativa las capacidades de Blackwell.

Entrenamiento y optimización

El gpt-oss-120b requirió más de 2,1 millones de horas de entrenamiento en GPUs NVIDIA H100 Tensor Core, mientras que el gpt-oss-20b necesitó aproximadamente diez veces menos. Para maximizar el rendimiento, NVIDIA ha colaborado con Hugging Face Transformers, Ollama, vLLM y su propia TensorRT-LLM, implementando mejoras específicas en núcleos de atención, enrutado MoE y preprocesamiento optimizado.

Entre las optimizaciones clave se incluyen:

- TensorRT-LLM Gen para prefill y decode de atención, y MoE de baja latencia.

- CUTLASS MoE kernels para Blackwell.

- XQA kernel especializado para Hopper.

- Librería FlashInfer para servir LLMs con atención optimizada y enrutado MoE acelerado.

- Compatibilidad con OpenAI Triton kernel para MoE en TensorRT-LLM y vLLM.

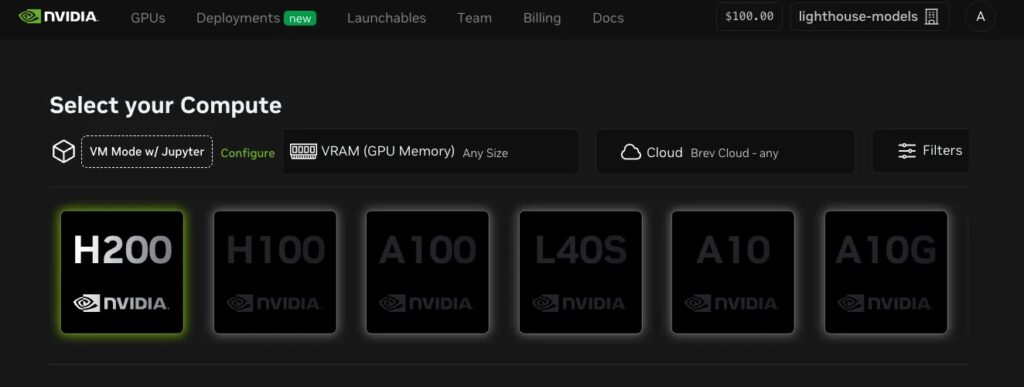

Despliegue flexible: del data center al PC local

En centros de datos:

- Con vLLM, los desarrolladores pueden lanzar un servidor web compatible con OpenAI descargando el modelo de forma automática con un simple comando.

- Con TensorRT-LLM, NVIDIA proporciona guías, contenedores Docker y configuraciones para maximizar el rendimiento tanto en baja latencia como en alto rendimiento.

En infraestructuras empresariales:

- NVIDIA Dynamo, plataforma open source de inferencia, mejora hasta 4x la interactividad para secuencias largas (32k ISL) en Blackwell gracias a la inferencia desagregada, separando fases de cálculo en distintas GPUs.

- Los modelos se ofrecen como microservicios NVIDIA NIM, listos para desplegar en cualquier infraestructura acelerada por GPU, con control sobre privacidad y seguridad.

En entornos locales:

- El gpt-oss-20b puede ejecutarse en cualquier PC con GPU NVIDIA GeForce RTX y al menos 16 GB de VRAM, o en estaciones profesionales con RTX PRO GPUs. Es compatible con Ollama, Llama.cpp y Microsoft AI Foundry Local.

- Los desarrolladores pueden probarlos en RTX AI Garage con entornos preconfigurados.

Una arquitectura diseñada para escalar

El sistema GB200 NVL72 combina 72 GPUs Blackwell con quinta generación de NVLink y NVLink Switch, funcionando como una única GPU de gran escala. El motor Transformer de segunda generación con Tensor Cores FP4, junto con un ancho de banda masivo, permite alcanzar picos de inferencia hasta ahora inalcanzables en modelos de este tamaño.

Según NVIDIA, este avance refuerza la capacidad de la plataforma para servir modelos de última generación desde el día cero, con alto rendimiento y bajo coste por token, tanto en entornos cloud como on-premise.

Ficha técnica de los modelos gpt-oss

| Modelo | Bloques Transformer | Parámetros totales | Parámetros activos por token | Nº de expertos | Expertos activos por token | Contexto máximo |

|---|---|---|---|---|---|---|

| gpt-oss-20b | 24 | 20B | 3,6B | 32 | 4 | 128K |

| gpt-oss-120b | 36 | 117B | 5,1B | 128 | 4 | 128K |

Conclusión

La colaboración entre NVIDIA y OpenAI en los modelos gpt-oss marca un nuevo punto de referencia en la inferencia de modelos de lenguaje de gran escala, no solo por el salto de rendimiento, sino también por la flexibilidad de despliegue: desde entornos cloud a PCs de escritorio, pasando por microservicios listos para producción.

Con un ecosistema optimizado que integra hardware, kernels y frameworks, el objetivo es claro: acercar la IA de alto rendimiento a cualquier desarrollador, en cualquier entorno.

vía: developer.nvidia.com