NVIDIA se enfrenta a un reto tan prosaico como determinante: el calor. A medida que cada generación de aceleradores de IA incrementa el consumo y la densidad en bastidores completos, la pregunta ya no es solo “cuántos TOPS” o “cuál es el ancho de banda de memoria”, sino cómo evacuar los vatios de forma sostenida y segura. Según información avanzada por la cuenta @QQ_Timmy, la compañía habría empezado a coordinar con socios un cambio relevante de enfoque para su próxima familia Rubin Ultra: placas frías de microcanales con refrigeración directa al chip (direct-to-chip, D2C). El objetivo no es menor: exprimir el rendimiento por vatio y dar margen térmico a un salto generacional que, desde Blackwell hasta Rubin, apunta a mayores presupuestos de potencia en configuraciones a escala rack.

La pista técnica no llega sola. En paralelo, Microsoft ha presentado su propuesta de refrigeración microfluídica, una aproximación emparentada con los microcanales pero que, en su caso, pone el foco en el “in-chip cooling”: el fluido circula dentro o por la cara trasera del propio silicio para maximizar el intercambio de calor. Más allá de matices, la coincidencia envía un mensaje claro: la industria necesita opciones nuevas para los megavatios que acarrea la era de la IA.

Excessive Concerns Over Microchannel Cover Plate Issues; Growth in Rubin GPU and ASIC Demand to Boost Liquid Cooling Revenue in 2026.

— 駿HaYaO (@QQ_Timmy) October 4, 2025

The market previously rumored that cooling for the Rubin GPU (TDP 2.3kW) might adopt a microchannel cover plate (MCL), but recent updates… pic.twitter.com/JFCj1Yrc6C

¿Qué son las “microchannel cover plates” y por qué importan ahora?

Las placas de microcanales (o MCCP) son, a grandes rasgos, una evolución de las placas frías tradicionales que ya se usan en bastidores de alto rendimiento. Igual que los entusiastas del overclock conocen el “direct-die cooling” en CPUs modernas, las MCCP acercan el fluido todo lo posible al dado del chip, mediante canales microscópicos labrados —típicamente— en cobre. Esos microcanales elevan la convección local y reducen la resistencia térmica entre el dado y el líquido, lo que se traduce en menores temperaturas de unión o, dicho de otra forma, más margen para sostener frecuencias y cargas durante más tiempo.

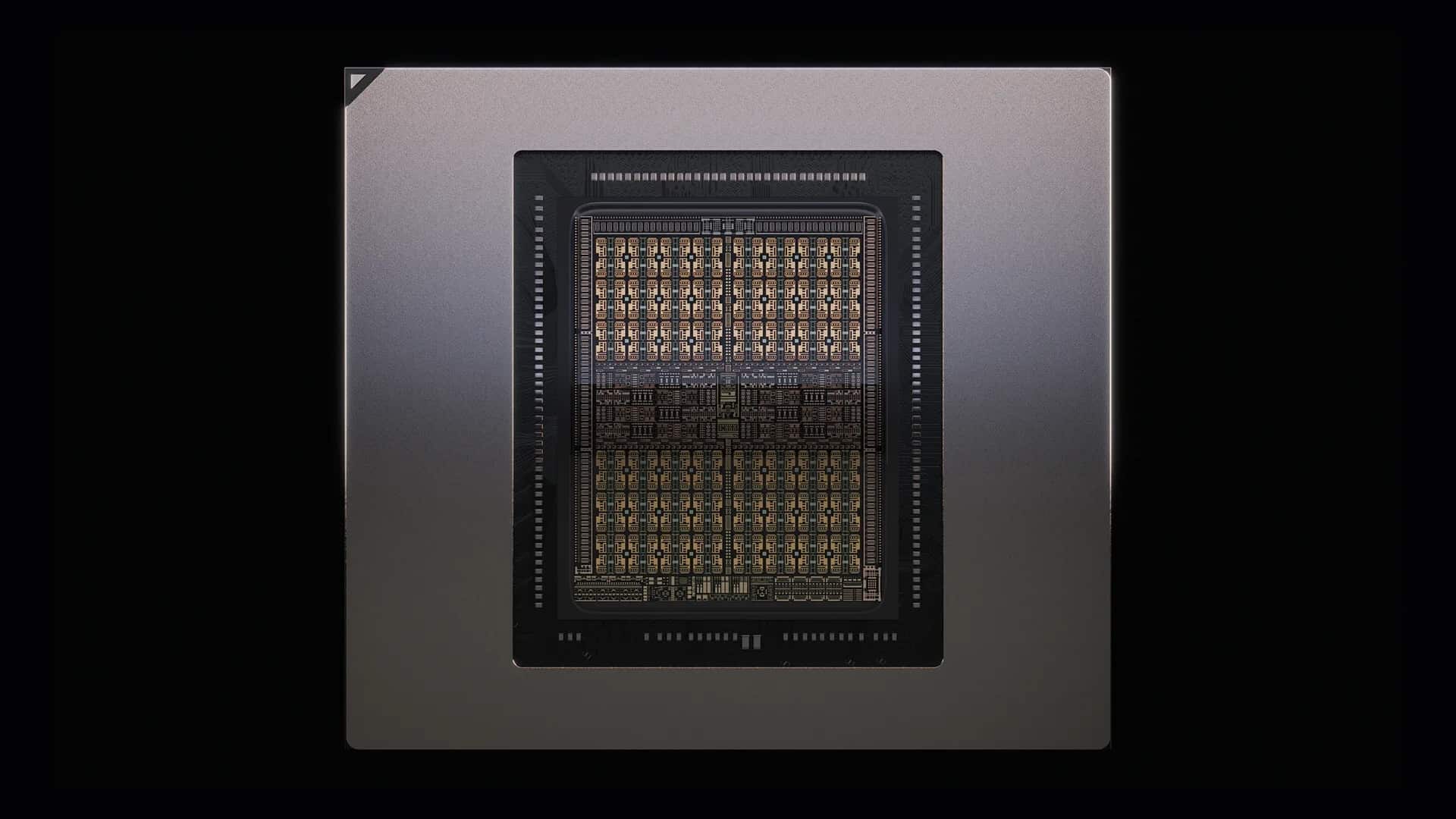

La diferencia con una placa líquida convencional no es cosmética: aquí el diseño interno —anchura y altura de canal, geometría, rugosidad, distribución— se optimiza para atacar puntos calientes del dado y homogeneizar el flujo. Es exactamente el tipo de detalle que marca la diferencia cuando hablamos de aceleradores con decenas de miles de núcleos, múltiples stacks de HBM y interconexiones que suman terabytes por segundo. En la documentación de NVIDIA han aparecido referencias a Rubin Ultra en configuraciones NVL orientadas a la inferencia FP4 del orden de 15 EF y enlaces de hasta 115,2 TB/s (CX9 8x). Cifras así no solo impulsan la potencia de cálculo: también suben la factura térmica.

De Blackwell a Rubin: por qué la refrigeración marca el paso

La cadencia de producto de la compañía no deja mucho margen para respirar. Cada salto —Ampere, Hopper, Blackwell, y ahora Rubin— ha traído mejoras en arquitectura, memoria y redes… y, casi siempre, más consumo agregado a nivel sistema. No es únicamente la GPU: son las topologías a escala rack, los backplanes, los switches y la suma de todo el hardware que acompaña a los aceleradores en un “pod” de IA moderno. A ese nivel, pensar solo en aire ya no encaja; y líquida tradicional puede no ser suficiente cuando se quiere compactar más sin renunciar a la estabilidad.

De ahí que, según las filtraciones, NVIDIA habría contactado con proveedores de térmicas para integrar D2C a través de microcanales en Rubin Ultra. Uno de los nombres que suena es Asia Vital Components (AVC), un fabricante taiwanés con experiencia en soluciones de refrigeración. La idea no sería completamente nueva —la empresa ya trabaja con placas frías en varios chasis—, pero sí supondría un paso adelante en eficiencia con respecto a los diseños actuales.

Conviene matizar el timing: la misma fuente apunta a que este enfoque habría estado encima de la mesa para Rubin, pero que los plazos han sido muy ajustados para migrar toda la cadena de suministro —diseño, materiales, pruebas de presión, manifolds, filtrado, mantenimiento— y, por eso, se habría empujado a Rubin Ultra.

Microcanales “direct-to-chip”: ventajas y compromisos

Lo bueno

- Resistencia térmica menor: al acercar el fluido al silicio, el gradiente de temperatura mejora, y también la uniformidad en el dado.

- Rendimiento sostenido: menor throttling bajo cargas largas; más fácil mantener boost sin penalizar vértices calientes.

- Densidad: permite compactar más en el rack sin sacrificar fiabilidad.

- Performance/Watt: la eficiencia térmica se traduce en mejor aprovechamiento de cada vatio.

Lo que hay que resolver

- Pérdida de carga: microcanales implican más presión y, por tanto, bombas dimensionadas y filtrado más fino para evitar obstrucciones.

- Materiales: compatibilidades (cobre, juntas, aditivos del fluido) para minimizar corrosión y degradación.

- Mantenimiento: procedimientos de servicio, pruebas de estanqueidad, sustitución de módulos y limpieza del circuito.

- Integración: manifolds, quick-disconnects, sensórica (caudal, presión, fugas) y monitorización integradas con el BMC del sistema.

Estas consideraciones no son nuevas en HPC. La direct-to-chip convive con otras aproximaciones —inmersión de 1 o 2 fases, o la microfluídica que ha anunciado Microsoft—, y cada una trae su propio equilibrio entre eficiencia, complejidad y operativa. Lo relevante es que el punto de partida del sector ya no es “¿pasamos a líquida?”, sino “qué líquida y con qué arquitectura”.

¿Qué diferencia la microfluídica “in-chip” de Microsoft?

La propuesta de Microsoft empuja más allá del contacto placa-dado para colocar el fluido “dentro” o por la cara trasera del silicio (backside cooling). Es un concepto más agresivo en términos de fabricación y packaging, y que puede ofrecer ventajas cuando el calor debe evacuarse desde múltiples capas del chip (piénsese en apilamientos 3D). Las placas de microcanales de NVIDIA —si se confirman— optarían por un enfoque más pragmático: optimizar la placa fría que ya forma parte de los sistemas, recortando resistencias y mejorando convección sin invadir el stack del dado.

Ambos caminos no son excluyentes. Es plausible que, con el tiempo, veamos combinaciones —microcanales en placa y mejoras en la cara trasera del chip— cuando arquitecturas y proveedores estén listos.

De la placa a la sala: implicaciones para el centro de datos

Para los operadores, este movimiento trae preguntas prácticas:

- Planta de agua: ¿qué temperaturas de entrada/salida piden estos sistemas? A mayor temperatura de retorno, mejor para el PUE del edificio.

- Circuito secundario: ¿presiones y caudales por “pod”? ¿Filtrado necesario para microcanales?

- Detección de fugas y trazabilidad: sensórica y telemetría integrada con el BMC y el DCIM.

- Servicio: tiempos y herramientas para sustituir un módulo sin parar el chasis (conexiones quick-disconnect, dripless).

- Compatibilidad: ¿se pueden mezclar en la misma fila sistemas de inmersión con direct-to-chip? ¿Qué sistemas de manifold permiten crecer sin rehacer?

Nada de lo anterior es insalvable. De hecho, muchas instalaciones HPC de referencia llevan años operando con D2C y inmersión. La novedad es que ahora hablamos de escala IA, con pods que pueden pasar de decenas a cientos de kW por rack, y con cadenas de suministro que deben estandarizar y masificar componentes.

Socios, calendario y lo que falta por ver

El nombre de Asia Vital Components (AVC) ha circulado como socio térmico para las MCCP de Rubin Ultra. Según las mismas fuentes, el plan era llegar con esta tecnología a Rubin, pero los tiempos han empujado la migración hacia Rubin Ultra. NVIDIA, por su parte, mantiene su ritmo de iteraciones sin dar detalles públicos sobre fechas o configuraciones finales.

Más allá de filtraciones, hay señales que conviene vigilar:

- Anuncios conjuntos con fabricantes de placas frías y ODM de chasis.

- Guías de referencia para manifolds, sensores y servicio.

- Especificaciones térmicas en futuras notas de NVL (tanto en W como en temperaturas de entrada).

- Comparativas de PUE/TUE y rendimiento sostenido entre Rubin y Rubin Ultra.

- Ecosistema: si otros hiperescalares siguen la senda D2C de microcanales o microfluídica in-chip.

Lectura de fondo: rendimiento por vatio y coste total

La justificación de este cambio no es estética. Si las MCCP logran bajar la resistencia térmica de forma significativa, NVIDIA puede sostener mayores boosts y cargas sin comprometer fiabilidad del silicio ni del HBM. En un entorno donde el cómputo se compra por tiempo y el aire condiciona el ratio de utilización, cualquier mejora térmica impacta en el TCO del cliente: más trabajo por unidad de energía, y menos ventana para el throttling cuando la sala calienta.

Es un círculo virtuoso si la operación acompaña: menores temperaturas, presiones y caudales dimensionados con cabeza, mantenimiento previsto y telemetría fina para adelantarse a sedimentos o microfugas. El riesgo de ir demasiado rápido —sin preparar plantas, procedimientos y repuestos— es abrir incidencias donde no hace falta.

Conclusión

Nada simboliza mejor el punto en el que está la IA que este giro a la refrigeración de precisión. Rubin Ultra apunta a más cómputo, más ancho de banda y más densidad; NVIDIA parece dispuesta a responder con microcanales direct-to-chip para domar el térmico sin frenar la cadencia. Y no está sola: la microfluídica en in-chip de Microsoft confirma que la batalla por el vatio útil ya es, también, una batalla de ideas de ingeniería.

Los próximos meses dirán si este salto se traduce en productos y procedimientos sólidos a escala. Pero el mensaje ya es claro: en la carrera por el rendimiento por vatio, la placa fría ha dejado de ser un accesorio para convertirse en tecnología estratégica.

Preguntas frecuentes

¿Qué es exactamente una placa de microcanales (MCCP) y en qué mejora a una placa fría convencional?

Una MCCP es una placa —normalmente de cobre— con canales microscópicos por donde circula el fluido justo encima del dado. Esa geometría aumenta la convección y reduce la resistencia térmica frente a placas con cavidades más simples, permitiendo temperaturas de unión más bajas y rendimiento sostenido superior.

¿Qué significa refrigeración “direct-to-chip” para un centro de datos de IA?

Supone llevar líquido a nivel de chip mediante manifolds y quick-disconnects, con sensores de caudal/presión/fugas. Requiere plantas de agua templada, filtrado fino y procedimientos de servicio. A cambio, aporta densidad, eficiencia y menos throttling.

¿En qué se diferencia la microfluídica “in-chip” de Microsoft del enfoque de NVIDIA?

La microfluídica in-chip sitúa el fluido dentro o en la cara trasera del silicio, mientras que el enfoque de placas de microcanales optimiza la placa fría que contacta con el chip. Ambas buscan mejorar el intercambio; su implantación y complejidad son distintas.

¿Por qué suben tanto los requisitos térmicos de Blackwell a Rubin?

Cada generación añade cómputo, memoria e interconexión. Ese salto eleva el consumo agregado de cada sistema (no solo de la GPU), sobre todo en pods a escala rack. De ahí la necesidad de soluciones térmicas más eficientes como D2C con microcanales.

vía:wccftech