El nuevo informe de Morgan Stanley Research ha puesto cifras al negocio de la IA de inferencia, y los resultados confirman lo que el mercado intuía: NVIDIA mantiene una ventaja abismal sobre sus competidores, no solo en potencia de hardware, sino en rentabilidad empresarial.

La “fábrica de inferencia” como unidad de negocio

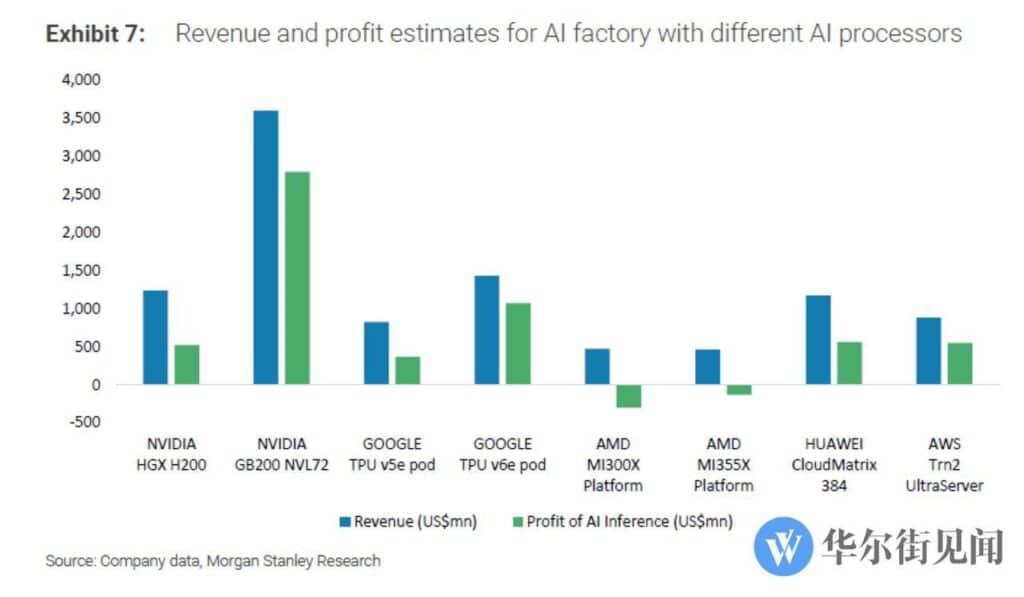

El estudio utiliza un modelo estandarizado que simula una “AI inference factory” de 100 MW, equivalente a un centro de datos de tamaño medio, para medir el coste total de propiedad (TCO) y los ingresos derivados de procesar tokens en modelos de lenguaje y aplicaciones de IA.

En este marco, el análisis arroja un promedio global de más del 50 % de margen operativo para los grandes proveedores, lo que convierte la inferencia en uno de los segmentos más lucrativos de la economía digital.

NVIDIA: el líder absoluto

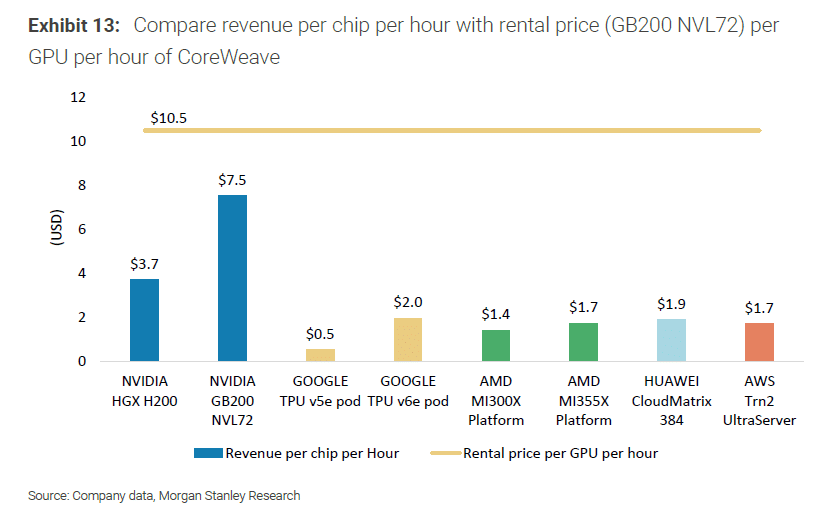

La plataforma GB200 NVL72 Blackwell de NVIDIA lidera con un 77,6 % de margen y beneficios estimados de 3.500 millones de dólares en un despliegue tipo. Esta cifra no solo refleja la potencia de cómputo y memoria del hardware, sino también la solidez del ecosistema CUDA y las optimizaciones en soporte a FP4, que elevan la eficiencia por vatio frente a cualquier rival.

Morgan Stanley destaca además el “efecto fine wine” que la compañía consigue con sus GPUs: incluso generaciones anteriores, como Hopper, mantienen mejoras periódicas gracias al software.

Google y AWS: alternativas sólidas

En segunda posición se sitúa Google TPU v6e, con un 74,9 % de margen, demostrando la capacidad de un proveedor cloud para rentabilizar su apuesta por hardware propietario y estrecha integración de software.

El tercer lugar lo ocupa AWS Trn2 UltraServer, con un 62,5 %, consolidando la estrategia de Amazon de diversificación frente al dominio de NVIDIA.

Huawei, con su plataforma CloudMatrix 384, también aparece en positivo con un 47,9 %, reforzando su posición en el mercado asiático.

AMD: la gran decepción

El contraste más llamativo lo protagoniza AMD. Su plataforma más reciente, MI355X, registra un margen negativo del -28,2 %, mientras que la anterior MI300X cae hasta un -64,0 %.

El problema no radica tanto en los costes iniciales: el TCO de MI300X alcanza 744 millones de dólares, prácticamente a la par con el GB200 de NVIDIA (800 millones). La diferencia es que la eficiencia en tareas de inferencia no logra generar ingresos suficientes para cubrir la inversión, lo que la convierte en un negocio deficitario en el escenario modelado.

Un negocio del presente y del futuro

El informe subraya que la inferencia representará el 85 % de la cuota de mercado de la IA en los próximos años, lo que refuerza la importancia de la posición de NVIDIA. Además, la compañía ya prepara su siguiente salto: la arquitectura Rubin, prevista para entrar en producción en 2026, con posteriores iteraciones Rubin Ultra y Feynman.

AMD, por su parte, intentará responder con su MI400, programado para competir directamente con Rubin. Mientras tanto, impulsa la iniciativa UALink, un estándar abierto de interconexión que busca ofrecer una alternativa a NVLink, aunque la batalla por la adopción de ecosistemas aún está en curso.

La batalla de los márgenes y la estrategia empresarial

La conclusión es clara: NVIDIA no solo domina el terreno técnico, también el financiero. Al ofrecer retornos significativamente más altos con costes similares a sus competidores, se convierte en la apuesta preferida para operadores de centros de datos y proveedores de servicios de IA.

Google y AWS demuestran que los hiperescalares con hardware propio pueden jugar en la élite, mientras que Huawei asegura rentabilidad en su mercado doméstico. AMD, en cambio, se enfrenta a una brecha que no se cerrará únicamente con mejoras de hardware: su desafío es construir un ecosistema de software que iguale la madurez de CUDA.

Preguntas frecuentes (FAQ)

1. ¿Qué es una “AI inference factory”?

Es un modelo conceptual de centro de datos de 100 MW dedicado a inferencia de IA, usado por Morgan Stanley para comparar costes, ingresos y márgenes de diferentes plataformas.

2. ¿Por qué NVIDIA logra márgenes tan altos?

Gracias a la combinación de hardware avanzado (GB200 Blackwell), soporte a FP4 y un ecosistema de software optimizado (CUDA), que maximiza la eficiencia del hardware.

3. ¿Qué papel juegan Google y AWS en este mercado?

Ambos logran márgenes superiores al 60 % gracias a sus arquitecturas propietarias, demostrando que la integración vertical puede competir con NVIDIA en rentabilidad.

4. ¿Por qué AMD pierde dinero en inferencia?

Aunque sus chips son potentes, la falta de un ecosistema de software maduro y optimizaciones comparables a CUDA reduce drásticamente la eficiencia en cargas de inferencia, generando márgenes negativos.

5. ¿Qué impacto tiene esto en el futuro del mercado de IA?

Con la inferencia representando el 85 % de la cuota futura, los resultados sugieren que NVIDIA mantendrá su hegemonía salvo que AMD u otros actores logren cerrar la brecha en software y eficiencia.

Morgan Stanley: AI inference is an incredibly profitable business. In its newly released report, the firm used a detailed financial model to calculate, for the first time from an economic perspective, the profitability of global AI compute competition. The conclusion is that… pic.twitter.com/j8GpKzYYRD

— Jukan (@Jukanlosreve) August 16, 2025

vía: WallStreetCN y Jukanlosreve