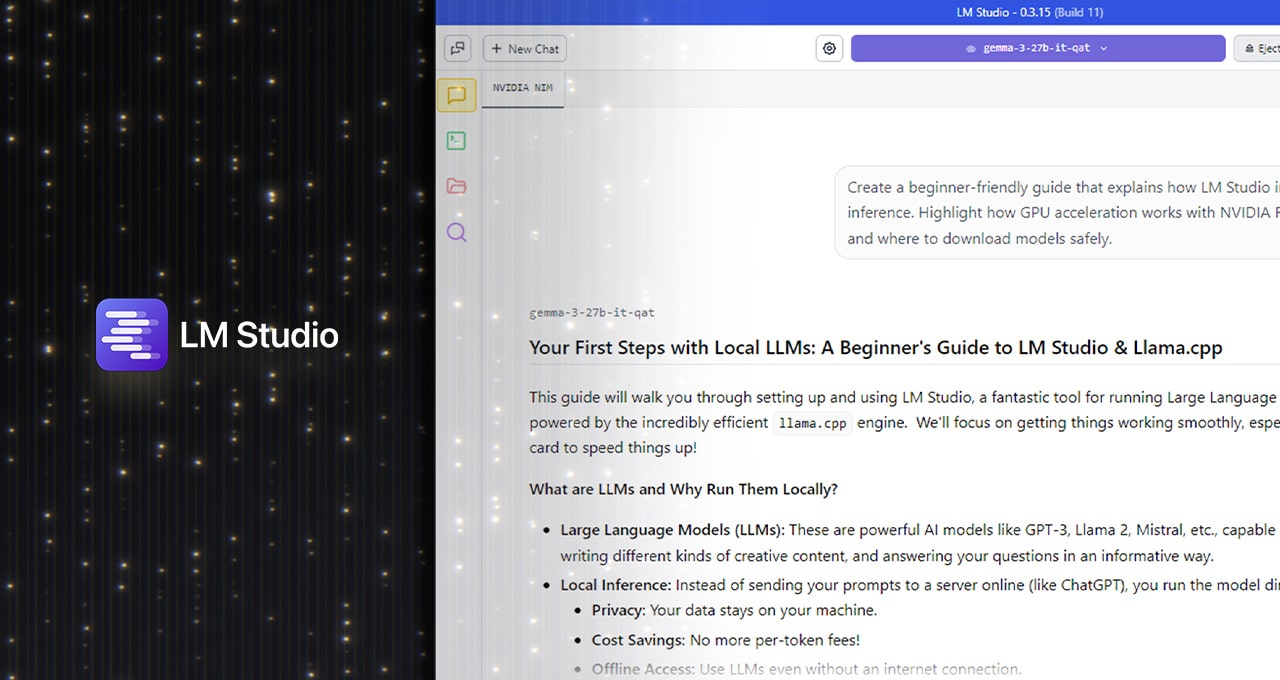

En un contexto donde la inteligencia artificial generativa se convierte en parte del día a día de desarrolladores, investigadores y usuarios avanzados, la posibilidad de ejecutar modelos de lenguaje (LLM) localmente ha pasado de ser una opción experimental a una alternativa madura, potente y con ventajas claras. En esta transformación, LM Studio se posiciona como uno de los entornos más versátiles y accesibles para ejecutar modelos de IA en local, sin depender de servicios en la nube.

Con la llegada de su versión 0.3.15, LM Studio se integra de forma nativa con CUDA 12.8, la última versión del entorno de ejecución de NVIDIA, lo que permite sacar el máximo rendimiento a las GPUs RTX, desde la serie RTX 20 hasta las más recientes con arquitectura Blackwell. El resultado: tiempos de inferencia más rápidos, mejor uso de los recursos del sistema y una experiencia optimizada para IA generativa directamente en PCs personales.

Ventajas de ejecutar LLMs en local con LM Studio

La ejecución local de modelos de lenguaje trae consigo una serie de beneficios estratégicos frente al enfoque basado en la nube:

- Privacidad total: los datos del usuario no salen del equipo.

- Latencia mínima: respuestas casi instantáneas, sin depender de la red.

- Costo reducido: sin tarifas por uso o límites de API externos.

- Integración flexible: conexión con flujos de trabajo personalizados, editores de texto, asistentes locales, y más.

LM Studio, basado en la eficiente librería llama.cpp, permite desplegar modelos populares como Llama 3, Mistral, Gemma u Orca en distintos formatos de cuantización (Q4_K_M, Q8_0, full precision…), adaptándose a múltiples configuraciones de hardware.

CUDA 12.8: la clave para desbloquear el rendimiento en RTX

La nueva integración de CUDA 12.8 permite a LM Studio aprovechar innovaciones específicas para GPUs RTX:

| Optimización | Descripción técnica | Beneficio práctico |

|---|---|---|

| CUDA Graphs | Consolidación de múltiples operaciones GPU en un solo flujo de llamadas | +35 % en eficiencia de procesamiento |

| Flash Attention (kernels dedicados) | Algoritmo optimizado para el manejo de la atención en transformers | Hasta +15 % en rendimiento en contextos largos |

| Offload completo a GPU | Todas las capas del modelo se ejecutan en la GPU | Reducción de cuellos de botella en CPU |

| Compatibilidad con toda la gama RTX | Desde RTX 2060 hasta RTX 5090 y las nuevas Blackwell | Aceleración escalable en PCs y estaciones de trabajo |

Estos avances se reflejan en los benchmarks más recientes sobre modelos como DeepSeek-R1-Distill-Llama-8B, donde se ha registrado una mejora de rendimiento del 27 % respecto a versiones anteriores de LM Studio, únicamente gracias a las optimizaciones en CUDA y llama.cpp.

Nuevas funciones para desarrolladores avanzados

LM Studio 0.3.15 no solo mejora el rendimiento, sino que también refuerza sus capacidades para desarrolladores:

- Editor de prompts mejorado: permite gestionar prompts más largos, con mejor organización y persistencia.

- Parámetro

tool_choice: control granular sobre el uso de herramientas externas por parte del modelo, esencial para RAG (retrieval-augmented generation), agentes inteligentes o sistemas estructurados. - Modo API OpenAI-compatible: permite conectar LM Studio a flujos de trabajo como si fuera un endpoint estándar, ideal para plugins, asistentes o herramientas como Obsidian, VS Code o Jupyter.

Casos de uso reales y ejemplos prácticos

Gracias a su diseño modular y su facilidad de uso, LM Studio es ya una herramienta clave en entornos como:

- Desarrolladores de software: integración con editores para generar, completar o depurar código con modelos como Llama 3 o Codellama.

- Estudiantes e investigadores: uso de LLMs para resumen de textos, preguntas-respuestas o exploración semántica de documentos PDF.

- Creadores de contenido: generación de ideas, titulares, descripciones o contenidos largos sin salir del entorno local.

- Usuarios avanzados de Linux o macOS: gracias a la compatibilidad multiplataforma y al soporte de múltiples runtimes.

Cómo activar el runtime de CUDA 12.8 en LM Studio

Configurar LM Studio para usar la aceleración RTX con CUDA 12.8 es sencillo:

- Descargar LM Studio desde su sitio oficial.

- En el panel izquierdo, ir a Discover > Runtimes.

- Seleccionar CUDA 12 llama.cpp (Windows) o correspondiente a tu sistema y descargar.

- Establecerlo como runtime predeterminado en el menú de configuración.

- Cargar un modelo, ir a Settings, activar Flash Attention y ajustar el “GPU Offload” al máximo.

Una vez realizado este proceso, la inferencia local quedará acelerada por hardware con el máximo rendimiento disponible.

Conclusión: el futuro de la IA personal es local y acelerado

El despliegue local de LLMs está dejando de ser un experimento para convertirse en una solución práctica, potente y escalable. LM Studio, en combinación con GPUs NVIDIA RTX y CUDA 12.8, ofrece una de las plataformas más sólidas del mercado para quienes buscan ejecutar inteligencia artificial de forma privada, rápida y personalizada.

Ya sea para crear un asistente local, integrar IA en tu flujo de desarrollo o simplemente explorar las posibilidades de los modelos de lenguaje, LM Studio es una puerta de entrada ideal. Con soporte activo de la comunidad, mejoras constantes y total libertad para personalizar, representa el equilibrio perfecto entre rendimiento, accesibilidad y control.

Fuente: Noticias inteligencia artificial