Un equipo del Institute of Science Tokyo presenta un método que traduce la información de estado del canal (CSI) de redes Wi-Fi al espacio latente de un modelo de difusión y genera imágenes RGB de alta resolución del entorno, con eficiencia y control por texto.

¿Puede el Wi-Fi “ver” a través de los cambios que las personas y objetos introducen en el canal de radio? La idea lleva años rondando en laboratorios: del reconocimiento de actividades al seguimiento de respiración con anchos de banda suficientes. Lo que faltaba era dar el salto a reconstrucciones visuales de alta resolución sin recurrir a costosos entrenamientos ad hoc ni a arquitecturas complejas. Ahí es donde entra LatentCSI, un enfoque que toma la CSI (Channel State Information) de un enlace Wi-Fi multicarrier, la mapea a un espacio latente y deja que un modelo de difusión latente preentrenado haga el resto, incluida la guía por texto para afinar estilos o elementos de la escena.

Firmado por Eshan Ramesh y Takayuki Nishio (School of Engineering, Institute of Science Tokyo), el trabajo —“High-resolution efficient image generation from WiFi CSI using a pretrained latent diffusion model”— describe un sistema que evita generar píxel a píxel. En vez de eso, entrena una red ligera para predecir directamente el embedding latente que un LDM (como Stable Diffusion) esperaría tras codificar una imagen. A partir de ahí, el pipeline conocido del LDM denoisea en el espacio latente (opcionalmente con instrucciones de texto) y decodifica a imagen.

Qué resuelve LatentCSI y por qué importa

Los intentos previos de “ver” con Wi-Fi apostaron por GANs o VAE sofisticados: dos redes enfrentadas, calibración cuidadosa, entrenamientos inestables… y salidas limitadas en resolución. Además, el aprendizaje end-to-end sobre imágenes reales tiende a memorizar detalles, con riesgos de privacidad: rasgos faciales, backgrounds reconocibles, etc.

LatentCSI simplifica:

- Una sola red (el codificador CSI) aprende a predecir el embedding latente que produciría el VAE de un LDM para la imagen emparejada.

- Se trabaja siempre en latente (mucho más compacto que el espacio de píxeles), con menos coste y menos memoria.

- El cuello de botella dimensional reduce la probabilidad de reconstruir detalles sensibles (caras, textos), y la guía por texto del LDM permite reconstruir/estilizar lo necesario (ropa, estilo de la escena, apariencia general) de forma controlada.

Resultado: mejor calidad perceptual frente a baselines de complejidad similar que predicen píxeles, más eficiencia de cómputo y control por texto sin pasos extra de codificación de imagen.

Cómo funciona (sin humo): del CSI al espacio latente

- Datos pareados en entrenamiento: CSI + imagen (la cámara solo se usa en training para tener la referencia; en despliegue se infiere solo con CSI).

- Un VAE preentrenado del LDM codifica la imagen en un embedding latente μ (en la práctica, usan la media del posterior gaussiano, ya que la varianza predicha es despreciable).

- El codificador CSI (fw(x)) se entrena para regresar μ a partir del amplitud-CSI (evitan fase para simplificar y por robustez con dispositivos no sincronizados).

- En inferencia, el LDM añade ruido controlado al embedding (parámetro “strength”) y denoisea con condicionamiento de texto (si se desea), antes de decodificar a imagen RGB.

La clave es que solo se entrena el codificador CSI; el LDM (U-Net de denoising, VAE y text encoder) se reutiliza sin finetuning. Así se abarata el entrenamiento y se hereda la calidad perceptual del LDM.

Datasets y evaluación: menos píxeles, más percepción

Los autores validan LatentCSI en dos conjuntos de datos:

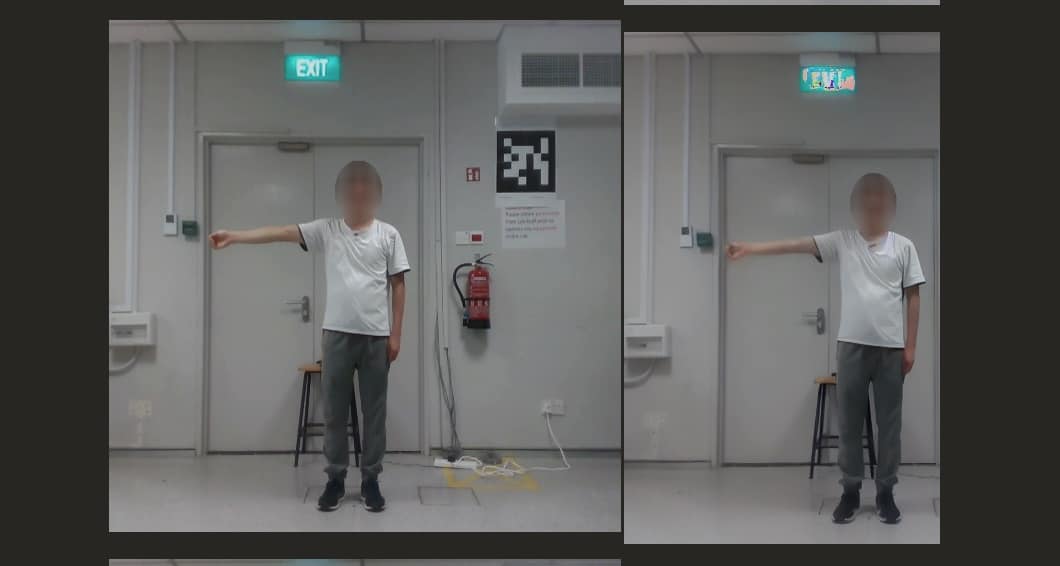

- Dataset 1: entorno realista con una persona en movimiento, oclusiones frecuentes y diversidad de vistas. CSI a 10 Hz durante 25 minutos con dos NUC y Intel AX210 (canal 160 MHz, 1×1, 1.992 subportadoras con FeitCSI). Imagen 640×480 reescalada a 512×512.

- Dataset 2 (MM-Fi, subconjunto): más consistencia visual (posición fija, fondo estable), 3 antenas, 40 MHz × 114 subportadoras (total 342), centrado en poses y movimientos de brazos.

Métricas

Comparan con un baseline que predice directamente píxeles con arquitectura y procedimiento equivalentes (salvo salida), y con CSI2Image (GAN híbrida). Miden RMSE y SSIM (fidelidad estructural) y FID (calidad perceptual) tanto en imagen completa como en recortes de personas (detectadas con YOLOv3).

- En el Dataset 1, LatentCSI supera con claridad en FID (mejor percepción), con tiempos de entrenamiento notablemente menores que el baseline de píxel por la salida de baja dimensión.

- En MM-Fi, el baseline brilla en RMSE/SSIM (escena repetitiva favorece “memorizar”), pero LatentCSI vuelve a ganar en FID, y más aún al centrarse en las personas. La GAN híbrida queda atrás en ambos escenarios.

Más allá de números, los autores señalan que las salidas de LatentCSI son mejores puntos de partida para el refinamiento por difusión (ajustes con “strength” y prompt), mientras que el baseline subentrena o artefacta con facilidad al escalar resolución.

Privacidad y control: por qué el “cuello de botella” ayuda

Un aspecto especialmente interesante es la tensión entre utilidad y privacidad. El paso por latente evita arrastrar microdetalles potencialmente identificables (un rostro nítido o un texto legible en el fondo), pero al mismo tiempo permite reconstrucciones verosímiles y ediciones guiadas por texto (“fotografía de una persona en una sala pequeña, 4K, realista”; “dibujo estilo anime en laboratorio”, etc.). Es decir, se conserva la correspondencia con el CSI (qué hay y dónde, a nivel semántico), mientras el LDM sintetiza los detalles visuales bajo control del usuario.

Para implantaciones sensibles (salud, oficinas, hogares), este enfoque reduce riesgos por diseño, frente a pipelines que “clavan” la imagen original.

Limitaciones y realismo

LatentCSI asume que existe información suficiente en el CSI para emplazar objetos y personas con coherencia visual, lo cual depende de la escena, la geometría TX/RX, el ancho de banda y la SNR. También requiere pares CSI-imagen durante el entrenamiento (p. ej., fase de calibración con cámara), aunque inferencia funcione solo con CSI. Por último, el LDM preentrenado aporta capacidad perceptual aprendida del mundo (no del CSI), y eso, si no se controla, puede alucinar detalles estilísticos; de ahí la guía por texto y el ajuste de “strength” para marcar el grado de libertad durante el denoising.

Qué aporta al estado del arte

- Arquitectura simple: un codificador CSI → embedding latente → pipeline LDM reutilizado.

- Eficiencia: entrenar en latente reduce costo y memoria y acelera épocas frente a predecir píxeles.

- Calidad perceptual: mejor FID y coherencia semántica con escenas dinámicas.

- Control: prompts de texto para editar/estilizar sin codificar imagen (no hay img2img tradicional).

- Privacidad por diseño: menor probabilidad de reproducir rasgos sensibles; contenido plausible bajo control explícito.

Cómo se insertaría en productos reales

- Seguridad/IoT: monitorización no intrusiva de habitaciones sin cámaras activas en operación; alertas semánticas (“persona de pie junto a la puerta”).

- Smart-home/Asistencia: detección de caídas o presencia con feedback visual sintético para el operador humano sin exponer a la persona real.

- Retail/Logística: distribución de objetos o actividad en pasillos sin cámaras, con reconstrucción visual controlada.

- Robótica/Edge: mapas semánticos rápidos desde radio en lugares donde la visión falla (humo, baja luz).

Siempre con calibración inicial y evaluación legal: aunque la reconstrucción no sea fotográfica, es una representación de personas/espacios y requiere consentimiento, información y controles.

Preguntas frecuentes

¿Necesita cámara en producción?

No. La cámara solo se usa en entrenamiento para emparejar CSI e imagen y enseñar al codificador CSI el embedding latente correcto. En producción, infiere solo con CSI.

¿Qué modelo de difusión usa?

El enfoque trabaja con un modelo de difusión latente preentrenado (p. ej., Stable Diffusion). El codificador CSI se entrena para imitar el embedding que produciría el VAE de ese LDM, y luego se usa el denoiser y el decoder preexistentes.

¿Es “ver a través de paredes”?

El CSI recoge la huella del entorno (reflexiones, multitrayecto). Con disposiciones adecuadas y suficiente banda puede detectar presencia y estructuras. Sin embargo, el método no promete visión fotográfica tras paredes; sintetiza una imagen plausible alineada con el CSI y el prompt, con límites físicos claros.

¿Qué pasa con la privacidad?

El cuello de botella latente dificulta reconstruir rasgos sensibles. Además, la guía por texto permite anonimizar/estilizar (p. ej., estilo cartoon) o evitar reproducir caras y letreros. Aun así, al ser representaciones de personas/espacios, exige cumplir normativa, consentimientos y buenas prácticas.

¿Qué calidad cabe esperar en escenas reales y ruidosas?

En entornos dinámicos y con oclusiones, LatentCSI mostró mejor calidad perceptual que baselines similares y menos coste de entrenamiento. La fidelidad exacta dependerá del ancho de banda, geometría, SNR y calibración; ajustes de “strength” y prompts ayudan a equilibrar realismo y control.

Créditos y soporte: el trabajo cita financiación de JSPS KAKENHI y JST ASPIRE, y uso del supercomputador TSUBAME4 (Institute of Science Tokyo). El código y los datasets de terceros mencionados incluyen MM-Fi y herramientas como FeitCSI.