La fiesta de las gangas en memoria y almacenamiento ha terminado. Lo que empezó como un rebote tras el desplome de 2022–2023 se ha convertido en una escasez amplia y persistente que ya afecta a DRAM, NAND flash y HDD a la vez, algo poco habitual en la última década. El motivo de fondo es claro: los centros de datos de IA están devorando la capacidad mundial a un ritmo que fabricantes y foundries no pueden —o no quieren— ampliar con la misma velocidad, tras años de ciclos traumáticos de sobreinversión y derrumbe de precios.

El resultado es un estrangulamiento que toca todos los segmentos: desde módulos DDR4 y SSD de consumo hasta arreglos all-flash para empresas y HDD nearline de alta capacidad. Los hiperescalares (grandes nubes) se apropian de la oferta prioritaria con contratos a varios años, mientras el resto del mercado compite por lo que queda… a precios crecientes.

De la sobreoferta al racionamiento: cómo se dio la vuelta el mercado

En 2022 y principios de 2023 tanto NAND como DRAM se vendían por debajo de coste. Los fabricantes reaccionaron con recortes drásticos de producción, que vaciaron inventarios y —ya en el 2.º semestre de 2023— dispararon los precios spot y de contrato. En NAND, por ejemplo, los 512 Gb TLC duplicaron su precio en apenas seis meses, y enseguida se vio en la estantería: un SSD de 2 TB que en Navidad rondaba los 120 $ pasó a 175–180 $ en cuestión de semanas.

En DRAM, el giro llegó con un trimestre de retraso, pero el patrón fue el mismo: los DDR4 de PC, que parecían liquidación en 2023, se toparon con oferta menguante cuando las líneas empezaron a cerrarse. Para Q3 2025 algunos analistas proyectaban +38–43 % trimestral en DDR4 de PC y +28–33 % en servidor. GDDR también se tensó: con el salto a GDDR7 de la próxima generación de GPU, GDDR6 subió ~30 %. DDR5 ha escalado más despacio, pero con tendencia al alza.

Los HDD —tradicional válvula de escape cuando la flash sube— no han escapado: fabricantes notificaron subidas del 5–10 % y, según firmas de seguimiento, los nearline de alta capacidad registran escasez y plazos que se alargan más de un año en ciertas capacidades. Al faltar nearline, parte de las cargas “warm data” han migrado a flash (QLC), apretando aún más la NAND.

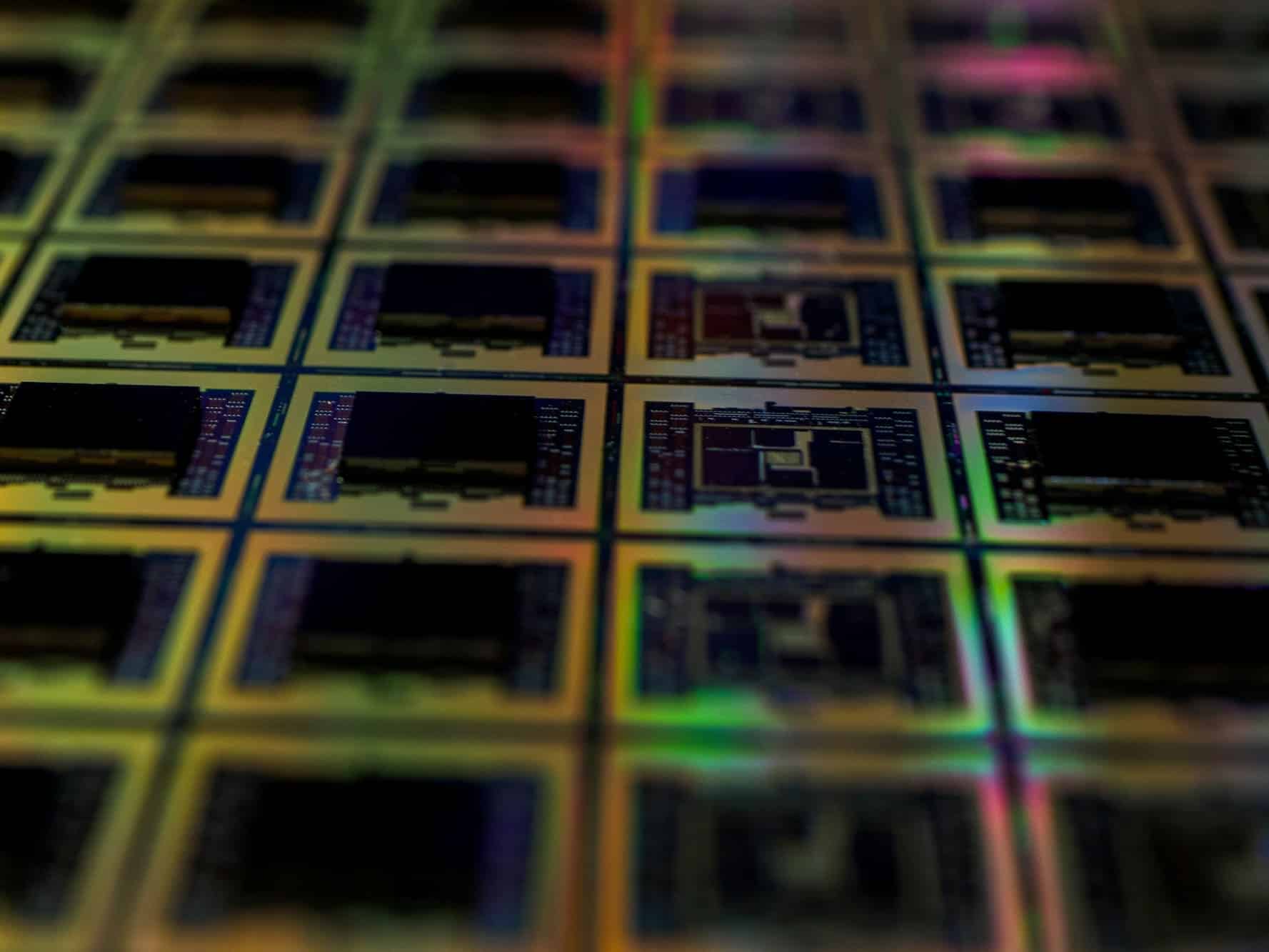

La razón principal: la “dieta” de los centros de datos de IA

Cada ciclo de memoria tiene su detonante. Hubo una época en que fueron los smartphones; luego, los portátiles SSD; más tarde, el cloud. Ahora es la IA. Entrenar modelos de lenguaje y servir inferencias a escala exige cientos de GB de DRAM y varios TB de flash por nodo de GPU, y miles de nodos por clúster. El hambre de memoria y almacenamiento es estructural, y se multiplica con cada nueva oleada de GPUs y tamaños de modelo.

La consecuencia: hiperescalares y laboratorios de IA bloquean suministro a años vista. Hay nodos de HBM de 2026 prevendidos casi al 100 %; líneas de V-NAND de próxima generación comprometidas antes de su lanzamiento; contratos que antes cubrían un trimestre ahora abarcan varios años. Lo que no va a HBM se destina a NAND QLC para arrays de empresa, dejando menos inversión para DRAM convencional y TLC de consumo.

El efecto cascada llega al usuario final. Ejemplo: Raspberry Pi anunció en octubre de 2025 una subida de 5–10 $ en variantes de 4 GB/8 GB por el encarecimiento de memoria, admitiendo que el coste por chip está ~120 % por encima del año anterior. Es la punta visible de una subida amplia que no perdona ni a la maker community.

¿Por qué los fabricantes no construyen más fabs?

Se están construyendo, pero no es rápido ni barato. Una fab de memoria greenfield cuesta decenas de miles de millones y tarda años en alcanzar volumen. Incluso ampliar líneas existentes supone meses de instalación y calibración de herramientas en un contexto donde ASML, Applied Materials y otros proveedores tienen carteras repletas y cuellos de botella.

Además, los fabricantes han aprendido que sobreinvertir en los picos de demanda suele acabar en colapso de precios (2019, 2022). Prefieren disciplina: vender menos a mejor margen antes que abrir el grifo y repetir el ciclo de ruina. Y ahora la prioridad es donde está el margen: HBM y nodos avanzados. Cada oblea que se destina a HBM es una menos para DRAM; cada ingeniero volcado en QLC empresarial es uno menos para TLC de consumo.

A esto se suma la geopolítica: controles de exportación en litografía y tierras raras (imanes de neodimio críticos para HDD), restricciones cruzadas entre grandes potencias, y escasez de talento especializado. El rompecabezas no se resuelve con un simple “construyamos más”.

Qué esperar por categoría

DRAM (DDR4, DDR5, HBM)

- DDR4: retirada más rápida que la caída de la demanda. Escasez en PC y servidor; alzas trimestrales de ~30–40 % vistas/referenciadas en el mercado.

- DDR5: sube de forma más moderada, pero en pendiente ascendente a medida que mainstreamiza.

- HBM: todo vendido en muchos fabricantes hasta 2026; foco prioritario de capex.

NAND (TLC, QLC, Enterprise)

- TLC de consumo: racionamiento; salto fuerte desde los mínimos de 2023.

- QLC empresarial: aceleración de despliegues para aliviar nearline → presión extra sobre supply.

- V-NAND de próxima generación: preasignada a clientes enterprise/hyperscale.

HDD (nearline y bulk)

- Nearline: plazos que se van a >12 meses en ciertas capacidades >20 TB; subidas del 5–10 % ya comunicadas por fabricantes.

- Sustitución por QLC en algunas cargas: alivia un cuello… y crea otro en NAND.

¿Cuánto puede durar?

Los más cautos hablan de “varios años” de tensión; hay voces que exageran con “una década” de supply tight. La verdad probablemente quede en medio y dependerá de tres vectores:

- Cadencia real de la IA: si la demanda se mantiene exponencial (entrenamientos más grandes, inferencias en todas partes), la absorción seguirá alta. Si hay pausas de compra tras stockpiling o eficiencia en modelos/infra (mejor uso por parámetro, sparsity, in-memory compute), el ritmo puede moderarse.

- Ejecución de fabs: cuánto volumen nuevo añaden HBM/DRAM y NAND en 2026–2027 y si llega a tiempo.

- Geopolítica y supply chain: equipos, materiales e imanes para HDD; subsidios y licencias; mano de obra.

En cualquier caso, 2025–2026 pinta como periodo de precios elevados y priorización del cliente empresarial. El consumidor queda a la cola: menos ofertas y capacidades más ajustadas.

Implicaciones prácticas (para cada perfil)

Consumidores y PC builders

- SSD: las “gangas” de 1–2 TB a precio de derribo no volverán a corto plazo. Si necesitas ampliar, compra cuando lo encuentres a precio razonable.

- RAM: DDR4 subirá más que DDR5; si aún estás en DDR4, valora cerrar la ampliación cuanto antes.

- Estrategia: prioriza capacidad sobre velocidad marginal; evalúa 2×16 GB frente a 2×8 GB, y 2 TB TLC frente a 1 TB “tope de gama”.

Pymes y mid-market

- Planificación: plazos más largos; previsiones trimestrales ya no bastan.

- Capex: reserva presupuesto extra para memoria y almacenamiento; negocia contratos anuales con escalonamiento de entregas.

- Arquitectura: combina nearline con QLC donde la latencia lo permita; evalúa compresión/dedupe y tiering más agresivo.

Hyperscale y grandes empresas

- Contratos multi-año con fabricantes (no solo distribuidores).

- Cadenas de suministro duales y segundos proveedores (cuando existan).

- Eficiencia: optimiza dataset movement, cacheo y formato (ej.: parquet, zstd), y refuerza observabilidad del uso real de HBM/DRAM por workload.

Tres ideas para contener el impacto

- Comprar con criterio: TLC con buen DWPD y controladores probados para producción; QLC para lecturas pesadas y ciclos bajos de escritura. Evita “falsos ahorros” en marcas o series de baja calidad.

- Arquitecturas híbridas: no todo debe vivir en NVMe. Mantén capas (memoria → NVMe → QLC → nearline), con políticas de movimiento y expiración de datos.

- Optimización de IA: antes de “arreglar” con más hardware, adopta técnicas de eficiencia (cuantización, LoRA, sparsity, carga inteligente de shards, inference batching). Reducir memoria por request es oro en este ciclo.

¿Volverá la normalidad?

El mercado de memoria/almacenamiento es cíclico. Llegarán nuevas fabs, algunos proyectos pincharán y habrá oscilaciones. Pero el piso de precios podría quedar más alto que en 2023 por tres razones:

- Demanda estructural de IA (entreno + inferencia + analítica),

- Disciplina de capex de los fabricantes (lecciones aprendidas),

- Costes crecientes en equipos y mano de obra en las geografías nuevas.

Hasta entonces, la consigna es planificar, diversificar y exprimir eficiencia. La memoria y la flash han vuelto a ser activos escasos. Y cuando el petróleo sube, todo lo que depende de él lo nota: servidores, cabinas, GPU pods, PCs… y, sí, esos SSD de 2 TB que ya no veremos a 80 € en mucho tiempo.

vía: tomshardware