La startup francesa redefine los límites de la inferencia en inteligencia artificial con una arquitectura optimizada que refuerza la soberanía digital europea

La empresa emergente Kog AI, con sede en Francia, ha dado un paso de gigante en el campo de la inferencia de modelos de inteligencia artificial al anunciar que su motor de inferencia ha alcanzado una velocidad de generación de tokens hasta 3,5 veces superior en comparación con soluciones líderes como vLLM y TensorRT-LLM, utilizando GPUs AMD Instinct™ MI300X. Este avance sitúa a Kog en la vanguardia de las plataformas de inferencia de nueva generación y refuerza la apuesta europea por una infraestructura tecnológica soberana e independiente.

En la era de la inteligencia artificial generativa, el cuello de botella ya no es el entrenamiento, sino la inferencia. La capacidad de generar respuestas secuenciales rápidas —es decir, tokens por segundo por petición individual— se ha convertido en un factor crítico para agentes autónomos, asistentes virtuales, aplicaciones de voz en tiempo real y modelos de razonamiento avanzado. Sin embargo, los motores de inferencia más utilizados siguen optimizados para casos de uso de chat masivo, descuidando el rendimiento en flujos individuales complejos.

Un nuevo paradigma de velocidad para la IA en tiempo real

Kog AI ha presentado los primeros resultados de sus pruebas en los que su motor supera ampliamente a los competidores en todas las métricas clave. Entre los datos más destacados:

- Hasta 3,5× más rápido en generación de tokens respecto a los motores actuales sobre MI300X.

- Consistencia en todos los tamaños de modelo, desde 1.000 millones hasta 32.000 millones de parámetros (Llama, Mistral, Qwen).

- Latencia inter-GPU récord de 4 microsegundos, reduciendo hasta cuatro veces los tiempos habituales en bibliotecas de comunicación existentes.

El motor de inferencia de Kog muestra un rendimiento excepcional con modelos compactos (1B a 7B), los cuales, debidamente afinados, pueden igualar o incluso superar la precisión de modelos mucho mayores en tareas específicas, reduciendo drásticamente los costes de infraestructura y multiplicando por diez la velocidad.

Un enfoque radical: del ensamblador a la soberanía digital

A diferencia de otras soluciones, Kog no se ha limitado a optimizar sobre frameworks ya existentes. Ha diseñado su motor desde cero, utilizando C++ y código ensamblador altamente optimizado para eliminar cuellos de botella tanto a nivel de hardware como de software.

Una de sus innovaciones clave es KCCL (Kog Collective Communications Library), una biblioteca de comunicaciones desarrollada internamente que ha permitido alcanzar las latencias más bajas jamás registradas en inferencia distribuida entre GPUs.

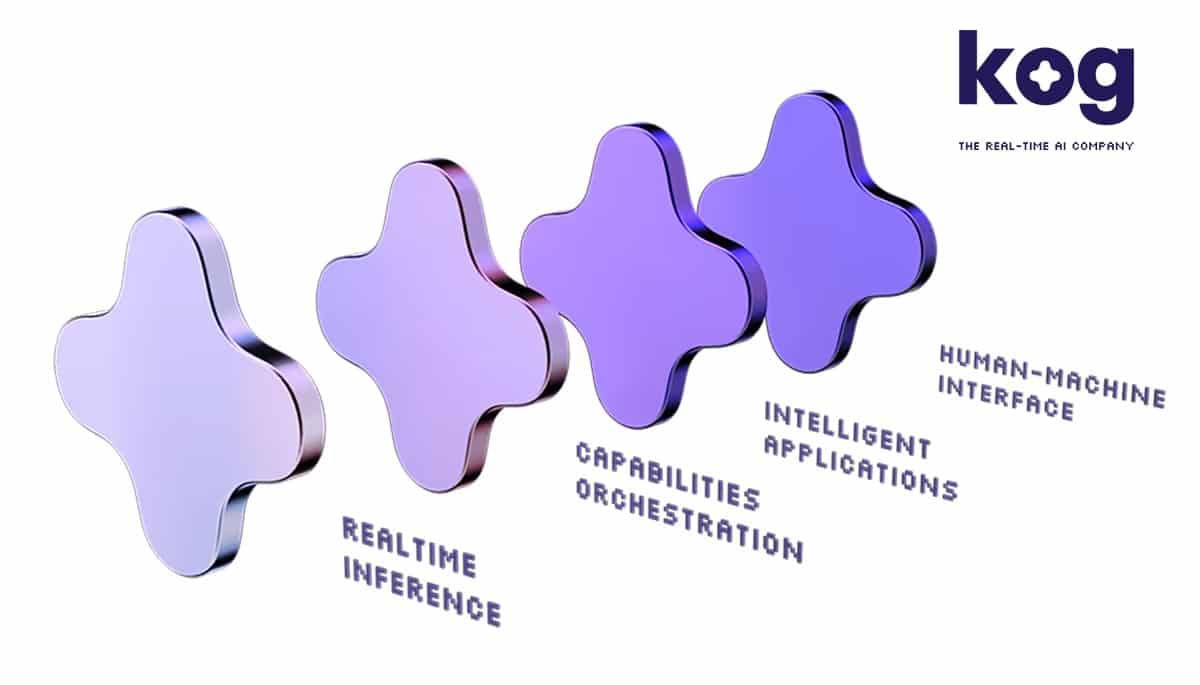

El resultado es un sistema capaz de desplegarse en distintos entornos —locales, en la nube o híbridos—, empaquetado en API o contenedores Docker, y preparado para casos de uso críticos como transcripción de voz en tiempo real, agentes autónomos o asistentes contextuales con razonamiento avanzado.

Europa planta cara en el nuevo mapa de la inteligencia artificial

El anuncio de Kog AI no es solo un avance técnico: también es una declaración de intenciones. La startup francesa representa una nueva ola de innovación tecnológica europea que busca reducir la dependencia de infraestructuras estadounidenses o asiáticas y desarrollar una inteligencia artificial soberana, ágil y altamente especializada.

«Las aplicaciones de IA modernas no pueden permitirse latencias elevadas ni infraestructuras ineficientes», señalan desde Kog. «Nuestro objetivo es convertir la inferencia en tiempo real en un estándar, no una excepción».

En un contexto donde los costes de inferencia se han disparado y los problemas de latencia amenazan la experiencia del usuario, la propuesta de Kog se presenta como una alternativa escalable, eficiente y soberana. Su alianza con AMD y el aprovechamiento del MI300X, uno de los aceleradores de IA más potentes del mercado, demuestra que Europa no solo puede competir, sino también liderar en el diseño de soluciones punteras para la próxima generación de inteligencia artificial.

fuente: AMD