En el mundo de la supercomputación y la inteligencia artificial (IA), las redes juegan un papel fundamental en la eficiencia y escalabilidad de los sistemas. InfiniBand HDR (High Data Rate) se ha consolidado como la mejor opción para centros de datos de alto rendimiento, gracias a su baja latencia, alto ancho de banda y optimización del procesamiento de datos. Con la creciente demanda de procesamiento en la nube, IA y aprendizaje automático, InfiniBand continúa superando a Ethernet y otras tecnologías en entornos HPC (High-Performance Computing).

InfiniBand: La Columna Vertebral de la Supercomputación

InfiniBand es un estándar de comunicación de red diseñado para ofrecer una interconexión ultrarrápida y confiable en sistemas de computación de alto rendimiento. Su uso ha crecido significativamente en los últimos años, convirtiéndose en la opción preferida en las principales supercomputadoras del mundo. Según la lista Top500 de noviembre de 2023, InfiniBand sigue dominando el mercado, con 189 sistemas basados en esta tecnología, destacando especialmente en los 100 primeros puestos.

Principales ventajas de InfiniBand en supercomputación:

- Ancho de banda extremo: HDR alcanza hasta 200 Gbps y NDR hasta 400 Gbps, permitiendo una comunicación más fluida y rápida entre servidores.

- Baja latencia: Mientras que Ethernet puede tener latencias de varios microsegundos, InfiniBand reduce este tiempo a menos de 100 nanosegundos, ideal para IA y HPC.

- Descarga de CPU: Su arquitectura optimiza el uso de la CPU mediante RDMA (Remote Direct Memory Access) y tecnología GPUDirect, facilitando el acceso directo a la memoria de la GPU sin intervención de la CPU.

- Red sin pérdidas: Gracias a un control de flujo eficiente, evita la retransmisión de paquetes y optimiza el rendimiento de los centros de datos.

Las Últimas Innovaciones: HDR y NDR

Las velocidades de transmisión en InfiniBand han evolucionado rápidamente. Actualmente, HDR es la tecnología dominante en los centros de datos de alto rendimiento, mientras que NDR (Next Data Rate) con 400 Gbps está ganando tracción en infraestructuras avanzadas. La siguiente generación, XDR (Extreme Data Rate), alcanzará los 800 Gbps, impulsando aún más la capacidad de procesamiento de datos en tiempo real.

| Tecnología | Velocidad Máxima | Aplicación Principal |

|---|---|---|

| SDR | 8 Gbps | HPC Básico |

| DDR | 16 Gbps | Redes HPC intermedias |

| QDR | 40 Gbps | Computación distribuida |

| FDR | 56 Gbps | Clústeres de IA |

| EDR | 100 Gbps | Redes empresariales avanzadas |

| HDR | 200 Gbps | Centros de datos y supercomputación |

| NDR | 400 Gbps | Infraestructuras de IA a gran escala |

| XDR | 800 Gbps | Próxima generación de supercomputación |

InfiniBand vs. Ethernet: ¿Cuál es la Mejor Opción?

Si bien Ethernet sigue siendo la red estándar en centros de datos tradicionales, su desempeño en HPC y aplicaciones de IA se ve limitado por el mayor consumo de CPU y la latencia superior. InfiniBand, en cambio, ha sido diseñado para manejar grandes volúmenes de datos con una latencia mínima y una utilización eficiente de los recursos.

Comparación técnica entre InfiniBand y Ethernet:

| Característica | InfiniBand | Ethernet |

|---|---|---|

| Ancho de banda | Hasta 400 Gbps (NDR) | Hasta 400 Gbps |

| Latencia | <100 ns | 2-10 μs |

| Consumo de CPU | Bajo (RDMA) | Mayor (TCP/IP) |

| Fiabilidad | Red sin pérdidas | Posibles pérdidas de paquetes |

| Gestión de Red | Subnet Manager (SDN integrado) | VLAN, STP, ARP |

| Costo | Alto | Bajo |

| Aplicaciones | HPC, IA, Clústeres de Supercomputación | Redes empresariales, Nube, Virtualización |

La gran diferencia radica en la latencia y el consumo de CPU. InfiniBand permite interconectar clústeres de servidores con una latencia casi nula, lo que es esencial para la IA y el entrenamiento de modelos de machine learning a gran escala. Ethernet, aunque es más económica y flexible, no puede igualar el rendimiento de InfiniBand en HPC.

Aplicaciones de InfiniBand en Inteligencia Artificial y HPC

La adopción de InfiniBand ha sido impulsada por empresas y centros de investigación que requieren gran capacidad de cómputo y alta velocidad de transferencia de datos. Algunas de las aplicaciones más destacadas incluyen:

- Entrenamiento de modelos de IA: Plataformas como OpenAI y NVIDIA Selene dependen de InfiniBand para entrenar modelos avanzados de machine learning con grandes volúmenes de datos.

- Supercomputación científica: Instituciones como el Centro Nacional de Supercomputación de Barcelona (BSC) utilizan InfiniBand para investigaciones en astrofísica, biomedicina y modelado climático.

- Centros de datos empresariales: Empresas como Microsoft Azure han integrado InfiniBand en su infraestructura en la nube para mejorar la eficiencia de sus servicios.

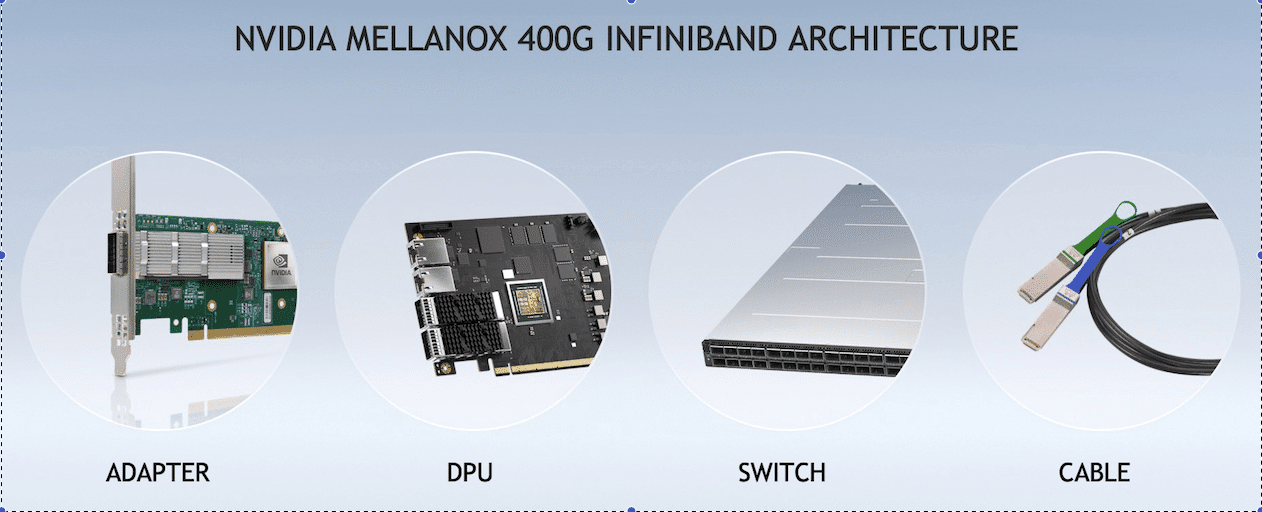

La Infraestructura HDR de InfiniBand: Conmutadores y Tarjetas de Red

Los últimos avances en hardware han permitido la expansión de InfiniBand en entornos de supercomputación. NVIDIA, uno de los principales fabricantes de hardware para IA y HPC, ha desarrollado conmutadores y tarjetas de red HDR y NDR, optimizados para estas cargas de trabajo.

Conmutadores InfiniBand HDR

Los switches HDR permiten interconectar miles de nodos con un rendimiento optimizado. Modelos como el NVIDIA QM8700-HS2F y el QM8790-HS2F ofrecen hasta 40 puertos QSFP56 de 200 Gbps, con una latencia inferior a los 130 ns.

| Modelo | Puertos | Velocidad de Enlace | Formato |

|---|---|---|---|

| QM8700-HS2F | 40 x QSFP56 | 200 Gbps | 1RU |

| QM8790-HS2F | 40 x QSFP56 | 200 Gbps | 1RU |

Tarjetas de Interfaz de Red (NIC) InfiniBand HDR

Las tarjetas SmartNICs InfiniBand HDR permiten aprovechar al máximo la velocidad y la baja latencia de la red. Modelos como el MCX653106A-ECAT soportan hasta 200 Gbps, con soporte para RDMA y GPUDirect.

| Modelo | Puertos | Velocidad Máxima | Interfaz |

|---|---|---|---|

| MCX653106A-ECAT | Dual | 200 Gbps | QSFP56, PCIe 4.0 |

El Futuro de InfiniBand: ¿Hacia Dónde Vamos?

Con la llegada de la supercomputación exaescala, InfiniBand seguirá evolucionando para soportar cargas de trabajo aún más intensivas. La próxima generación XDR (800 Gbps) permitirá la ejecución de simulaciones complejas y entrenamientos de IA con una velocidad sin precedentes.

Las tendencias indican que InfiniBand se convertirá en la tecnología estándar para redes de alto rendimiento, desplazando a Ethernet en entornos HPC. Su combinación de velocidad, baja latencia y optimización de CPU la hace esencial para el futuro de la computación.

Conclusión

InfiniBand HDR ha demostrado ser la solución ideal para supercomputación, IA y centros de datos de alto rendimiento. Mientras que Ethernet sigue siendo la opción más versátil para redes convencionales, InfiniBand es la única alternativa capaz de manejar el crecimiento exponencial de la IA y la computación avanzada.

A medida que tecnologías como XDR y NDR continúan avanzando, los centros de datos de próxima generación dependerán cada vez más de InfiniBand para lograr un rendimiento óptimo y una escalabilidad sin límites.

vía: FS