Google cerró las ponencias de machine learning en la conferencia Hot Chips con un anuncio de peso: Ironwood, la nueva generación de sus TPU (Tensor Processing Units), diseñada específicamente para inferencia de modelos de lenguaje y razonamiento a gran escala.

A diferencia de generaciones anteriores, centradas sobre todo en entrenamiento, Ironwood nace para ejecutar en producción LLMs, arquitecturas mixture-of-experts y modelos de razonamiento, donde la latencia y la fiabilidad son factores críticos.

Escalabilidad masiva

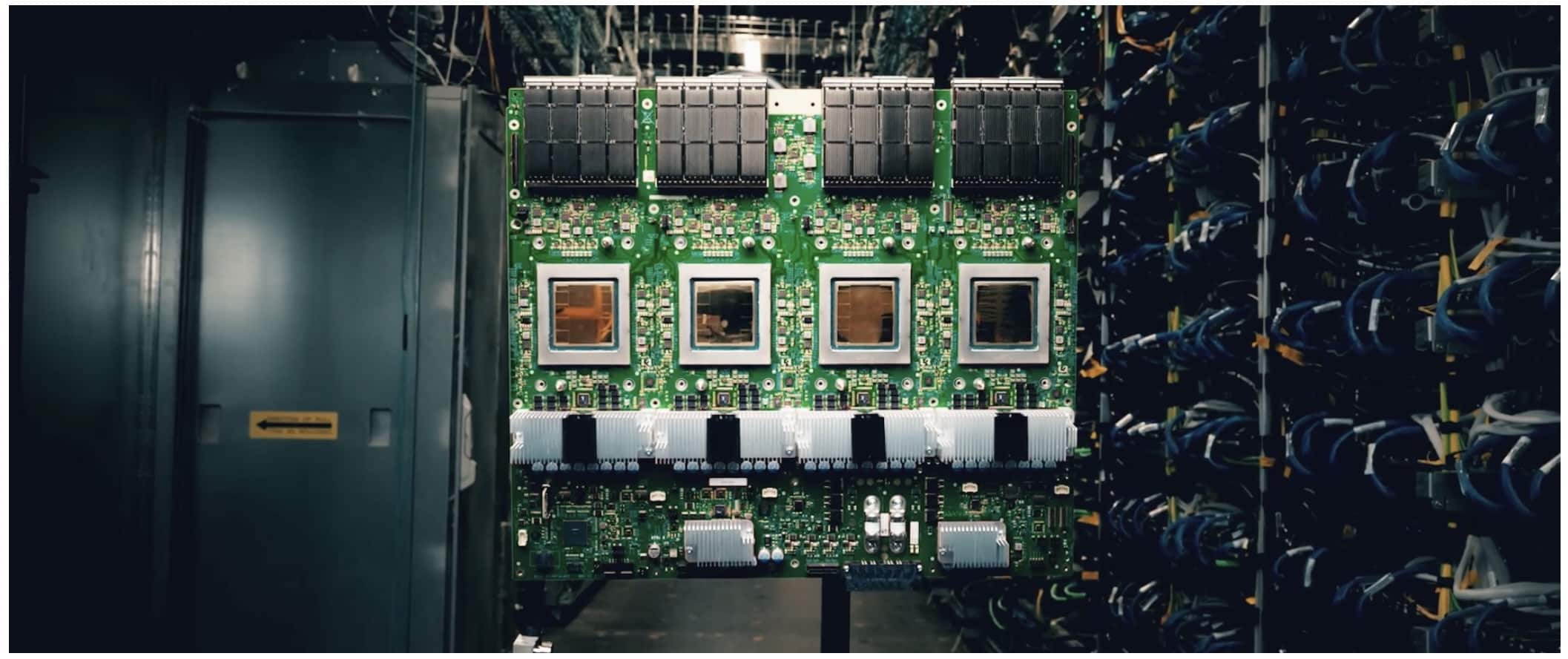

El avance más llamativo es la capacidad de escalar hasta 9.216 chips en un único nodo, lo que permite alcanzar los 42,5 exaflops de rendimiento (FP8). Todo ello acompañado de 1,77 PB de memoria HBM3e directamente direccionable, compartida mediante optical circuit switches (OCS), que duplican la escala respecto a la TPUv4 (4.096 chips).

El diseño incluye redundancia: no se eligió un número exacto de potencia de dos (8.192), sino 9.216 para tener racks de repuesto en caso de fallos.

Eficiencia energética y fiabilidad

Google asegura que Ironwood ofrece el doble de rendimiento por vatio que Trillium y hasta 6 veces más eficiencia frente a TPUv4, gracias a:

- Arquitectura multi-chiplet (dos compute dies por chip).

- 8 stacks de HBM3e con 192 GB por chip y 7,3 TB/s de ancho de banda.

- Tercera generación de refrigeración líquida, con múltiples circuitos para mantener limpios los intercambiadores térmicos.

- Control de picos de carga eléctrica para estabilizar el consumo en despliegues de megavatios.

La fiabilidad (RAS: Reliability, Availability, Serviceability) ha sido una prioridad:

- Checkpointing automático para reasignar cargas si muere un nodo.

- Detección de corrupción silenciosa de datos y comprobaciones aritméticas en ejecución.

- Root of trust integrado, arranque seguro y soporte de confidential computing.

Un chip con IA diseñada con IA

Google explicó que incluso el diseño interno del chip se optimizó con IA aplicada al diseño de ALUs y al floorplanning, en colaboración con su equipo AlphaChip.

Esto refleja una tendencia creciente: usar IA no solo para ejecutar cargas, sino para diseñar el hardware que alimentará la próxima ola de modelos.

SparseCore y nuevas funciones

Ironwood incorpora la 4ª generación de SparseCore, aceleradores específicos para embeddings y operaciones colectivas, fundamentales en arquitecturas de modelos gigantes.

A nivel de rack:

- 64 TPUs por rack (16 bandejas de 4 TPUs cada una).

- 16 racks de CPU anfitriones para coordinar el trabajo.

- Conexiones internas de cobre; los OCS conectan los racks entre sí en un entramado lógico tridimensional.

Una pieza clave para Google Cloud

Ironwood no se venderá como hardware independiente: será exclusivo de Google Cloud, integrado en su oferta de Cloud TPU. Esto refuerza el modelo de Google de diseñar su propia infraestructura para dar servicio a terceros, como ya ocurre con YouTube, Gmail o Search, donde la IA es transversal.

Para los clientes, Ironwood promete:

- Inferencia en tiempo real de modelos de razonamiento.

- Mayor estabilidad en producción, clave para IA generativa usada como agente autónomo.

- Optimización energética y fiabilidad a escala de centro de datos.

Conclusión

Con Ironwood, Google busca consolidar su liderazgo en IA a nivel de hardware en un momento en que NVIDIA GB300 y otras propuestas marcan la pauta en computación para IA.

Mientras NVIDIA empuja con GPUs diseñadas para cargas mixtas de entrenamiento e inferencia, Google apuesta por un acelerador propio, optimizado únicamente para inferencia masiva, con foco en razonamiento y latencia baja.

El resultado: un súper sistema de hasta 42,5 exaflops, con 1,77 PB de memoria compartida, pensado para la era de los modelos de billones de parámetros y agentes de IA que deberán ser confiables, eficientes y seguros en producción.

Preguntas frecuentes (FAQ)

¿En qué se diferencia Ironwood de generaciones anteriores de TPU?

Está diseñado específicamente para inferencia a gran escala, mientras que las TPU previas estaban más orientadas a entrenamiento.

Qué papel juegan los Optical Circuit Switches (OCS)?

Permiten compartir memoria entre miles de chips dentro de un pod, escalar hasta 9.216 TPUs y reconfigurar el sistema dinámicamente en caso de fallos.

Qué mejoras en memoria trae Ironwood?

Cada chip integra 8 stacks de HBM3e (192 GB) con un ancho de banda de 7,3 TB/s, esenciales para alimentar LLMs y razonamiento.

Podrá adquirirse Ironwood fuera de Google Cloud?

No. Como en generaciones anteriores, Ironwood es exclusivo para los clientes de Google Cloud TPU.

vía: servethehome y google