La startup respaldada por NVIDIA lanza una solución pionera para aliviar la presión sobre la memoria HBM y optimizar los costes de inferencia en modelos generativos

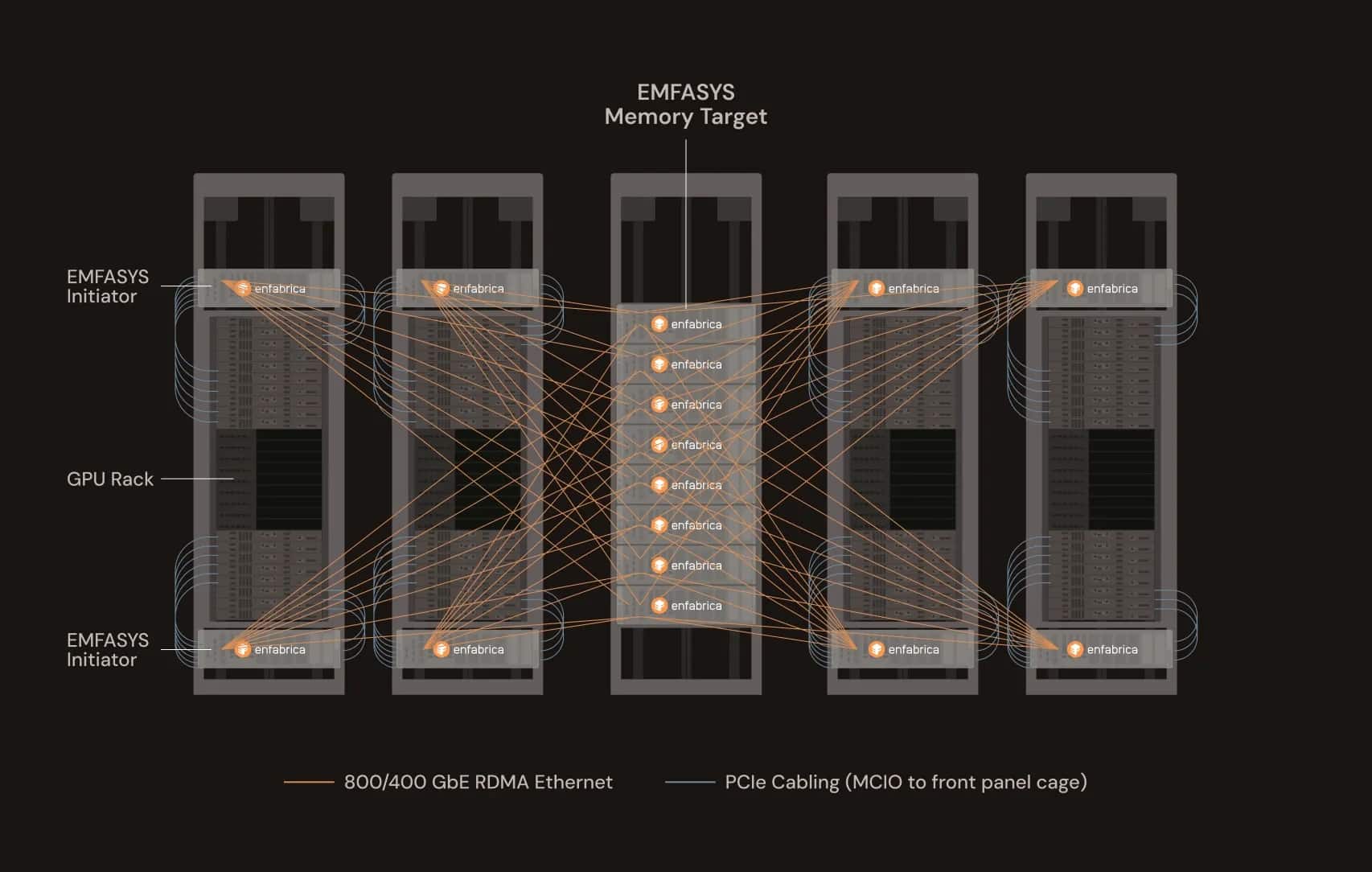

La empresa emergente Enfabrica Corporation ha anunciado esta semana el lanzamiento de Emfasys, el primer sistema comercial de memoria elástica para inteligencia artificial basado íntegramente en Ethernet. Esta nueva arquitectura promete revolucionar la eficiencia en cargas de trabajo de inferencia a gran escala, permitiendo ampliar la capacidad de memoria de servidores GPU mediante DRAM DDR5 conectada por red, sin alterar la infraestructura del sistema.

Diseñado para afrontar los retos de escalado que plantean los modelos de lenguaje grandes (LLM), Emfasys ofrece hasta 18 TB de memoria DDR5 por nodo, accesible a través de conexiones estándar de Ethernet de 400 y 800 GbE, usando tecnologías como RDMA y CXL. Según la compañía, esta solución puede reducir el coste por token generado en un 50 %, especialmente en cargas con múltiples turnos, ventanas de contexto ampliadas o inferencia de agentes autónomos.

“La inferencia de IA tiene un problema de escalado de ancho de banda de memoria y otro de apilamiento de márgenes”, afirma Rochan Sankar, CEO de Enfabrica. “A medida que los modelos se vuelven más retentivos y menos conversacionales, el acceso a memoria necesita una nueva aproximación. Emfasys es nuestra respuesta a ese desafío”.

Un nuevo paradigma en la arquitectura de memoria

La tecnología se basa en el chip ACF-S SuperNIC, que ofrece un rendimiento de 3,2 Tbps y permite la interconexión de servidores GPU con memoria DDR5 mediante el protocolo CXL.mem. Esta arquitectura funciona como un «controlador de memoria por Ethernet», donde los datos se transfieren sin intervención de la CPU y con latencias medidas en microsegundos, muy por debajo de lo que ofrecen los sistemas basados en almacenamiento flash.

El sistema incluye un software de memoria remota compatible con RDMA y entornos operativos estándar, lo que facilita su despliegue sin necesidad de rediseñar el stack de hardware o software de los servidores existentes. Gracias a este enfoque, los recursos de computación se aprovechan mejor, se reduce el desperdicio de memoria HBM —cara y limitada— y se alivian cuellos de botella en entornos multicliente o de uso intensivo.

Aplicaciones para la nueva generación de IA generativa

El crecimiento exponencial de los modelos generativos y agentivos, con requerimientos 10 a 100 veces superiores a los de despliegues anteriores de LLMs, está tensionando la infraestructura de IA global. Enfabrica propone Emfasys como una solución de escala para entornos de nube donde los tokens por segundo y la memoria por contexto determinan el coste total de propiedad (TCO).

Los primeros clientes ya están probando la tecnología. Enfabrica no ha comunicado aún cuándo estará disponible para el público general, pero la solución se encuentra en fase activa de evaluación y piloto. Además, la empresa forma parte del consorcio Ultra Ethernet Consortium (UEC) y colabora con el estándar emergente Ultra Accelerator Link (UALink).

Una startup con respaldo estratégico

El anuncio se suma al reciente impulso financiero de la compañía, que en 2023 cerró una ronda de inversión Serie B de 125 millones de dólares con participación de Sutter Hill Ventures y NVIDIA. En abril de 2025, Enfabrica comenzó a distribuir muestras de su chip ACF-S, y en febrero abrió un nuevo centro de I+D en la India para acelerar el desarrollo de soluciones de red para IA.

Con Emfasys, Enfabrica aspira a liderar un nuevo segmento de infraestructura de memoria distribuida para IA generativa, donde la eficiencia de acceso a memoria puede marcar la diferencia entre viabilidad económica o colapso de recursos en la próxima ola de aplicaciones cognitivas.

vía: enFabrica