Hay infografías que, sin necesidad de entrar en tecnicismos, dibujan una idea potente: si el mundo está levantando centros de datos como si fueran fábricas, habrá un puñado de piezas sin las que esa maquinaria no funciona. Y en 2026, esas piezas se llaman memoria y almacenamiento.

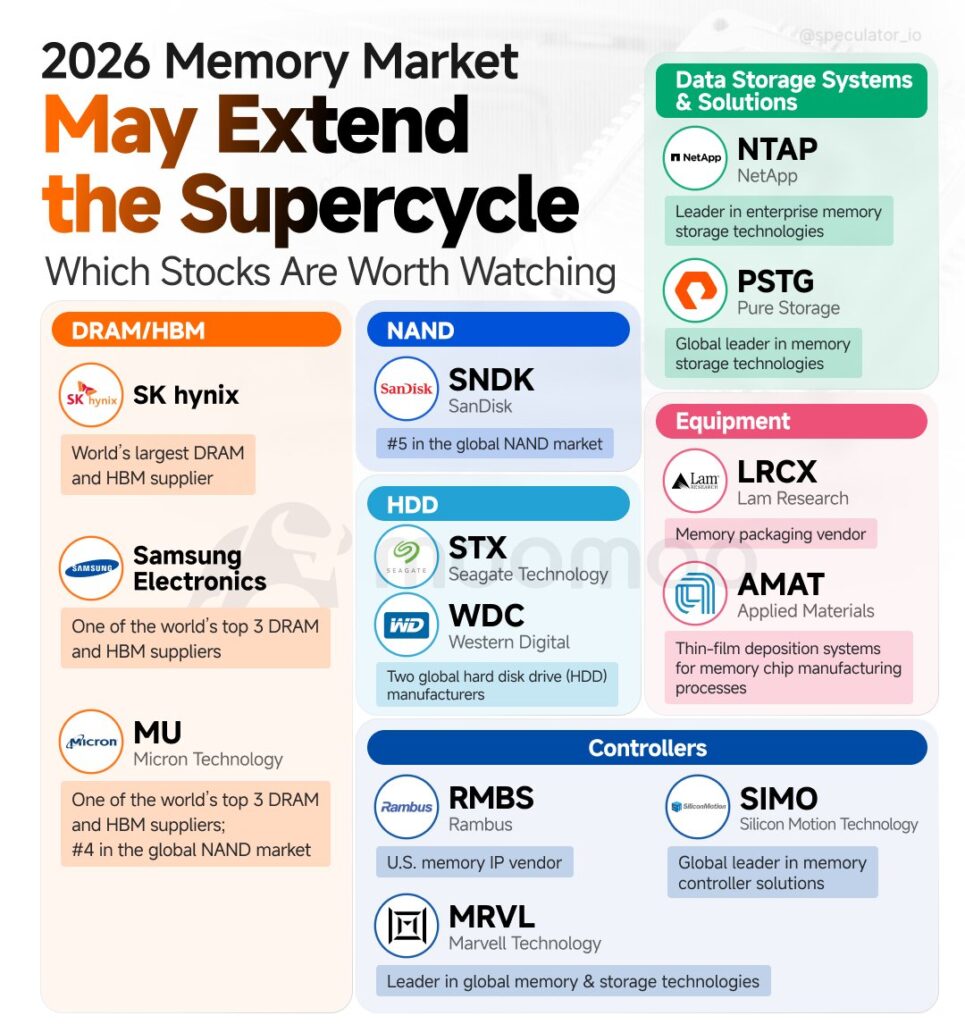

La imagen que circula estos días sobre el “Memory Market 2026” lo resume con una lista clara de categorías y compañías. No pretende ser una recomendación bursátil, sino un mapa mental: qué actores conviene vigilar si el ciclo alcista de la memoria se alarga. La tesis de fondo es sencilla: el auge de la IA y la expansión del cloud no se sostienen solo con GPUs. También necesitan HBM, DRAM, NAND, discos, controladoras, sistemas enterprise… y, además, las máquinas para fabricar y empaquetar todo eso.

La razón principal: la IA no solo come GPUs, devora ancho de banda

La IA generativa y los modelos de razonamiento han puesto el foco mediático en las tarjetas gráficas y los aceleradores. Pero la realidad industrial es menos glamourosa: un clúster de IA se puede quedar “atascado” por el cuello de botella de la memoria.

Ahí entra la HBM (High Bandwidth Memory), que es, básicamente, la memoria ultrarrápida que acompaña a muchas GPUs de entrenamiento. Cuanto más ambicioso es el modelo, más necesidad hay de ancho de banda, paralelismo y alimentación constante de datos. La infografía coloca en este bloque a SK Hynix, Samsung Electronics y Micron Technology (MU) como nombres a seguir, precisamente por su papel en DRAM/HBM.

Si el ritmo de construcción de data centers de IA se mantiene, es lógico pensar que la memoria rápida tenga viento a favor: sin HBM, el rendimiento real de una granja de GPUs no escala como prometen los folletos.

DRAM: la memoria “invisible” que sostiene el cloud

Más allá de la HBM, la DRAM sigue siendo el músculo silencioso del servidor generalista. Cada nodo de computación —para bases de datos, virtualización, analítica o inferencia— necesita grandes cantidades de RAM para ser eficiente. Y cuando se multiplican los nodos por miles (o decenas de miles), la DRAM deja de ser un componente y se convierte en un factor estratégico.

Esto es clave porque el mercado de memoria suele moverse por ciclos: cuando la demanda se dispara y la oferta tarda en ajustarse (por capacidad fabril, rendimientos, inventario o transiciones tecnológicas), los precios tienden a tensionarse. Ese es el terreno en el que aparece la palabra “superciclo”: no como magia, sino como una tormenta perfecta de demanda sostenida y capacidad limitada.

NAND y SSD: el almacenamiento ya no es “disco”, es velocidad operativa

La segunda gran pata del mapa es la NAND, la tecnología detrás de los SSD. La infografía menciona SanDisk (SNDK) como referencia en este bloque. Aquí el argumento es igual de directo: los centros de datos modernos viven de mover datos con rapidez. Y eso significa que el almacenamiento de estado sólido no es un lujo, sino una forma de mantener latencias bajas y servicios estables.

La IA agrava este punto. Entrenar, reentrenar, versionar datasets, registrar logs, almacenar embeddings y mantener “lagos” de datos operativos exige un stack de almacenamiento más rápido y, a menudo, más caro. En ese contexto, el SSD no es solo capacidad: es productividad del clúster.

HDD: el viejo disco duro sigue siendo el rey del coste por terabyte

A la vez, el mundo no se ha vuelto completamente SSD. Para datos fríos, backups masivos, archivado, cumplimiento normativo y copias históricas, los HDD siguen siendo imbatibles en coste por capacidad. Por eso la infografía pone en el bloque de HDD a Seagate Technology (STX) y Western Digital (WDC).

En un superciclo de data centers, el HDD suele reaparecer con fuerza por una razón poco discutida: aunque la computación sea “nueva”, los datos crecen más rápido que la capacidad de gestionarlos. Y cuando el objetivo es almacenar mucho —no necesariamente acceder ultrarrápido— el disco tradicional aún tiene un papel.

Sistemas enterprise: NetApp y Pure Storage, el “producto” final que compran las empresas

Hay un salto importante entre fabricar chips de memoria y resolver problemas reales en una empresa. Ahí entran los sistemas de almacenamiento enterprise, donde la infografía menciona NetApp (NTAP) y Pure Storage (PSTG).

Este segmento se beneficia cuando el gasto se mueve de “probar IA” a “operar IA”. En producción importan conceptos menos vistosos que los parámetros de un modelo: disponibilidad, snapshots, replicación, rendimiento consistente, recuperación ante desastres y costes operativos. Y eso suele empujar a plataformas integradas, no a piezas sueltas.

Equipamiento: si hay superciclo, también ganan los que venden “picos y palas”

El mapa reserva un bloque para “Equipment”, con Lam Research (LRCX) y Applied Materials (AMAT). La idea es clásica en tecnología: si el sector decide ampliar capacidad de fabricación o acelerar transiciones, quienes suministran herramientas y procesos industriales suelen estar en la primera línea.

En memoria esto es especialmente relevante por la complejidad de los procesos: fabricación, deposición, grabado, empaquetado… y una presión permanente por mejorar rendimiento, densidad y eficiencia energética. Si la demanda empuja a subir inversión, el equipamiento se convierte en un indicador adelantado.

Controladoras e IP: el “cerebro” que hace que el almacenamiento y la memoria funcionen bien

Por último, la infografía agrupa a Rambus (RMBS), Marvell Technology (MRVL) y Silicon Motion (SIMO) en “Controllers”. Es una categoría que suele pasar desapercibida para el público general, pero es crítica: sin controladoras, protocolos, IP y conectividad, la memoria y el almacenamiento no entregan sus prestaciones reales.

En la práctica, la controladora decide cómo se gestiona el rendimiento, el acceso paralelo, la corrección de errores, el comportamiento bajo carga y, en el caso de SSD, parte de la fiabilidad. En data centers, ese detalle se traduce en algo muy concreto: coste por operación y estabilidad del servicio.

La conclusión: un data center nuevo es, en esencia, una fábrica de memoria

El mensaje final que deja la infografía es fácil de entender: el boom de centros de datos no solo impulsa a quien fabrica GPUs. Impulsa a toda la cadena que convierte electricidad en computación útil: memoria rápida para IA, RAM para servidores, SSD para operar, HDD para almacenar, plataformas enterprise para gestionarlo, herramientas para fabricarlo y controladoras para que todo funcione.

Si el “superciclo” se extiende o no dependerá de factores macro (capex, energía, tasas, demanda empresarial real, eficiencia de modelos), pero como fotografía del momento, el esquema ayuda a poner orden en el ruido: la IA no es solo software. En 2026, más que nunca, también es memoria.

Vía: X Speculator IO