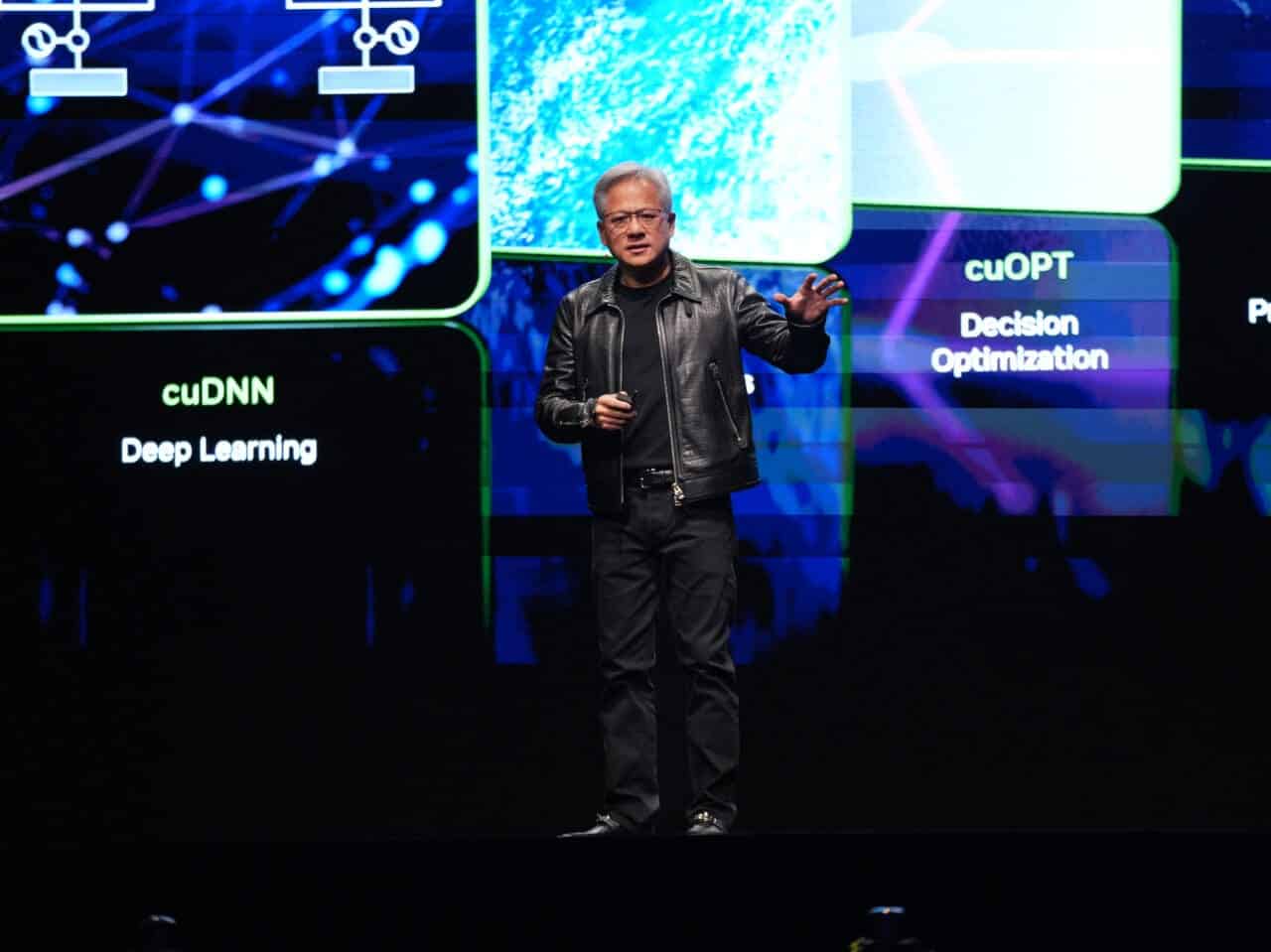

Jensen Huang, CEO de NVIDIA, ha puesto sobre la mesa un debate cada vez más relevante en el sector tecnológico: ¿podrían los ASIC destronar a las GPU como el estándar para la inteligencia artificial? Aunque hoy las GPU de NVIDIA son el corazón del entrenamiento y la inferencia de los modelos de IA más avanzados, el avance de los ASIC diseñados a medida por empresas como Google, Amazon y OpenAI podría transformar el mercado en pocos años.

GPU vs. ASIC: la batalla tecnológica por la inteligencia artificial

Las GPU (unidades de procesamiento gráfico) han sido tradicionalmente las favoritas para entrenar modelos de IA. Su principal ventaja radica en su versatilidad: pueden realizar operaciones paralelas de gran volumen, adaptarse a múltiples cargas de trabajo y son compatibles con un vasto ecosistema de herramientas y librerías (como CUDA). Esto las convierte en la opción ideal para la investigación y el desarrollo de nuevos modelos.

Por el contrario, los ASIC (circuitos integrados de aplicación específica) son diseñados para tareas concretas. Mientras que las GPU pueden hacerlo todo —aunque a veces sin la máxima eficiencia—, los ASIC se crean para realizar una función específica con el mayor rendimiento posible. En el caso de la IA, esto significa que un ASIC puede procesar tareas de inferencia o entrenamiento con un consumo energético más bajo y un coste inferior por operación, aunque con menor flexibilidad.

Ventajas y desventajas: GPU frente a ASIC

| Característica | GPU (NVIDIA) | ASIC |

|---|---|---|

| Versatilidad | Altamente versátil; adaptables a distintas tareas | Limitados a funciones específicas |

| Ecosistema | Amplio soporte de software (CUDA, TensorRT, PyTorch) | Ecosistema cerrado; requiere desarrollo a medida |

| Rendimiento bruto | Alto en tareas generales de IA y gráficos | Máximo rendimiento en tareas concretas |

| Coste por unidad | Elevado, especialmente en modelos de gama alta | Menor, pero requiere inversión inicial en diseño |

| Consumo energético | Alto, especialmente en operaciones prolongadas | Mucho más eficiente energéticamente |

| Flexibilidad futura | Adaptables a futuras mejoras y modelos | Obsoletos si la tarea específica cambia o evoluciona |

| Disponibilidad | Afectada por problemas de suministro | Dependiente de la producción propia, sin intermediarios |

La posición de NVIDIA y el temor a un cambio de paradigma

Durante su intervención, Jensen Huang señaló que los ASIC aún no son competitivos frente a las GPU en tareas complejas de entrenamiento, pero no escondió su preocupación:

“Si las empresas comienzan a producir ASIC en masa y estos alcanzan niveles competitivos en entrenamiento e inferencia, nuestro liderazgo podría verse amenazado”.

Compañías como Google, con sus TPU, y Amazon o Microsoft, ya están desarrollando chips propios para IA. Incluso OpenAI ha iniciado el diseño de sus propios ASIC para evitar la dependencia de NVIDIA.

El riesgo para NVIDIA

Si las empresas logran resultados iguales o superiores utilizando chips diseñados a medida, el modelo de negocio de NVIDIA podría verse seriamente afectado. El mercado podría pasar de pedidos de decenas de miles de GPU a una apuesta por soluciones propietarias más eficientes, dejando a NVIDIA con un exceso de producción y una caída de ventas que impactaría en su valoración bursátil.

Conclusión: ¿quién ganará la carrera?

Por ahora, las GPU siguen siendo la solución más flexible y extendida. Sin embargo, la optimización y la eficiencia empiezan a ganar peso en un sector cada vez más preocupado por costes y sostenibilidad energética. Los ASIC son una amenaza latente que NVIDIA no puede ignorar. La gran incógnita es si la compañía sabrá reinventarse para mantener su dominio o si los gigantes tecnológicos preferirán apostar por soluciones personalizadas que reduzcan su dependencia de un único proveedor.

El futuro del hardware de inteligencia artificial está en juego, y la batalla entre GPU y ASIC apenas comienza.

Fuente: Noticias inteligencia Artificial