En los últimos meses todo el foco mediático se ha puesto en las GPUs para inteligencia artificial. Cada nuevo despliegue de clústeres de entrenamiento se mide en miles de millones y megavatios, y la conversación gira en torno a quién conseguirá más tarjetas y más capacidad de cómputo.

Pero mientras los titulares miran a las GPUs, se está gestando un cambio igual de profundo —y mucho menos visible— en el resto de la cadena: memoria, almacenamiento y servidores estándar. La próxima subida de costes de infraestructura no afectará solo a quien entrene modelos gigantes, sino también a quien quiera montar “un servidor normal” para bases de datos, virtualización o servicios web.

La IA se come la fábrica de memoria

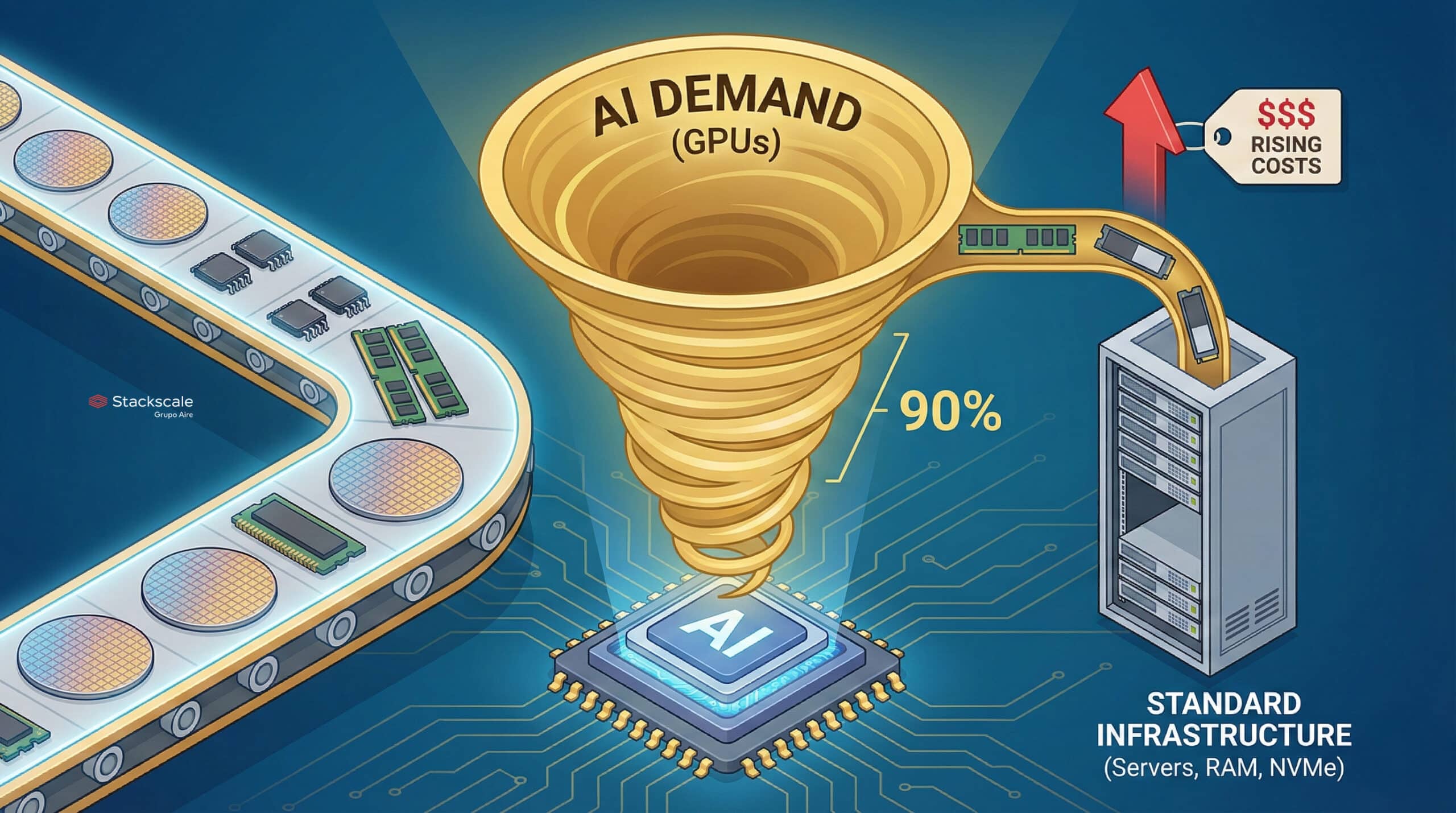

El punto de partida es sencillo: la demanda de IA está desviando una parte creciente de la capacidad mundial de fabricación de memoria hacia los chips más rentables, los que se integran en GPUs de última generación.

Eso significa que:

- Los fabricantes priorizan memoria de alto valor (HBM, GDDR, NAND de gama alta) para los grandes clústeres de IA.

- Queda menos capacidad efectiva para producir módulos de RAM “corrientes” o unidades NVMe que dan servicio al resto del mercado: centros de datos tradicionales, pymes, hosting, almacenamiento corporativo, etc.

Cuando la producción total no crece al mismo ritmo que la demanda, el resultado es previsible: suben los precios, incluso para productos que no llevan la etiqueta de “IA” por ninguna parte.

Lo que viene: servidores entre un 15 % y un 35 % más caros

Las previsiones internas que maneja el sector apuntan a un escenario incómodo para cualquiera que tenga que planificar compras de hardware:

- El mismo servidor fabricado en diciembre de 2026 podría costar entre un 15 % y un 35 % más que en diciembre de 2025.

- La presión no viene solo del coste de la GPU, sino del conjunto: RAM, NVMe, ciertos tipos de CPU y componentes asociados.

La cadena de suministro ya se está moviendo. Muchos actores —proveedores de infraestructura, hyperscalers, grandes integradores— están comprando componentes con varios meses de antelación para protegerse de las subidas.

Ese movimiento defensivo, sin embargo, tiene efecto secundario: acelera la escalada de precios. Cuando medio mercado intenta asegurarse stock antes de tiempo, se reproduce el fenómeno de “acopio” que ya se vio en la crisis de chips de 2020–2021: más tensión, más incertidumbre y más volatilidad.

Del hierro al cloud: la factura también subirá en la nube

En el entorno cloud, esta presión sobre los costes de hardware se acaba trasladando más pronto que tarde a los catálogos públicos.

Con las condiciones actuales, los modelos que manejan algunos proveedores hablan de:

- Incrementos medios del 5–10 % en ciertos servicios entre abril y septiembre de 2026, si no cambian las dinámicas de mercado.

No será un shock repentino, sino una suma de ajustes: nuevas generaciones de instancias algo más caras, recálculo de precios en almacenamiento de alto rendimiento, revisiones de tarifas en determinados bloques de RAM y NVMe.

Quien solo mire el coste de la GPU se llevará una sorpresa: la inflación de la IA también impactará en la infraestructura “de apoyo”, desde los nodos de bases de datos hasta los servidores de virtualización generalista.

El ángulo Stackscale: prepararse para la tormenta, no solo comentarla

En este contexto, proveedores de cloud privado y bare-metal como Stackscale (Grupo Aire) no pueden limitarse a observar. Tienen que rediseñar su estrategia con tiempo.

Desde la compañía explican que ya trabajan en varios frentes:

- Optimización de compras, adelantando pedidos de forma selectiva, pero evitando caer en la espiral especulativa.

- Ajuste fino de los diseños de plataforma, buscando configuraciones de servidores que ofrezcan más rendimiento por euro invertido y mayor eficiencia energética.

- Mejora de la densidad y utilización, para extraer el máximo de cada nodo físico y amortizar mejor la inversión en memoria y almacenamiento.

El objetivo es claro: absorber parte del impacto sin trasladarlo de forma directa e inmediata al cliente final.

En palabras de su cofundador David Carrero:

“Siempre que nos sea posible, vamos a intentar mantener estables los precios de la nueva infraestructura, ofreciendo entornos de alto rendimiento y, sobre todo, previsibilidad a largo plazo. Sabemos que muchas empresas dependen de una estructura de precios estable para planificar sus inversiones IT, especialmente en proyectos de misión crítica y de IA.”

En otras palabras: la batalla no es solo tecnológica, también es de ingeniería económica.

Qué pueden hacer las empresas: de la reacción al plan

Para las organizaciones que dependen de infraestructura —ya sea en cloud público, privado o modelos híbridos—, la conclusión es incómoda pero necesaria: hay que prepararse desde ya, no esperar a ver la próxima subida en la factura.

Algunas líneas de acción razonables serían:

- Revisar el inventario de cargas de trabajo

- Identificar qué proyectos necesitan realmente GPUs y qué otros pueden seguir funcionando con CPU y almacenamiento estándar.

- Evitar “pagar la tasa de la IA” en servicios que no lo requieren.

- Planificar a 2–3 años vista

- No ver la infraestructura como una colección de compras puntuales, sino como una estrategia de capacidad.

- Anticipar renovaciones, consolidaciones y ampliaciones antes de que los precios toquen techo.

- Negociar modelos de precio predecible

- Dar prioridad a proveedores que ofrezcan marcos de precios estables o escalas claras a medio plazo, en lugar de tarifas opacas sujetas a cambios constantes.

- Valorar soluciones de cloud privado y bare-metal cuando el consumo sea estable o previsible; en muchos casos, el CAPEX bien planificado puede amortiguar mejor un entorno inflacionista.

- Exprimir la eficiencia antes de pedir más hierro

- Revisar la configuración de máquinas virtuales, eliminar sobreaprovisionamientos y optimizar almacenamiento.

- Invertir en observabilidad y FinOps: no se puede optimizar lo que no se mide.

La IA también se nota donde no hay titulares

La narrativa dominante pinta la IA como una sucesión de grandes modelos, lanzamientos espectaculares y récords de rendimiento en GPUs. Pero su impacto real es mucho más silencioso y transversal.

En los próximos meses, la presión sobre la cadena de suministro de memoria y almacenamiento demostrará que la revolución de la IA no solo vive en los grandes clústeres de entrenamiento, sino también en los componentes aparentemente más corrientes:

módulos de RAM, unidades NVMe, servidores de propósito general.

Para el ecosistema tecnológico —proveedores, integradores, empresas usuarias— el mensaje es claro:

- No basta con hablar de IA, hay que hacer números de infraestructura.

- No basta con perseguir la última GPU, hay que asegurar que el resto del hardware no se convierte en un cuello de botella económico.

- Y no basta con reaccionar a las subidas: es el momento de escoger con cuidado a los socios de infraestructura y exigirles algo más que pura capacidad de cómputo.

Si algo ha enseñado la última década es que la tecnología avanza a una velocidad brutal, pero los presupuestos no. La diferencia, en los años que vienen, la marcarán aquellas organizaciones que entiendan que la próxima gran ola de costes no llegará solo en forma de tarjetas negras de 700 vatios, sino también en esa “chapa y pintura” de siempre que hasta ahora parecía barata y abundante.

Quien se prepare hoy, con una estrategia de infraestructura seria y socios alineados, tendrá mañana menos sorpresas… y más margen para invertir en lo que de verdad importa: construir productos y servicios que aprovechen la IA, en lugar de quedar atrapados pagando la factura de su efecto colateral.