El avance imparable de la inteligencia artificial (IA) y el desarrollo de nuevas generaciones de memoria HBM (High Bandwidth Memory) están llevando al límite el consumo energético de las GPU aceleradoras para IA. Así lo revela un informe conjunto del Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST) y el laboratorio TERA, que anticipa una escalada sin precedentes en las necesidades de energía de los sistemas de computación de alto rendimiento.

HBM: la carrera hacia la memoria ultrarrápida y de gran capacidad

Actualmente, la tecnología HBM3E ha permitido que aceleradoras como la NVIDIA B300 y la AMD MI350 alcancen capacidades de hasta 288 GB de memoria de alto ancho de banda. Sin embargo, la próxima generación, HBM4, elevará el listón hasta los 384 GB en el caso de NVIDIA (serie Rubin) y hasta 432 GB en el caso de AMD (serie MI400), con lanzamientos previstos para el próximo año.

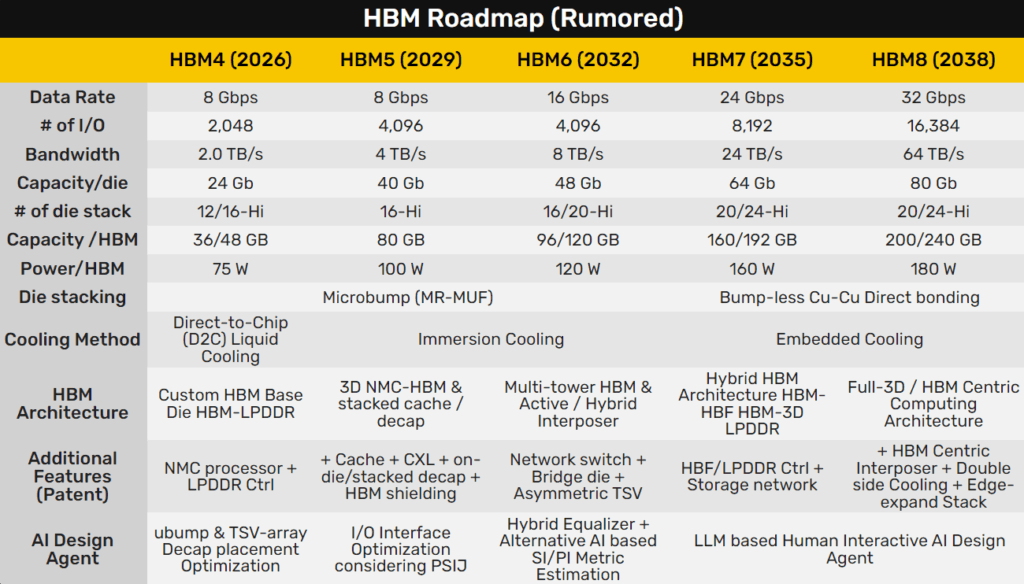

Pero la verdadera revolución vendrá con HBM5, HBM6 y HBM7, cuyas proyecciones sitúan las capacidades máximas en cifras astronómicas: HBM5 podría llegar a los 500 GB, HBM6 entre 1,5 y 1,9 TB, y HBM7 hasta los 6 TB por aceleradora. Esto supone un salto cualitativo para aplicaciones de IA generativa, big data y simulación científica.

GPU de próxima generación: rumbo a los 15.000 W por tarjeta

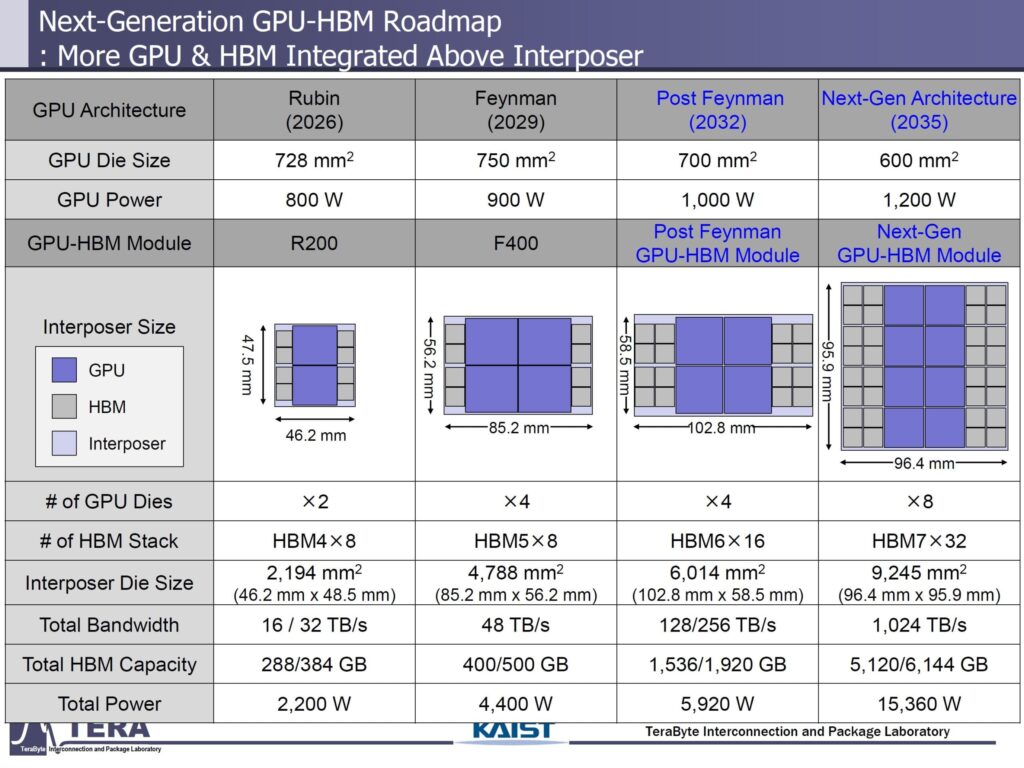

El informe detalla el espectacular aumento del consumo energético de las GPU para IA. Por ejemplo, la futura GPU NVIDIA Rubin —que llegará en 2026— tendrá un consumo de chip de 800 W, y la tarjeta completa, con HBM4 y doble chip integrado, alcanzará los 2.200 W. Las actuales AMD MI350 ya rozan los 1.400 W en sistemas de refrigeración líquida.

A medio plazo, la GPU NVIDIA Feynman (prevista para 2029) escalará hasta los 900 W de consumo en el núcleo y los 4.400 W para la tarjeta completa, utilizando cuatro chips y HBM5 para ofrecer un ancho de banda de 48 TB/s.

Las proyecciones para la década apuntan aún más alto: en 2032, una aceleradora basada en 4 chips con HBM6 podría rozar los 6.000 W, y para 2035, una hipotética tarjeta de 8 chips, 32 módulos de HBM7 y más de 1 TB/s de ancho de banda superaría los 15.000 W.

Un reto energético para los centros de datos

El crecimiento exponencial del consumo energético de las GPU para IA plantea un serio desafío para los centros de datos, que podrían necesitar infraestructuras energéticas propias, como centrales nucleares o renovables dedicadas, para alimentar estos sistemas. El consumo de una sola tarjeta de 15.000 W supone el equivalente al de una vivienda media española durante varios días.

Según los expertos, si la tendencia no se modera mediante innovaciones en eficiencia y arquitectura, el modelo de crecimiento actual podría ser insostenible, tanto desde el punto de vista ambiental como económico.

¿Es viable este futuro?

El informe concluye con una reflexión: «Si la evolución tecnológica sigue este camino, cada centro de datos necesitará su propia central eléctrica». La industria afronta el reto de equilibrar la potencia bruta que demanda la IA con la eficiencia energética y la sostenibilidad, claves para el futuro digital.

Fuente: MyDrivers, KAIST, TERA Lab, Fast Technology, NVIDIA, AMD