Meta ha revelado los detalles de Catalina, su nueva arquitectura de hardware para inteligencia artificial, que combina la potencia del NVIDIA Blackwell GB200 NVL72, el estándar Open Rack v3 (ORv3) y refrigeración líquida de alta densidad. Este anuncio, realizado en el marco del Open Compute Project (OCP), no solo muestra cómo la compañía está escalando su infraestructura de IA, sino que también refuerza su apuesta por la colaboración abierta y estandarizada en un sector dominado por soluciones propietarias.

De 6.000 a 100.000 GPUs: el crecimiento exponencial de Meta en IA

En 2022, Meta trabajaba con clústeres de unos 6.000 GPUs, orientados principalmente a sistemas de recomendación y modelos de ranking. Un año más tarde, con la irrupción de la IA generativa y los grandes modelos de lenguaje (LLM), los clústeres crecieron hasta 16.000-24.000 GPUs, multiplicando por cuatro su tamaño.

En 2024, la compañía ya operaba con más de 100.000 GPUs en producción y espera que esta cifra crezca diez veces más en los próximos años. Este crecimiento responde al entrenamiento de modelos como Llama 3.1 de 405.000 millones de parámetros, que requirió más de 16.000 GPUs H100 para ser entrenado sobre 15 billones de tokens.

Catalina nace como respuesta a esta demanda explosiva de computación, donde no solo importa el número de GPUs, sino también la capacidad de interconexión, la eficiencia energética y la escalabilidad del sistema.

¿Qué es Catalina?

Catalina es un sistema de pods de IA, donde cada pod equivale a dos racks IT que conforman un dominio de escalado de 72 GPUs. Cada rack se organiza con:

- 18 bandejas de cómputo (arriba y abajo).

- 9 NVSwitches en cada lado para interconectar los GPUs.

- Conexiones NVLink para formar un único dominio coherente de memoria.

- ALCs (Air-assisted Liquid Cooling) que permiten implementar refrigeración líquida en centros de datos tradicionales.

La clave de Catalina está en su capacidad de copiar y escalar: los pods pueden interconectarse mediante el Disaggregated Scheduled Fabric (DSF), una red abierta y modular que une múltiples pods, racks e incluso edificios completos en un único superclúster optimizado para IA.

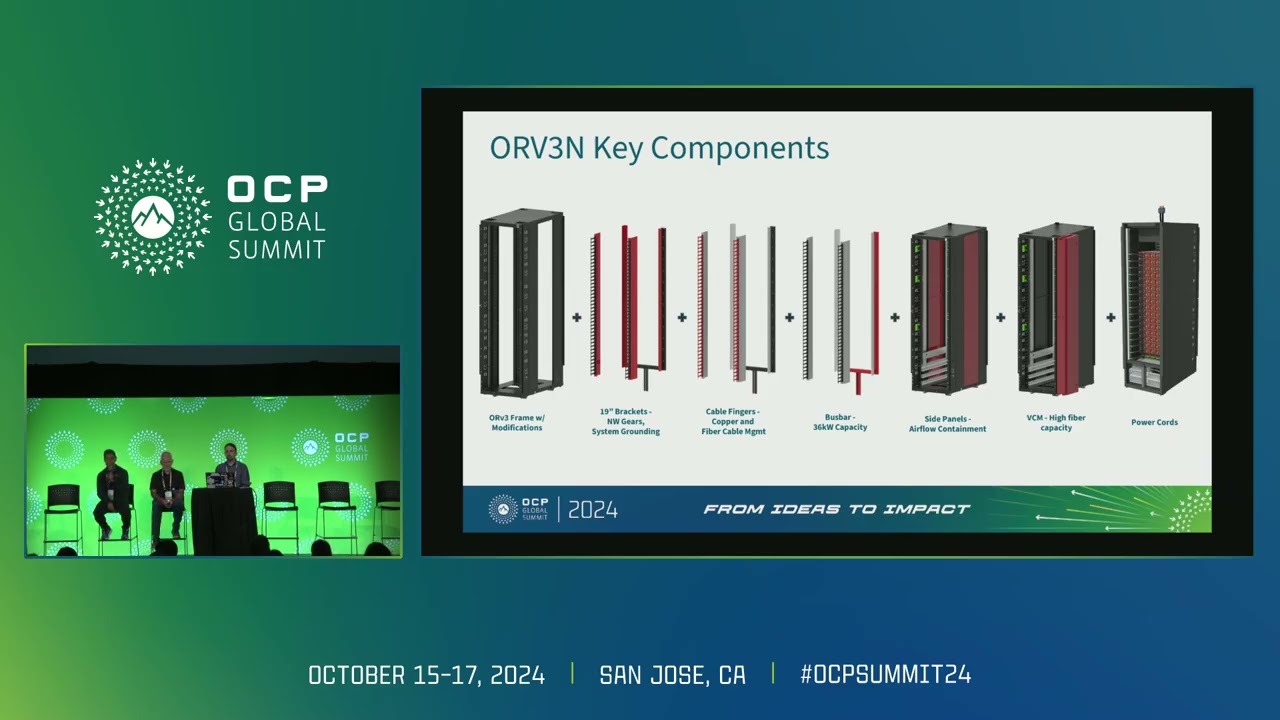

Open Rack v3 y la apuesta por la estandarización

Catalina es la primera implementación de alta potencia de Open Rack v3 (ORv3). Este estándar, impulsado por el Open Compute Project, permite soportar hasta 94 kW por rack (600 A) y está diseñado para los requisitos extremos de los aceleradores de IA.

La modularidad de ORv3 permite:

- Integrar unidades de energía de 480 V que convierten a 48 V DC, optimizando la eficiencia.

- Conectar directamente sistemas de refrigeración líquida desde las instalaciones al rack.

- Mejorar la seguridad gracias al Rack Management Controller (RMC), encargado de monitorizar fugas, controlar válvulas y orquestar el sistema de refrigeración.

Este enfoque no solo permite más potencia por rack, sino también una reducción del tiempo de despliegue y mantenimiento, un factor crítico en un escenario donde la demanda de IA crece a ritmos históricos.

Refrigeración líquida y sostenibilidad

La densidad energética de los GPUs Blackwell obliga a repensar el diseño térmico de los centros de datos.

Meta ha implementado un sistema híbrido:

- Refrigeración líquida asistida por aire (ALC) en los laterales de los racks.

- Un sistema de gestión de líquidos monitorizado por el RMC, con sensores distribuidos para detectar fugas en bandejas, racks y sistemas de refrigeración.

- Compatibilidad con infraestructuras de edificios de nueva generación, que permiten canalizar agua directamente a los racks.

Este diseño busca mantener la eficiencia energética y al mismo tiempo reducir el riesgo operativo en centros con cargas críticas.

Más allá de NVIDIA: apertura a AMD y Broadcom

Aunque Catalina se basa en el NVIDIA GB200 NVL72, Meta también amplía sus plataformas abiertas para trabajar con otros proveedores. Su plataforma Grand Teton, lanzada en 2022, ahora integra AMD Instinct MI300X, mostrando que el futuro de la IA no puede depender de un solo actor.

Además, Meta ha presentado:

- Nuevos switches de red de 51T basados en ASICs de Broadcom y Cisco.

- Su primer ASIC de red propio (FBNIC), diseñado para optimizar la comunicación en clústeres de IA.

- El Disaggregated Scheduled Fabric (DSF), un backend de red abierto y agnóstico a proveedores, soportado por estándares como OCP-SAI y RoCE sobre Ethernet.

Con esta estrategia, Meta busca romper el lock-in tecnológico y fomentar un ecosistema abierto donde diferentes fabricantes puedan competir en igualdad de condiciones.

Meta y Microsoft: un frente común en OCP

Meta mantiene desde 2018 una colaboración estrecha con Microsoft dentro del OCP. Juntas han contribuido al desarrollo del estándar SAI (Switch Abstraction Interface) y han promovido iniciativas clave como el Open Accelerator Module (OAM).

Actualmente trabajan en Mount Diablo, un rack de potencia desagregado de 400 VDC, que permite alojar más aceleradores por rack con mayor eficiencia.

Este esfuerzo conjunto refleja un cambio de paradigma en la industria: los gigantes tecnológicos no solo compiten, también colaboran para establecer estándares que favorezcan la innovación abierta.

Catalina como símbolo de apertura

La presentación de Catalina no es solo un anuncio técnico, sino una declaración de intenciones. Meta insiste en que la IA no alcanzará su verdadero potencial sin apertura. Esto implica:

- Hardware abierto, modular y estandarizado.

- Redes desagregadas, libres de dependencias de un único proveedor.

- Colaboración industrial para acelerar la innovación.

En palabras de los responsables de la compañía: “Abrir nuestros diseños de hardware es tan importante como liberar frameworks de software. Solo así podemos democratizar la IA y garantizar que sus beneficios lleguen a todos”.

Conclusión

Catalina representa la síntesis de tres fuerzas que definen la próxima era de la infraestructura digital:

- Escala masiva para entrenar y desplegar modelos de IA generativa cada vez mayores.

- Eficiencia energética y refrigeración líquida para sostener el crecimiento sin comprometer sostenibilidad.

- Apertura tecnológica, con estándares como ORv3 y DSF, que marcan el camino hacia un ecosistema colaborativo.

En un momento donde los centros de datos se convierten en las fábricas de la inteligencia artificial, Catalina es la apuesta de Meta por liderar no solo con músculo tecnológico, sino también con una filosofía de apertura que podría cambiar el rumbo de la industria.

Preguntas frecuentes (FAQ)

¿Qué es Meta Catalina?

Es un sistema de infraestructura de IA basado en el NVIDIA GB200 NVL72, diseñado como pod de dos racks que integran 72 GPUs, refrigeración líquida y arquitectura modular.

¿Por qué es importante el estándar Open Rack v3?

ORv3 permite soportar cargas de hasta 94 kW por rack, estandariza la alimentación de 48 VDC y facilita la adopción de refrigeración líquida en centros de datos.

¿Cómo se conecta Catalina a gran escala?

Mediante el Disaggregated Scheduled Fabric (DSF), que permite unir múltiples pods y edificios en un único clúster de IA, con soporte abierto para Ethernet RoCE.

¿Meta solo trabaja con NVIDIA en IA?

No. Aunque Catalina se basa en Blackwell, Meta también amplía plataformas como Grand Teton para integrar aceleradores de AMD (MI300X) y desarrolla su propio hardware de red (FBNIC).