Microsoft ha puesto en producción el primer clúster a gran escala con NVIDIA GB300 NVL72 para cargas de trabajo de OpenAI. No se trata de un piloto ni de una prueba de concepto: la compañía confirma más de 4.600 sistemas GB300 NVL72 desplegados, con GPUs Blackwell Ultra interconectadas por la nueva red NVIDIA InfiniBand Quantum-X800. El movimiento inaugura una generación de infraestructuras de IA que, según Redmond, permitirá entrenar en semanas lo que antes requería meses, y abrirá la puerta a modelos con cientos de billones de parámetros (en nomenclatura anglosajona, trillions).

La ambición va más allá del primer hito. Microsoft subraya que este clúster es el primero de muchos: su hoja de ruta apunta a cientos de miles de GPUs Blackwell Ultra distribuidas por sus centros de datos de IA en todo el mundo. El objetivo es doble: acelerar el entrenamiento de modelos frontera y elevar el rendimiento de inferencia en producción con ventanas de contexto más largas, agentes más responsivos y multimodalidad a escala.

“Este sistema co-ingenierizado proporciona el primer clúster GB300 de producción a escala del mundo, el motor de supercomputación que OpenAI necesita para servir modelos multibillonarios en parámetros. Marca el nuevo estándar definitivo en computación acelerada”, destacó Ian Buck, vicepresidente de Hyperscale and High-performance Computing en NVIDIA.

De GB200 a GB300: Azure sube el listón de la IA de propósito general

A comienzos de año, Azure introdujo las máquinas virtuales ND GB200 v6, basadas en la arquitectura NVIDIA Blackwell. Esas VMs se convirtieron en la columna vertebral de algunas de las cargas más exigentes del sector; OpenAI y Microsoft ya venían utilizando grandes clústeres de GB200 NVL2 en Azure para entrenar y desplegar modelos frontera.

La nueva generación ND GB300 v6 eleva el listón con un diseño orientado a modelos de razonamiento, IA agéntica y generativa multimodal. El enfoque es rack-scale: cada rack agrupa 18 VMs con un total de 72 GPUs y 36 CPUs Grace:

- 72 GPUs NVIDIA Blackwell Ultra (con 36 CPUs NVIDIA Grace).

- 800 Gbit/s por GPU de ancho de banda inter-rack a través de NVIDIA Quantum-X800 InfiniBand de próxima generación.

- 130 TB/s de NVLink dentro del rack.

- 37 TB de memoria rápida agregada por rack.

- Hasta 1.440 PFLOPS de rendimiento FP4 Tensor Core por rack.

La arquitectura NVLink + NVSwitch atenúa los cuellos de botella de memoria y ancho de banda dentro del rack, posibilitando transferencias internas de hasta 130 TB/s sobre 37 TB de memoria de alta velocidad. En la práctica, cada rack actúa como una unidad fuertemente acoplada que aumenta el rendimiento de inferencia y reduce latencias incluso en modelos más grandes y con contextos extendidos, clave para agentes conversacionales y sistemas multimodales.

Escalar sin bloqueo: fat-tree completo con InfiniBand Quantum-X800

Más allá del rack, Azure despliega una topología fat-tree no bloqueante con NVIDIA Quantum-X800 InfiniBand, el tejido de red más rápido disponible en la actualidad. Este diseño persigue un efecto concreto: que los clientes puedan escalar entrenamientos de modelos ultra-grandes de forma eficiente a decenas de miles de GPUs con mínima sobrecarga de comunicación.

Menos sincronización significa mayor utilización efectiva de las GPUs y, por tanto, iteraciones más rápidas y costes inferiores aun cuando el entrenamiento sea intensivo en cómputo. La pila co-diseñada de Azure —con protocolos a medida, librerías colectivas e in-network computing— busca exprimir la red con fiabilidad y aprovechamiento completos. Tecnologías como NVIDIA SHARP aceleran las operaciones colectivas ejecutando cómputo en el propio switch, lo que en la práctica duplica el ancho de banda efectivo y hace que el entrenamiento y la inferencia a gran escala sean más eficientes y predecibles.

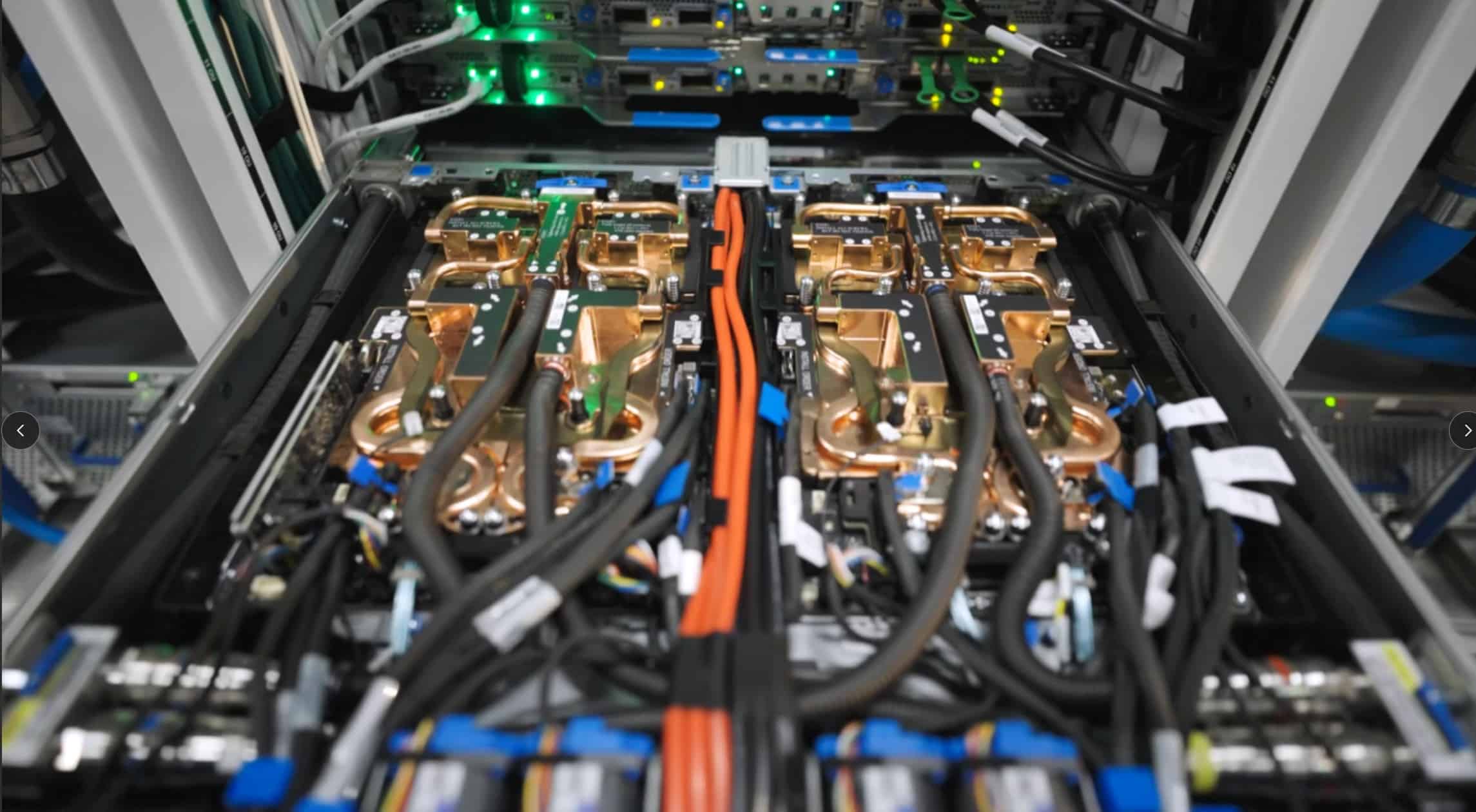

Ingeniería de centro de datos: refrigeración, energía y software a la medida de la IA

La llegada de GB300 NVL72 no es solo una actualización de tarjetas; implica repensar cada capa del ‘stack’ —cómputo, memoria, red, centro de datos, refrigeración y potencia— como un sistema unificado.

- Refrigeración avanzada. Azure emplea unidades independientes de intercambiadores de calor combinadas con refrigeración de la instalación para minimizar el uso de agua y mantener estabilidad térmica en clústeres densos y de alto rendimiento como GB300 NVL72.

- Distribución eléctrica evolucionada. La compañía continúa desarrollando nuevos modelos de distribución de energía capaces de soportar altas densidades y equilibrado dinámico de carga, requisitos necesarios para la clase ND GB300 v6.

- Pilas software re-arquitecturadas. Los sistemas de almacenamiento, orquestación y planificación se han reingenierizado para aprovechar al máximo computación, red y almacenamiento a escala de supercomputación, con eficiencia alta y rendimiento sostenido.

El resultado es una plataforma que no solo acelera el entrenamiento, sino que reduce latencias y aumenta el throughput en inferencia, incluso cuando se trabaja con contextos largos y múltiples modalidades (texto, visión, audio).

Qué cambia para OpenAI (y para el resto del ecosistema)

Para OpenAI, la disponibilidad del primer clúster GB300 a escala de producción en Azure supone disponer de un motor de supercomputación preparado para modelos multibillonarios en parámetros y ciclos de entrenamiento más cortos. Formar y desplegar modelos frontera con ventanas de contexto más extensas, razonamiento más profundo y capacidades agénticas más sofisticadas exige granjas de computación coordinadas donde NVLink/NVSwitch y InfiniBand permitan mantener a raya la sincronización y el tráfico colectivo.

Para el resto de clientes de Azure, ND GB300 v6 se perfila como nuevo estándar de infraestructura de IA: donde antes un “job” duraba meses, ahora el objetivo es medir en semanas; donde inferir a gran escala implicaba comprometer latencia o tamaño de modelo, la promesa es responder más rápido y con más contexto. Esta combinación abre puertas a casos de uso que iban quedando en el terreno de lo teórico por limitaciones físicas: asistentes multimodales de alto contexto, IA agéntica con memoria extendida, sistemas de recomendación y búsqueda generativa con frescura y recall mejorados, o simulaciones que integran lenguaje, visión y señales estructuradas en un mismo lazo.

La pieza de ingeniería: del rack a decenas de miles de GPUs

El rack es el módulo base: 72 GPUs Blackwell Ultra con NVLink/NVSwitch y 37 TB de memoria rápida conectada con 130 TB/s de ancho de banda. Este “bloque” se replica dentro del tejido InfiniBand Quantum-X800, que proporciona 800 Gbit/s por GPU para escalar entre racks sin bloqueos (arquitectura fat-tree). Sobre esa base se montan las librerías colectivas y los mecanismos de in-network computing —como NVIDIA SHARP— que aligeran el tráfico de reducciones y broadcasts al llevar las operaciones al switch, duplicando el ancho de banda efectivo y bajando la presión sobre endpoints.

La suma es un clúster elástico que mantiene utilizaciones altas de GPU, un factor clave cuando cada punto porcentual de eficiencia puede traducirse en millones de euros a lo largo de un entrenamiento de semanas.

Un despliegue habilitado por años de inversión

Microsoft recuerda que el anuncio no surge de la nada. La compañía ha invertido durante años en infraestructura de IA, lo que le permite adoptar con rapidez GB300 NVL72 a escala de producción y acelerar su despliegue mundial. A medida que Azure extienda estos clústeres, los clientes podrán entrenar y desplegar nuevos modelos en fracciones de tiempo respecto a generaciones previas.

El compromiso es continuar publicando métricas y benchmarks de rendimiento a medida que avance el despliegue global de NVIDIA GB300 NVL72.

Por qué importa: cuatro lecturas clave

- Más rápido entrenando, más barato iterando. Si el entrenamiento baja de meses a semanas, aumenta el ritmo de hipótesis y mejoras. En IA, el tiempo de iteración es el multiplicador que separa a quienes avanzan de quienes persiguen.

- Modelos más grandes y más útiles. La combinación de FP4, NVLink y InfiniBand habilita modelos con cientos de billones de parámetros (escala multitrillion) y contextos largos; esto se traduce en respuestas más precisas, menos fragmentadas y más contextuales.

- Inferencia con menos compromisos. La inferencia deja de ser el pariente pobre del entrenamiento: racks fuertemente acoplados y librerías colectivas optimizadas permiten latencias bajas incluso con modelos grandes y contextos extensos.

- Ecosistema y co-ingeniería. Nada de esto ocurre sin NVIDIA: Blackwell Ultra, Grace, NVLink/NVSwitch, Quantum-X800 y SHARP son los ladrillos; Azure aporta el cemento —centros de datos, energía, refrigeración, planificación y software— para que el edificio se sostenga a escala.

Ficha técnica (por rack ND GB300 v6)

- 72 GPUs NVIDIA Blackwell Ultra + 36 CPUs Grace

- 800 Gbit/s por GPU (escala entre racks) vía InfiniBand Quantum-X800

- 130 TB/s de NVLink (intra-rack)

- 37 TB de memoria rápida

- Hasta 1.440 PFLOPS FP4 Tensor Core

Conclusión

La puesta en producción del primer clúster GB300 NVL72 a escala convierte a Azure en referente inmediato de la supercomputación de IA para modelos frontera. Si el plan de escalar a cientos de miles de GPUs se ejecuta al ritmo anunciado, el sector podría normalizar ciclos de entrenamiento de semanas y acelerar una ola de modelos más grandes, rápidos y útiles en agentes y multimodalidad. La apuesta no es incremental; es sistémica: desde el silicio hasta el centro de datos, pasando por la red y las pilas software.

La colaboración estrecha con NVIDIA actúa como factor de riesgo y de ventaja al mismo tiempo: concentra tecnología puntera en una única senda de evolución que, por ahora, lidera el mercado. En el corto plazo, para OpenAI y para clientes de Azure, el mensaje es claro: más capacidad, más rápido y con menor fricción operativa para entrenar e inferir a muy gran escala.

Preguntas frecuentes (FAQ)

¿Qué es NVIDIA GB300 NVL72 y en qué se diferencia de GB200 NVL2 usado previamente en Azure?

GB300 NVL72 es la nueva generación Blackwell Ultra que Azure ha llevado a producción a gran escala; ND GB300 v6 se orienta a razonamiento, IA agéntica y multimodal. Azure ya operaba GB200 NVL2, pero GB300 eleva memoria, interconexión NVLink y red InfiniBand Quantum-X800, habilitando más rendimiento FP4, contextos más largos y mayor eficiencia de entrenamiento e inferencia.

¿Qué cifras clave definen un rack ND GB300 v6 en Azure?

Por rack: 72 GPUs Blackwell Ultra + 36 Grace, 130 TB/s de NVLink (intra-rack), 800 Gbit/s por GPU (entre racks) con InfiniBand Quantum-X800, 37 TB de memoria rápida y hasta 1.440 PFLOPS FP4. Cada rack opera como unidad fuertemente acoplada con baja latencia y alto throughput.

¿Cómo reduce Azure los cuellos de botella de red a gran escala?

Con una fat-tree no bloqueante sobre InfiniBand Quantum-X800 y colectivas optimizadas. NVIDIA SHARP ejecuta operaciones colectivas en el switch, lo que dobla el ancho de banda efectivo y rebaja la sobrecarga de sincronización en entrenamientos que escalan a decenas de miles de GPUs.

¿Qué impacto real tiene en plazos y tipos de modelos?

Microsoft afirma que los nuevos clústeres permiten entrenar en semanas lo que antes tomaba meses, al tiempo que habilitan modelos más grandes —cientos de billones de parámetros— y contextos más extensos, esenciales para agentes y multimodalidad con respuesta más rápida y mayor capacidad de síntesis.