La industria mundial de semiconductores entra en 2026 con una sensación de cambio de época. No es solo una cuestión de nuevos chips, sino de reordenación del valor: el dinero y la prioridad tecnológica se desplazan hacia la infraestructura de Inteligencia Artificial, y en ese movimiento la memoria —DRAM, HBM y almacenamiento empresarial— pasa de ser un componente “acompañante” a convertirse en una pieza decisiva para rendimiento y rentabilidad.

Esa es la tesis central del análisis de SK hynix sobre el mercado de 2026: la expansión de la IA está empujando un ciclo alcista en memoria que algunos bancos y analistas ya describen como “superciclo”, y la compañía surcoreana aspira a situarse en el centro gracias a su liderazgo en HBM3E y su preparación para la siguiente ola, HBM4. El tono del mensaje es revelador: ya no se discute si la IA transformará el mercado, sino qué parte de la cadena de suministro capturará el crecimiento.

Un mercado que roza el “billón” y una memoria que gana peso

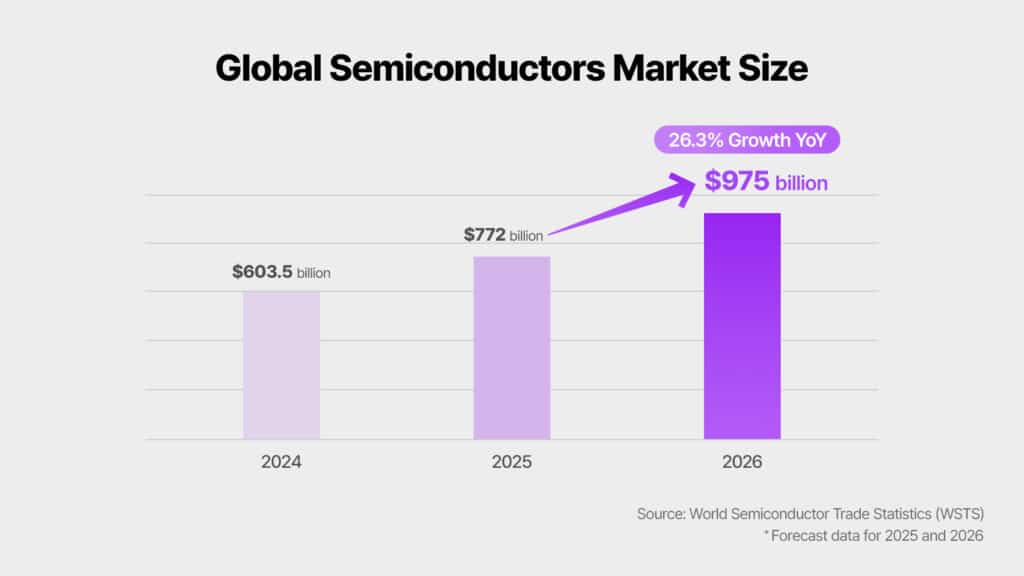

Las previsiones del sector apuntan a un 2026 de crecimiento fuerte. La organización World Semiconductor Trade Statistics (WSTS) estima que el mercado global de semiconductores crecerá más de un 25 % interanual y alcanzará aproximadamente 975.000 millones de dólares, una cifra que deja a tiro el umbral del billón de dólares (en el sentido anglosajón de “trillion”). En ese escenario, memoria y lógica destacan como categorías líderes, con aumentos previstos de más del 30 %.

El punto clave no es solo el tamaño del mercado, sino su composición. La IA está cambiando la forma en la que se “llena” un servidor: más DRAM por sistema, más HBM por acelerador y, en paralelo, un crecimiento del almacenamiento empresarial (eSSD) para absorber datasets, checkpoints, vectores y todo el ciclo de vida del entrenamiento y la inferencia. De ahí que algunas estimaciones sitúen el mercado de memoria de 2026 por encima de 440.000 millones de dólares, con especial tracción en el segmento de servidor y centro de datos.

Traducido a lenguaje de infraestructura: a medida que el entrenamiento y la inferencia escalan, también lo hace el “apetito” del sistema por memoria cercana, rápida y eficiente. Y esa demanda no se satisface solo con más unidades; exige generaciones nuevas, más apilamiento y mejores empaquetados.

El “superciclo” de la memoria: precios, demanda y un cambio estructural

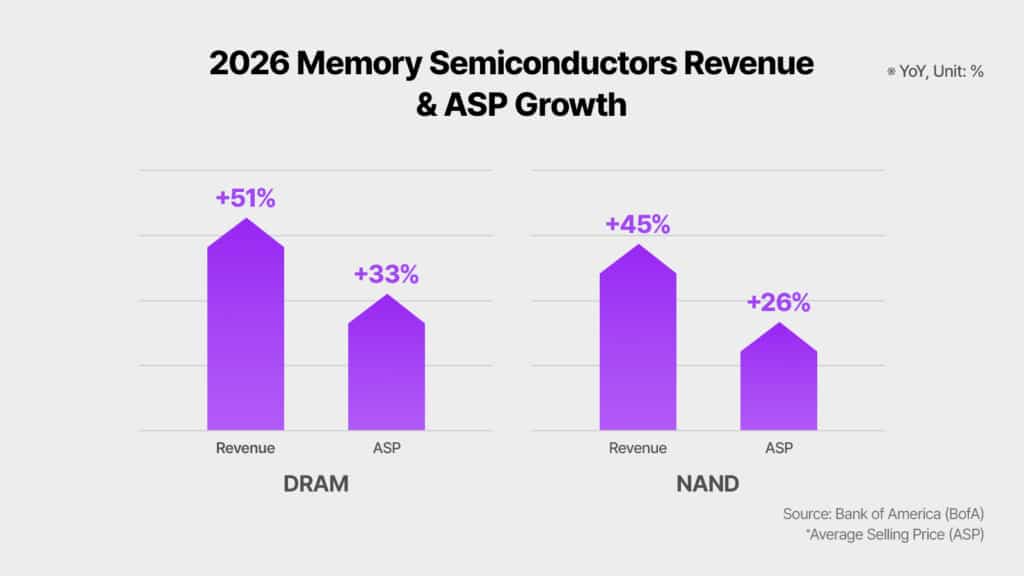

El término “superciclo” lleva circulando desde 2024 para describir el impulso de la memoria. En el análisis que recoge SK hynix, Bank of America compara 2026 con el boom de los años 90 y proyecta un salto interanual del 51 % en ingresos globales de DRAM y del 45 % en NAND, junto a subidas de precios medios (ASP) del 33 % y el 26 %, respectivamente. Este tipo de previsiones no se basan únicamente en la demanda: también reflejan un cambio de oferta. Cuando fabricantes y clientes priorizan productos de alto valor vinculados a IA, parte de la capacidad productiva se orienta hacia ese objetivo, alterando el equilibrio del resto del mercado.

En paralelo, Reuters ha reflejado en las últimas jornadas un contexto de tensión de suministro y subidas de precios en memoria asociadas al boom de la IA, con inversores interpretando el momento como un ciclo alcista que podría prolongarse. Ese telón de fondo refuerza la idea de que el mercado no está viviendo un repunte puntual, sino una dinámica de varios años.

HBM, el nuevo centro de gravedad de la IA

Dentro de la memoria, la verdadera palabra clave es HBM (High Bandwidth Memory). El análisis divulgado por SK hynix resume el giro del mercado con una comparación contundente: algunas previsiones apuntan a que el tamaño del mercado HBM en 2028 podría superar al mercado total de DRAM de 2024. No es una afirmación menor. Sugiere que el centro de beneficios y de poder negociador se desplaza hacia el componente que alimenta directamente a GPUs y ASICs de IA con el ancho de banda necesario.

En esa misma línea, Bank of America estima que el mercado HBM de 2026 podría alcanzar 54.600 millones de dólares, un 58 % más que el año anterior. Y Goldman Sachs, según el propio análisis, anticipa una aceleración especialmente fuerte en la demanda de HBM para chips de IA basados en ASICs personalizados, con un crecimiento previsto del 82 % y un peso de aproximadamente un tercio del mercado. La lectura es clara: la infraestructura de IA se diversifica más allá de la GPU generalista y empuja la memoria hacia soluciones cada vez más a medida.

HBM3E seguirá dominando en 2026, mientras HBM4 gana terreno

La transición generacional no será instantánea. Los expertos citados en el análisis esperan que HBM3E siga siendo el “producto bandera” del mercado HBM durante 2026. La razón es práctica: es la tecnología que encaja con la generación de aceleradores y plataformas de IA que estarán desplegándose masivamente durante el año, tanto en grandes nubes como en desarrollos propios de las big tech.

En paralelo, HBM4 irá ganando peso de forma gradual. La estrategia que se dibuja para SK hynix es de “doble carril”: mantener liderazgo y volumen en HBM3E mientras construye un sistema de desarrollo y suministro sólido para HBM4.

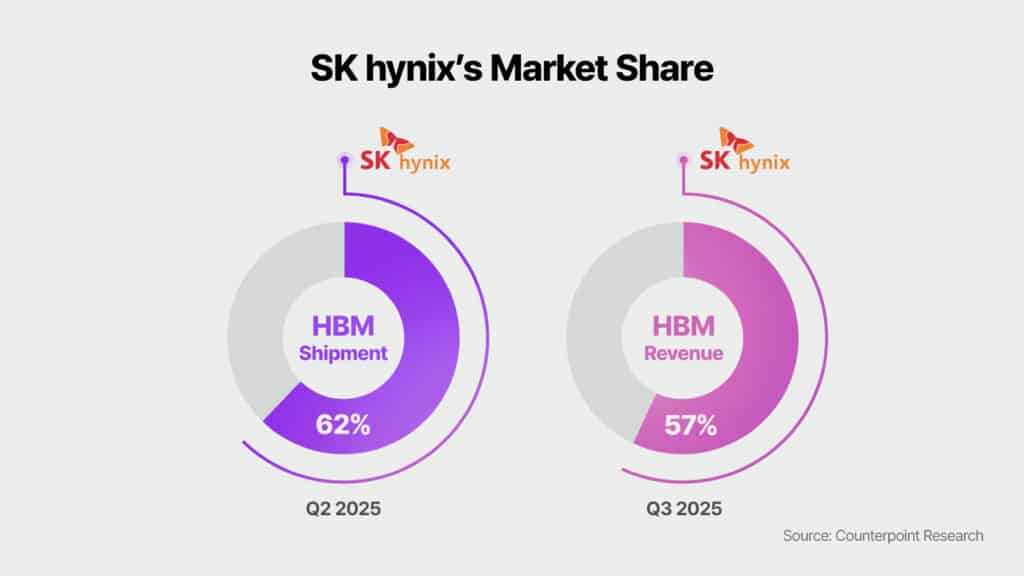

El liderazgo de SK hynix: cuota, clientes y capacidad de ejecución

La tesis competitiva de SK hynix se apoya en dos ideas: cuota actual y preparación industrial. Según datos de Counterpoint Research citados en el análisis, SK hynix lideraba los envíos de HBM con un 62 % de cuota en el segundo trimestre de 2025, y un 57 % de cuota de ingresos en el tercer trimestre. Goldman Sachs, siempre según el mismo documento, considera que la compañía mantendría su posición dominante en HBM3/HBM3E al menos hasta 2026, sosteniendo una cuota total de HBM por encima del 50 %.

Además, UBS subraya la relación con grandes clientes y sitúa a SK hynix como primer proveedor de HBM3E para determinadas plataformas, al tiempo que proyecta un escenario ambicioso: una cuota cercana al 70 % en HBM4 para la plataforma Rubin de NVIDIA en 2026. Es importante leer ese dato como lo que es —una previsión—, pero ilustra cómo el mercado anticipa continuidad del liderazgo cuando cambie la generación tecnológica.

En cuanto a la ejecución industrial, el análisis atribuye a SK hynix una posición singular por su capacidad para suministrar HBM3E y, a la vez, preparar HBM4 “de forma fiable”. En esa preparación se mencionan hitos e inversiones: la compañía afirma haber asegurado un sistema de producción en masa para HBM4, reforzado la colaboración tecnológica de empaquetado con TSMC, impulsado la fábrica Cheongju M15X, y creado estructuras dedicadas como una organización específica de HBM y un Global AI Research Center.

Riesgos: ¿hasta cuándo dura el ciclo y qué puede torcerlo?

El propio análisis admite que, junto al entusiasmo, conviven perspectivas cautas. Entre los riesgos, se mencionan posibles correcciones de precio después de 2026 por competencia y ampliación de capacidad, así como variables de suministro y el impacto de regulaciones y tensiones geopolíticas.

La clave está en el equilibrio entre dos fuerzas: por un lado, la IA empuja una demanda estructural difícil de frenar; por otro, la industria no se queda quieta y acelera inversiones para capturar el margen. En HBM, además, la barrera tecnológica es alta y eso tiende a ralentizar cambios bruscos de liderazgo, pero no elimina el riesgo de ajustes cuando el mercado “respire” tras una fase de fuerte tensión.

Un 2026 de transición: HBM3E como estándar y HBM4 como siguiente etapa

La conclusión del mercado que plantea SK hynix puede resumirse así: 2026 será un año de transición en el que convivirán tres dinámicas. Primero, la expansión de la infraestructura de IA seguirá elevando el peso de memoria y almacenamiento en el gasto total. Segundo, HBM3E se consolidará como el estándar de facto en servidores y centros de datos de IA durante el año. Y tercero, HBM4 irá entrando en escena, preparando el crecimiento de medio y largo plazo.

En ese mapa, la memoria deja de ser un “commodity” para convertirse en un factor estratégico. Y si el superciclo se confirma, el valor no estará solo en fabricar más, sino en entregar a tiempo, con fiabilidad y con empaquetado avanzado justo cuando la IA pida el siguiente salto.

Preguntas frecuentes

¿Qué diferencia hay entre HBM3E y HBM4 en servidores de IA y por qué importa en 2026?

HBM3E se perfila como la memoria dominante en 2026 por su encaje con plataformas actuales, mientras que HBM4 representa la siguiente generación que irá ganando cuota. La diferencia práctica está en la evolución de capacidad/ancho de banda y en el calendario de adopción de nuevas plataformas.

¿Por qué se habla de “superciclo” de memoria cuando crece la Inteligencia Artificial?

Porque la IA incrementa la memoria por servidor (DRAM y HBM) y dispara la necesidad de eSSD para datos y modelos. Esa demanda, combinada con restricciones de oferta y foco en productos de alto valor, puede sostener varios años de crecimiento y presión de precios.

¿Qué significa que el mercado de HBM pueda superar al de DRAM “tradicional” en pocos años?

Implica que el componente crítico para alimentar aceleradores de IA (HBM) podría convertirse en el principal generador de valor dentro de memoria, desplazando parte del protagonismo histórico de DRAM convencional.

¿Qué riesgos podrían frenar el crecimiento de la memoria para IA a partir de 2026?

Los analistas mencionan posibles correcciones de precios por más competencia y capacidad, además de incertidumbre geopolítica y regulatoria. Aun así, la complejidad técnica de HBM tiende a evitar giros abruptos en el corto plazo.

vía: news.skhynix