Durante años, la conversación en centros de datos y equipos de TI se movía entre dos extremos: servidores físicos dedicados para “lo importante” y, en el otro lado, máquinas virtuales para consolidar y ganar flexibilidad. Hoy, sin embargo, el mapa es más rico. La virtualización y la contenerización conviven —y en muchos entornos se apilan una sobre otra— para responder a una misma presión: hacer más con menos, desplegar más rápido y mantener el control sobre seguridad, costes y operación.

La comparación no es nueva, pero sí lo es el contexto. La aceleración de la nube híbrida, el auge de Kubernetes, la obsesión por la automatización y el avance de la IA han convertido a estos dos enfoques en una especie de “gramática” obligatoria para entender cualquier arquitectura moderna. Y aunque a menudo se plantean como alternativas, en la práctica la pregunta real suele ser otra: ¿qué combinación aporta el equilibrio adecuado para cada carga?

Bare metal: el rendimiento puro… con peaje operativo

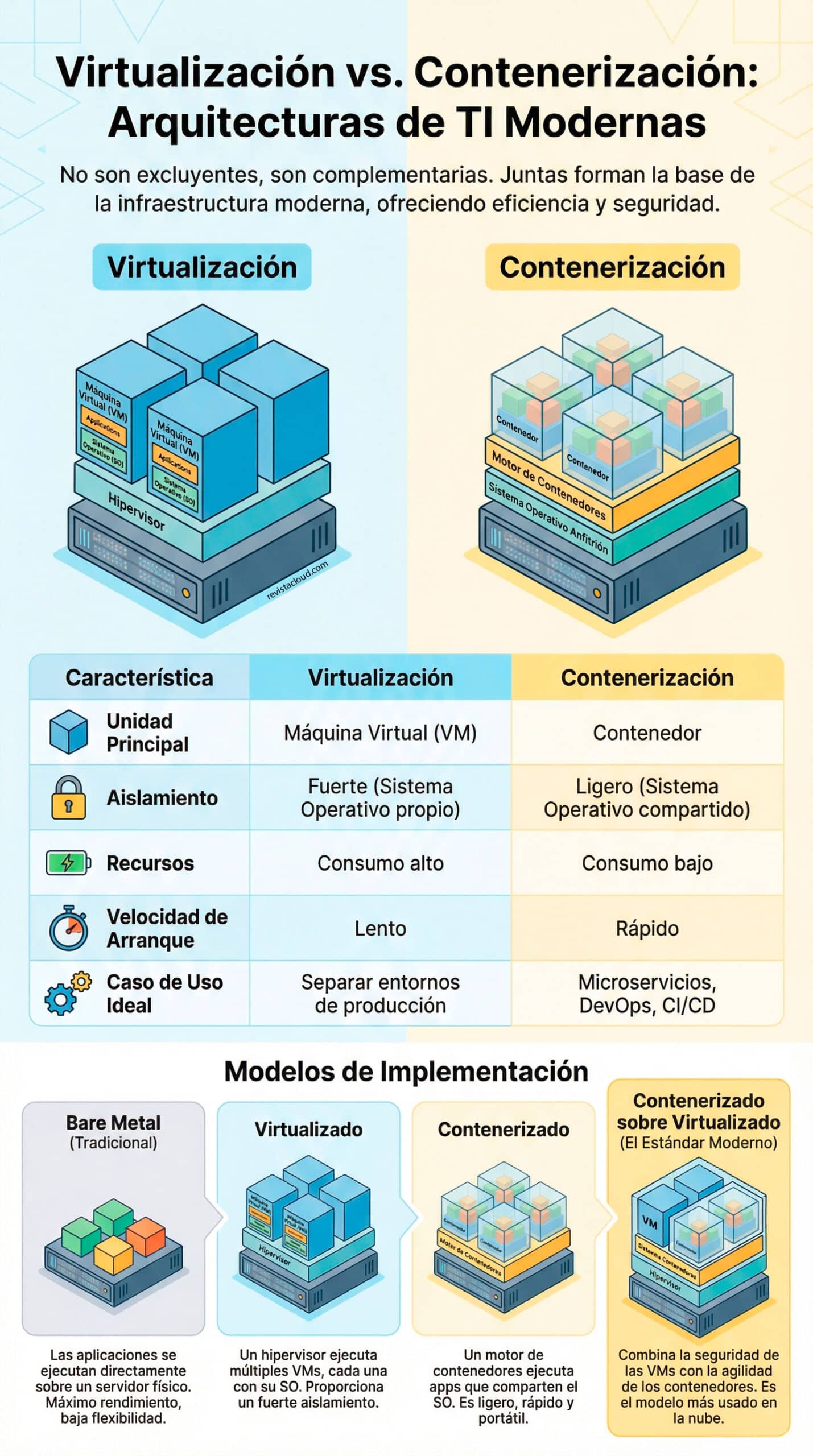

El modelo bare metal (servidor físico con sistema operativo y aplicaciones ejecutándose directamente sobre él) sigue siendo la referencia cuando se habla de rendimiento sin capas intermedias. Es el enfoque “tradicional” y todavía se usa para cargas que exigen latencias mínimas, acceso directo al hardware o configuraciones muy específicas (por ejemplo, ciertas bases de datos, procesamiento de alto rendimiento o necesidades particulares de red y almacenamiento).

El valor es claro: máximo rendimiento y, a menudo, comportamiento más predecible. Pero también lo son sus límites: cada servidor tiende a convertirse en una isla, con aprovechamiento irregular de recursos, escalado más lento y una operativa menos flexible. En un mundo donde los equipos necesitan mover cargas, probar versiones y automatizar despliegues con rapidez, el bare metal puro suele reservarse para casos donde su ventaja compensa el coste de gestionarlo.

Virtualización: aislamiento fuerte y consolidación, a cambio de “peso”

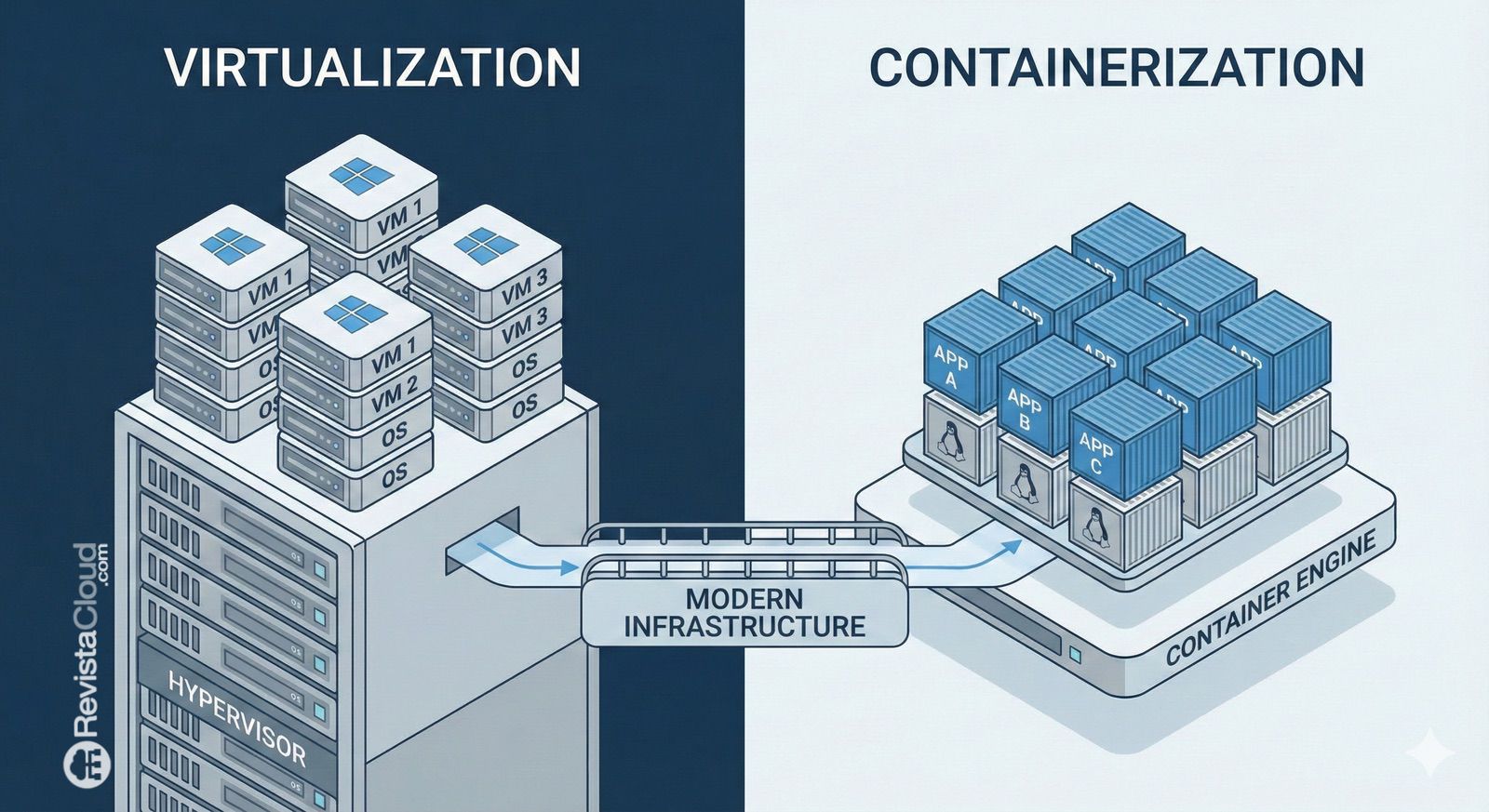

La virtualización dio un giro al tablero al permitir que un único servidor físico alojara múltiples máquinas virtuales (VM) mediante un hipervisor. Cada VM incluye su propio sistema operativo invitado (guest OS), lo que ofrece un aislamiento muy robusto entre entornos. En términos empresariales, esto ha sido clave: separar aplicaciones, departamentos o clientes en compartimentos más seguros, con independencia a nivel de sistema.

La virtualización brilla especialmente en escenarios donde se necesita:

- Separación clara entre cargas (producción vs pruebas, clientes distintos, entornos regulados).

- Compatibilidad con sistemas operativos heterogéneos (por ejemplo, convivir con Linux y Windows).

- Herramientas maduras de alta disponibilidad, snapshots, migración en caliente y gestión centralizada (según plataforma).

La contrapartida es conocida: cada VM arrastra el coste de su propio sistema operativo. Eso significa más consumo de CPU y memoria, más parches, más superficie de administración y, en determinados casos, un rendimiento ligeramente inferior frente a ejecución directa (dependiendo del workload y de la configuración).

Aun así, el equilibrio sigue siendo muy atractivo para miles de organizaciones. No es casual que nombres como VMware, Hyper-V, Proxmox o soluciones basadas en KVM formen parte del kit básico de cualquier infraestructura moderna.

Contenerización: velocidad y eficiencia, con un aislamiento distinto

La contenerización popularizó un enfoque más ligero: en lugar de encapsular un sistema operativo completo por aplicación, los contenedores comparten el kernel del sistema operativo anfitrión y empaquetan la aplicación con sus dependencias. El resultado es una unidad mucho más portable, rápida de arrancar y fácil de replicar.

Aquí entran en juego motores y runtimes como Docker (históricamente el más popular en entornos de desarrollo), además de tecnologías hoy muy extendidas en producción como containerd o CRI-O, especialmente en ecosistemas Kubernetes.

Su propuesta de valor se resume en tres ideas:

- Eficiencia: menos sobrecarga que una VM tradicional.

- Velocidad: despliegues y escalado mucho más rápidos.

- Portabilidad: “funciona igual” en distintos entornos, siempre que la base y el runtime sean compatibles.

Por eso la contenerización se ha convertido en el lenguaje natural de microservicios, pipelines de CI/CD, equipos DevOps y plataformas cloud-native.

Pero también conviene subrayar su límite más debatido: el aislamiento. Aunque los contenedores aíslan procesos, red y sistema de archivos a un nivel muy útil, no son lo mismo que una VM en términos de separación de kernel. Esto no significa que sean “inseguros” por defecto, pero sí que requieren disciplina: políticas de seguridad, control de permisos, hardening del host, gestión de imágenes, escaneo de vulnerabilidades y, cuando toca, herramientas como seccomp, AppArmor/SELinux o perfiles restrictivos.

Contenedores sobre virtualización: la combinación que domina el mundo real

En la práctica, el modelo que más se repite en empresas y proveedores de nube es el híbrido: contenedores ejecutándose dentro de máquinas virtuales. Es decir, primero virtualización para aislar entornos y facilitar operación; después contenerización para ganar agilidad y eficiencia dentro de cada dominio.

La lógica es simple:

- Las VM aportan un perímetro de aislamiento más fuerte y un marco operativo muy conocido.

- Los contenedores permiten desplegar y escalar aplicaciones con rapidez, estandarizar empaquetado y automatizar.

Este enfoque es especialmente común con Kubernetes, donde un clúster suele ejecutarse sobre nodos virtualizados (o físicos, según el caso). Para muchas organizaciones, esa capa de VM aporta tranquilidad: segmentación, control del ciclo de vida del sistema operativo del nodo, compatibilidad con herramientas de backup/snapshots y una frontera clara entre equipos o clientes.

El resultado es un “mejor de ambos mundos” que, aun con cierta sobrecarga adicional, encaja con el tipo de operación que el mercado ha adoptado: plataformas multi-tenant, entornos híbridos, despliegues por etapas y necesidad constante de automatización.

Entonces, ¿qué se elige?

No existe una respuesta universal. La elección suele depender de cuatro variables:

- Rendimiento y latencia: si el hardware manda, bare metal o virtualización muy optimizada.

- Aislamiento y cumplimiento: si la separación es crítica, la virtualización sigue siendo un estándar de facto.

- Agilidad y escalado: si se despliega con frecuencia y se escala a golpe de automatización, la contenerización es difícil de ignorar.

- Operación y herramientas: lo que el equipo sabe operar bien suele ganar, siempre que no comprometa requisitos de negocio.

La conclusión no es que uno sustituya al otro, sino que ambos se han convertido en capas complementarias para construir infraestructuras más eficientes, escalables y automatizadas.

Preguntas frecuentes

¿Qué diferencia hay entre una máquina virtual y un contenedor en términos de aislamiento?

Una máquina virtual incluye su propio sistema operativo invitado y aísla a nivel de hipervisor, mientras que un contenedor comparte el kernel del sistema anfitrión y aísla procesos y recursos con mecanismos del sistema operativo.

¿Cuándo conviene bare metal en lugar de virtualización o contenedores?

Suele convenir en cargas con requisitos muy estrictos de rendimiento, latencia o acceso directo a hardware específico (por ejemplo, ciertas bases de datos, redes de alta velocidad o configuraciones avanzadas).

¿Por qué muchas empresas ejecutan Kubernetes sobre máquinas virtuales?

Porque las máquinas virtuales añaden una capa adicional de aislamiento y facilitan la operación con herramientas conocidas (segmentación, snapshots, políticas de backup, separación por entornos o clientes), mientras Kubernetes aporta automatización y escalado de contenedores.

¿La contenerización sustituye a VMware, Hyper-V o Proxmox?

No necesariamente. En muchos entornos, la contenerización se apoya en virtualización para reforzar aislamiento y organización. Son tecnologías que suelen convivir y complementarse más que competir de forma directa.