La explosión de la demanda de IA no solo está transformando los centros de datos: también está empujando a la computación a “salir” del núcleo y acercarse al usuario. En esa batalla por la latencia —y por la soberanía del dato— cada metro de fibra cuenta. Y por eso el movimiento anunciado desde Barcelona por Submer, proveedor de infraestructura para IA, no es un simple titular corporativo: apunta a una pieza que muchos actores estaban intentando encajar a la fuerza.

Submer ha comunicado que adquirirá Radian Arc Operations Pty Ltd, un proveedor de plataforma de infraestructura como servicio (IaaS) orientada a desplegar servicios de nube GPU soberana “embebidos” en redes de telecomunicaciones. La operación, anunciada el 10 de febrero de 2026, persigue una idea concreta: ofrecer un “stack” completo que una fábricas de IA en centros de datos con capacidad de cómputo acelerado en el borde, dentro de la propia red del operador.

De la GPU en el datacenter… a la GPU en el carrier

En el mercado se está imponiendo una realidad incómoda: la IA se ha vuelto una cuestión de infraestructura, y la infraestructura se ha vuelto una cuestión de ubicación. Para inferencia de baja latencia, gaming en la nube, vídeo inteligente, analítica en tiempo real o asistentes que reaccionen “en vivo”, el recorrido hasta un datacenter lejano puede ser la diferencia entre un servicio usable y uno desesperante.

Radian Arc llega precisamente desde ese ángulo. Su plataforma se utiliza, según la comunicación, dentro de redes telco para soportar cargas como cloud gaming y workloads de IA, donde el rendimiento y la latencia mandan. Y, además, con un argumento que está subiendo de rango en Europa y en muchos países fuera de Europa: procesar datos “en el país”, dentro de infraestructura local, con integración en sistemas del operador (incluyendo facturación y datos).

En otras palabras: no se trata solo de alquilar GPUs, sino de convertir la red del operador en un plano de cómputo distribuido.

Un “stack” de dos planos: núcleo y edge, con soberanía como mensaje

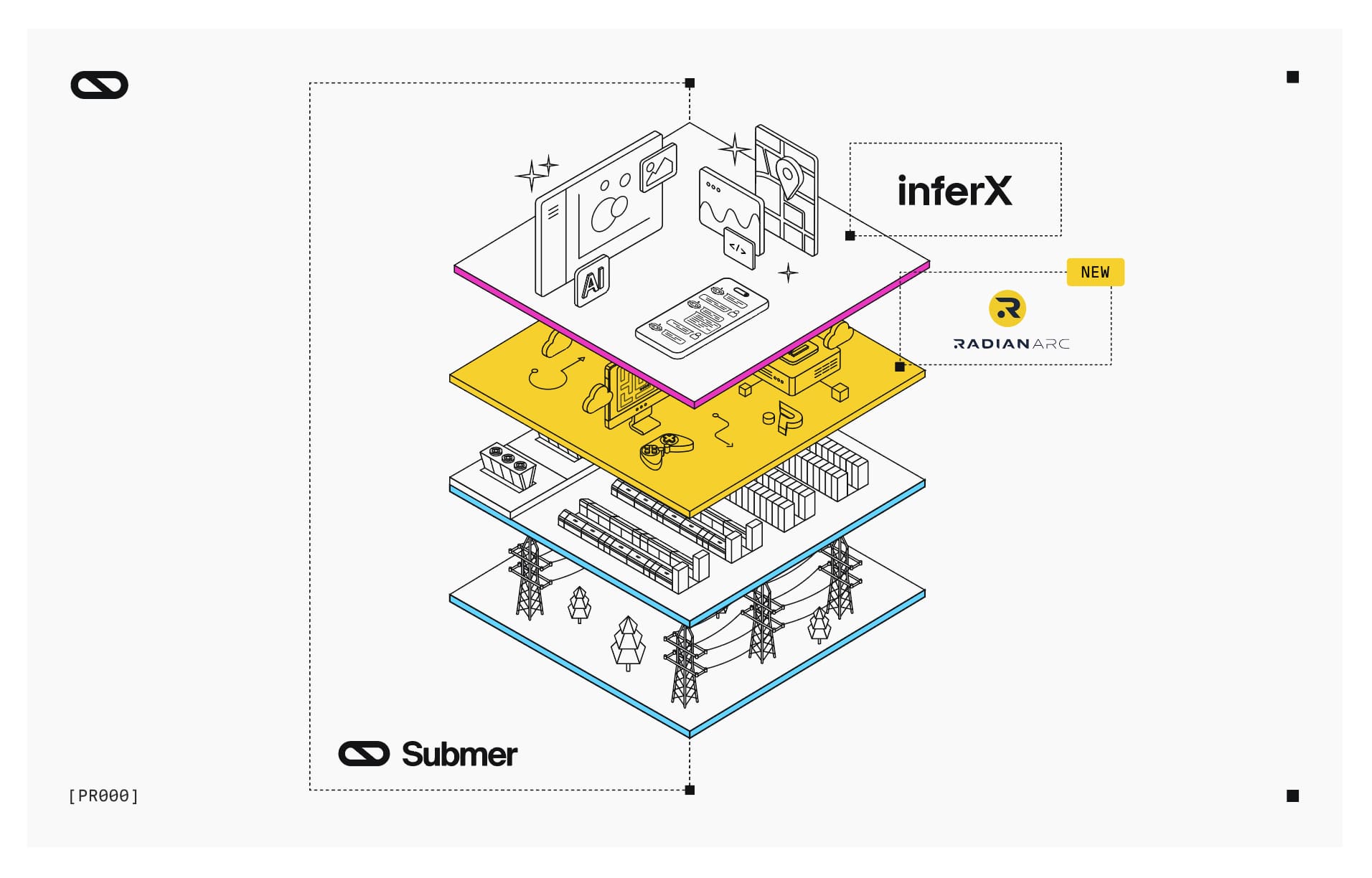

La compra encaja con la narrativa que Submer quiere construir alrededor de su plataforma. La compañía explica que la adquisición completa su oferta “full-stack” al integrar InferX —su plataforma de NVIDIA Cloud Partner— con la capa de edge GPU de Radian Arc.

El resultado, tal y como lo presenta Submer, es una propuesta de “doble plano”:

- Plano de datacenter (core) para despliegues de IA de alta densidad.

- Plano edge (telco-embedded) para ejecutar servicios cerca del usuario final, con menor latencia y con control local del dato.

Radian Arc aporta también tracción operativa: el comunicado habla de despliegues en más de 70 clientes telco y edge a nivel global, con miles de GPUs ya en funcionamiento. Submer, por su parte, refuerza el discurso de “partner único” capaz de responder “de chip a operación”, apoyándose en su historial en refrigeración líquida y en diseño y despliegue de infraestructura modular.

Qué cambia para telcos y empresas: menos teoría, más producto

Más allá de los eslóganes, la operación refleja un patrón que se repite en 2026: los operadores buscan monetizar su capilaridad (y sus inversiones en 5G y fibra) con servicios de valor añadido, pero no quieren convertirse en integradores eternos de piezas incompatibles. Unificar plataforma, operación y entrega acelera el “time to revenue”.

En términos prácticos, esta combinación puede interesar especialmente en cuatro escenarios:

- Servicios de IA soberana para sector público y regulado

Cuando el requisito es “el dato no sale del país”, la infraestructura distribuida dentro de redes telco puede convertirse en un atajo operativo. - Inferencia de baja latencia y workloads interactivos

Cloud gaming, copilotos industriales, analítica en streaming o vídeo inteligente en tiempo real suelen penalizarse con latencias largas y jitter. - Modelos de despliegue híbridos

Entrenar o ajustar modelos en el core y servir inferencia en el edge es un patrón cada vez más habitual. Aquí, el valor no es solo técnico: también es financiero (dónde pagas transporte, dónde pagas energía, dónde pagas salida de datos). - Escalado rápido “as-a-service”

Submer subraya que el conjunto está orientado a acelerar despliegues sin grandes inversiones iniciales, especialmente en escenarios donde la demanda es impredecible.

La lectura estratégica: el borde vuelve a ser protagonista

Durante años, “edge” fue una promesa difusa. La IA lo está convirtiendo en necesidad. Si el entrenamiento masivo empuja a grandes clústeres, la inferencia ubicua empuja a estar cerca del usuario. Y la soberanía —entendida como control territorial, normativo y operativo— se ha convertido en un argumento de compra, no solo en un debate político.

Submer también añade un elemento que apunta a escala: el comunicado menciona acceso a un pipeline de suelo y energía que supera los 5 GW a través de consorcios de partners en Reino Unido, Estados Unidos, India y Oriente Medio. En un mercado donde el cuello de botella no siempre son las GPUs sino el permiso, la potencia y la refrigeración, ese detalle funciona como declaración de intenciones.

Tabla rápida: qué aporta cada pieza del “stack”

| Capa | Aporta | Para qué se usa |

|---|---|---|

| Submer (infraestructura) | Diseño, construcción y operación de infraestructura de IA, con foco en alta densidad | “Fábricas de IA” y despliegues a gran escala |

| InferX (plataforma) | Plano de operación/entrega para nube GPU (NVIDIA Cloud Partner) | Exponer capacidad GPU como servicio con gobernanza |

| Radian Arc (edge telco) | Plataforma IaaS de GPU embebida en redes de operadores | IA y cloud gaming con baja latencia y soberanía local |

Preguntas frecuentes

¿Qué significa “GPU cloud soberana” en la práctica?

Que el cómputo y los datos pueden procesarse y almacenarse dentro de un país (o jurisdicción) y bajo control operativo local, algo clave para administraciones públicas y sectores regulados.

¿Por qué a una telco le interesa “meter GPUs” dentro de su red?

Porque le permite ofrecer servicios de baja latencia (IA en tiempo real, gaming, analítica) y monetizar su capilaridad, además de reducir dependencia de ubicaciones remotas.

¿Esto sustituye a los hiperescalares o compite con ellos?

Suele complementar: el core puede convivir con cloud pública o privada, mientras el edge cubre casos donde la latencia, el coste de transporte o la soberanía del dato son decisivos.

¿Qué tipo de cargas se benefician más del edge GPU?

Inferencia interactiva, cloud gaming, visión por computador en tiempo real, procesamiento de vídeo, asistentes con respuesta inmediata y analítica de eventos con requisitos de latencia estrictos.