En la carrera por la Inteligencia Artificial (IA), las grandes batallas ya no se libran solo en los aceleradores o en los procesadores. Cada vez con más frecuencia, el cuello de botella está en la memoria: en cuánta se puede empaquetar, a qué velocidad mueve datos y, sobre todo, cuánta energía consume al hacerlo. Con ese telón de fondo, SK hynix ha elegido CES 2026 para exhibir una hoja de ruta que apunta directamente a los próximos grandes saltos de la industria: desde la HBM4 de alta capacidad hasta nuevos módulos pensados para servidores de IA y memoria móvil orientada al “on-device AI”.

La compañía surcoreana ha anunciado la apertura de un stand de exhibición para clientes en Venetian Expo (Las Vegas), entre el 6 y el 9 de enero de 2026, con un mensaje que resume su estrategia: “Innovative AI, Sustainable tomorrow”. En un momento donde los centros de datos se miden en densidad, refrigeración y coste por operación, la palabra “sostenible” no funciona como eslogan vacío: es una forma de hablar de rendimiento por vatio y de eficiencia en toda la cadena, desde el chip al sistema.

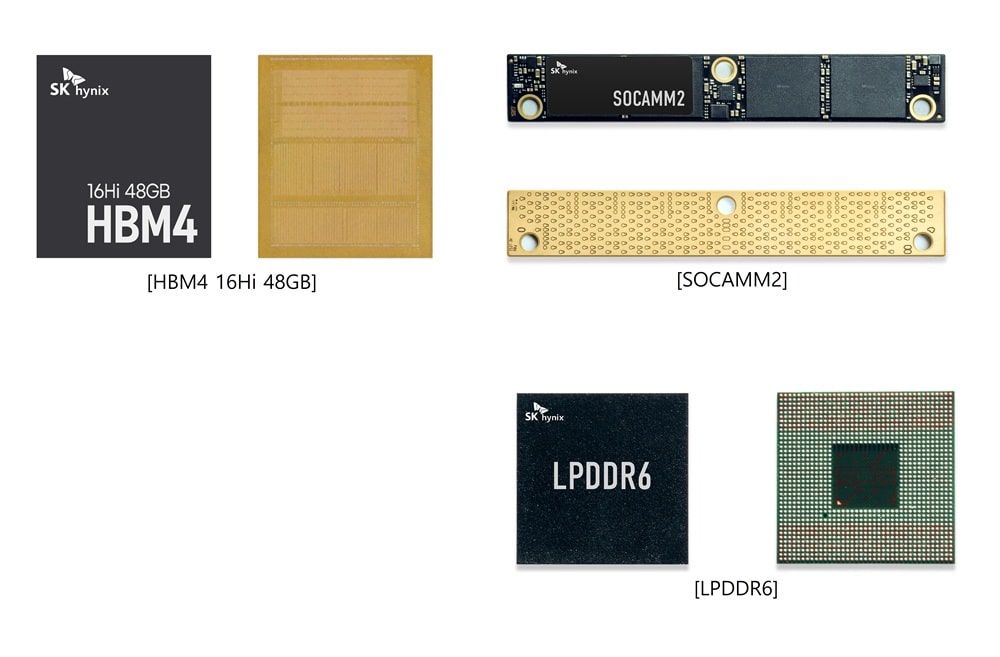

HBM4 de 16 capas y 48 GB: el escaparate de la memoria que viene

La pieza central del stand será una memoria que apunta a la próxima generación de plataformas de IA: HBM4 de 16 capas con 48 GB. SK hynix la presenta por primera vez en CES como evolución directa de su HBM4 de 12 capas y 36 GB, un producto que, según la compañía, ha mostrado una velocidad de 11,7 Gbps y se encuentra en desarrollo “alineado con los calendarios de los clientes”.

En términos prácticos, esta clase de anuncio refleja cómo se está moviendo el mercado: la memoria HBM (High Bandwidth Memory) es hoy el “pulmón” de los aceleradores para entrenamiento e inferencia. A medida que los modelos crecen y las cargas de trabajo exigen más contexto y más paralelismo, los fabricantes de memoria intentan responder con dos palancas: más capacidad por pila y más velocidad de E/S. El salto a 48 GB en 16 capas es, precisamente, un mensaje de ambición en ambos frentes.

SK hynix no ha dado fechas comerciales cerradas para esta HBM4 de 48 GB en el anuncio del stand, pero sí marca una intención clara: enseñar a socios y clientes hacia dónde se dirige su catálogo cuando la industria empiece a desplegar nuevas generaciones de hardware de IA.

HBM3E de 36 GB: la memoria que “mueve el mercado este año”

Junto a HBM4, la empresa también exhibirá HBM3E de 12 capas con 36 GB, que describe como el producto llamado a impulsar el mercado “este año”. Más allá del titular, este punto es relevante: HBM3E es, hoy por hoy, una tecnología clave en la generación actual de infraestructura de IA, y SK hynix quiere reforzar su papel como proveedor de referencia.

La compañía ha adelantado, además, que co-exhibirá módulos de GPU para servidores de IA que incorporan HBM3E, junto a un cliente, con la intención de mostrar el rol de esta memoria dentro del sistema completo. Es una forma de “aterrizar” el anuncio: no se trata solo de un chip aislado, sino de cómo encaja en el producto final que llega al centro de datos.

SOCAMM2: módulos de bajo consumo para servidores de IA

Otro de los focos del stand será SOCAMM2, definido como un módulo de memoria de bajo consumo especializado para servidores de IA. La aparición de este formato ilustra una transición que se está acelerando: el crecimiento de la IA no solo exige ancho de banda extremo cerca del acelerador (HBM), también demanda memoria eficiente y modular en el resto del sistema, tanto por consumo como por escalabilidad.

En el discurso de SK hynix, SOCAMM2 sirve para subrayar que su apuesta no es únicamente HBM, sino un porfolio que cubre el “sistema” completo. Dicho de otra forma: la IA no se construye solo con un chip brillante, sino con la suma de memoria, interconexión y almacenamiento moviéndose al mismo ritmo.

LPDDR6: más velocidad y eficiencia para la IA en el dispositivo

En paralelo al centro de datos, SK hynix también mostrará LPDDR6, orientada a IA en el propio dispositivo. La compañía sostiene que esta generación mejora de forma significativa la velocidad de procesamiento de datos y la eficiencia energética frente a generaciones anteriores.

Este tipo de memoria importa por una razón muy concreta: el uso de modelos en local (en portátiles, móviles, dispositivos industriales o automoción) vive un auge impulsado por privacidad, latencia y costes. Para que esa IA “cercana” sea viable, la memoria móvil tiene que acompañar: no basta con tener NPU o aceleración, también hace falta alimentar el sistema con datos de forma eficiente.

NAND de 321 capas y 2 Tb QLC: capacidad para eSSD en centros de datos de IA

La exhibición no se queda en DRAM. En NAND, SK hynix presentará una memoria QLC de 321 capas y 2 Tb, diseñada para eSSD de ultra alta capacidad, un segmento que está creciendo con la expansión de los centros de datos orientados a IA. La compañía defiende que, gracias a una integración “de las mejores de la industria”, este producto mejora eficiencia energética y rendimiento respecto a generaciones anteriores de QLC, una ventaja especialmente relevante en entornos donde cada vatio cuenta.

La lectura de fondo es evidente: los proyectos de IA no solo consumen computación, también almacenan volúmenes masivos de datos, checkpoints, embeddings y artefactos de entrenamiento. El almacenamiento, por tanto, se convierte en una pieza estratégica para contener costes y escalar.

“AI System Demo Zone”: cuando la memoria intenta hacer parte del trabajo

Uno de los elementos más llamativos del anuncio es la creación de una zona de demostración de sistema (“AI System Demo Zone”) para mostrar cómo sus soluciones se conectan y forman un ecosistema. Aquí SK hynix entra en terreno más futurista: enseñará una maqueta a gran escala de cHBM (Custom HBM), una idea que refleja el giro del sector desde “más rendimiento bruto” hacia “más eficiencia de inferencia y optimización de costes”.

La propuesta de cHBM, según la compañía, consiste en integrar en el “base die” de la HBM algunas funciones que tradicionalmente residían en GPU o ASIC, con el objetivo de mejorar la eficiencia global del sistema reduciendo la energía necesaria para mover datos.

En esa misma zona, SK hynix menciona otras líneas de trabajo y conceptos que orbitan una misma obsesión: reducir el coste de mover datos.

- PIM (Processing-In-Memory), memoria con capacidades de cómputo para aliviar el cuello de botella del movimiento de datos.

- AiMX, una tarjeta aceleradora prototipo basada en un chip especializado para modelos de lenguaje.

- CuD (Compute-using-DRAM), orientada a ejecutar cálculos simples dentro de la propia memoria.

- CMM-Ax, un módulo que combina capacidades de cómputo con la expansión de memoria mediante CXL.

- Data-aware CSD, almacenamiento con capacidad de procesar datos de forma autónoma.

Más que productos cerrados, estas piezas funcionan como señales: el futuro de la IA no depende solo de sumar GPUs, sino de rediseñar el sistema para que la memoria y el almacenamiento dejen de ser “pasivos”.

Una estrategia centrada en el cliente y en el “valor nuevo” de la IA

SK hynix también ha subrayado un cambio de enfoque en CES: este año prioriza su stand de exhibición para clientes como punto de encuentro con socios clave, para discutir colaboración y desarrollo. En palabras de Justin Kim, presidente y responsable de AI Infra en SK hynix, los requisitos técnicos de los clientes “están evolucionando rápidamente” y la compañía pretende responder con soluciones diferenciadas y cooperación estrecha para “crear nuevo valor” en el ecosistema de IA.

El mensaje encaja con la realidad del mercado: el ritmo de despliegue de la IA está forzando a toda la cadena —memoria, interconexión, almacenamiento— a evolucionar a la velocidad de los modelos. CES 2026, en ese sentido, no es solo un escaparate: es un lugar donde se negocia el futuro inmediato del hardware que sostendrá la próxima ola de Inteligencia Artificial.

Preguntas frecuentes

¿Qué ventajas aporta la memoria HBM4 de 48 GB frente a generaciones anteriores en infraestructura de Inteligencia Artificial?

Aporta más capacidad por pila y apunta a mayores velocidades de transferencia, claves para alimentar aceleradores con cargas de entrenamiento e inferencia cada vez más exigentes.

¿Para qué sirve SOCAMM2 en servidores de IA y por qué se menciona el bajo consumo?

SOCAMM2 se plantea como un módulo especializado para servidores de IA, donde el consumo y la eficiencia son críticos para escalar capacidad sin disparar costes energéticos.

¿Qué es cHBM (Custom HBM) y por qué la industria habla ahora de “eficiencia de inferencia”?

cHBM es un enfoque que integra funciones adicionales en la memoria HBM para reducir movimiento de datos y mejorar la eficiencia del sistema. La inferencia gana peso porque muchas organizaciones buscan reducir el coste de servir modelos en producción.

¿Por qué un NAND QLC de 321 capas y 2 Tb es relevante para centros de datos de Inteligencia Artificial?

Porque los despliegues de IA demandan eSSD de alta capacidad para datos, modelos y pipelines; mejorar densidad y eficiencia energética en NAND ayuda a contener costes a gran escala.