Proxmox VE 9 ya ha aterrizado y, con él, una ristra de novedades que apuntan a profesionalizar aún más la plataforma. No hablamos de un simple “lavado de cara”, sino de cambios que afectan al ciclo de vida, a la red definida por software, al almacenamiento y, sobre todo, a la forma de gobernar cargas con criterios de afinidad y anti-afinidad. En paralelo, el salto de base a Debian 13 “Trixie” reordena repositorios y trae un kernel más moderno. En resumen: menos promesas y más piezas prácticas para dar servicio, tanto en laboratorio como —lo que a muchos les interesa— en producción.

A continuación, un recorrido ordenado y crítico por lo que de verdad aporta Proxmox 9, apoyado en una sesión práctica y comentarios de campo. Nada de humo: funcionalidades concretas, implicaciones y algunos consejos para no tropezar en la adopción.

Base del sistema: Debian 13 “Trixie” y repos reorganizados

El primer golpe de vista llega en el subsistema base. Proxmox 9 se alinea con Debian 13 y reestructura repositorios para la nueva distribución. La parte interesante no es el nombre en clave, sino lo que significa en la práctica: paquetería fresca, kernel actualizado y un ciclo de parches alineado con una rama que verá mucho movimiento en los próximos meses.

- Qué aporta: compatibilidad con hardware reciente y actualizaciones de seguridad más ágiles.

- Qué vigilar: al principio, los repos “nuevos” pueden implicar cambios de procedencia de paquetes y pequeñas fricciones en drivers o módulos fuera de árbol. Mejor planificar entornos de staging y validar playbooks de Ansible/Terraform antes de pasar a producción.

Conclusión: es un salto que merece la pena por base tecnológica, pero pide disciplina de pruebas.

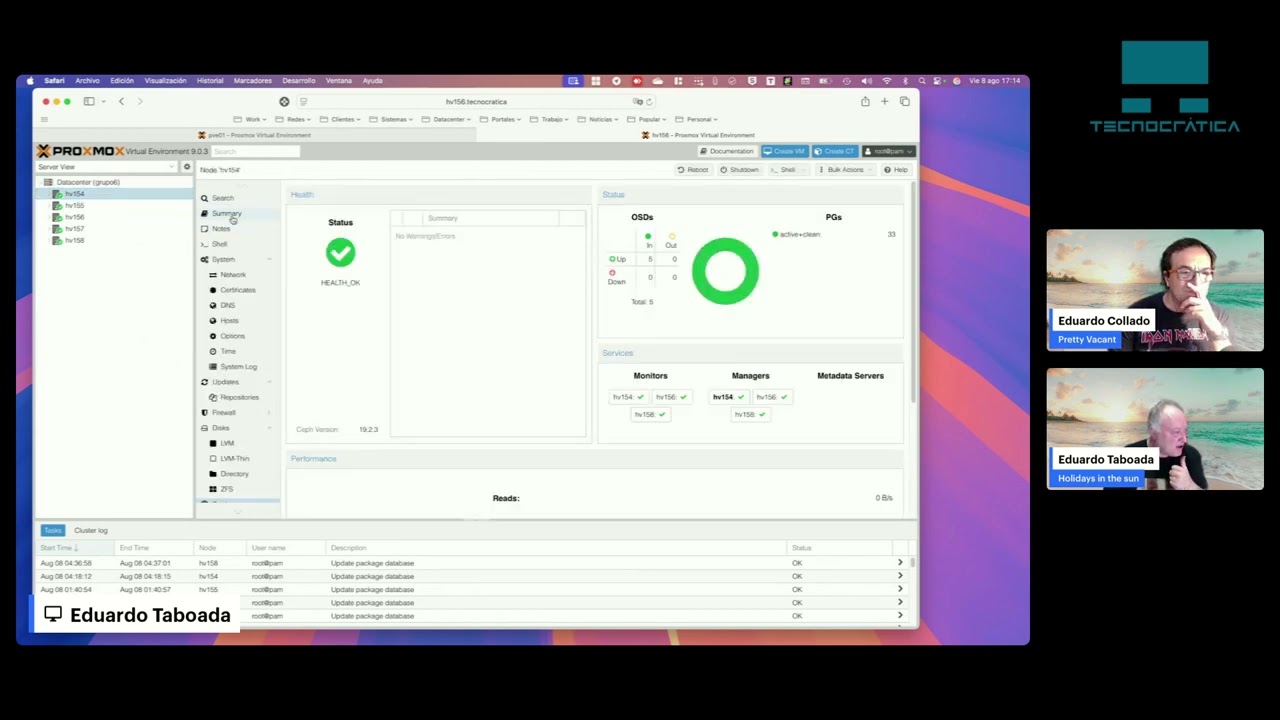

Interfaz y administración: lo importante no es el color de los botones

Se han tocado elementos del entorno gráfico. Nadie en la comunidad dirá que Proxmox luce como un dashboard de una multinacional del SaaS: sigue siendo austero. Pero el valor está en pequeños detalles útiles para operadores:

- Interfaces de red con nombres alternativos: algo tan sencillo como alias claros para NICs evita errores en enlaces, bondings y VLANs cuando se gestiona a distancia o por turnos. En producción, reduce “sustos” en cambios y despliegues.

- Navegación y agrupaciones más coherentes en el tree de datacenter: a poco que crezcan clústeres y SDN zones, se agradece.

Conclusión: la UI no gana concursos de diseño, pero suma ergonomía operativa, que es lo que importa.

SDN con tejido spine–leaf: Proxmox da el salto de laboratorio a topologías serias

Una de las novedades más llamativas aparece en Datacenter → SDN: definición de fabric estilo spine–leaf desde la propia consola de Proxmox. No es un reemplazo de tu switching —eso sigue estando en el dominio de red—, pero acerca al operador la posibilidad de modelar la conectividad de forma declarativa y coherente entre nodos.

- Qué resuelve: coherencia de segmentación, rutas y dominios de overlay en configuraciones donde antes cada host se “arreglaba” por su cuenta.

- Para quién: on-prem que necesitan estandarizar redes lógicas y crecer sin dolores de cabeza.

- Qué no es: un sustituto de las capacidades de tu fabric físico. Piensa en ello como en un complemento de control que evita divergencias.

Conclusión: un paso que profesionaliza la red definida por software en Proxmox y reduce deuda técnica.

ZFS: crecer “en caliente” sin desmontar el pool

Aquí Proxmox 9 trae una mejora que, en la práctica, cambia la vida a quien opera hosts con ZFS. La idea es simple: ampliar capacidad en caliente añadiendo discos al conjunto, sin “deshacer” lo ya construido.

- Qué significa en el día a día: puedes empezar con pocos discos y añadir más conforme suben las necesidades (o el presupuesto). Para backups o repositorios de imágenes, esto es oro.

- Impacto operacional: menos ventanas de mantenimiento, menos riesgo humano y crecimiento por etapas (capex escalonado).

- Matiz técnico: la mecánica exacta depende del tipo de vdev. La interfaz y la documentación de ZFS ayudan a elegir si añades o modificas un vdev. En Proxmox 9, el flujo está mucho más cuidado para no romper lo que funciona.

Conclusión: elasticidad real en almacenamiento local. En combinación con Proxmox Backup Server, supone planificación sencilla para crecer sin reingeniería.

Reglas de afinidad y anti-afinidad: HA con cerebro

Era uno de los reproches recurrentes de quienes veían a Proxmox como “solo” un hypervisor de laboratorio: hasta ahora faltaba un control fino de dónde deben convivir o separarse VMs y servicios. Proxmox 9 introduce afinidad y anti-afinidad:

- Anti-afinidad (separación): si se operan dos instancias críticas (por ejemplo, dos nodos de un mismo servicio o dos controladores), puede definirse que nunca residan en el mismo host. Si cae un nodo, el HA no recoloca juntas las cargas “hermanas”.

- Afinidad (colocación): si aplicación y base de datos conviene que cohabiten por latencia, pueden vincularse para que el scheduler intente mantenerlas en el mismo host cuando sea viable.

- Objetivo: acercar el comportamiento de clúster a expectativas de entornos Enterprise, con reglas que acompañan a la VM en fallos y migraciones.

Conclusión: esta pieza coloca a Proxmox en otra liga para políticas de colocación. Es clave para quien gestiona HA de verdad.

Ciclo de adopción: cómo desplegar Proxmox 9 sin sustos

Más allá de la lista de novedades, el éxito está en cómo se adopta. Una estrategia conservadora puede ser la diferencia entre disfrutar Proxmox 9 o sufrirlo.

- Staging con casos reales

- Replica un conjunto representativo: almacenamiento, redes, carga media y picos.

- Verifica playbooks de provisioning (cloud-init, plantillas, etiquetas, hooks).

- Pruebas de red

- Si vas a usar SDN y spine–leaf declarativo, documenta topologías actuales y el plan de overlay.

- Testea conmutación por error (cortes de enlace, apagado de un leaf, perdida de MTU).

- ZFS con cabeza

- Define qué vdev necesitas y cómo crecerás: no es lo mismo añadir capacidad que cambiar redundancia.

- Valida tiempos de resilver en tus discos reales y su impacto en I/O.

- HA con afinidades

- Etiqueta roles: db, app, proxy, pbs, etc.

- Redacta reglas de afinidad/anti-afinidad y pruébalas simulando la caída de un nodo.

- Plan de rollback

- Mantén imágenes de Proxmox 8 hasta completar la transición.

- No mezcles grandes cambios: SDN, ZFS y HA a la vez solo cuando estén validados.

¿Y el debate del vendor lock-in? El (nuevo) lugar de Proxmox en el tablero

El contexto de mercado importa. Con el cambio de rumbo de algunos fabricantes tradicionales de virtualización, muchas organizaciones exploran alternativas. En ese clima, Proxmox 9 no es solo “la nueva versión”: llega con funcionalidad que despeja objeciones habituales (políticas de colocación, SDN declarativa, crecimiento ZFS).

- Para pymes y mid-market: la suma de coste controlado + capacidad empresarial es difícil de ignorar.

- Para service providers: la facilidad para orquestar clústeres y operarlos con herramientas abiertas y APIs encaja con catálogos multi-tenant.

- Para TI corporativa: la clave está en gobierno (afinidad/anti-afinidad), observabilidad y ciclo de parches. Proxmox 9 apunta en esa dirección.

Conclusión: más que una actualización incremental, Proxmox 9 limpia el camino para adopciones serias donde antes había dudas razonables.

Apuntes de campo: lo que se ve al “tocarlo”

- Alias de NICs: una tontería sobre el papel, un ahorro de errores en la práctica.

- Fabric en SDN: “todo en su sitio” cuando gestionas varios dominios lógicos; menos drift entre nodos.

- ZFS en caliente: libertad para empezar con 5 discos y subir a 24 según crece tu repositorio, sin rehacer el pool. De paso, mitiga fallos correlacionados si no compras todos los discos el mismo día.

- Afinidad: no solo “HA que arranca cosas”, sino HA que coloca bien. Al final, eso es lo que diferencia una plataforma operable de un laboratorio con aspiraciones.

Buenas prácticas para el “día dos”

- Etiquetado estricto de VMs y nodos (roles, criticidad, dominio de fallo).

- Catálogo de plantillas con cloud-init y endurecimiento básico (SSH, sudo, auditing).

- Backups con PBS y pruebas periódicas de restauración (no vale con “tengo snapshots”).

- Observabilidad: métricas de clúster (CPU, memoria, I/O, latencias) y alertas por cruces de umbral.

- Runbooks de incidencias: caída de un leaf, pérdida de un bond, fallo de disco, degradación ZFS, etc.

- Ventanas de mantenimiento pequeñas y frecuentes, no “big bangs” trimestrales.

En resumen

Proxmox 9 no pretende deslumbrar con fuegos artificiales. Hace algo igual de valioso: acerca la plataforma al estándar operativo que se exige en producción. El soporte de Debian 13, los repos acomodados, los alias de red, el SDN con spine–leaf, el ZFS que crece en caliente y —sobre todo— las reglas de afinidad/anti-afinidad dibujan una solución que se toma en serio la resiliencia y el control.

Si Proxmox VE 8 fue el punto en el que muchos dejaron de verlo solo como “un buen hypervisor gratuito”, Proxmox 9 es la versión que invita a operarlo como plataforma. Con método, pruebas y gobierno, está preparado para jugar en ligas mayores.

Preguntas frecuentes (FAQ)

¿Qué cambia realmente con Proxmox 9 frente a 8?

Además de la base Debian 13 “Trixie” y la reorganización de repositorios, aporta alias de red (operativa más clara), SDN con definición de fabric spine–leaf (coherencia de redes lógicas), crecimiento en caliente de ZFS (capacidad sin rehacer pools) y —clave— reglas de afinidad/anti-afinidad para colocación inteligente de VMs en HA.

¿Puedo adoptar Proxmox 9 directamente en producción?

Técnicamente sí, pero la recomendación es staging con cargas reales, validar playbooks, ensayar fallos (HA, red, discos) y tener plan de rollback. Si introduces SDN, ZFS y afinidad a la vez, secuéncialo: primero red, luego almacenamiento, luego políticas de colocación.

¿Para quién aporta más valor Proxmox 9?

Para equipos que necesitan control (afinidades), crecer sin rehacer almacenamiento (ZFS) y ordenar redes lógicas (SDN) sin entrar en complejidades propietarias. Service providers, mid-market y TI corporativa con mentalidad infra-as-code le sacan especial partido.

¿Qué riesgos debo vigilar en el salto a Debian 13?

Los propios de una base nueva: módulos, drivers y dependencias que cambian de repo. Mitiga con staging, control de versiones de tooling (Ansible, Terraform, Packer), y observabilidad afinada durante las primeras semanas de vida del clúster.