En el mundo de la inteligencia artificial, la búsqueda por mejorar el razonamiento en modelos de lenguaje ha dado un nuevo paso con la aparición de Open-R1, un proyecto que pretende reconstruir de forma abierta el pipeline de entrenamiento de DeepSeek-R1. La iniciativa, que ha captado la atención de la comunidad tecnológica, se basa en la reciente difusión de DeepSeek-R1 y su innovador enfoque en el uso del aprendizaje por refuerzo para potenciar el razonamiento en tareas complejas.

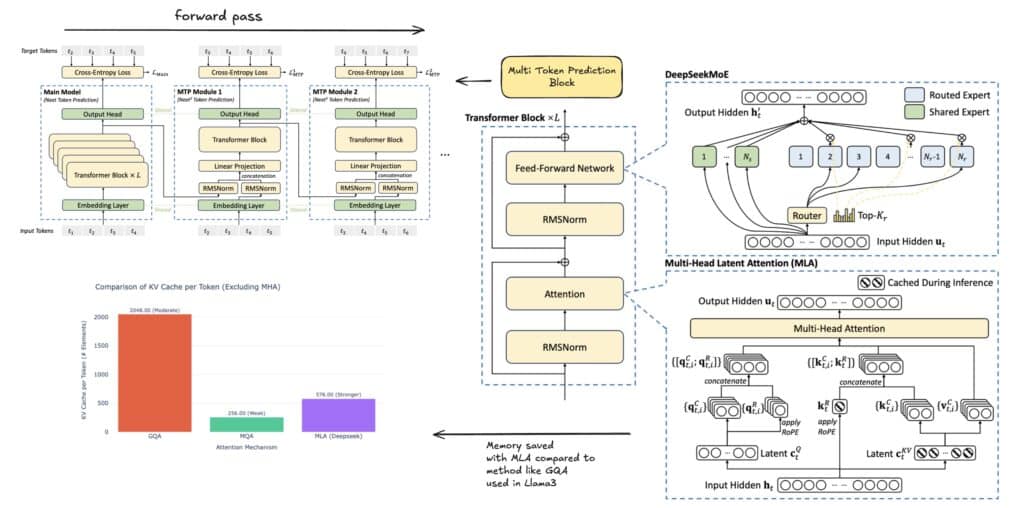

DeepSeek-R1 se destacó inicialmente por su capacidad para resolver problemas matemáticos, de programación y de lógica, superando incluso a modelos de referencia como el o1 de OpenAI. El secreto detrás de su éxito radica en el uso intensivo de cómputo durante la inferencia, lo que permitió al modelo aprender a descomponer problemas complejos y verificar sus propias respuestas. Además, el modelo se fundamenta en DeepSeek-V3, un robusto modelo de 671B Mixture of Experts (MoE) que ha demostrado un rendimiento equiparable al de otros gigantes como Sonnet 3,5 y GPT-4o. Uno de los aspectos más llamativos de este enfoque fue la eficiencia en costes, alcanzada con una inversión de tan solo 5,5 millones de dólares, gracias a innovaciones arquitectónicas como la Predicción de Múltiples Tokens (MTP) y la Atención Latente Multi-Cabeza (MLA).

La versión DeepSeek-R1 se diferencia de su variante DeepSeek-R1-Zero en su metodología de entrenamiento. Mientras que la versión «Zero» prescindió de la supervisión humana y se apoyó exclusivamente en el aprendizaje por refuerzo mediante la optimización de políticas relativas en grupo (GRPO), DeepSeek-R1 incorporó una fase inicial de “cold start”. Esta etapa consistió en afinar el modelo con un pequeño conjunto de ejemplos cuidadosamente seleccionados para mejorar la claridad y la legibilidad de las respuestas. Posteriormente, el modelo pasó por sucesivas fases de refuerzo y refinamiento, incluyendo la eliminación de salidas de baja calidad mediante recompensas verificables y basadas en la preferencia humana.

No obstante, pese al impacto que ha generado DeepSeek-R1, su lanzamiento dejó algunas interrogantes sin responder. Aunque los pesos del modelo fueron liberados, los conjuntos de datos y el código utilizados en su entrenamiento permanecen en reserva. Frente a esta limitación, Open-R1 se plantea reconstruir estos componentes esenciales para que tanto la comunidad investigadora como la industria puedan replicar o incluso mejorar los resultados obtenidos por DeepSeek-R1.

El plan de acción de Open-R1 se estructura en varios pasos fundamentales:

- Replicación de los modelos R1-Distill: Se pretende destilar un conjunto de datos de razonamiento de alta calidad a partir de DeepSeek-R1.

- Reconstrucción del pipeline de aprendizaje por refuerzo: Se buscará reproducir el proceso que permitió crear la versión R1-Zero, lo que implicará la curación de nuevos conjuntos de datos a gran escala orientados a matemáticas, razonamiento y código.

- Validación del entrenamiento multi-etapa: Se demostrará que es posible pasar de un modelo base a uno afinado mediante supervisión (SFT) y, posteriormente, a través de aprendizaje por refuerzo.

El uso de conjuntos de datos sintéticos facilitará a investigadores y desarrolladores la tarea de convertir modelos de lenguaje existentes en modelos especializados en razonamiento. Asimismo, la documentación detallada de este proceso aspira a compartir conocimientos que eviten el gasto innecesario de recursos computacionales y de tiempo en enfoques infructuosos.

La relevancia de esta iniciativa no se limita al ámbito de las matemáticas o la programación. El potencial impacto de los modelos de razonamiento abarca campos tan diversos como la medicina y otras áreas científicas, donde la capacidad de descomponer y analizar problemas complejos puede marcar una diferencia significativa.

Open-R1 se presenta, por tanto, no solo como un ejercicio de replicación técnica, sino como una propuesta de colaboración abierta. Invitando a la comunidad a contribuir con código, participar en debates en plataformas como Hugging Face y aportar con ideas, el proyecto pretende sentar las bases para el desarrollo de futuros modelos de inteligencia artificial con capacidades de razonamiento avanzadas.

La apuesta por la transparencia y la colaboración en el ámbito del aprendizaje por refuerzo abre nuevas perspectivas en el desarrollo de tecnologías de inteligencia artificial, impulsando una era en la que la ciencia y la industria trabajan de la mano para desentrañar los retos del razonamiento automatizado.