La inferencia se ha convertido en el nuevo campo de batalla de la inteligencia artificial. Los modelos actuales ya no son simples generadores de texto o imágenes: evolucionan hacia sistemas agénticos capaces de razonar en múltiples pasos, mantener memoria persistente y gestionar contextos de millones de tokens. Para afrontar este desafío, NVIDIA ha presentado Rubin CPX, una GPU diseñada específicamente para acelerar las cargas de trabajo de contexto masivo con mayor rendimiento y eficiencia.

El reto de la inferencia a gran escala

A medida que la IA se integra en más industrias, las exigencias cambian. En el desarrollo de software, por ejemplo, los copilotos de programación necesitan analizar repositorios completos, dependencias entre archivos y estructuras de proyectos. En vídeo, la generación de contenidos largos requiere coherencia sostenida durante horas de metraje, algo que puede equivaler a más de un millón de tokens por contexto.

Estas cargas superan los límites de las infraestructuras tradicionales, que fueron diseñadas para contextos relativamente cortos. El problema no es solo computacional: también afecta a la memoria, el ancho de banda de red y la eficiencia energética, obligando a repensar cómo escalar la inferencia.

Disaggregated inference: separar para optimizar

NVIDIA propone una arquitectura de inferencias desagregadas, donde el procesamiento se divide en dos fases diferenciadas:

- Fase de contexto: intensiva en cómputo. El sistema debe ingerir y analizar grandes volúmenes de datos para preparar la primera salida.

- Fase de generación: intensiva en memoria. Requiere transferencias rápidas y un interconectado eficiente para producir resultados token por token.

Separar estas fases permite optimizar recursos de forma específica, dedicando más potencia a la ingestión inicial y más ancho de banda a la generación sostenida. Sin embargo, también introduce nuevas capas de complejidad: coordinación de cachés clave-valor (KV cache), enrutamiento sensible al modelo y gestión avanzada de memoria.

Aquí entra en juego NVIDIA Dynamo, la plataforma de orquestación que sincroniza estos procesos y que ha sido clave en los últimos récords de MLPerf Inference.

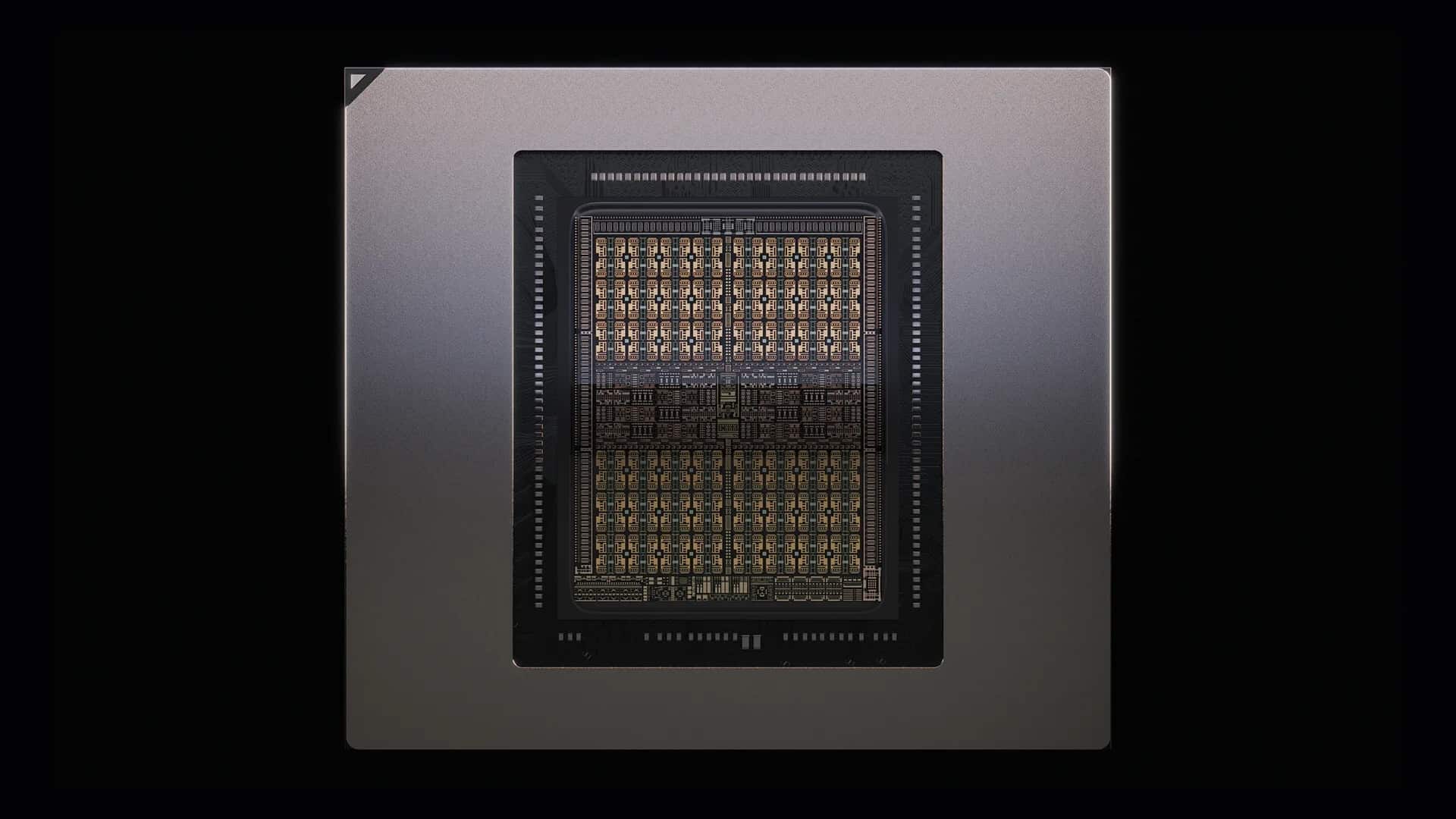

Rubin CPX: aceleración para el contexto masivo

Rubin CPX es la respuesta al cuello de botella en la fase de contexto. Diseñada con la arquitectura Rubin, la GPU entrega:

- 30 petaFLOPs de cómputo en NVFP4.

- 128 GB de memoria GDDR7 de alta eficiencia.

- Aceleración 3 veces superior en mecanismos de atención respecto a la serie GB300 NVL72.

- Soporte nativo para decodificación y codificación de vídeo de alta resolución.

Gracias a estas características, Rubin CPX se posiciona como la pieza clave para aplicaciones de alto valor, desde el desarrollo de software con IA hasta la generación de vídeo HD y la investigación de gran escala.

Vera Rubin NVL144 CPX: potencia a escala exaFLOP

La nueva GPU no llega sola. Forma parte de la plataforma NVIDIA Vera Rubin NVL144 CPX, un rack que integra:

- 144 GPUs Rubin CPX para la fase de contexto.

- 144 GPUs Rubin para la fase de generación.

- 36 CPUs Vera para coordinar y optimizar el flujo de trabajo.

El resultado es una capacidad de 8 exaFLOPs en NVFP4, con 100 TB de memoria de alta velocidad y 1,7 PB/s de ancho de banda, todo en un solo rack. Esta potencia es 7,5 veces superior a la de la plataforma GB300 NVL72, marcando un nuevo estándar en la industria.

La interconexión se apoya en Quantum-X800 InfiniBand y Spectrum-X Ethernet, junto a ConnectX-9 SuperNICs, asegurando baja latencia y escalabilidad en entornos de IA distribuida.

Economía de la inferencia: ROI en el centro

Más allá del rendimiento, NVIDIA subraya el impacto económico. Según sus cálculos, un despliegue basado en Rubin CPX puede ofrecer entre 30 y 50 veces el retorno de la inversión (ROI), generando hasta 5.000 millones de dólares en ingresos por tokens con una inversión de 100 millones en CAPEX.

Este enfoque refleja un cambio de métrica: ya no se mide solo en FLOPs, sino en tokens procesados de manera rentable, un indicador clave para empresas que ofrecen servicios basados en IA generativa.

Casos de uso transformadores

El valor de Rubin CPX se traduce en aplicaciones concretas:

- Desarrollo de software: asistentes que comprenden repositorios enteros, históricos de commits y documentación sin necesidad de reentrenar.

- Generación de vídeo: IA capaz de mantener coherencia narrativa y visual en contenidos de larga duración, con calidad cinematográfica.

- Investigación y ciencia: análisis de grandes bases de conocimiento, permitiendo a los agentes de IA trabajar con corpus extensos en tiempo real.

- Agentes autónomos: sistemas capaces de tomar decisiones complejas gracias a memorias contextuales de escala millonaria.

Un ecosistema preparado

Rubin CPX se integra plenamente en el stack de software de NVIDIA:

- TensorRT-LLM, para optimizar inferencias de modelos de lenguaje.

- NVIDIA Dynamo, como capa de orquestación y eficiencia de recursos.

- Nemotron, familia de modelos multimodales con capacidades de razonamiento avanzado.

- NVIDIA AI Enterprise, que garantiza despliegues listos para producción en nubes, centros de datos y estaciones de trabajo.

Disponibilidad

NVIDIA espera que Rubin CPX esté disponible a finales de 2026, coincidiendo con la creciente demanda de inferencia de contexto largo y el auge de los agentes de IA de nueva generación.

Conclusión

Con Rubin CPX, NVIDIA no se limita a presentar otra GPU más: propone una nueva forma de pensar la inferencia, separando las fases de contexto y generación, y ofreciendo un hardware especializado para cada una.

En un mundo donde la IA necesita comprender repositorios completos, generar vídeos de horas y sostener agentes autónomos, esta arquitectura no solo aporta potencia, sino también eficiencia y viabilidad económica.

Rubin CPX y la plataforma Vera Rubin NVL144 CPX redefinen el futuro de la IA, poniendo a la inferencia masiva en el centro del debate tecnológico y empresarial.

Preguntas frecuentes (FAQ)

¿Qué diferencia a Rubin CPX de otras GPUs de NVIDIA?

Rubin CPX está diseñada específicamente para la fase de contexto de inferencia, optimizando el procesamiento de secuencias largas y ofreciendo hasta 3 veces más rendimiento en atención que generaciones anteriores.

¿Qué es la inferencia desagregada?

Es un modelo que separa el procesamiento en dos fases —contexto y generación—, permitiendo optimizar de forma independiente cómputo y memoria para mejorar eficiencia y latencia.

¿Qué retorno económico puede aportar Rubin CPX?

NVIDIA estima un ROI de 30 a 50 veces, con ingresos de hasta 5.000 millones de dólares por tokens por cada 100 millones invertidos en infraestructura.

¿Cuándo estará disponible Rubin CPX?

La GPU y la plataforma Vera Rubin NVL144 CPX estarán listas para clientes a finales de 2026.

vía: developer.nvidia