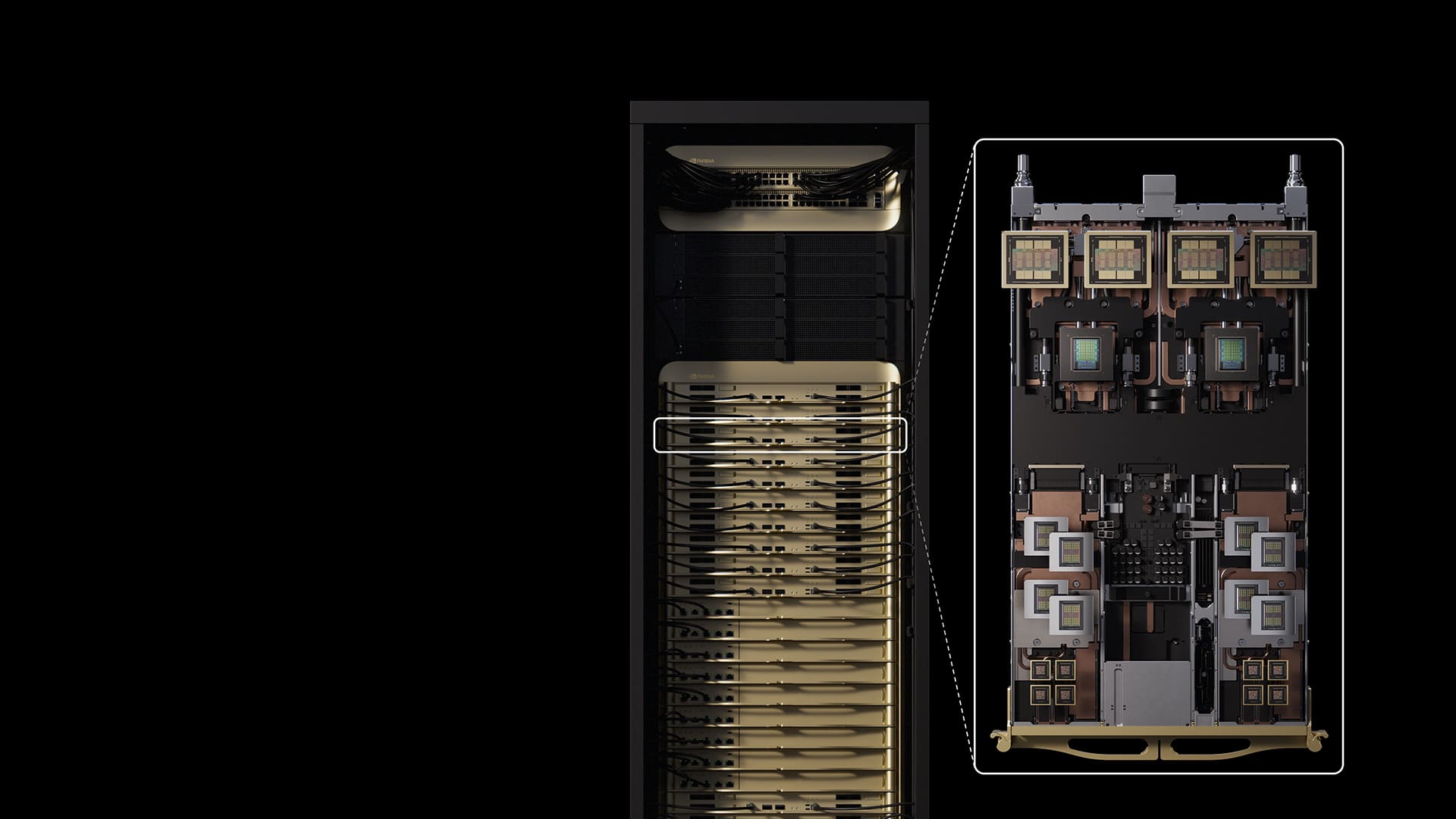

NVIDIA ha mostrado por primera vez en público su Vera Rubin Superchip, la plataforma que marcará su siguiente gran salto en computación de IA tras Blackwell. Sobre el escenario de GTC Washington (octubre de 2025), Jensen Huang enseñó una placa real que integra dos GPUs Rubin y una CPU Vera de 88 núcleos Arm (176 hilos), enlazadas mediante NVLink-C2C a 1,8 TB/s y acompañadas por memoria “rápida” en placa (LPDDR) que en la demo alcanzaba 2,0 TB, además de HBM4 en cada GPU. Según la hoja de ruta divulgada, los primeros Rubin ya han llegado a los laboratorios de NVIDIA y la producción en volumen arrancaría a finales de 2026 (entre el 3.º y 4.º trimestre), en paralelo al despliegue de Blackwell Ultra (GB300).

La compañía presentó también los dos sistemas de referencia que estandarizarán Rubin en centros de datos: NVL144 (2026) y Rubin Ultra NVL576 (2027), con incrementos notables en cómputo, memoria y red frente a la generación Blackwell.

Qué es Vera Rubin Superchip (y por qué importa)

Vera Rubin condensa el enfoque de NVIDIA hacia sistemas “rack-scale”: CPU + GPU en un mismo superchip con interconexión de alta velocidad, memoria LPDDR local como “fast memory” para la parte de control/servicios y HBM4 pegada a cada GPU para maximizar ancho de banda en entrenamiento e inferencia. La CPU Vera adopta 88 núcleos Arm personalizados (176 hilos) y actúa como coordinador cercano de las dos GPUs Rubin —cada una formada por dos troqueles de tamaño retícula—.

En la placa mostrada en GTC, además del denso power delivery alrededor de las GPUs, se aprecian varios módulos de memoria LPDDR para la CPU, y el rótulo de la demo destacaba “100 PF AI” y “2 TB Fast Memory”, dejando claro el posicionamiento del conjunto como motor de IA generativa y agentic a gran escala.

NVL144 (2026): 3,6 exaflops FP4 e interconexión renovada

El primer sistema de la familia será Vera Rubin NVL144, previsto para la segunda mitad de 2026. Su ficha técnica apunta a:

- GPU Rubin: dos chiplets “reticle-sized” por GPU, hasta 50 PFLOPS FP4 por acelerador y 288 GB de HBM4 por GPU.

- CPU Vera: 88 núcleos Arm / 176 hilos.

- Enlace CPU–GPU: NVLink-C2C a 1,8 TB/s.

- Rendimiento (plataforma): 3,6 exaflops de FP4 (inferencia) y 1,2 exaflops de FP8 (entrenamiento), ≈ 3,3× sobre GB300 NVL72.

- Memoria: 13 TB/s de ancho de banda agregado HBM4 y ≈ 75 TB de “fast memory” total a nivel de rack/sistema.

- Red: NVLink hasta 260 TB/s y CX9 hasta 28,8 TB/s.

El objetivo de NVIDIA con NVL144 es ofrecer una rampa inmediata para quienes están estandarizando GB300 y quieran doblar densidad de cómputo y ancho de banda sin rehacer todo el “data plane”.

Rubin Ultra NVL576 (2027): cuatro chiplets por GPU, 1 TB de HBM4e y hasta 15 exaflops FP4

En 2027 llegará Rubin Ultra NVL576, que escala la topología a 576 GPUs y duplica el número de chiplets por GPU:

- GPU Rubin Ultra: cuatro troqueles de tamaño retícula por GPU, hasta 100 PFLOPS FP4 por acelerador y 1 TB de HBM4e por GPU (16 stacks).

- Rendimiento (plataforma): 15 exaflops de FP4 (inferencia) y 5 exaflops de FP8 (entrenamiento), ≈ 14× sobre GB300 NVL72.

- Memoria: 4,6 PB/s de ancho de banda HBM4 y ≈ 365 TB de “fast memory”.

- Red: hasta 1,5 PB/s vía NVLink y 115,2 TB/s en CX9, con salto generacional en NVLink/NVSwitch.

Varios análisis industriales estiman, además, que el rack NVL576 —en su configuración líquida— rondará los 600 kW de potencia, lo que ilustra el reto térmico-eléctrico de la próxima ola de superchips de IA.

Cómo encaja con Blackwell (GB300) y qué cambia

Blackwell Ultra (GB300) es la plataforma de 2025 para acelerar casos de IA generativa con HBM3e y saltos claros en FP4/FP8 frente a Hopper. Rubin empuja ese listón con HBM4/HBM4e, chiplets de mayor tamaño efectivo (dentro del límite reticular), interconexión y memoria reforzadas, y una CPU Arm vecina, con LPDDR de gran capacidad para servicios/coordinar. En cifras, NVL144 promete ≈3,3× sobre GB300 NVL72, y Rubin Ultra multiplica por 14.

La convivencia es esperable: GB300 seguirá entrando en producción y ampliando flotas en 2025-2026, mientras Rubin se prepara en 2026 para cubrir picos de entrenamiento e inferencia masiva con necesidades de ancho de banda y memoria aún más agresivas.

Cadena de suministro: HBM4 y ventana de producción

El detalle de HBM4/HBM4e es crucial. La transición desde HBM3e implicará nuevas pilas (más anchas/altas), materiales y empacado más exigente, además de coordinación con TSMC para el interposer y con los grandes proveedores de memoria. NVIDIA afirma haber recibido las primeras GPUs Rubin y sitúa la producción en masa para finales de 2026 —una meta coherente con los tiempos de calificación de HBM4 y del ecosistema de placas/racks.

Riesgos y preguntas abiertas

Como en toda presentación de futuro, las cifras son objetivos: a medida que HBM4 y los chiplets vayan madurando, veremos ajustes en frecuencias, consumos y rendimientos (yield). También quedan por detallar los modos de FP soportados por Rubin (FP4/FP8/BF16/FP16) y la distribución exacta entre memoria rápida LPDDR y HBM según configuración.

Lo que sí deja claro la demo de GTC es la dirección: más memoria, más ancho de banda y más densidad por rack, con el CPU–GPU “pegados” y NVLink como sistema nervioso de la granja.

Preguntas frecuentes

¿Qué diferencia a Rubin de Blackwell?

Rubin introduce HBM4/HBM4e, GPUs multi-chiplet más grandes (dentro de la retícula), CPU Arm Vera integrada (88 núcleos) y NVLink-C2C a 1,8 TB/s entre CPU y GPU. Frente a GB300, NVL144 escala ≈3,3× en FP4/FP8 y Rubin Ultra llega hasta 14× sobre NVL72.

¿Qué significan los “exaflops FP4/FP8”?

Son unidades de rendimiento en flotante de baja precisión (FP4/FP8) usadas para IA generativa: FP8 suele emplearse en entrenamiento; FP4, en inferencia a gran escala. No deben compararse 1:1 con FP64 de HPC tradicional.

¿Cuándo podrá comprarse Rubin?

NVIDIA sitúa la producción en volumen para finales de 2026. Los sistemas NVL144 apuntan a 2.º semestre de 2026, y Rubin Ultra NVL576, a 2.º semestre de 2027. El despliegue real dependerá de HBM4, validación de plataforma y capacidad de fabricación.

¿Qué papel juega la “fast memory” de 2,0 TB?

Es LPDDR en placa asociada a la CPU Vera para servicios, coordinación y trabajos de control cercanos a la GPU. No sustituye a la HBM4 de las GPUs —que es la que alimenta el cómputo intensivo—, pero reduce latencias y alivia el acceso a datos no residentes en HBM.

Fuentes (selección):

Cobertura y especificaciones preliminares del Vera Rubin Superchip, NVL144 (2026) y Rubin Ultra NVL576 (2027); primeras imágenes del hardware en GTC Washington 2025; detalles de CPU Vera (88 Arm/176 hilos), HBM4/HBM4e, NVLink-C2C 1,8 TB/s y objetivos de rendimiento/memoria/red.