NVIDIA ha vuelto a mover ficha en la carrera tecnológica que define la inteligencia artificial a gran escala. Su nuevo chip, Blackwell Ultra, no es solo un salto evolutivo respecto a generaciones anteriores: representa el corazón de lo que la propia compañía denomina la era de las fábricas de IA, infraestructuras capaces de entrenar y ejecutar modelos multimodales con billones de parámetros y dar servicio en tiempo real a miles de millones de usuarios.

La presentación oficial, detallada en la web de desarrolladores de NVIDIA, muestra cómo innovaciones en el silicio, la memoria y la interconexión se combinan para ofrecer niveles de rendimiento y eficiencia sin precedentes.

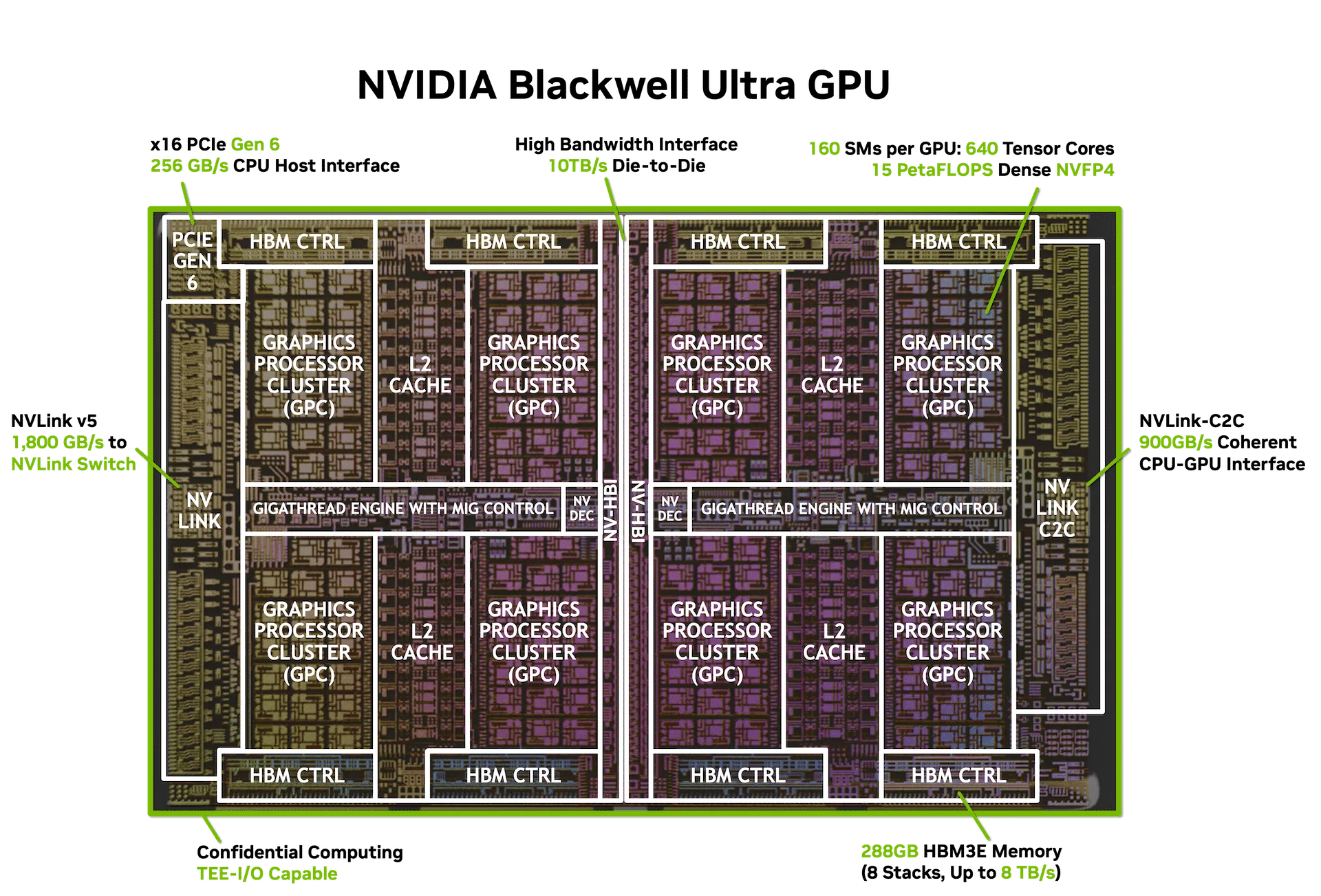

Un diseño dual para superar los límites físicos

El Blackwell Ultra introduce un diseño dual-retícula: dos dies del tamaño máximo que permite la fotolitografía, unidos mediante NV-HBI, una interconexión personalizada de 10 TB/s. De esta forma, el chip funciona como un único acelerador programable con CUDA, manteniendo la compatibilidad con el ecosistema de software que NVIDIA lleva perfeccionando dos décadas.

El resultado son 208.000 millones de transistores, 2,6 veces más que la arquitectura Hopper, integrados en un solo chip lógico.

Tensor Cores de quinta generación y NVFP4

El corazón de cada GPU lo componen 160 multiprocesadores de streaming (SMs) organizados en ocho clústeres. Cada SM alberga:

- 128 CUDA Cores tradicionales.

- 4 Tensor Cores de quinta generación con la segunda iteración del Transformer Engine, optimizados para formatos de baja precisión como FP8, FP6 y el nuevo NVFP4.

- 256 KB de Tensor Memory, diseñados para reducir tráfico hacia memoria externa.

El nuevo formato NVFP4 combina escalado por bloques en FP8 con precisión FP32 a nivel tensorial, logrando un equilibrio entre eficiencia y precisión casi idéntico al FP8, pero con hasta un 3,5x menos consumo de memoria.

Esto se traduce en 15 PetaFLOPS de potencia densa en NVFP4, un 1,5x más que el Blackwell estándar y 7,5 veces más que un Hopper H100/H200.

Softmax acelerado: IA más rápida y eficiente

Uno de los cuellos de botella más comunes en los modelos transformadores es el cálculo de softmax en las capas de atención. NVIDIA ha duplicado el rendimiento de las unidades matemáticas especiales (SFUs) dedicadas a estas operaciones, alcanzando 10,7 teraexponenciales por segundo.

En la práctica, esto significa:

- Reducción del tiempo al primer token en modelos conversacionales.

- Mayor eficiencia energética al disminuir ciclos de cómputo por consulta.

- Mejor experiencia de usuario en aplicaciones interactivas y de razonamiento.

Memoria a escala de trillones de parámetros

Blackwell Ultra incluye 288 GB de memoria HBM3e por GPU, un 50% más que Blackwell y 3,6 veces más que Hopper. Con un ancho de banda de 8 TB/s, esta capacidad permite:

- Alojar modelos de más de 300.000 millones de parámetros sin recurrir a técnicas de offloading.

- Ampliar la longitud de contexto en modelos de lenguaje.

- Ejecutar inferencias de alta concurrencia con menor latencia.

Interconexión: el tejido nervioso de la fábrica de IA

El chip soporta NVLink 5, con 1,8 TB/s de ancho de banda bidireccional por GPU, duplicando lo disponible en Hopper. Además:

- Puede integrarse en topologías de hasta 576 GPUs sin bloqueo.

- Se conecta con CPUs Grace mediante NVLink-C2C (900 GB/s).

- Ofrece compatibilidad con PCIe Gen6 (256 GB/s).

Esto permite construir configuraciones NVL72, con 72 GPUs interconectadas y 130 TB/s de ancho de banda agregado, pensadas para clústeres de entrenamiento e inferencia a escala masiva.

Más allá del rendimiento: seguridad y fiabilidad

Blackwell Ultra también incorpora mejoras pensadas para despliegues empresariales:

- Multi-Instance GPU (MIG): permite particionar una GPU en hasta 7 instancias con memoria dedicada, habilitando multi-tenancy seguro.

- Confidential Computing y TEE-I/O: extiende entornos de ejecución confiables al GPU, protegiendo modelos y datos sensibles.

- RAS (Reliability, Availability, Serviceability) con IA: monitoriza miles de parámetros para predecir fallos y optimizar mantenimientos.

Procesamiento multimodal acelerado

Además del cómputo clásico, el chip incluye motores especializados para vídeo, imágenes y compresión de datos:

- NVDEC para códecs como AV1, HEVC y H.264.

- NVJPEG para descompresión masiva de imágenes.

- Motor de descompresión a 800 GB/s, reduciendo carga en CPU y acelerando flujos de datos en entrenamientos.

Del chip a la fábrica de IA

NVIDIA integra Blackwell Ultra en varias configuraciones:

- Grace Blackwell Ultra Superchip: un CPU Grace más dos GPUs Blackwell Ultra, con 1 TB de memoria unificada y hasta 40 PetaFLOPS en NVFP4 esparso.

- GB300 NVL72: rack líquido con 36 superchips, alcanzando 1,1 exaFLOPS en FP4, con innovaciones de gestión energética para suavizar picos de consumo.

- HGX y DGX B300: configuraciones estándar de 8 GPUs para despliegues flexibles.

Impacto en la economía de la IA

Los datos son claros: con más tokens por segundo por megavatio y menor coste por inferencia, Blackwell Ultra mejora la ecuación económica de las IA generativas. Esto es clave en un momento en el que entrenar un modelo de última generación puede costar cientos de millones de dólares en infraestructura y energía.

Según NVIDIA, su nueva plataforma reduce un 50% el coste energético por token frente a Hopper, lo que podría ser decisivo para la adopción masiva en sectores como:

- Sanidad (descubrimiento de fármacos, análisis de imágenes médicas).

- Automoción (sistemas avanzados de conducción autónoma).

- Finanzas (modelado de riesgos y predicción en tiempo real).

- Entretenimiento (renderizado y generación de contenido en streaming).

Preguntas frecuentes (FAQ)

¿Qué diferencia a Blackwell Ultra de Blackwell “estándar”?

Aporta un 50% más de rendimiento NVFP4, un 50% más de memoria HBM3e, y duplica el rendimiento en operaciones de softmax, fundamentales en modelos de lenguaje.

¿Qué aplicaciones se beneficiarán más de Blackwell Ultra?

Los modelos de lenguaje multimodales con trillones de parámetros, aplicaciones de razonamiento en tiempo real y servicios de inferencia masiva en la nube.

¿Qué significa que alcance 1,1 exaFLOPS?

En configuraciones de rack completo (GB300 NVL72), Blackwell Ultra ofrece exaescala en precisión FP4, pensada para IA generativa y simulaciones masivas.

¿Será compatible con CUDA y software existente?

Sí. NVIDIA mantiene la compatibilidad total con CUDA, sus bibliotecas y frameworks de IA, asegurando una transición fluida para desarrolladores e investigadores.

📌 Con Blackwell Ultra, NVIDIA no solo refuerza su posición de liderazgo: marca el estándar técnico y económico para la próxima década de la inteligencia artificial.