Durante décadas, la robótica ha brillado donde todo está medido al milímetro: cadenas de montaje, entornos controlados, tareas repetitivas y guiones cerrados. Pero la industria lleva tiempo persiguiendo un salto cualitativo: máquinas capaces de desenvolverse en escenarios cotidianos, con objetos distintos cada día, con interferencias humanas y con margen para el error. En ese contexto, Microsoft Research ha presentado Rho-alpha (ρα), su primer modelo de robótica derivado de la familia Phi de modelos de visión y lenguaje, con el objetivo de acercar la llamada IA física —la convergencia entre IA agéntica y sistemas físicos— a robots que puedan percibir, razonar y actuar con mayor autonomía.

La compañía encuadra el anuncio en el auge de los modelos VLA (vision-language-action) para sistemas físicos, una corriente que busca unir percepción (visión), comprensión (lenguaje) y ejecución (acción) en un mismo “cerebro” operativo. Para Ashley Llorens, vicepresidente corporativo y director general de Microsoft Research Accelerator, esta clase de modelos está permitiendo que los sistemas físicos ganen autonomía en entornos mucho menos estructurados, más parecidos al mundo real que a una fábrica.

De entender instrucciones a mover un robot

Rho-alpha está diseñado para traducir órdenes en lenguaje natural en señales de control para robots que realizan manipulación bimanual, es decir, tareas que exigen coordinación fina de ambas manos o pinzas: empujar un botón, girar un mando, mover un deslizador o tirar de un cable. Microsoft lo describe como un VLA+, porque amplía capacidades frente a los VLAs habituales en dos dimensiones clave:

- Percepción ampliada: incorpora sensado táctil y, según el propio equipo, ya trabaja para añadir modalidades como la fuerza.

- Aprendizaje durante el despliegue: la ambición es que el modelo pueda mejorar en operación aprendiendo de la retroalimentación humana, un enfoque especialmente relevante cuando el robot se equivoca o queda “atascado” en una maniobra.

Este planteamiento apunta a un objetivo que Microsoft repite como hilo conductor: adaptabilidad. En robótica, adaptarse no es un eslogan; es la diferencia entre un sistema que funciona en una demo y uno que se sostiene en producción. El propio texto de Microsoft insiste en que los robots que ajusten su comportamiento a situaciones dinámicas y a preferencias humanas tenderán a ser más útiles y, sobre todo, más confiables para quienes los operan.

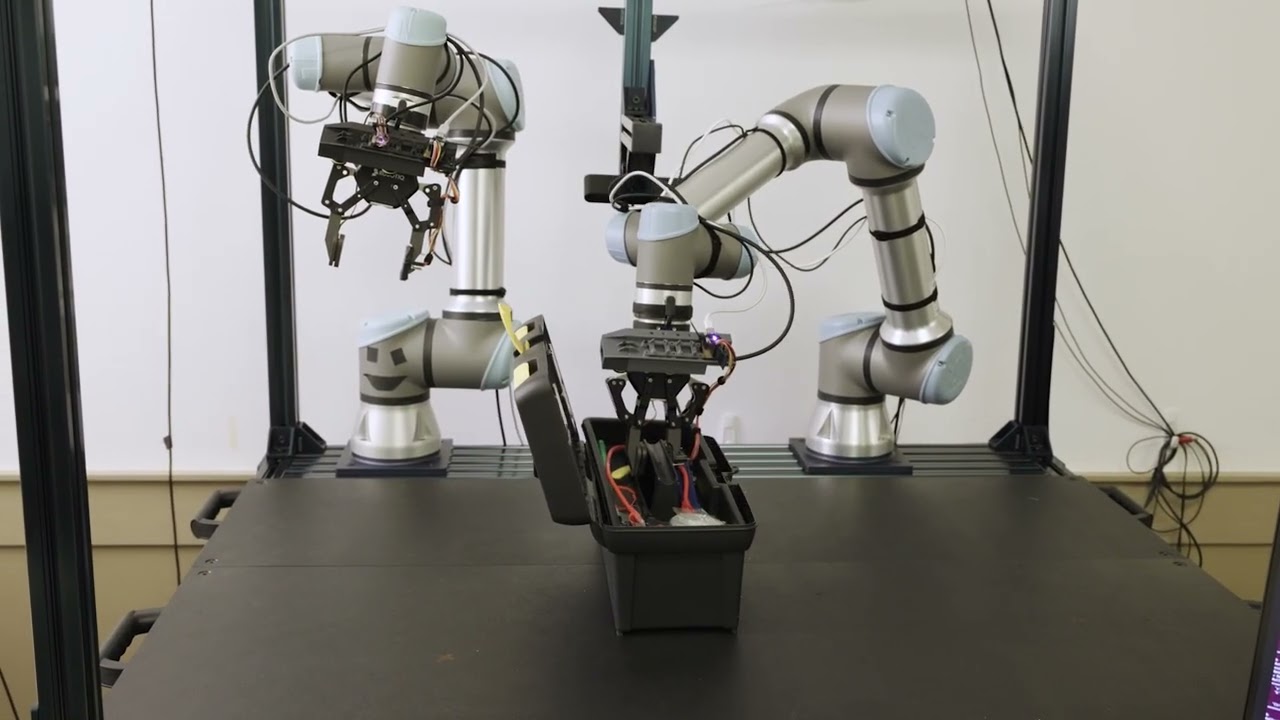

BusyBox, el “campo de pruebas” para la interacción física

Para mostrar el enfoque, Microsoft ha utilizado BusyBox, un benchmark físico introducido recientemente por Microsoft Research. En los vídeos y ejemplos citados, el robot responde a instrucciones del tipo “pulsa el botón verde”, “saca el cable rojo”, “gira el mando” o “mueve el deslizador”, y ejecuta la acción sobre un dispositivo diseñado para evaluar destrezas de manipulación en condiciones realistas.

BusyBox es relevante por una razón sencilla: durante años, comparar avances en robótica ha sido difícil por falta de pruebas estandarizadas que reflejen la variedad del mundo físico. Un banco de interacción que combine objetos, resistencia mecánica, tolerancias y fallos posibles ayuda a medir algo que en robótica importa tanto como la precisión: la capacidad de recuperación cuando las cosas no salen a la primera.

El gran cuello de botella: datos (y datos con tacto)

Si hay un problema estructural en la robótica moderna es la escasez de datos de entrenamiento a escala comparable a la de la IA de lenguaje o visión. Grabar demostraciones físicas es caro, lento y a veces directamente inviable. Por eso, Microsoft subraya que la simulación cumple un papel central para superar la falta de datos de preentrenamiento, especialmente cuando se busca incluir señales menos comunes como el tacto.

La receta que describe el equipo combina:

- Trayectorias de demostraciones físicas (datos reales).

- Tareas simuladas generadas en un pipeline de varias fases, apoyado en aprendizaje por refuerzo.

- Integración de simulación con el framework NVIDIA Isaac Sim, y uso de Azure para producir conjuntos sintéticos físicamente plausibles.

- Co-entrenamiento adicional con datos a escala web de “visual question answering” (pregunta-respuesta visual), con la idea de inyectar comprensión visión-lenguaje en el comportamiento.

La aportación no es menor: la robótica necesita modelos que no solo “vean”, sino que también sientan y ajusten la acción en tiempo real. Ahí el tacto se convierte en algo más que un extra: puede ser el elemento que permita reducir errores al manipular enchufes, pestañas, cierres, tornillos o piezas con tolerancias.

Humanos en el circuito: corregir para aprender

Microsoft reconoce otro punto crítico: incluso ampliando percepción, los robots pueden cometer errores difíciles de resolver por sí solos. Por eso el equipo se centra en herramientas y técnicas para que el sistema aprenda de correcciones humanas durante la operación, por ejemplo mediante dispositivos de teleoperación intuitivos como un ratón 3D. En sus ejemplos, se muestra un escenario de inserción de un enchufe donde el robot tiene dificultades y recibe ayuda humana en tiempo real para completar la tarea.

Este enfoque “human-in-the-loop” no es un detalle: en entornos reales, la transición entre autonomía y asistencia es lo que determina si un robot reduce carga de trabajo o la aumenta con incidencias.

Qué viene ahora: evaluación, acceso temprano y un salto a plataforma

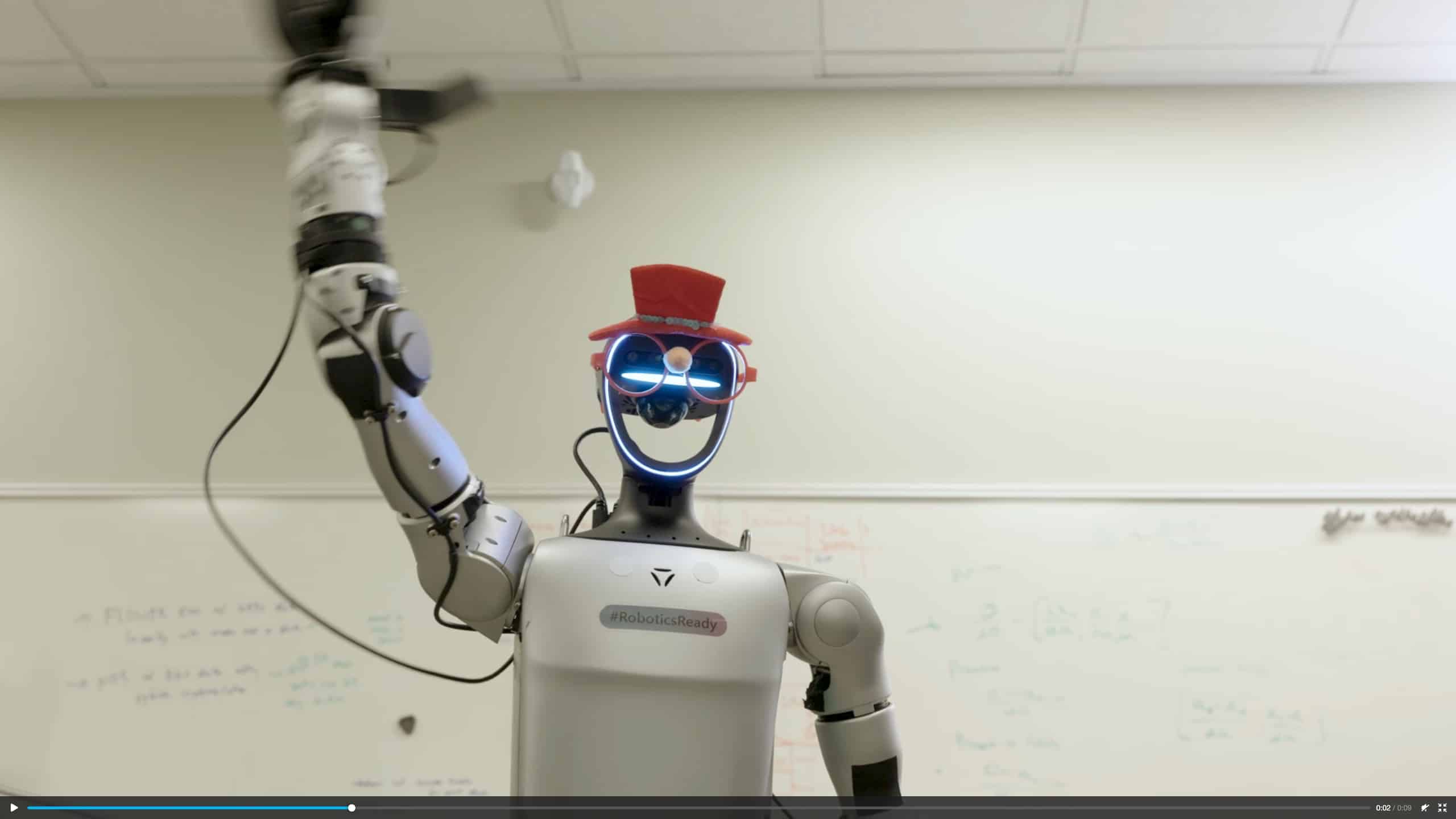

Microsoft afirma que Rho-alpha está en evaluación tanto en configuraciones de doble brazo como en robots humanoides, y que publicará una descripción técnica en los próximos meses. Además, invita a organizaciones interesadas a participar en un programa de acceso temprano (Research Early Access Program) y anticipa que el modelo también llegará más adelante a Microsoft Foundry.

En términos de industria, el mensaje es claro: la carrera por la IA ya no se limita a generar texto o imágenes. Se desplaza hacia sistemas capaces de actuar en el mundo físico con una mezcla exigente de percepción multimodal, control fino y aprendizaje continuo. Y, en ese tablero, el tacto —junto con la simulación y la corrección humana— se perfila como uno de los grandes aceleradores para pasar de demos vistosas a robótica útil.

Preguntas frecuentes

¿Qué es un modelo VLA y por qué es importante en robótica?

Un modelo vision-language-action (VLA) intenta conectar lo que el robot ve, lo que entiende en lenguaje natural y lo que hace (acciones de control), para operar en entornos menos estructurados que los industriales.

¿Qué aporta el “tacto” en un robot frente a usar solo visión?

El sensado táctil ayuda a detectar contacto, resistencia y deslizamientos. Es especialmente útil en tareas de manipulación fina (enchufes, interruptores, cables, pestañas), donde la visión por sí sola puede fallar por oclusiones o variaciones físicas.

¿Qué es BusyBox y para qué se utiliza?

BusyBox es un benchmark físico de Microsoft Research para evaluar habilidades de interacción y manipulación mediante tareas guiadas por lenguaje natural, como mover deslizadores, accionar interruptores o girar mandos.

¿Cuándo podrá usarse Rho-alpha fuera del laboratorio?

Microsoft ha indicado un programa de acceso temprano para organizaciones y un plan para ofrecerlo más adelante en Microsoft Foundry, además de una futura publicación técnica con más detalles.

vía: microsoft