La carrera por la inteligencia artificial tropieza con un límite físico: el calor. Cada nueva generación de GPU y aceleradores para IA incrementa la densidad de potencia y, con ella, la temperatura que deben disipar los centros de datos. Microsoft afirma haber superado un hito en ese frente con un sistema de refrigeración microfluídica “in-chip” que, en pruebas de laboratorio, extrajo calor hasta tres veces mejor que las placas frías (cold plates) actuales. El método lleva el líquido refrigerante al interior del propio silicio, donde se concentra la generación térmica, mediante microcanales grabados en la cara posterior del chip y una distribución de caudal guiada por IA para atacar puntos calientes específicos.

La compañía probó el sistema en un servidor que ejecutaba servicios núcleo de una reunión de Microsoft Teams simulada y, según sus ingenieros, además de aumentar el techo térmico, la técnica redujo hasta un 65 % el incremento máximo de temperatura dentro de una GPU (dato que, matiza, variará según el tipo de chip y la configuración).

Cómo funciona: del “frío encima” al “frío dentro”

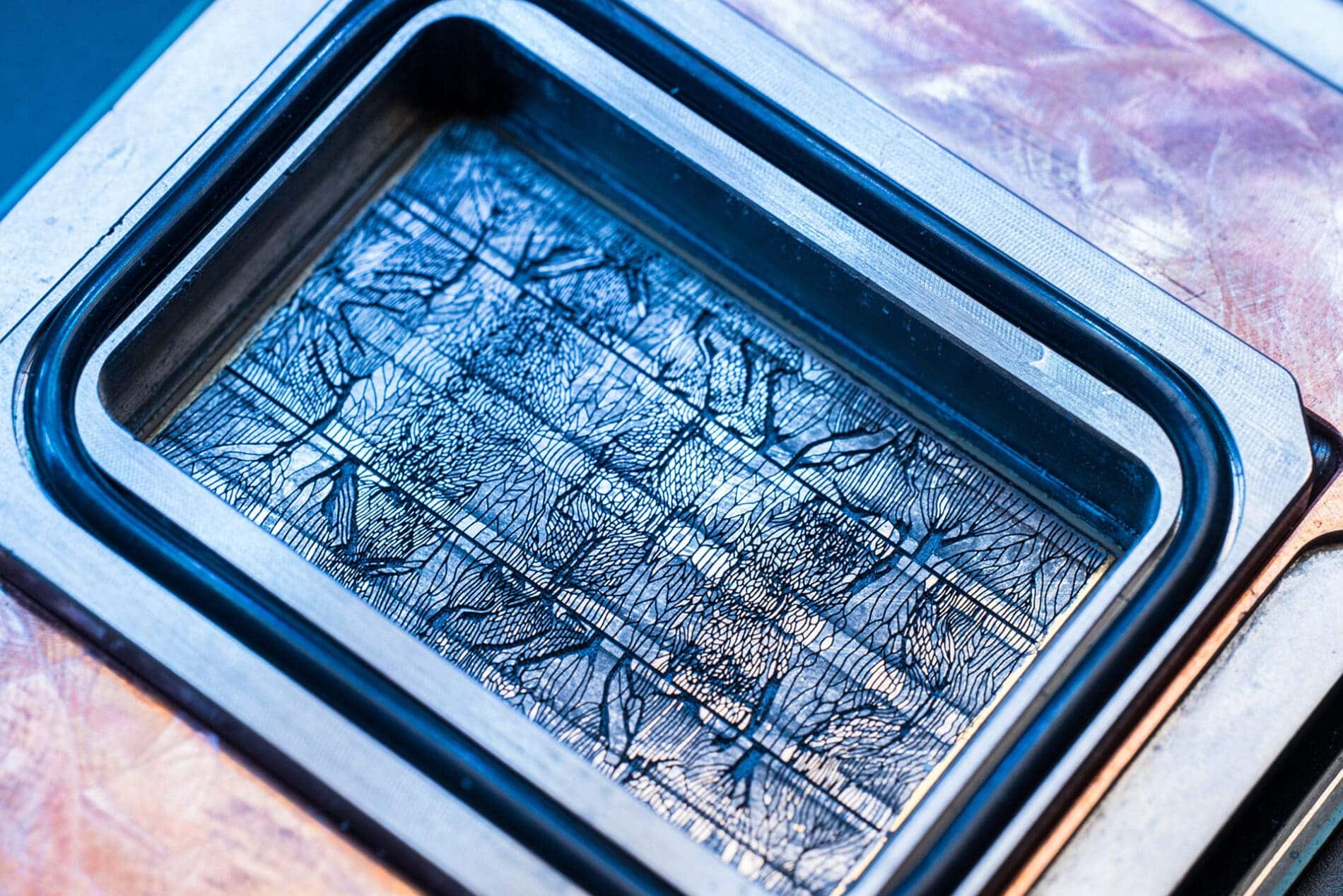

Las placas frías, omnipresentes ya en despliegues de alta densidad, apoyan un circuito de líquido sobre el encapsulado del chip. Entre la fuente de calor (dado) y el líquido hay varias capas que amortiguan el intercambio térmico: TIMs, esparcidores, sustratos… El enfoque microfluídico elimina intermediarios: graba microcanales —del grosor de un cabello humano— directamente en el silicio y hace circular el refrigerante por esas ranuras. Así acorta la distancia térmica, reduce las pérdidas y permite trabajar con refrigerante menos frío para extraer la misma (o mayor) cantidad de calor, con efectos en eficiencia energética del centro de datos y en coste operativo.

La arquitectura no es trivial. Los canales deben ser lo bastante profundos para mover caudal sin obstrucciones, pero no tanto como para debilitar el dado y comprometer su integridad. Además, el paquete final requiere estanqueidad absoluta, compatibilidad de materiales con el fluido, nuevos métodos de grabado y un proceso de fabricación que integre estas etapas adicionales sin romper rendimientos industriales. El equipo de Cloud Operations and Innovation de Microsoft indica que ha iterado cuatro diseños en el último año para cuadrar estas variables.

IA que aprende de las hojas: canales bioinspirados

La compañía colaboró con la startup suiza Corintis para optimizar la geometría de los microcanales con un diseño bioinspirado: en lugar de rejillas ortogonales, una ramificación similar a venas —como en una hoja o un ala— distribuye el flujo de forma más eficiente hacia los hotspots. El sistema complementa ese patrón con un modelo de IA que identifica firmas térmicas únicas de cada chip y dirige el caudal allí donde hace falta en cada carga de trabajo, reduciendo cuellos de botella que los canales uniformes no resuelven.

La idea reproduce una intuición de ingeniería de sistemas: no todos los bloques del chip calientan igual ni al mismo tiempo. En escenarios reales —desde un transcódigo hasta un attention kernel— la huella térmica cambia. Si el enfriamiento es adaptativo, el presupuesto térmico disponible para picos aumenta y, con él, el margen para exprimir rendimiento sin degradar fiabilidad.

¿Por qué ahora? El muro de las placas frías

La propia Microsoft advierte: en cinco años, si se sigue dependiendo en exceso de placas frías “habrá un techo” para la potencia por chip y por rack. El motivo es doble. Primero, cada capa entre líquido y dado resta coeficiente térmico. Segundo, la evolución de GPU con más HBM, más unidades y más frecuencia hace que el flujo de calor por milímetro crezca más rápido que la capacidad de extracción de soluciones “sobre el encapsulado”.

La refrigeración microfluídica acerca el fluido al punto de origen, lo que eleva el techo térmico y abre la puerta a nuevas arquitecturas: desde racks más densos (más servidores por metro) a chips 3D apilados con “pilares” microfluídicos que hagan circular el líquido entre capas —una imagen que los ingenieros comparan con los apoyos de un parking multilevel con el refrigerante fluyendo alrededor.

Más allá del termómetro: densidad, PUE y overclocking seguro

La compañía asocia tres efectos sistémicos a esta técnica:

- Densidad de cómputo: al elevar el techo térmico, se pueden acercar servidores sin caer en zonas de temperatura que penalicen fiabilidad. Menos distancia significa menos latencia entre nodos y más rendimiento por rack.

- Eficiencia energética (PUE): si el refrigerante no necesita estar tan frío para hacer el mismo trabajo, disminuye la energía dedicada a enfriar el líquido. Eso ahorra electricidad y, según Microsoft, reduce la presión sobre la red local.

- Flexibilidad operativa: en servicios con picos —como Teams, que concentra conexiones al inicio de cada franja—, poder empujar temporalmente el rendimiento (overclocking controlado) sin cruzar umbrales térmicos protege el SLA sin sobredimensionar capacidad ociosa.

Un rompecabezas de materiales, procesos y fiabilidad

El entusiasmo ingenieril convive con retos de manual que aún deben resolverse para pasar del laboratorio al fabricante y, de ahí, al centro de datos:

- Microfabricación: integrar el grabado de canales en la línea de proceso de cada fundición, con tolerancias estrictas y rendimientos industriales.

- Mecánica del paquete: garantizar estanqueidad, compatibilidad química del fluido, resistencia a ciclos térmicos y vibración, y mantenimiento sin degradar el chip.

- Calidad y control: detectar microfisuras o oclusión en canales a escala, con métodos no destructivos y reparabilidad razonable.

- Estándares: definir interfaces y protocolos comunes para que microfluidos no implique ecosistemas cerrados con costes operativos prohibitivos.

Microsoft dice haber centrado el siguiente tramo de trabajo en fiabilidad (reliability) y en industrializar el método con socios de fabricación para incorporarlo a futuras generaciones de sus chips Cobalt y Maia, además de explorar su generalización con terceros en Azure.

El contexto: inversión récord y enfoque de pila completa

El empuje microfluídico encaja en una estrategia más amplia: ajustar cada capa de la nube —del silicio a la sala— para exprimir rendimiento y contener consumo. La empresa planea invertir más de 30.000 millones de dólares en capex este trimestre, una cifra alineada con la necesidad de ampliar capacidad y modernizar la infraestructura con chips propios optimizados para cargas de clientes.

Aun así, los chips son una pieza de un sistema complejo. Tablas, racks, redes, fibra y software de orquestación deben moverse en bloque para que las ganancias térmicas se traduzcan en velocidad, estabilidad y coste unitario competitivos.

¿Qué significa para la industria?

Si la refrigeración in-chip se estandariza, el impacto excederá a un proveedor o a un hyperscaler. Abrir el techo térmico deja espacio para más núcleos, más memoria, más ancho de banda y chips apilados, con centros de datos más pequeños pero más potentes. También podría elevar la reutilización de calor residual de mayor calidad (temperaturas más altas y controladas), útil para redes de calor o procesos industriales cercanos.

El reverso: complejidad y coste de fabricación, mantenimiento y reparación. Llevar líquido dentro del dado encarece el riesgo de cada fallo; habrá que equilibrar beneficio térmico con economía de fabricación y operación. La historia de la industria sugiere un camino probable: primero en servicios premium y gran escala, después la bajada de costes y la difusión al resto del mercado.

Preguntas frecuentes

¿En qué se diferencia la microfluídica de las placas frías?

Las placas frías extraen calor desde encima del encapsulado; la microfluídica in-chip graba canales en el silicio y hace circular refrigerante dentro del chip. Eso acorta la distancia térmica y mejora la extracción de calor, permitiendo trabajar con refrigerante menos frío y, potencialmente, mejorar el PUE del centro de datos.

¿Qué mejoras reales ha medido Microsoft?

En pruebas de laboratorio, hasta tres veces mejor extracción de calor frente a placas frías y reducciones del 65 % en el incremento máximo de temperatura interna de una GPU (según carga y diseño). La traslación a producción dependerá de tipo de chip, fluido, paquete y proceso.

¿Puede habilitar chips 3D apilados?

Sí, al llevar el refrigerante muy cerca de los puntos de consumo, la microfluídica abre una vía para enfriar entre capas en arquitecturas 3D, con “pilares” (pines cilíndricos) alrededor de los cuales fluye el líquido.

¿Cuándo podría verse en producción?

La tecnología está en fase de prototipo avanzado y pruebas de fiabilidad. Los próximos pasos pasan por industrializar el proceso con fundiciones y socios, e integrarlo en futuras generaciones de chips y centros de datos. El calendario dependerá del encaje de fabricación y de la madurez del ecosistema.

vía: news.microsoft