En un panorama dominado por nombres como OpenAI, Google DeepMind y Anthropic, una nueva propuesta china irrumpe con fuerza en el competitivo campo de la inteligencia artificial generativa. Se trata de MAGI-1, un modelo autoregresivo de generación de vídeo a gran escala desarrollado por Sand AI, que promete elevar el listón de lo que los modelos de difusión pueden hacer en tareas de síntesis visual.

Con 24.000 millones de parámetros, una arquitectura basada en Transformers optimizada y un enfoque completamente open source, MAGI-1 no solo iguala, sino que supera en varios aspectos a modelos comerciales como Sora o Kling, según evaluaciones técnicas recientes y los propios benchmarks de la compañía.

Un enfoque técnico distinto: generación por fragmentos y arquitectura autoregresiva

A diferencia de otros generadores de vídeo por IA que procesan el vídeo como una secuencia completa, MAGI-1 apuesta por una estrategia chunk-by-chunk: divide el vídeo en segmentos de 24 fotogramas, que procesa de manera secuencial y autoregresiva, manteniendo una consistencia temporal de izquierda a derecha entre fragmentos.

Este diseño permite:

- Escalabilidad natural para streaming y síntesis en tiempo real.

- Mayor coherencia visual entre escenas.

- Procesamiento paralelo de múltiples bloques durante la inferencia.

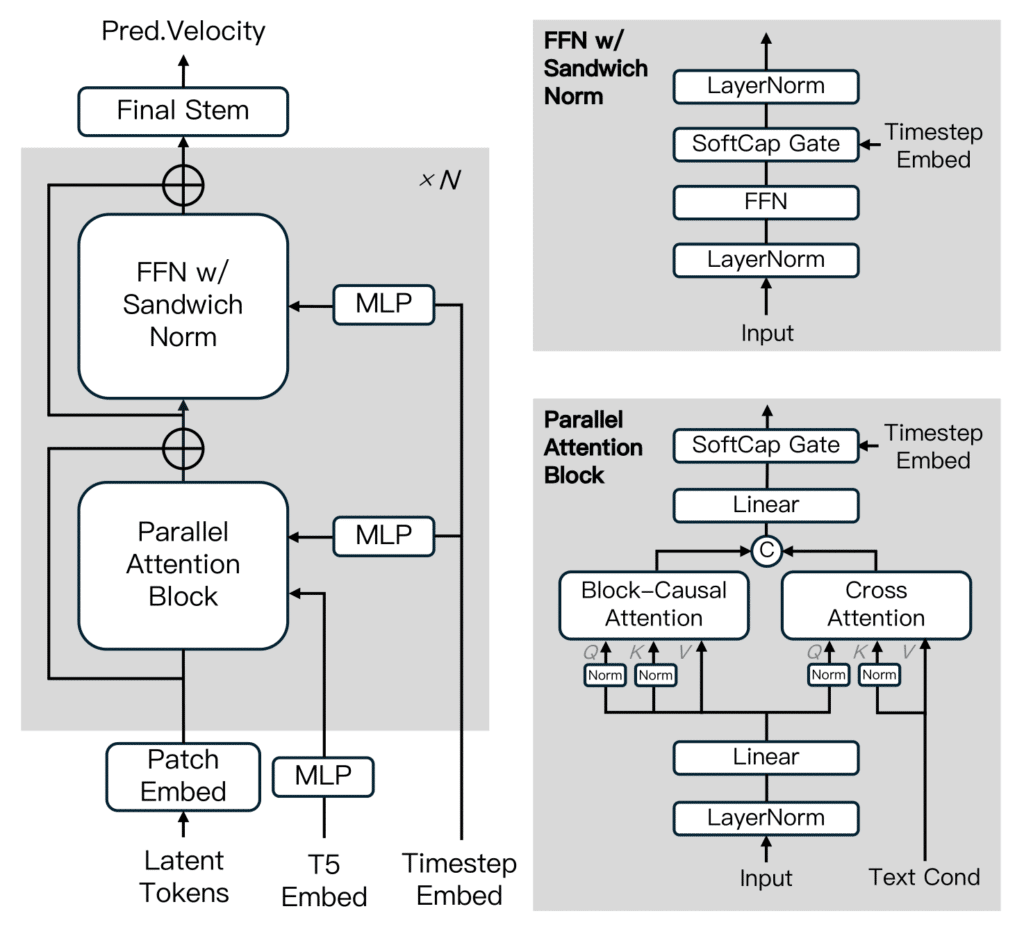

La arquitectura está basada en un modelo de difusión tipo Transformer, con mejoras como Block-Causal Attention, QK-Norm, Sandwich Normalization y Softcap Modulation. Además, utiliza un enfoque de ruido progresivo en el tiempo durante el entrenamiento, lo que permite al modelo aprender la causalidad entre cuadros.

Rendimiento sobresaliente frente a modelos abiertos y comerciales

MAGI-1 ha sido evaluado tanto en benchmarks humanos como en pruebas automáticas. En términos de fidelidad de movimiento, adherencia a instrucciones, y continuidad semántica, supera claramente a modelos abiertos como Wan-2.1 y HunyuanVideo, y compite de tú a tú con soluciones cerradas como Sora, Kling, Hailuo e incluso VideoPoet de Google.

En el benchmark Physics-IQ, que mide la capacidad de los modelos para entender y predecir el comportamiento físico en entornos dinámicos, MAGI-1 logra puntuaciones líderes gracias a su naturaleza autoregresiva, superando a todos los modelos actuales tanto en precisión espacial como temporal.

Resultados destacados (I2V):

| Modelo | Physics IQ ↑ | Coherencia Espacial ↑ | Coherencia Espacio-Temporal ↑ | MSE ↓ |

|---|---|---|---|---|

| MAGI-1 (I2V) | 30.23 | 0.203 | 0.151 | 0.012 |

| Kling 1.6 | 23.64 | 0.197 | 0.086 | 0.025 |

| VideoPoet | 20.30 | 0.141 | 0.126 | 0.012 |

| Sora | 10.00 | 0.138 | 0.047 | 0.030 |

Control narrativo y generación condicional: un punto fuerte

Uno de los mayores avances de MAGI-1 es su sistema de prompts por fragmento, que permite controlar la narrativa de cada bloque del vídeo de forma independiente, sin perder coherencia global.

Esto hace posible:

- Definir eventos distintos en diferentes partes del vídeo.

- Aplicar transiciones suaves entre escenas.

- Realizar ediciones en tiempo real a partir de texto o imágenes.

Además, el sistema es compatible con tareas t2v (texto a vídeo), i2v (imagen a vídeo) y v2v (continuación de vídeo), ampliando sus capacidades para múltiples flujos creativos y comerciales.

Entrenamiento, distilación y rendimiento

Sand AI ha liberado tanto la versión completa de MAGI-1 (24B) como una más ligera (4.5B) e incluso versiones distiladas y cuantizadas optimizadas para uso en tarjetas RTX 4090 o GPUs H100/H800.

Durante el entrenamiento, se empleó un algoritmo de distilación progresiva con distintas tasas de muestreo y un sistema de guía sin clasificador, lo que garantiza una alineación fiel con las instrucciones del prompt y una inferencia rápida sin pérdida de calidad.

Código abierto y democratización del video por IA

A diferencia de otros líderes del sector, Sand AI ha optado por una filosofía de apertura total: el modelo, el código de inferencia, las configuraciones y la documentación están disponibles en GitHub bajo licencia Apache 2.0, con soporte para Docker y Conda.

Esta estrategia reduce las barreras de entrada para investigadores, creadores y startups que quieran experimentar con generación de vídeo realista sin depender de APIs comerciales cerradas.

¿El nuevo estándar en vídeo por IA?

Si DeepSeek marcó el ritmo en modelos de lenguaje open source, MAGI-1 parece dispuesto a hacer lo mismo en el terreno audiovisual. El respaldo de figuras como Kai-Fu Lee (director de Microsoft Research Asia) y el interés creciente en el repositorio de GitHub apuntan a que no se trata solo de un experimento más, sino de una apuesta sólida por competir a escala global.

👀 You won’t believe this is AI-generated

— Farhan (@mhdfaran) April 21, 2025

🧠 You won’t believe it’s open-source

🎬 You won’t believe it’s FREE

Magi-1 video model just humiliated commercial video tools

Details and examples below: 👇 pic.twitter.com/zlXRecWeqH

MAGI-1 es más que un modelo de IA generativa: es una infraestructura visual potente, flexible y libre, que llega en un momento donde la generación de vídeo se perfila como el próximo gran campo de batalla en inteligencia artificial. Frente a propuestas cerradas como Sora o Gemini, la transparencia y calidad técnica de MAGI-1 podrían convertirlo en el nuevo referente de la generación visual open source.

Fuente: Noticias inteligencia artificial