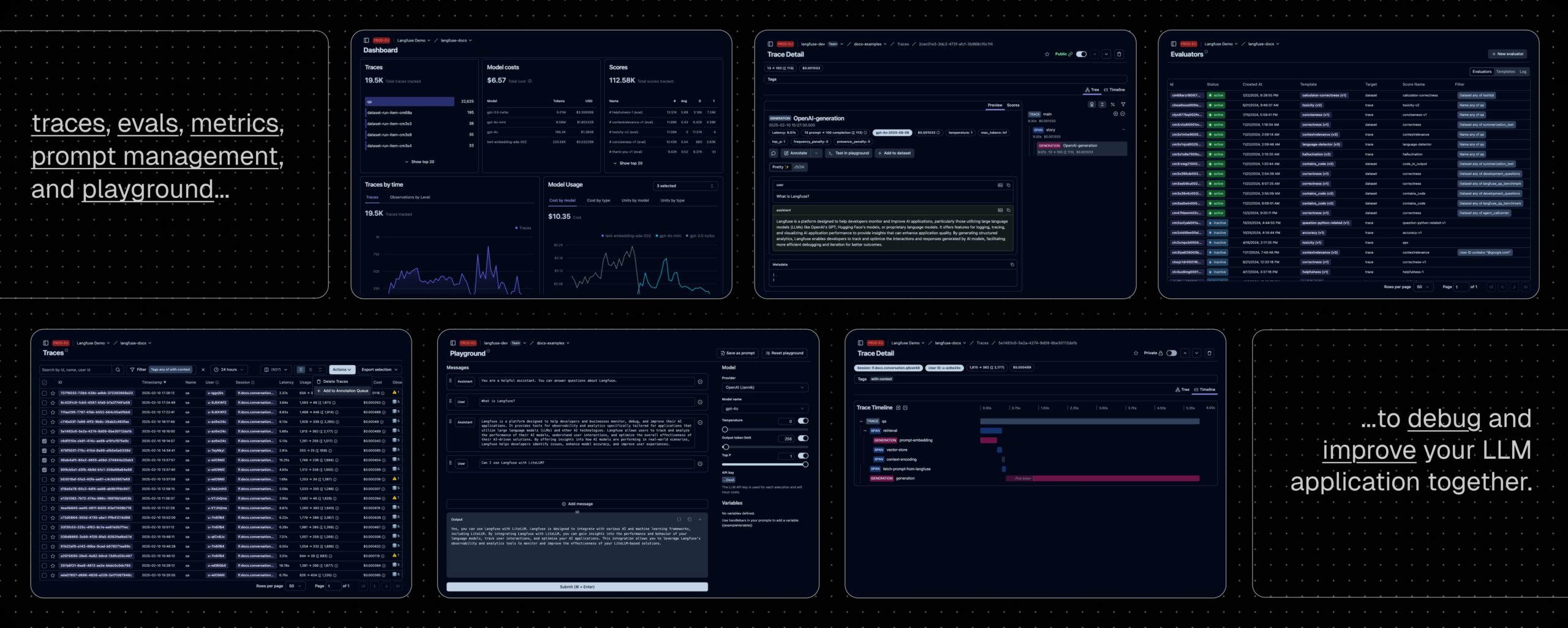

Langfuse emerge como una plataforma open source indispensable para el desarrollo, la observabilidad y la evaluación de aplicaciones con modelos de lenguaje. Su enfoque cloud-native y su capacidad para integrarse en flujos CI/CD la convierten en una herramienta estratégica para cualquier equipo que trabaje con IA generativa a escala.

En plena expansión del uso de modelos de lenguaje (LLM) en sectores como el comercio, la atención al cliente, la medicina o las finanzas, contar con una infraestructura de observabilidad adaptada a estos sistemas se vuelve imprescindible. Langfuse, una plataforma open source nacida en el ecosistema de Y Combinator (W23), se posiciona como uno de los principales habilitadores para empresas que buscan entender, optimizar y escalar sus aplicaciones con IA generativa.

Con una arquitectura pensada para desplegarse tanto en entornos cloud públicos como privados —mediante Kubernetes, Terraform o Docker Compose—, Langfuse ofrece visibilidad completa sobre las interacciones con modelos LLM, así como herramientas de colaboración, pruebas automatizadas y trazabilidad detallada.

Observabilidad profunda para aplicaciones impulsadas por IA

Langfuse responde a una necesidad creciente en el ámbito cloud y de IA: la falta de observabilidad estructurada en aplicaciones construidas sobre modelos de lenguaje. A diferencia de los logs tradicionales, los LLM requieren capturar contextos complejos, acciones encadenadas (como retrieval, embeddings o decisiones de agentes) y métricas de calidad de generación.

Con Langfuse, los equipos pueden:

- Registrar y visualizar trazas detalladas de cada llamada al modelo.

- Inspeccionar el flujo completo de operaciones y decisiones en tiempo real.

- Iterar y corregir errores desde un entorno interactivo (LLM Playground).

- Versionar y testear prompts de forma colaborativa y controlada.

- Ejecutar evaluaciones automáticas (LLM-as-a-judge), con feedback humano o pipelines personalizados.

Integración total en entornos DevOps y LLMOps

El enfoque cloud-native de Langfuse permite su integración en cualquier pipeline moderno de despliegue o monitorización. Sus SDK para Python y JavaScript/TypeScript, combinados con una API pública documentada con OpenAPI y colecciones Postman, facilitan su uso tanto en pruebas locales como en entornos CI/CD complejos.

Langfuse se integra directamente con:

- LangChain, LlamaIndex, Haystack, DSPy, LiteLLM, OpenAI, entre otros frameworks LLM.

- Herramientas de visualización como Flowise, Langflow o OpenWebUI.

- Modelos de ejecución local (como Ollama) o remota (Amazon Bedrock, HuggingFace).

- Plataformas multiagente como CrewAI, Goose o AutoGen.

En contextos empresariales, esta capacidad de integración se traduce en trazabilidad total del comportamiento de los modelos desplegados y en una mayor capacidad para realizar pruebas de regresión, evaluaciones comparativas y auditorías de rendimiento, todo con control sobre la infraestructura.

Despliegue flexible, privacidad garantizada

Langfuse puede desplegarse en minutos en local, en una VM o en Kubernetes. La versión Langfuse Cloud, ofrecida como SaaS, incluye una generosa capa gratuita sin necesidad de tarjeta de crédito. Sin embargo, para organizaciones que gestionan datos sensibles o trabajan bajo marcos regulatorios estrictos, la opción de autoalojamiento (self-hosted) sigue siendo el camino preferido.

En cuanto a privacidad, Langfuse no comparte datos con terceros y su sistema de telemetría puede desactivarse por completo (TELEMETRY_ENABLED=false), lo que garantiza el cumplimiento normativo en sectores como banca, sanidad o defensa.

Casos de uso reales y adopción en crecimiento

Proyectos líderes del ecosistema LLM como Dify, LobeChat, Langflow, MindsDB o Flowise utilizan Langfuse como base de trazabilidad. Esto demuestra su madurez tecnológica y la solidez de su comunidad. Empresas que desarrollan chatbots, asistentes inteligentes, herramientas de análisis semántico o automatización documental ya están adoptando Langfuse para ganar control y escalar sus operaciones.

Además, Langfuse facilita el cumplimiento de buenas prácticas en IA responsable, al permitir monitorizar el comportamiento de los modelos, recolectar feedback de los usuarios y prevenir resultados inesperados o sesgados.

Una capa de infraestructura clave para la IA generativa empresarial

A medida que los LLMs se convierten en parte del core business de muchas empresas, Langfuse se consolida como una solución crítica en el stack de observabilidad. Su propuesta no solo acelera el desarrollo, sino que aporta transparencia, fiabilidad y eficiencia en entornos cloud.

Para organizaciones que operan en múltiples regiones, Langfuse ofrece soporte para despliegues en la UE o en EE. UU., cumpliendo requisitos de soberanía de datos. Y para arquitecturas híbridas o edge, su diseño modular permite adaptarse sin fricciones.

Conclusión

Langfuse representa la evolución natural de los sistemas de trazabilidad en la era de la inteligencia artificial generativa. Su enfoque modular, su capacidad de autoalojamiento y su compatibilidad con el ecosistema LLM la convierten en una plataforma indispensable para los equipos de ingeniería y operaciones que trabajan con IA en la nube.

En un futuro dominado por la IA conversacional, la trazabilidad no es una opción, es una necesidad. Y Langfuse está liderando el camino.

🔗 Más información: https://langfuse.com

🛠️ Repositorio GitHub: https://github.com/langfuse/langfuse