El debate se ha instalado con fuerza en el sector: a medida que la inteligencia artificial pasa del gran entrenamiento de modelos fundacionales a una fase de inferencia masiva, ¿tiene sentido seguir llenando los centros de datos de GPU o ha llegado la hora de los ASIC y los TPU diseñados a medida?

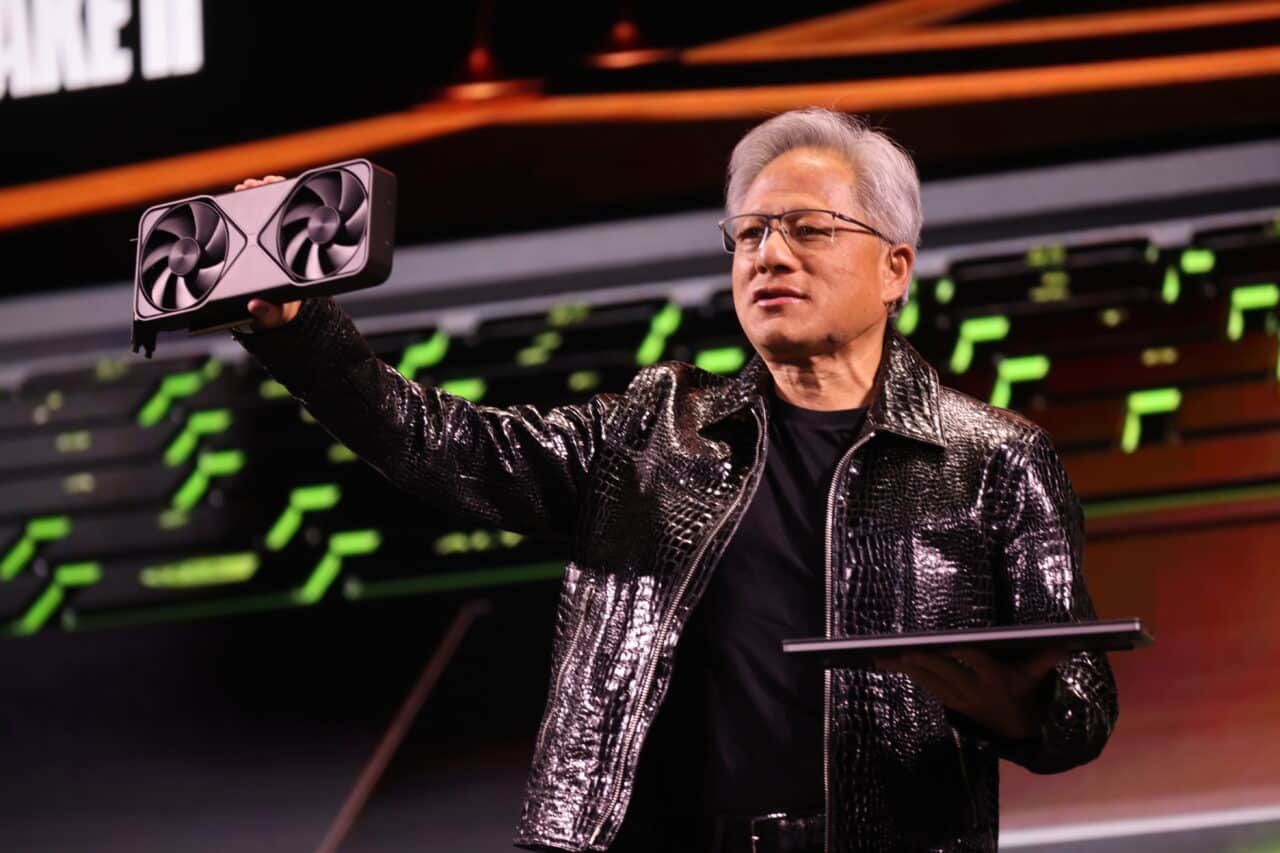

Para Jensen Huang, consejero delegado de NVIDIA, la respuesta sigue siendo clara. En una reciente intervención con analistas, volvió a defender que la verdadera batalla de la IA no es entre empresas, sino entre equipos de ingeniería, y que muy pocos en el mundo pueden competir con el ritmo de innovación de su compañía. En ese contexto, restó importancia a la pujanza de los ASICs (circuitos específicos) y de los TPU de gigantes como Google, que muchos ven como alternativa a las GPU de propósito general.

GPU frente a ASIC/TPU: dos formas muy distintas de hacer cómputo para IA

Antes de entrar en el discurso de Huang, conviene aclarar qué está en juego. En los grandes centros de datos de IA conviven, o aspiran a convivir, dos familias de chips:

- GPU (Graphics Processing Unit):

- Nacieron como procesadores gráficos, pero se convirtieron en el estándar de facto para el deep learning.

- Son chips de propósito general altamente paralelos, programables y flexibles.

- En el caso de NVIDIA, vienen acompañados del ecosistema CUDA, librerías, compiladores y herramientas optimizadas para IA.

- ASICs / TPU (Application-Specific Integrated Circuit / Tensor Processing Unit):

- Chips diseñados a medida para tareas muy concretas, como multiplicaciones y acumulaciones de tensores para redes neuronales.

- Buscan máxima eficiencia energética y coste por operación para determinados modelos y cargas, sobre todo en inferencia a gran escala.

- Ejemplo emblemático: los TPU de Google, que la compañía utiliza en sus propios servicios y ofrece a clientes en su nube.

Comparativa simplificada: GPU vs ASIC/TPU para IA

| Característica | GPU (ej. NVIDIA) | ASIC / TPU (ej. Google TPU) |

|---|---|---|

| Tipo de chip | Propósito general, altamente paralelo | Específico para ciertas operaciones de IA |

| Flexibilidad | Muy alta (entrenamiento, inferencia, otros) | Media/Baja (optimizado para casos concretos) |

| Ecosistema de software | Muy maduro (CUDA, cuDNN, TensorRT, etc.) | Limitado a quien controle la plataforma |

| Facilidad de adopción | Alta: gran comunidad y soporte multi-cloud | Más compleja: requiere adaptar herramientas y modelos |

| Eficiencia en inferencia masiva | Muy buena, mejorando generación tras generación | Excelente en escenarios bien adaptados |

| Riesgo de “lock-in” | Menor, disponible en muchos proveedores | Mayor, ligado a la nube o proveedor propietario |

| Ritmo de innovación | Continuo, con familias anuales de GPU | Depende de cada Big Tech y su hoja de ruta interna |

Lo que realmente dice Jensen Huang

En el último trimestre, NVIDIA ha reforzado su posición con resultados récord en su negocio de centros de datos y acuerdos con actores clave del ecosistema de IA. Cuando un analista preguntó a Jensen Huang por el impacto de los programas de chips dedicados —TPU y otros ASIC— de compañías como Google o Amazon, el ejecutivo respondió con una idea central:

No se compite contra empresas, se compite contra equipos. Y no hay tantos equipos en el mundo capaces de construir cosas tan increíblemente complejas.

Ese matiz es importante. Huang no niega la existencia ni la utilidad de ASICs como los TPU; lo que cuestiona es que haya suficientes equipos capaces de sostener, versión tras versión, todo lo que NVIDIA ya ofrece:

- Hardware optimizado para IA en múltiples segmentos (entrenamiento, inferencia, computación científica).

- Un ecosistema de software unificado: CUDA y un conjunto de librerías, frameworks y herramientas que se han convertido en estándar de facto.

- Soporte masivo por parte de la comunidad de desarrolladores, start-ups, universidades y proveedores cloud.

En el fondo, su mensaje es que igualar una ficha técnica no basta; hay que ser capaz de replicar una plataforma integral.

El ejemplo de Anthropic: GPU y TPU conviven

El caso de Anthropic ilustra bien esta convivencia. La compañía ha firmado acuerdos tanto con NVIDIA, que le proporciona sistemas basados en arquitecturas como Blackwell o Rubin, como con Google, que ofrece sus TPU de última generación (Ironwood) para determinadas cargas.

A ojos de algunos analistas, esa combinación podría interpretarse como un signo de que las GPU son prescindibles. Huang, sin embargo, lo presenta justo al revés:

- Las grandes empresas de IA diversifican hardware para optimizar costes y rendimiento según el tipo de tarea.

- Pero para muchas cargas críticas, especialmente entrenamiento a gran escala y pipelines complejos, siguen recurriendo al ecosistema de NVIDIA.

Es decir, que la aparición de ASICs no desplaza a las GPU, sino que forma parte de un paisaje más heterogéneo donde cada tipo de chip ocupa su nicho.

Ventajas de las GPU: flexibilidad y ecosistema

¿Por qué los centros de datos siguen comprando GPU a un ritmo tan alto, incluso cuando hay ASICs más eficientes para ciertas tareas?

- Flexibilidad extrema

Una GPU moderna no solo sirve para inferencia de modelos ya entrenados, sino también para:- Entrenar nuevos modelos fundacionales.

- Ajuste fino (fine-tuning) para casos de uso específicos.

- Simulaciones, HPC, gráficos avanzados y más.

- Ecosistema CUDA consolidado

La mayor parte de los frameworks de deep learning (PyTorch, TensorFlow, JAX, etc.) ofrecen soporte maduro y optimizado para GPU de NVIDIA.

Migrar todo eso a un ASIC específico es posible, pero muy costoso en tiempo, talento y mantenimiento. - Portabilidad entre proveedores

Las GPU de NVIDIA están disponibles a través de múltiples nubes y proveedores de infraestructura. Eso permite a empresas y laboratorios evitar un bloqueo total en una sola plataforma propietaria. - Ritmo de innovación sostenido

Cada nueva generación de GPU trae mejoras en rendimiento por vatio, memoria, ancho de banda y soporte de nuevas instrucciones para IA. Replicar ese ritmo en un ASIC interno no es trivial.

Dónde brillan los ASICs y los TPU: eficiencia y escala controlada

Dicho esto, los ASICs y TPU no son humo de marketing. Tienen ventajas muy claras cuando se dan ciertas condiciones:

- Volumen enorme de inferencia repetitiva

Para servicios globales que ejecutan miles de millones de consultas diarias con modelos relativamente estables, un ASIC bien diseñado puede ofrecer un coste por inferencia muy inferior a una GPU. - Control total del stack

Cuando una compañía controla la capa de hardware, middleware y software, como hace Google con sus TPU, puede exprimir al máximo la plataforma y adaptarla a sus productos internos (búsquedas, publicidad, vídeo, etc.). - Optimización energética extrema

En centros de datos donde el límite ya no es solo el dinero, sino la energía disponible y la capacidad de refrigeración, un ASIC hiperoptimizado puede marcar la diferencia.

En resumen: los TPU y otros ASIC tienen mucho sentido para hiperescalares que pueden permitirse invertir miles de millones en silicio propio y tienen cargas de trabajo muy predecibles. Para la mayoría de empresas, en cambio, las GPU siguen siendo la opción más práctica.

¿Amenaza real o ruido competitivo?

Las declaraciones de Jensen Huang deben leerse en varias capas:

- A corto plazo, la demanda de GPU para IA continúa siendo extraordinariamente fuerte, y los acuerdos con actores como Anthropic refuerzan esa posición.

- A medio plazo, los ASICs y TPU de Google, Amazon u otras Big Tech no desaparecen, pero tienden a usarse como piezas especializadas dentro de arquitecturas híbridas donde las GPU siguen teniendo un peso central.

- A largo plazo, la gran incógnita no es solo el chip, sino quién será capaz de mantener el mejor equipo de ingeniería y el ecosistema de software más atractivo.

Y es precisamente ahí donde Huang insiste: incluso si existen buenos ASICs, muy pocos equipos en el mundo pueden sostener la cadencia de innovación que NVIDIA ha establecido en hardware, software y soporte para toda la industria.

Por ahora, la carrera entre GPU y ASICs no parece un juego de suma cero. Más bien se perfila como un escenario híbrido en el que cada tecnología ocupa su espacio… pero con NVIDIA decidida a seguir siendo el eje alrededor del cual gire el grueso de la IA moderna.