IBM y AMD han anunciado una colaboración para suministrar a Zyphra —startup de San Francisco centrada en “superinteligencia” open-source— una infraestructura avanzada de entrenamiento de modelos de IA en IBM Cloud basada en GPU AMD Instinct™ MI300X. El acuerdo, multianual, coloca a IBM como proveedor de un gran clúster dedicado con aceleradores de AMD para entrenar modelos fundacionales multimodales (lenguaje, visión y audio). Es, según las empresas, el primer despliegue a gran escala en IBM Cloud que integra la pila completa de AMD para entrenamiento —desde cómputo hasta red— y, de hecho, se apoya también en AMD Pensando™ Pollara 400 AI NICs y AMD Pensando Ortano DPUs. El primer tramo se puso en marcha a inicios de septiembre y se prevé una expansión en 2026.

La noticia llega tras el cierre de la Serie A de Zyphra con valoración de 1.000 millones de dólares, con la que aspira a construir un laboratorio líder en ciencia abierta y código abierto para impulsar nuevas arquitecturas neuronales, memoria a largo plazo y aprendizaje continuo. El producto estrella en el horizonte es Maia, un “superagente” de propósito general orientado a productividad para trabajadores del conocimiento en la empresa.

“Es la primera vez que la plataforma de entrenamiento de AMD —desde el cómputo hasta la red— se integra y escala en IBM Cloud, y en Zyphra nos honra liderar el desarrollo de modelos de frontera con silicio de AMD en IBM Cloud”, afirma Krithik Puthalath, CEO y presidente de Zyphra.

Qué hay en el paquete: GPU, red inteligente y nube empresarial

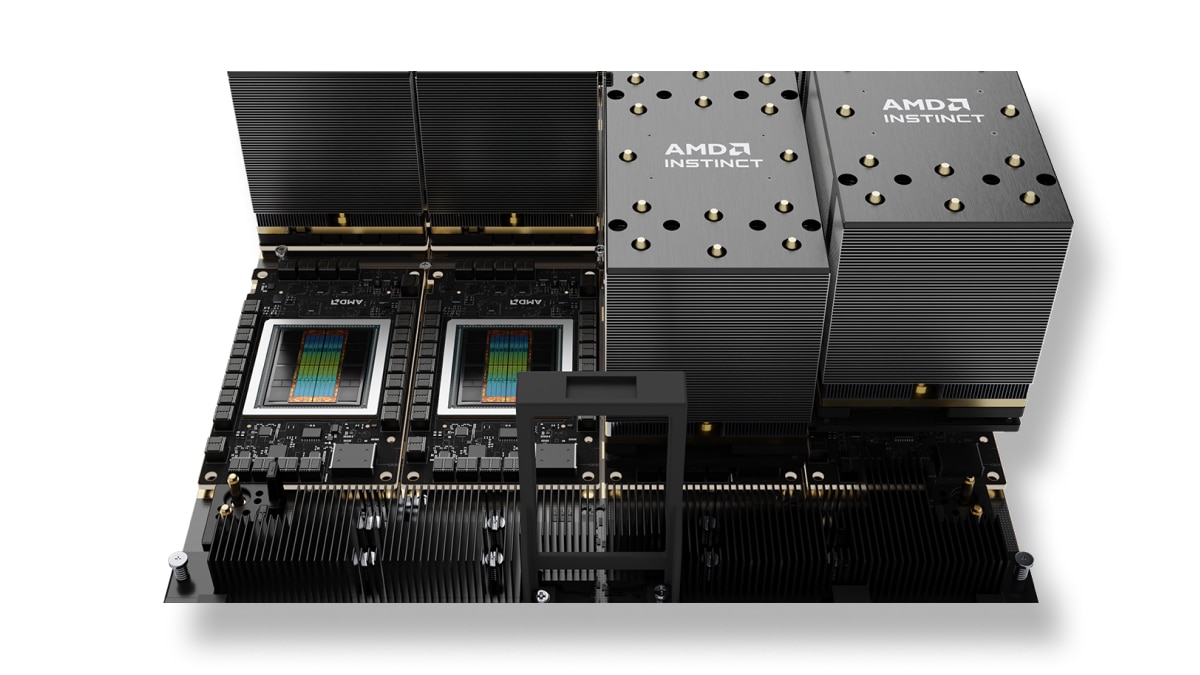

El clúster dedicado para Zyphra combina varias piezas de la pila AMD:

- GPU AMD Instinct MI300X para entrenamiento generativo y cargas de HPC afines.

- AMD Pensando Pollara 400 AI NICs (tarjetas de red inteligentes orientadas a IA) para alimentar el flujo de datos a escala con baja latencia y alto rendimiento.

- AMD Pensando Ortano DPUs (unidades de procesamiento de datos) para descargar tareas de red y seguridad, y orquestar servicios de infra sin “robar” ciclos al cómputo principal.

Sobre esta base, IBM Cloud aporta su capa de nube empresarial —seguridad, fiabilidad, escalabilidad y multicloud híbrido—, en la que ya venía ofreciendo MI300X as-a-service desde 2024. La combinación apunta a un patrón de uso muy concreto: granjas de entrenamiento dedicadas, “aisladas” para clientes con necesidades extremas de cómputo, pero con la elasticidad y gobernanza de un hiperescalador.

“Escalar cargas de IA más rápido y con mejor eficiencia marca la diferencia en el ROI, tanto para grandes empresas como para compañías emergentes”, subraya Alan Peacock, GM de IBM Cloud. Para AMD, la colaboración demuestra “innovación a la velocidad y escala que los clientes exigen” —en palabras de Philip Guido, EVP y Chief Commercial Officer—, y aspira a fijar un “nuevo estándar” de infraestructura de IA combinando la experiencia de IBM en nube empresarial con el liderazgo de AMD en HPC y aceleración de IA.

Para qué lo usará Zyphra: modelos multimodales y Maia, el “superagente”

Zyphra desarrollará en esta plataforma modelos fundacionales multimodales que integran lenguaje, visión y audio. El destino inmediato es dotar de cerebro a Maia, un superagente de propósito general que promete acelerar procesos intensivos en conocimiento (búsqueda, análisis, redacción, coordinación) dentro del entorno empresarial. La IDEA: que el agente entienda documentos, resuma llamadas, cruce fuentes internas y externas, y tome pasos intermedios (o sugiera next-best action) en sistemas corporativos sin obligar al humano a saltar entre aplicaciones.

El que Zyphra etiquete su enfoque como open-source/open-science no es un matiz: en un mercado dominado por modelos cerrados, la apuesta por transparencia y colaboración científica añade atractivo para empresas que quieren auditar lo que usan o adaptarlo a on-prem.

Por qué este anuncio importa (más allá de Zyphra)

- “Full-stack” AMD probado en hiperescalador. Es el primer macrocluster dedicado en IBM Cloud que integra GPU + NICs + DPUs de AMD para entrenamiento. Es un caso de referencia para otras compañías que quieran desplegar su IA en la nube sin renunciar a un aislamiento de alto rendimiento.

- Señal a la cadena de suministro. Los grandes proyectos de IA dependen tanto de la HBM y el packaging avanzado como del silicio. Que IBM y AMD coordinen planes con un cliente intensivo anticipa prioridades de capacidad y servicio para 2026.

- Competencia real frente a NVIDIA. Aun con CUDA y un ecosistema software sin rival, NVIDIA no es la única vía. La pila AMD (ROCm, librerías, kernels optimizados) gana tracción cuando se suma la co-ingeniería con clientes extremos de cómputo.

- Nube como vector de “time-to-model”. Los hiperescaladores con ofertas “GPU as-a-service” y contratos dedicados tendrán ventaja captando entrenamientos de frontera: reducción de tiempos de espera y acceso a redes y servicios listos para producción.

Hacia el “quantum-centric supercomputing”: la otra vía IBM–AMD

Al margen de este anuncio, IBM y AMD han señalado planes para explorar arquitecturas de próxima generación en la línea del “quantum-centric supercomputing”: combinar cuántica (donde IBM lidera en máquinas y software) con HPC y aceleración de IA (donde sobresale AMD). Aunque el calendario no se detalla, la dirección que marcan es clara: orquestar recursos heterogéneos (clásicos, acelerados y cuánticos) según el tipo de problema, el coste y la ventana de cómputo.

Qué vigilar (y dónde están los riesgos)

- Software: la paridad funcional y el rendimiento de ROCm frente a CUDA en cargas reales (atención eficiente, MoE, training denso, serving de baja latencia) serán determinantes para el TCO del rack.

- HBM y OSAT: la memoria de alto ancho de banda y el empaquetado siguen tensionados; cualquier escalado dependerá de la cola de pedidos global.

- Energía y térmica: clústeres de esta escala exigen MW firmes y refrigeración líquida (D2C, inmersión). La ubicación y el coste del kWh influyen tanto como el chip.

- Networking: aunque las NICs AI y DPUs descargan parte del trabajo, la topología y los backplanes a terabits/s siguen siendo el hueso de las épocas largas.

- Calendario: la expansión en 2026 de Zyphra lucirá si hay entradas graduales de capacidad sin cuellos de botella intermedios.

Lectura rápida para CTOs y equipos de infra

- Caso de uso: frontier training multimodal (texto+imagen+audio) con clúster dedicado en IBM Cloud.

- Tecnología: MI300X + Pensando NICs/DPUs (red y tareas de datos más “cerca” del rack), seguridad y multicloud híbrido de IBM.

- Objetivo: productividad de modelos y eficiencia a escala (menos latencia, más throughput, mejor PUE/TUE potencial).

- Producto: alimentar Maia, el superagente de Zyphra orientado a colaboración y automatización en entornos corporativos.

Conclusión

La colaboración IBM–AMD–Zyphra añade una pieza relevante al mapa de la IA a escala: un macrocluster dedicado en IBM Cloud con pila AMD completa (GPU + NIC + DPU), orientado a modelos multimodales de frontera y con expansión prevista en 2026. Para Zyphra, es el combustible que necesita para su apuesta open-source/open-science y para llevar Maia del laboratorio al mundo real; para IBM, un caso de referencia que consolida su oferta GPU as-a-service; y para AMD, una demostración de que su full-stack de entrenamiento escala en un hiperescalador con “SLA de empresa”. En un mercado donde las ventanas de entrenamiento se estrechan y los watios útiles mandan, este tipo de alianzas operables son la moneda más valiosa.

Preguntas frecuentes

¿Qué hace “distinto” este clúster frente a otros despliegues de IA en la nube?

Es el primer macrocluster dedicado en IBM Cloud que integra la pila completa de AMD para entrenamiento (GPU MI300X, Pensando Pollara 400 AI NICs y Pensando Ortano DPUs), uniendo cómputo y red inteligente con la capa empresarial de IBM Cloud.

¿En qué trabajará Zyphra sobre esta infraestructura?

En modelos fundacionales multimodales (texto, visión, audio) que alimenten Maia, su superagente de propósito general para productividad en la empresa, así como en investigación de nuevas arquitecturas, memoria a largo plazo y aprendizaje continuo.

¿Por qué eligieron IBM y AMD?

Por hojas de ruta de producto “de vanguardia” y la capacidad de entregar aceleradores al ritmo que exige Zyphra. IBM aporta seguridad, fiabilidad y escalabilidad; AMD, HPC y aceleración con GPU, NICs AI y DPUs.

¿Qué calendario hay sobre la mesa?

El primer despliegue estuvo operativo a inicios de septiembre de 2025; la expansión del clúster está prevista para 2026. IBM y AMD señalan que pueden seguir escalando según crezcan las necesidades de entrenamiento de Zyphra.

vía: amd