La carrera por la memoria HBM4 —la “gasolina” que alimenta a las GPUs de inteligencia artificial— entra en una fase especialmente delicada: la de los últimos retoques antes de la validación final. En este pulso, el líder actual del mercado, SK Hynix, ha vuelto a mover ficha con una nueva tanda de muestras mejoradas para Nvidia, en un intento de cerrar cuanto antes el proceso de qualification dentro del primer trimestre. Al mismo tiempo, Samsung Electronics asoma como aspirante real a colarse en la cadena de suministro de Nvidia con su HBM4 de 12 capas, con señales de que podría estar cerca de empezar producción para clientes en cuestión de semanas.

Detrás de estos titulares hay una realidad menos vistosa, pero decisiva: en memorias apiladas como HBM, el salto generacional no se gana solo con “más rendimiento”. Se gana con rendimiento, fiabilidad y fabricabilidad a la vez. Y ese equilibrio es lo que explica por qué SK Hynix está revisando y “re-revisando” sus muestras finales, incluso después de haber entregado Customer Samples (CS) y de haber pasado por rediseños de circuito tras pruebas SiP (System-in-Package).

Qué significa “calificar” HBM4 con Nvidia (y por qué se repiten las revisiones)

La validación con un cliente como Nvidia no es un trámite: es un filtro implacable. Las memorias HBM se apilan, se interconectan y se integran en un paquete complejo donde cada ajuste —latencias, integridad de señal, estabilidad térmica, comportamiento bajo carga, márgenes de voltaje— puede impactar en el rendimiento… y, sobre todo, en el rendimiento a escala.

Por eso, una muestra “funciona” no significa que esté lista. Puede cumplir en laboratorio y, aun así, quedarse corta cuando se trata de fabricar de forma consistente, con yield aceptable, y sostener objetivos de velocidad y consumo dentro de las exigencias del cliente. En este contexto, la industria asume con normalidad que haya rondas sucesivas de optimización: se corrigen detalles detectados en test de paquete (SiP), se afinan márgenes para no castigar el yield y se ajusta el diseño para responder a peticiones específicas del cliente.

En el caso de SK Hynix, el relato es el de una fase final de pulido: la compañía mantiene a la vez la entrega de muestras revisadas (incluso como muestras de pago) y, paralelamente, suministra una nueva iteración todavía más afinada para la batería de pruebas de calificación, con resultados esperados dentro del primer trimestre.

Nvidia no puede esperar: “Rubin” necesita una rampa de suministro estable

El calendario lo marca la próxima plataforma de Nvidia. La compañía está preparando la transición a “Rubin” —su siguiente generación— y, según el propio contexto de mercado, el objetivo no es solo llegar antes: es llegar con volumen. Ahí es donde SK Hynix juega una carta clave: aunque Samsung pueda ir por delante en ritmo de calificación, SK Hynix aspira a sostener una porción mayor del suministro total durante el año gracias a contratos de volumen cerrados previamente.

En el trasfondo, la dependencia del sector de la IA respecto a la cadena de suministro de memoria avanzada es cada vez más visible. En un escenario donde la demanda de infraestructura para IA aprieta, los proveedores de HBM se convierten en actores estratégicos, y cualquier cuello de botella —por capacidad, validación o empaquetado— se traduce en retrasos y costes.

Samsung aprieta: 12 capas y ambición de entrar en el “club Nvidia”

Samsung, por su parte, ha intensificado su discurso público sobre HBM4 y su competitividad, mientras el mercado interpreta que podría estar cerca de iniciar producción para clientes si se consolidan los pasos pendientes.

Más allá del marketing, el movimiento tiene lógica: en HBM, estar dentro de la plataforma ganadora es medio partido. Y si Nvidia empuja “Rubin” hacia producción, el premio para el proveedor que se consolide como segunda fuente —o como alternativa con capacidad real— no es pequeño. La propia dinámica competitiva sugiere que, incluso cuando un proveedor lidera, el cliente busca reducir riesgo y ganar poder de negociación.

Volumen, poder de negociación y el factor precio

Otro punto sensible es el precio. En el mercado se da por hecho que HBM4 será más cara que su antecesora, no solo por la complejidad técnica, sino por el contexto de demanda y por la presión en empaquetado avanzado. Las estimaciones del sector sitúan el precio de una HBM4 de 12 capas por encima de los 600 dólares, y se habla de un escenario de paridad entre proveedores en las negociaciones, algo relevante si se compara con etapas anteriores donde había diferencias de precio más acusadas entre competidores.

Este detalle importa por un motivo simple: HBM es uno de los componentes que más condiciona el coste de una GPU de IA y, en consecuencia, el coste por token, por entrenamiento o por inferencia en los centros de datos. En otras palabras: no es solo una batalla tecnológica, es una batalla por el margen de toda la cadena.

El papel silencioso de TSMC y el dilema del “más rápido” vs “más fabricable”

El último tramo de optimización suele incluir decisiones incómodas. Si el cliente pide más velocidad, se puede forzar el diseño… pero eso puede tensar rendimientos de fabricación. Y ahí entra un elemento que se menciona cada vez más en conversaciones del sector: la coordinación con los actores de la cadena (incluyendo foundries y empaquetado) para mantener un “colchón” de seguridad y no convertir la mejora de rendimiento en un problema de suministro.

En el fondo, el éxito no será quién llegue primero con una muestra que pasa una demo, sino quién llegue con un producto que pasa la calificación, escala en volumen y mantiene estabilidad. Y por eso, en HBM4, las revisiones no son una señal de debilidad: son una señal de que el producto está entrando en el terreno donde se decide todo.

Lo que viene ahora

Si la calificación se resuelve dentro del primer trimestre, el mercado entrará en una segunda fase: la de ramp-up real, con contratos, capacidad comprometida y una cadena de suministro que tendrá que absorber la demanda de una generación que apunta a ser todavía más intensiva en memoria.

Mientras tanto, Nvidia necesita que la memoria acompañe a la ambición de “Rubin”. Y Samsung necesita demostrar que su HBM4 no solo es competitiva, sino que es suministrable. SK Hynix, por su parte, busca mantener el liderazgo no solo por méritos tecnológicos, sino por algo igual de decisivo: ser el proveedor que, cuando llegue la hora, pueda decir “sí, y además tengo volumen”.

Preguntas frecuentes

¿Qué es la memoria HBM4 y por qué es tan importante para GPUs de IA?

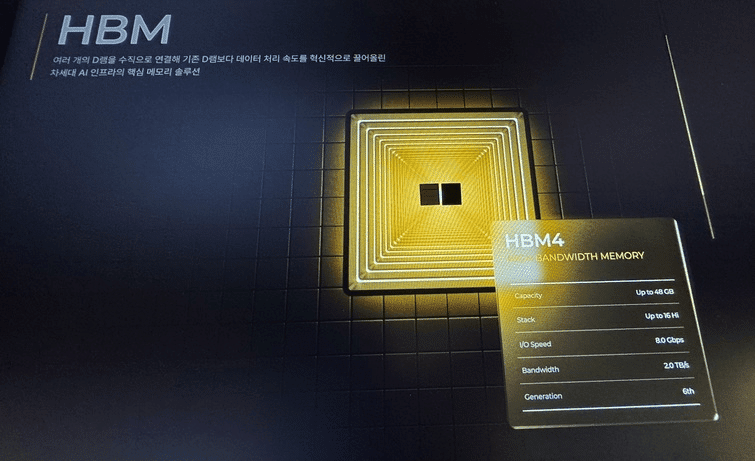

HBM4 es una generación de memoria de alto ancho de banda apilada en 3D, diseñada para ofrecer enorme velocidad y eficiencia energética. En IA, permite alimentar los aceleradores con datos a gran ritmo, evitando cuellos de botella que limitan el rendimiento real.

¿Qué significa que Nvidia “califique” (qualification) una HBM4?

Significa que la memoria supera una batería de pruebas técnicas y de fiabilidad dentro de un paquete y una plataforma concreta. No basta con funcionar: debe hacerlo con estabilidad, márgenes y consistencia suficientes para producción y despliegue a gran escala.

¿Por qué se revisan las muestras tantas veces antes de la producción masiva?

Porque el salto final consiste en equilibrar velocidad, consumo, estabilidad térmica y rendimiento de fabricación (yield). Subir rendimiento puede empeorar el yield, y el yield define si habrá volumen y precios sostenibles.

¿Cómo afecta el precio de HBM4 al coste de entrenar o servir modelos de IA?

HBM es un componente crítico y caro dentro del hardware de IA. Si sube su precio o se restringe su disponibilidad, aumenta el coste de los sistemas y, con ello, el coste por entrenamiento o por inferencia, impactando directamente en la economía del despliegue de modelos.

vía: dealsite.co.kr