La startup estadounidense Groq, fundada en 2016, ha desarrollado una innovadora unidad de procesamiento del lenguaje (LPU) que promete transformar el campo de la inteligencia artificial generativa. Esta tecnología avanzada genera contenido de manera casi instantánea, superando en velocidad a los tradicionales GPUs (unidades de procesamiento gráfico) de Nvidia.

Una Alternativa a los GPUs de Nvidia

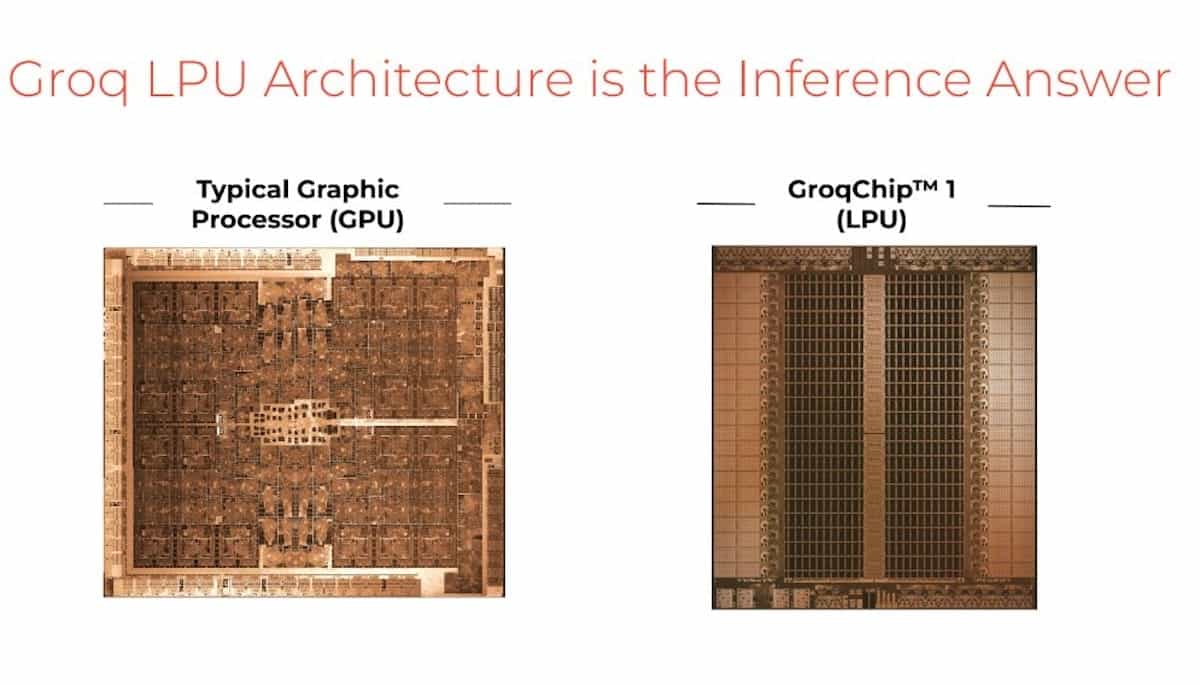

Groq ha estado en el centro de atención recientemente debido al auge de la inteligencia artificial generativa. La empresa ha creado las LPU (Language Processing Unit), procesadores diseñados específicamente para la inferencia de modelos de IA con miles de millones de parámetros. A diferencia de los GPUs, que son más adecuados para el entrenamiento de modelos de IA, las LPUs de Groq están optimizadas para la ejecución rápida y eficiente de estos modelos.

Jonathan Ross, fundador de Groq y ex ingeniero de Google, resalta que «en dispositivos móviles, la gente no tiene paciencia». Con las LPUs de Groq, se busca que la interacción con la IA sea casi instantánea, eliminando la sensación de estar conversando con una máquina.

Características Técnicas Impresionantes

Las GroqChips, como se denominan estas LPUs, son capaces de realizar un cuatrillón de operaciones por segundo, generando hasta 400 palabras por segundo, comparado con las 100 palabras por segundo que pueden manejar los GPUs de Nvidia. Esta velocidad superior podría posicionar a Groq como un líder en el mercado de la IA generativa.

A pesar de que las LPUs de Groq alcanzan un rendimiento de 188 Tflops, considerablemente menor que los 1,000 Tflops de los GPUs Nvidia H100, su arquitectura simplificada y eficiencia energética las hacen ideales para la inferencia de modelos de lenguaje. Las LPUs consumen significativamente menos energía, con una tarjeta PCIe de Groq consumiendo diez veces menos energía que una tarjeta similar de Nvidia.

Un Diseño Innovador para la Eficiencia

La arquitectura de las LPUs de Groq se asemeja a un ensamblaje de varios mini-DSPs (procesadores de señal digital), montados en serie. Esta estructura permite que cada circuito se especialice en una única función, maximizando la eficiencia energética y la velocidad de procesamiento. Este enfoque modular y especializado reduce drásticamente el consumo de energía en comparación con los GPUs, que fueron originalmente diseñados para el procesamiento gráfico.

Enfoque en la Inferencia y la Eficiencia

Groq enfatiza que sus chips no están destinados al entrenamiento de modelos de IA, sino a la ejecución de modelos ya entrenados. «Hemos desarrollado una puce que acelera por diez la ejecución de estos modelos. Esto significa que cuando haces una pregunta a una IA que funciona en un servidor equipado con nuestra puce, obtienes una respuesta en tiempo real», explica Ross.

El Futuro de la Inferencia con Groq

El Groq LPU™ Inference Engine es un sistema de aceleración de inferencia diseñado para ofrecer un rendimiento, eficiencia y precisión sustanciales en un diseño simple. Con la capacidad de ejecutar modelos como Llama-2 70B a más de 300 tokens por segundo por usuario, las LPUs de Groq prometen establecer un nuevo estándar en la experiencia de IA.

Conclusión

Groq está redefiniendo la manera en que interactuamos con la inteligencia artificial, ofreciendo una tecnología que no solo es más rápida, sino también más eficiente energéticamente. Con su enfoque en la inferencia y la ejecución eficiente de modelos de lenguaje, Groq se posiciona como un competidor formidable en el campo de la IA generativa.

Para más información sobre Groq y sus innovadoras LPUs, visita Groq.