Google ha oficializado Gemini 3, la tercera generación de su familia de modelos de inteligencia artificial, con un mensaje claro para el sector tecnológico: la carrera ya no va solo de escribir textos o generar imágenes, sino de razonar, usar herramientas y actuar como agente autónomo en entornos reales.

Para un público técnico, la compañía ha puesto sobre la mesa algo más que promesas. Ha publicado una tabla de benchmarks muy detallada y ha estrenado una nueva plataforma de desarrollo basada en agentes, Google Antigravity, que convierte a Gemini 3 en algo más cercano a un “operador de sistemas” o “ingeniero virtual” que a un simple asistente conversacional.

De Gemini 1 a Gemini 3: dos años de iteración acelerada

En menos de dos años, la línea Gemini ha pasado de ser la respuesta de Google a los primeros modelos generativos generalistas a una familia completa orientada a agentes y planificación a largo plazo.

- Gemini 1 introdujo la multimodalidad nativa y ventanas de contexto muy amplias.

- Gemini 2 y 2.5 Pro llevaron esa base a la arquitectura agéntica, con modelos capaces de encadenar acciones y liderar rankings comunitarios como LMArena durante meses.

- Gemini 3 se presenta como una síntesis de ambas etapas, reforzando el razonamiento, el uso robusto de herramientas y la capacidad de planificar flujos complejos.

El despliegue es inmediato: Gemini 3 Pro llega desde el primer día al Modo IA del Buscador, a la app Gemini, a la API para desarrolladores en AI Studio y Vertex AI, y se convierte en el motor central de la nueva plataforma Antigravity.

Benchmarks: dónde mejora Gemini 3 Pro y dónde se aprieta la carrera

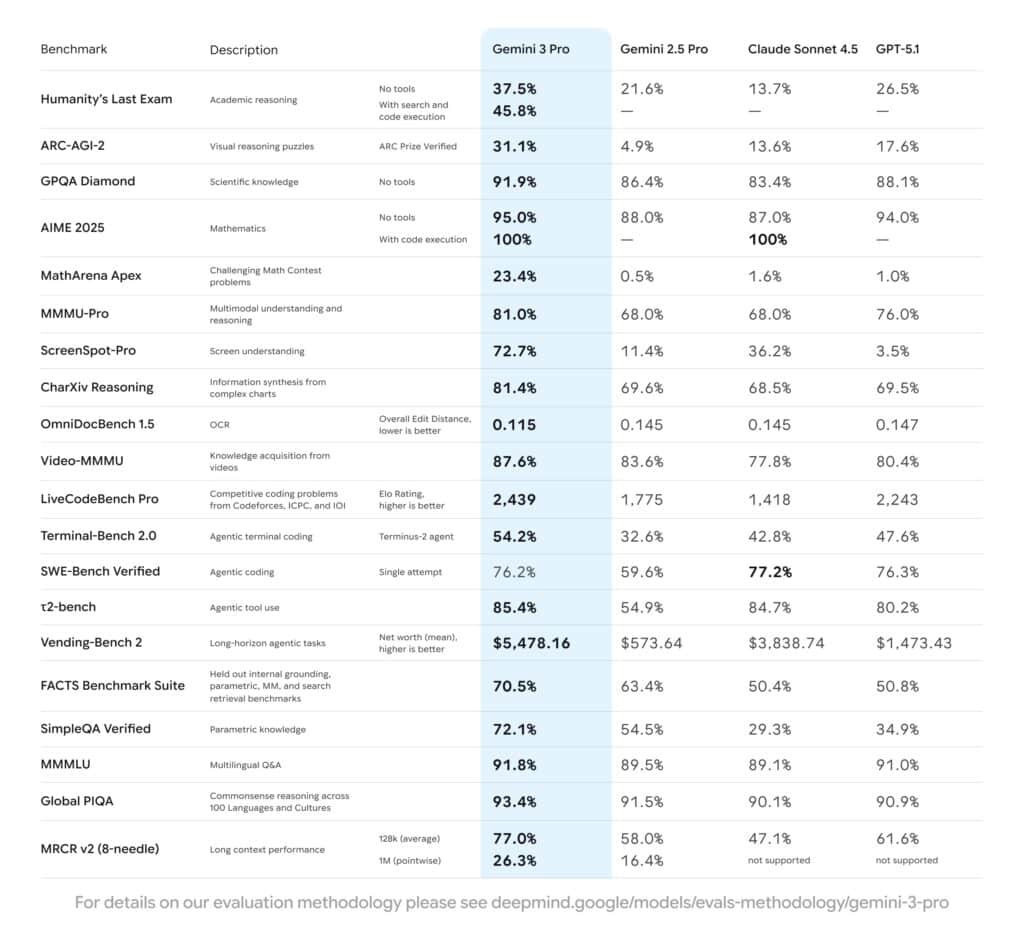

Para cualquiera que siga de cerca la evolución de los modelos de frontera, la tabla de benchmarks de Gemini 3 Pro es el punto más interesante del anuncio. Google ha comparado su modelo con Gemini 2.5 Pro, Claude Sonnet 4.5 y GPT-5.1 en un conjunto de pruebas de razonamiento, multimodalidad, uso de herramientas y planificación.

Razonamiento académico y científico

En tareas de razonamiento duro, Gemini 3 Pro marca diferencias:

- Humanity’s Last Exam (HLE), prueba de razonamiento académico de “nivel doctorado” sin herramientas: 37,5 % de acierto frente a 21,6 % de Gemini 2.5 Pro, 13,7 % de Claude Sonnet 4,5 y 26,5 % de GPT-5.1.

- GPQA Diamond, centrado en conocimiento científico complejo: 91,9 %, mejorando a sus rivales más cercanos.

- ARC-AGI-2, rompecabezas de razonamiento visual verificados por ARC Prize: 31,1 %, bastante por encima del 4,9 % de Gemini 2.5 Pro y del 13–18 % de los otros modelos.

Para matemáticas de competición, la foto es matizada. En MathArena Apex, Gemini 3 Pro alcanza un 23,4 %, frente a cifras inferiores al 2 % en el resto de modelos analizados. Pero en AIME 2025, otro conjunto de problemas matemáticos, el cuadro es más igualado: 95 % sin herramientas, por encima de 88–94 % de sus competidores, y 100 % cuando se permite ejecución de código, empate con Claude Sonnet 4.5.

Multimodalidad avanzada

En razonamiento multimodal, uno de los puntos fuertes históricos de Google, Gemini 3 Pro firma:

- 81,0 % en MMMU-Pro, prueba que mezcla imágenes y texto en múltiples disciplinas, superando a Gemini 2.5 Pro y Claude Sonnet y situándose por encima de GPT-5.1.

- 87,6 % en Video-MMMU, que mide comprensión de información procedente de vídeo, de nuevo con ventaja frente a otros modelos avanzados.

- 72,7 % en ScreenSpot-Pro, comprensión de pantallas y interfaces, con una mejora drástica frente al 11,4 % de Gemini 2.5 Pro.

En tareas de OCR y documentos complejos (OmniDocBench 1.5), el modelo logra una distancia de edición media de 0,115, mejor que el resto de modelos comparados, lo que apunta a una lectura más robusta de PDFs, capturas y documentos escaneados.

Codificación, agentes y uso de herramientas

Donde Gemini 3 Pro intenta diferenciarse claramente es en el terreno agéntico y de codificación:

- LiveCodeBench Pro, que asigna un ELO similar al de competiciones tipo Codeforces o ICPC: Gemini 3 Pro alcanza 2.439 puntos, frente a 2.243 de GPT-5.1 y valores bastante inferiores de los demás.

- Terminal-Bench 2.0, que evalúa el uso de herramientas desde una terminal simulada: 54,2 % de éxito, frente al 32,6 % de Gemini 2.5 Pro y al 42,8–47,6 % de Claude y GPT-5.1.

- t2-bench, centrado en uso agéntico de herramientas: 85,4 %, por encima de sus rivales.

- Vending-Bench 2, planificación a largo plazo en la gestión de un negocio simulado de máquinas expendedoras: un patrimonio medio en torno a 5.478 dólares, muy por encima de los 573 de Gemini 2.5 Pro, los 3.838 de Claude y los 1.473 de GPT-5.1.

En SWE-Bench Verified, una de las referencias clave para evaluar agentes de corrección de código en repositorios reales, la carrera está casi empatada: 76,2 % de Gemini 3 Pro frente a 77,2 % de Claude Sonnet 4.5 y 76,3 % de GPT-5.1. Aquí el salto frente a Gemini 2.5 Pro (59,6 %) es claro, pero no hay un ganador absoluto entre modelos de frontera.

Conocimiento factual, multilingüe y contexto largo

En precisión factual y grounding, el modelo muestra:

- 70,5 % en el FACTS Benchmark Suite, conjunto interno de pruebas que combina grounding, conocimiento paramétrico, multimodalidad y recuperación con búsqueda.

- 72,1 % en SimpleQA Verified, muy por encima de los alrededor de 30–35 % de Claude y GPT-5.1.

En pruebas de sentido común y multilingües:

- 91,8 % en MMLU (multilingual Q&A) y 93,4 % en Global PIQA, por encima de la generación anterior y ligeramente por delante de otros modelos avanzados.

Y, en capacidad de contexto largo:

- 77,0 % en MRCR v2 (8-needle) a 128.000 tokens de contexto medio.

- 26,3 % en MRCR v2 a 1 millón de tokens, frente al 16,4 % de Gemini 2.5 Pro y sin soporte en esa longitud para algunos competidores.

En conjunto, la tabla refuerza la narrativa de Google: Gemini 3 Pro no es solo un salto incremental, sino un intento de ofrecer un modelo equilibrado en razonamiento, multimodalidad y capacidades agénticas, con ciertos puntos donde la competencia mantiene el tipo o incluso lidera.

Deep Think: más pasos de cálculo para los casos realmente difíciles

Para los casos en los que la precisión importa más que la latencia, Google introduce Gemini 3 Deep Think, un modo específico en el que el modelo se permite más pasos internos de razonamiento antes de responder.

En este modo, se reportan mejoras adicionales en pruebas como Humanity’s Last Exam, GPQA Diamond o ARC-AGI, donde llega a un 45,1 % con ejecución de código. Deep Think aún no está disponible de forma general: la compañía lo mantiene bajo evaluación de seguridad y lo liberará primero para suscriptores de Google AI Ultra.

Gemini 3 en productos: buscador, app, cloud y agentes

Más allá de los números, la hoja de ruta de despliegue es agresiva:

- Modo IA en el Buscador: Gemini 3 alimenta nuevas interfaces dinámicas, con layouts visuales generativos, simulaciones y herramientas interactivas construidas “on the fly” según la consulta.

- Aplicación Gemini: los usuarios de Google AI Pro y Ultra empezarán a interactuar con Gemini 3 Pro y, más adelante, con Deep Think y capacidades de agente más avanzadas.

- AI Studio, Vertex AI y Gemini Enterprise: desarrolladores y empresas pueden integrar el modelo vía API y servicios gestionados, con foco en agentes, RAG y automatización de flujos de negocio.

- Google Antigravity: la nueva plataforma de desarrollo centrada en agentes, donde Gemini 3 actúa como motor de planificación, codificación y uso de navegador y terminal.

Antigravity es, probablemente, la pieza más estratégica para el público técnico: convierte la asistencia de IA en algo más cercano a un runtime de agentes que se coordinan para completar tareas de software complejas, con acceso directo al IDE, a la línea de comandos y al navegador para pruebas end-to-end.

Seguridad, alineamiento y el lado menos vistoso del anuncio

Google afirma que Gemini 3 es su modelo más seguro hasta ahora. Ha sido sometido al conjunto de evaluaciones internas más amplio de la compañía y a análisis externos de socios especializados y organismos públicos. Entre las mejoras destacadas figuran:

- Menos respuestas “complacientes” cuando la información es incierta.

- Mayor resistencia a prompt injection y técnicas de jailbreak.

- Protecciones específicas frente a usos maliciosos en ciberataques.

Para un medio tecnológico, el detalle clave es que el modelo ha sido evaluado también bajo el marco de seguridad de modelos de frontera de la propia Google, y que Deep Think no se liberará al público general hasta superar filtros adicionales.

Preguntas frecuentes para perfiles técnicos sobre Gemini 3

¿Qué representan realmente los benchmarks publicados de Gemini 3 Pro?

Los benchmarks cubren varias dimensiones: razonamiento académico (Humanity’s Last Exam, GPQA), matemáticas (AIME 2025, MathArena), multimodalidad (MMMU-Pro, Video-MMMU, ScreenSpot-Pro), precisión factual (FACTS, SimpleQA), codificación y agentes (SWE-Bench, LiveCodeBench, Terminal-Bench, t2-bench, Vending-Bench) y contexto largo (MRCR v2). Son pruebas reconocidas en la comunidad, pero los resultados provienen de evaluaciones realizadas por Google; habrá que contrastarlos con mediciones independientes a medida que terceros tengan acceso al modelo.

¿Cómo se posiciona Gemini 3 en codificación y agentes frente a otros modelos avanzados?

En codificación competitiva y uso de herramientas desde terminal, Gemini 3 Pro figura claramente por delante en la tabla de referencia (ELO de 2.439 en LiveCodeBench Pro y 54,2 % en Terminal-Bench 2.0). En SWE-Bench Verified, la diferencia con Claude Sonnet 4.5 y GPT-5.1 es mínima, lo que sugiere que el terreno de agentes de codificación sigue siendo muy competitivo y aún no hay un ganador absoluto.

¿Qué papel juega Google Antigravity en el ecosistema de Gemini 3?

Antigravity es la capa que convierte a Gemini 3 en algo más que un modelo de texto. Funciona como una plataforma de desarrollo basada en agentes con acceso directo al editor, la terminal y el navegador. Los agentes pueden planificar tareas de software complejas, aplicar cambios en el código, ejecutar pruebas y validar resultados, siempre supervisados por el desarrollador. Para equipos de ingeniería, es la pieza que determinará si Gemini 3 puede realmente aumentar la productividad más allá de la generación puntual de fragmentos de código.

¿Qué deberían vigilar empresas y desarrolladores antes de adoptar Gemini 3 en producción?

Más allá del rendimiento bruto, hay varios puntos críticos: coste por token en distintos modos (Pro y Deep Think), latencia en flujos agénticos, capacidad real de alineamiento con políticas internas y regulación sectorial, y compatibilidad con infraestructuras existentes de observabilidad, seguridad y gobernanza. También será clave observar cómo se comporta el modelo en evaluaciones independientes de robustez, privacidad y seguridad, especialmente en contextos sensibles como finanzas, salud o administración pública.

vía: Gemini 3