En el mercado de la Inteligencia Artificial, la carrera ya no se libra únicamente en quién entrena el mejor modelo, sino en quién consigue la infraestructura capaz de sostenerlo. Y ahí Nvidia vuelve a mover ficha con una propuesta que, por su potencia y por su coste, retrata mejor que ninguna otra el momento que vive el sector: su nuevo rack VR200 NVL72, asociado a la plataforma Vera Rubin, podría situarse en torno a 180 millones de dólares taiwaneses, es decir, unos 5,7–6,0 millones de dólares al cambio, según estimaciones de cadena de suministro en Taiwán.

La cifra, “dolorosa” incluso para estándares corporativos, no ha tardado en levantar cejas. Pero, en paralelo, también ha servido para recordar una regla que se repite en cada ciclo tecnológico: cuando un proveedor dispone de algo que el resto no puede igualar (o no puede entregar a tiempo), el precio deja de ser un número y pasa a ser un instrumento de poder.

Un rack que no se vende como “hardware”, sino como capacidad de cómputo concentrada

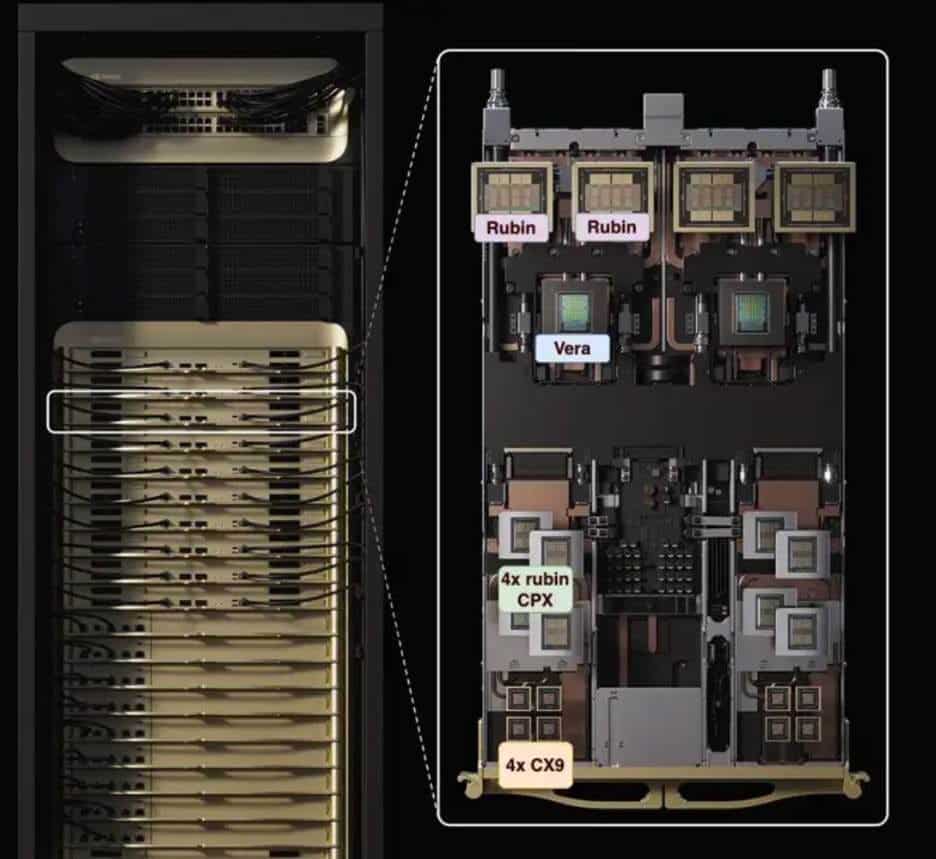

El VR200 NVL72 no es un servidor al uso ni una colección de tarjetas: es un sistema a escala de rack, pensado para desplegarse como unidad de cómputo dentro de grandes clústeres de IA. En la práctica, es la “pieza” que permite construir pods y granjas de entrenamiento e inferencia con una densidad cada vez más extrema.

Según la información técnica disponible, este rack integra 72 GPUs Rubin y 36 CPUs Vera, además de una pila de interconexión y switching diseñada para comportarse como un dominio de aceleración de alto rendimiento. En cifras, el sistema se mueve en un terreno que, hasta hace poco, era casi exclusivo de supercomputación: se habla de 3,6 EFLOPS de inferencia en el formato NVFP4 y de un incremento notable frente a generaciones anteriores.

El salto no es solo de cómputo. También es de memoria y de alimentación. El rack está asociado a HBM4 en volúmenes masivos, y a un diseño que exige refrigeración líquida y una infraestructura eléctrica que, en entornos reales, obliga a redimensionar partes del centro de datos.

De los 2,9 a los 6,0 millones: la escalada de precios en la era “rack-scale”

El precio filtrado del VR200 no aparece en el vacío. El propio mercado ya venía asumiendo que la IA “seria” se paga en millones por rack. En Taiwán se apunta a que el anterior GB200 NVL72 habría rondado los 2,9 millones de dólares, mientras que el GB300 habría escalado hacia los 4,0 millones. Ahora, con un VR200 más complejo, con más integración y mayores exigencias térmicas y eléctricas, el listón se movería hacia los 5,7–6,0 millones.

El dato es relevante por una razón: no habla únicamente del coste del hardware, sino del coste del acceso a la capacidad. En un mercado donde la demanda de cómputo para IA sigue creciendo y la oferta de componentes críticos —memoria HBM, empaquetado avanzado, redes, energía disponible— no siempre acompaña, el precio se convierte en una forma de racionamiento. Quien puede pagar, entra antes en la cola.

El factor “infraestructura”: potencia que obliga a rehacer el centro de datos

La otra cara del VR200 es que no solo se compra un rack: se compra el derecho a reformar el CPD para que ese rack quepa “de verdad”. Los análisis del sector describen que el VR200 NVL72 implica mayores requisitos de potencia, con evoluciones en la arquitectura eléctrica y en la distribución, y con la refrigeración líquida como pilar central del diseño.

En este tipo de sistemas, la cuestión ya no es si el servidor necesita más ventiladores: es si el edificio puede sostener el salto de densidad. En ese contexto, la cifra de varios millones por rack se lee de otra manera: para un gran comprador, la diferencia entre tener capacidad hoy o dentro de seis meses puede valer más que el coste del armario.

“Si tienes algo que otros no tienen, pones el precio”: el poder de fijación en la IA

El comentario que circula en el sector —“si tienes algo que otros no tienen, pones el precio”— resume una dinámica que Nvidia ha sabido explotar. La empresa no solo vende chips; está empujando el mercado hacia soluciones integradas en las que el cliente compra un bloque completo: cómputo, red, memoria, refrigeración, diseño del sistema y validación.

Esa integración tiene un efecto directo: desplaza parte del valor desde el fabricante del servidor o el integrador hacia quien controla el núcleo tecnológico. En términos de negocio, es una forma de capturar más margen y, al mismo tiempo, convertir la oferta en un “producto escaso” con barreras de entrada elevadas.

El VR200 también encaja con otra tendencia: la compra de IA como infraestructura estratégica, no como experimento. En 2026, los clientes que miran racks de 5,7–6,0 millones no suelen ser pymes ni laboratorios modestos; son hiperescalares, grandes plataformas, gobiernos, defensa o empresas que compiten por entrenar modelos de frontera o desplegar inferencia a gran escala.

La pregunta incómoda: ¿cuánta demanda real existe para un rack de 6 millones?

La gran incógnita no es si el VR200 es caro (lo es), sino cuántas unidades puede absorber el mercado de forma sostenida. La cadena de suministro taiwanesa, según las mismas informaciones, maneja estimaciones dispares sobre el volumen de envíos, precisamente porque el salto de precio y de requisitos de infraestructura reduce el universo de compradores.

Aun así, la lógica del sector empuja en una dirección: mientras el cómputo siga siendo el cuello de botella para IA avanzada, los sistemas capaces de multiplicar rendimiento y simplificar despliegues seguirán encontrando demanda. En ese escenario, el VR200 no se vende como un “rack”, sino como tiempo: tiempo para entrenar antes, para servir inferencia con menos latencia, para lanzar productos antes que el competidor.

Y ahí, en la economía real de la IA, el mercado demuestra que hay clientes dispuestos a pagar.

Preguntas frecuentes

¿Cuál es el precio estimado del rack Nvidia VR200 NVL72?

Las estimaciones del sector en Taiwán sitúan el VR200 en torno a 180 millones de dólares taiwaneses, aproximadamente 5,7–6,0 millones de dólares, aunque no se trata de un precio oficial publicado por Nvidia.

¿Qué diferencia al VR200 NVL72 frente a racks anteriores como GB200 o GB300?

La plataforma asociada a Vera Rubin eleva la integración y la potencia del sistema, con 72 GPUs Rubin y 36 CPUs Vera, además de mejoras en interconexión, memoria y diseño para operación a gran escala.

¿Qué requisitos de centro de datos exige un rack de IA como el VR200?

Estos sistemas suelen requerir refrigeración líquida, alta densidad energética y adaptación de la infraestructura eléctrica del CPD. El reto no es solo comprar el rack, sino alimentarlo y enfriarlo de forma estable.

¿Por qué Nvidia puede fijar precios tan altos en infraestructura de IA?

Porque la demanda de cómputo para IA supera a menudo la capacidad disponible y Nvidia mantiene una posición dominante en aceleración y sistemas integrados. Cuando el suministro es limitado y el rendimiento marca ventaja competitiva, el precio se sostiene.

✳️NVIDIA’s new VR200 server rack could be priced around NT$180 million, which translates to approximately USD 5.7 million. It delivers much stronger compute power, but the price is also eye-wateringly high.

— SemiVision👁️👁️ (@semivision_tw) January 28, 2026

That’s just how the market works: if you have something others don’t,… pic.twitter.com/UlSmga2mJ4