CoreWeave ha puesto fecha —al menos por ventana temporal— a su siguiente salto en infraestructura de IA: la compañía ha anunciado que incorporará la plataforma NVIDIA Rubin a su cloud orientado a entrenamiento e inferencia, con la expectativa de estar entre los primeros proveedores en desplegarla en la segunda mitad de 2026. El movimiento no va solo de “tener la GPU nueva”, sino de algo más interesante para un medio técnico: cómo se opera una generación que empuja la complejidad hacia el rack completo, con requisitos de energía, refrigeración y red que ya no se resuelven como si fueran “servidores sueltos”.

La tesis de CoreWeave es clara: a medida que los modelos evolucionan hacia razonamiento y casos de uso agentic (sistemas que planifican, actúan y encadenan tareas), el valor no se mide únicamente en TFLOPs, sino en consistencia operativa, observabilidad y capacidad de poner sistemas en producción sin fricción. En ese contexto, el anuncio viene acompañado de dos piezas que interesan especialmente a administradores de sistemas y equipos de plataforma: CoreWeave Mission Control y un enfoque de orquestación del rack como entidad programable.

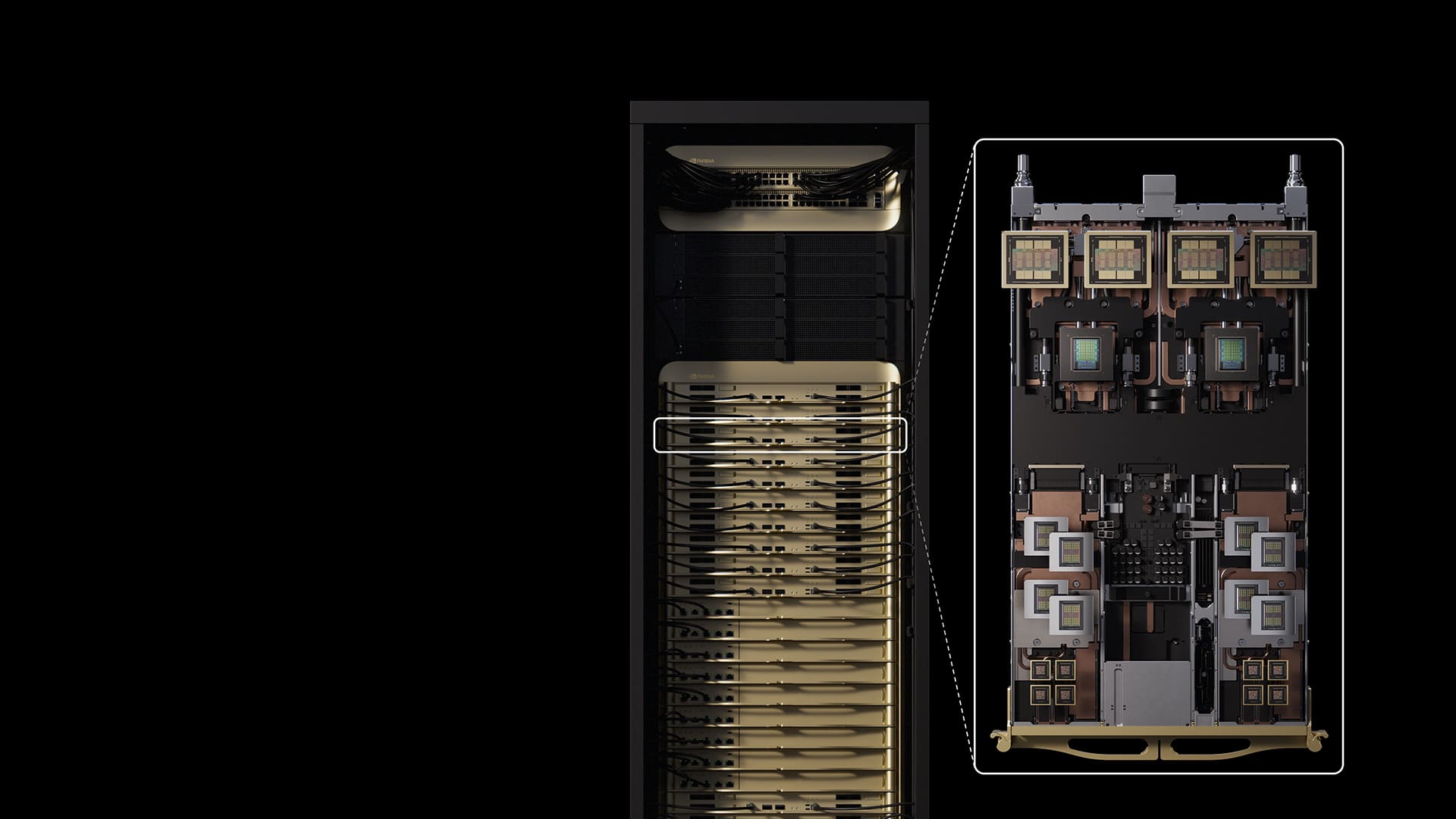

Del “cluster de GPUs” al rack como unidad operativa

En la práctica, los despliegues de IA a gran escala llevan tiempo obligando a replantear el “día 2” (operación): provisión, validación, diagnóstico, mantenimiento, sustitución de componentes, y control fino del estado del hardware antes de aceptar cargas críticas. Lo novedoso del planteamiento de CoreWeave es reconocer explícitamente que, con plataformas como Rubin, el rack completo se convierte en la unidad mínima “real” que hay que gobernar.

Según el anuncio, CoreWeave desplegará Rubin apoyándose en Mission Control, definido como un estándar operativo para entrenamiento, inferencia y cargas agentic, integrando una capa de seguridad, operaciones expertas y observabilidad. Además, la compañía describe un Rack Lifecycle Controller, un orquestador Kubernetes-native que trata un rack NVL72 como un “objeto” programable: coordina provisión, operaciones de energía y validación de hardware para asegurar que el rack está listo antes de ponerlo a servir cargas de cliente.

Para un sysadmin, esta parte importa casi más que el nombre de la GPU: cuando el coste de oportunidad de una hora caída se mide en decenas (o cientos) de GPUs o en colas de entrenamiento, el “¿está sano el sistema?” deja de ser un chequeo puntual y pasa a ser telemetría continua con decisiones automatizadas.

Qué aporta Rubin al tipo de cargas que vienen

CoreWeave posiciona Rubin como plataforma para modelos Mixture-of-Experts y cargas que requieren cómputo sostenido a gran escala, algo coherente con la tendencia actual: modelos más grandes, pero también más complejos en ejecución, con patrones de inferencia que cambian según el tipo de petición, herramientas conectadas o flujos multiagente.

En su comunicación, la compañía también enmarca Rubin como habilitador para sectores de alto consumo de computación (y alta sensibilidad a latencia/fiabilidad), citando ejemplos como descubrimiento de fármacos, investigación genómica, simulación climática o modelado de energía de fusión. Es el tipo de cartera de cargas donde, tradicionalmente, los equipos de plataforma terminaban diseñando “capas paralelas” de observabilidad, métricas y control de cambios. Aquí la idea es empaquetarlo como una norma operativa.

Lo que debería leer un administrador de sistemas entre líneas

Este anuncio sugiere varias implicaciones prácticas:

- Observabilidad “hasta el metal”, pero accionable

CoreWeave menciona diagnósticos y visibilidad en niveles de flota, rack y gabinete, con el objetivo de exponer capacidad “planificable” (schedulable) real. En producción, eso suele traducirse en: menos sorpresas, más capacity planning basado en salud real, y políticas más estrictas sobre qué entra a cola. - Orquestación de infraestructura, no solo de contenedores

Que el controlador del ciclo de vida del rack sea Kubernetes-native apunta a una convergencia: el plano de control de la plataforma (K8s) empieza a rozar decisiones tradicionalmente “fuera” del clúster (power ops, validación HW, readiness). - Infraestructura como producto, no como proyecto

El anuncio insiste en “llevar tecnologías nuevas rápido al mercado” sin perder fiabilidad. En entornos reales, eso exige pipelines de validación, tests de red y rendimiento, y procesos de rollout/rollback parecidos a los de software, pero aplicados al hardware.

Tabla rápida: piezas clave y por qué importan en operación

| Capa / componente | Qué es | Por qué le importa a un sysadmin / SRE |

|---|---|---|

| NVIDIA Rubin (plataforma) | Nueva generación para entrenamiento e inferencia a gran escala | Cambia el perfil de provisión, potencia y red; exige operación más “industrial” |

| NVL72 (rack como unidad) | Rack de alta densidad pensado como bloque | Simplifica capacity units, pero obliga a dominar power/cooling/telemetría por rack |

| Mission Control | Estándar operativo para cargas de IA (train/infer/agentic) | Reduce el bricolaje de “operación por capas” si realmente unifica observabilidad y procesos |

| RAS / diagnósticos integrados | Telemetría y diagnósticos en tiempo real | Permite decisiones automáticas (aislar, drenar, reprovisionar) y mejora el MTTR |

| Rack Lifecycle Controller (Kubernetes-native) | Orquestador para tratar el rack como entidad programable | Acerca la automatización de HW a flujos GitOps/CI/CD y acelera despliegue seguro |

Un detalle estratégico: “Rubin en 2026” como señal al mercado

Más allá de lo técnico, CoreWeave refuerza su narrativa: ser el cloud donde los laboratorios y empresas corren IA “de verdad” cuando la tecnología cambia de generación. En un mercado donde el cuello de botella ya no es solo el silicio sino ponerlo a producir con fiabilidad, la promesa de “primero en desplegar” tiene sentido únicamente si viene acompañada de operación madura. Por eso el anuncio insiste tanto en estándares operativos, observabilidad y control del ciclo de vida del rack.

Preguntas frecuentes

¿Qué significa que Rubin esté orientado a IA “agentic” y razonamiento?

Que la infraestructura se prepara para modelos que no solo responden, sino que encadenan pasos, consultan herramientas y ejecutan acciones, lo que eleva la exigencia en latencia, consistencia y operación continua.

¿Por qué tratar un NVL72 como “una entidad programable” cambia la operación del centro de datos?

Porque el unit of management deja de ser el servidor. Se automatizan provisión, energía y validación por rack, facilitando despliegues repetibles y reduciendo fallos humanos en entornos de alta densidad.

¿Qué gana una empresa usando un cloud que integra estándares operativos (Mission Control) frente a “GPU instances” genéricas?

En teoría, más fiabilidad en producción: mejor observabilidad, diagnósticos más rápidos, y una capacidad realmente “planificable” para cargas críticas (entrenamiento o inferencia) con menos degradaciones inesperadas.

¿Cuándo se espera que CoreWeave despliegue NVIDIA Rubin?

La ventana comunicada es la segunda mitad de 2026, con CoreWeave posicionándose como uno de los primeros proveedores en ponerlo disponible para clientes.