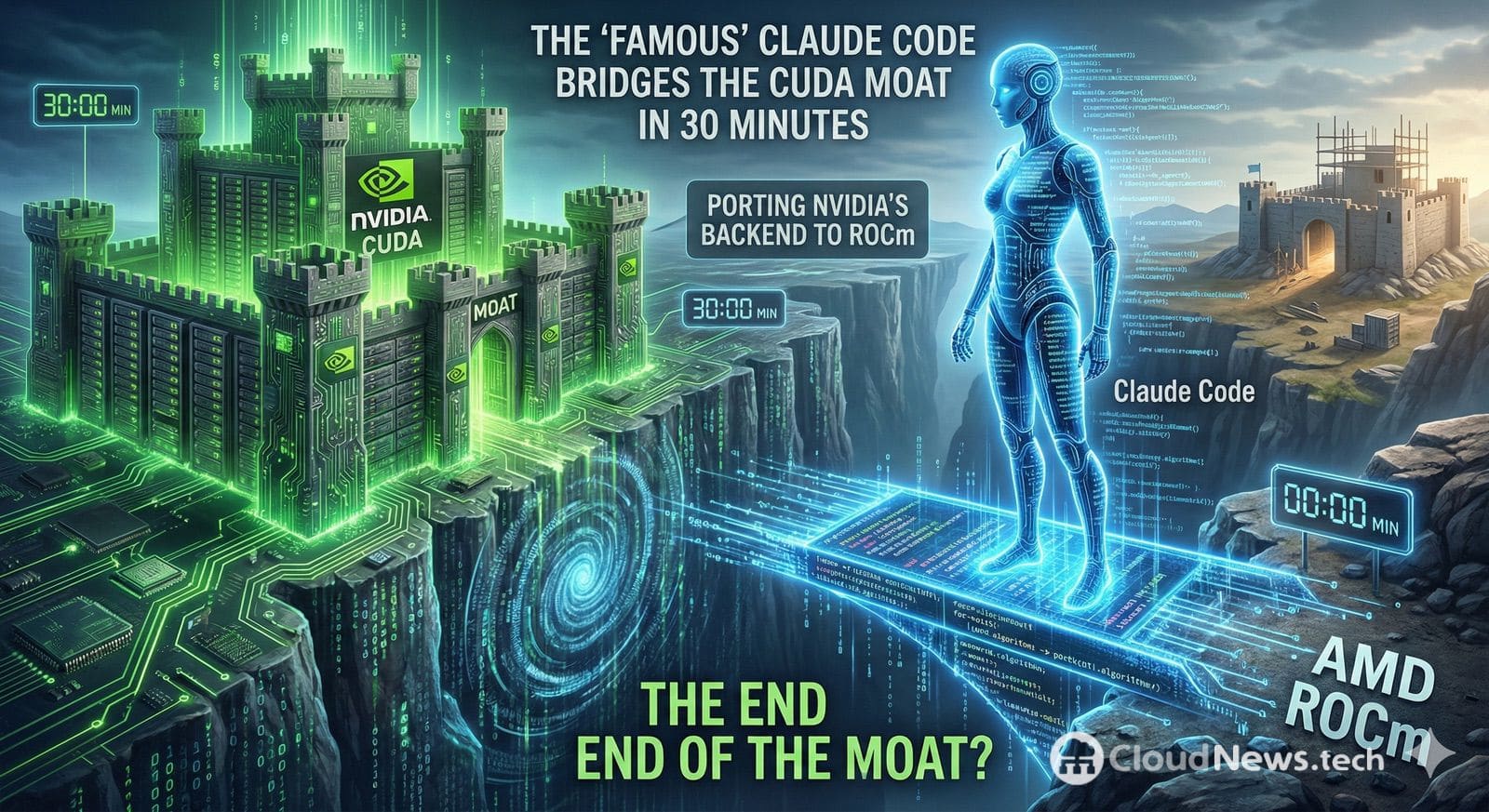

Un hilo en Reddit ha encendido una discusión que llevaba meses cociéndose en la comunidad de GPU: hasta qué punto la “muralla” de CUDA —la combinación de APIs, bibliotecas, tooling y experiencia acumulada alrededor de NVIDIA— sigue siendo una barrera real si las herramientas de programación asistida por agentes empiezan a automatizar el trabajo duro del portado.

El origen del revuelo es una afirmación tan directa como polémica: un usuario asegura haber portado un backend CUDA completo a ROCm en unos 30 minutos utilizando Claude Code, el entorno de codificación agéntica de Anthropic, sin recurrir a capas de traducción “intermedias” tipo wrapper, y con un único escollo relevante: las diferencias de data layout.

Por qué esto importa: ROCm no es nuevo, pero el “coste de salida” sí puede cambiar

AMD lleva años empujando ROCm como plataforma para cómputo acelerado en GPU, y su estrategia de compatibilidad se apoya en HIP, un enfoque que busca que parte del código CUDA sea portable con cambios razonables. De hecho, AMD mantiene herramientas oficiales como HIPIFY para traducir automáticamente código fuente CUDA a HIP C++.

El problema es que, en la práctica, “portar” no suele significar solo compilar: significa mantener la corrección (resultados idénticos), recuperar rendimiento (o minimizar pérdidas), y sustituir dependencias (por ejemplo, bibliotecas específicas de CUDA). Ahí es donde muchas organizaciones chocan con la realidad: el coste no es solo técnico, también es de pruebas, perfiles de rendimiento, regresiones y mantenimiento.

Si una herramienta agéntica reduce drásticamente el tiempo de traducción inicial, el debate se desplaza: ya no es “si se puede portar”, sino “cuánto cuesta validar y optimizar el portado” y “cuántos casos quedan fuera de lo automatizable”.

Lo que se sabe del caso: una afirmación viral y un PR real

En el hilo de Reddit, el usuario vincula su experiencia a un trabajo concreto: un pull request en el repositorio de Leela Chess Zero (lc0) titulado como un “backend ROCm completo”.

Ese detalle es importante porque separa dos planos:

- Plano verificable: existe un PR público que introduce un backend ROCm en un proyecto real.

- Plano discutible: la atribución de “lo hice en 30 minutos con Claude Code” depende del testimonio del autor y del contexto exacto (tamaño del código, complejidad de kernels, cobertura funcional, tests, etc.).

En otras palabras: hay una pieza técnica tangible, pero la conclusión “fin de la muralla de CUDA” es, hoy, más un titular emocional que una demostración universal.

Por qué un agente puede “portar rápido”… y por qué eso no liquida CUDA

Las herramientas agénticas encajan especialmente bien en tareas de transformación mecánica:

- Mapear llamadas CUDA comunes a equivalentes en HIP/ROCm cuando existen.

- Renombrar tipos, macros y utilidades.

- Reestructurar ficheros, CMake y flags de compilación.

- Hacer refactors sistemáticos que antes requerían horas de trabajo repetitivo.

Esa lógica se alinea con lo que AMD formaliza en HIP/HIPIFY: automatizar el tramo más “editorial” del portado.

Y Claude Code, como entorno diseñado para trabajar con repositorios y tareas de desarrollo, se presenta precisamente como una herramienta para ejecutar cambios extensos con ayuda de un agente.

Sin embargo, el “moat” de CUDA no se reduce a nombres de funciones. Donde se rompe la promesa del “portado en minutos” es en el trabajo que no es puramente sintáctico:

- Optimización específica de hardware

Los kernels de alto rendimiento están íntimamente ligados a jerarquías de caché, patrones de acceso, ocupación, sincronización y micro-decisiones que no siempre se trasladan de forma equivalente entre arquitecturas. - Diferencias semánticas y de ejecución

Incluso cuando dos plataformas “se parecen”, pequeñas diferencias en comportamiento o supuestos pueden generar bugs sutiles que solo aparecen bajo carga, con tamaños concretos o en escenarios de concurrencia. - Dependencias de ecosistema

CUDA no es solo el runtime: son bibliotecas, perfiles, herramientas, documentación, ejemplos y una base instalada enorme. Portar un proyecto serio suele implicar sustituir o revalidar piezas auxiliares. - Validación y mantenimiento

El coste real aparece después: CI, pruebas de rendimiento, tolerancias numéricas, regresiones, y la pregunta empresarial: “¿quién mantiene esta rama portable cuando el upstream evolucione?”.

El impacto real: menos barrera de entrada, pero no “fin del lock-in”

Lo que sí cambia —si estos casos se multiplican— es la psicología del mercado:

- Para equipos que se plantean multi-vendor GPU, bajar el coste inicial del portado reduce el miedo a quedar atrapados.

- Para AMD y su ecosistema, cada historia de “migración rápida” es marketing orgánico y presión competitiva.

- Para NVIDIA, el riesgo no es que CUDA desaparezca, sino que parte del mercado empiece a tratar CUDA como un target más, no como “el único camino razonable”.

Aun así, el término “fin de la muralla” es prematuro. La muralla no es solo técnica; es también de formación, tooling maduro, bibliotecas dominantes, soporte y disponibilidad de talento.

El contexto más amplio: la industria lleva meses buscando grietas

Este episodio llega en un momento en que proliferan iniciativas (con distintos enfoques) para reducir dependencia: desde capas de compatibilidad hasta proyectos comunitarios que persiguen ejecutar o adaptar workloads CUDA fuera de NVIDIA. Un ejemplo recurrente en el debate es ZLUDA, un proyecto orientado a compatibilidad CUDA en entornos no NVIDIA.

La diferencia ahora es el “factor agente”: si un modelo puede encargarse del trabajo repetitivo y el humano se centra en validación y optimización, la ecuación de costes cambia.

Preguntas frecuentes

¿Qué es ROCm y en qué se diferencia de CUDA?

ROCm es la plataforma de AMD para computación en GPU, con un stack de compilación y runtime propio. CUDA es el stack propietario de NVIDIA. AMD promueve HIP como vía para escribir código más portable entre GPUs, mientras CUDA está optimizado para el ecosistema NVIDIA.

¿HIPIFY permite portar CUDA “automáticamente”?

HIPIFY traduce parte del código fuente CUDA a HIP C++ de forma automatizada, útil para acelerar el arranque de una migración. No garantiza por sí solo equivalencia funcional completa ni rendimiento idéntico: esos pasos dependen de pruebas y optimización.

¿Claude Code puede sustituir a HIPIFY o a un equipo de ingeniería?

Puede acelerar tareas repetitivas (refactors masivos, cambios de API, ajustes de build), pero en proyectos complejos el trabajo crítico sigue siendo validación, depuración y tuning de rendimiento. Además, la calidad del resultado depende del contexto, tests disponibles y revisión humana.

¿Qué debería hacer una empresa si quiere reducir dependencia de CUDA?

Normalmente: identificar componentes “portables” (kernels propios), separar dependencias de bibliotecas, construir una batería de tests y benchmarks, y tratar el portado como un proyecto de ingeniería con KPIs (correctitud y rendimiento). Las herramientas automáticas pueden recortar tiempo, pero no sustituyen la gobernanza técnica.