Amazon Web Services (AWS) ha puesto en marcha Project Rainier, un macroclúster de computación para inteligencia artificial que ya está operativo menos de un año después de anunciarse. La instalación integra casi 500.000 chips Trainium2 —procesadores diseñados por la propia Amazon para entrenar modelos de IA— y se ha construido en varios centros de datos en EE. UU. conectados como si fuesen un solo superordenador.

Su primer gran usuario es Anthropic, creador de Claude. La compañía ya está ejecutando cargas reales en Rainier y planea superar el millón de chips Trainium2 dedicados a entrenamiento e inferencia antes de que termine 2025. Según AWS, el nuevo clúster proporciona más de 5 veces la potencia de cálculo que Anthropic empleó para entrenar sus modelos previos.

¿Qué significa montar medio millón de chips de IA?

Para entender la escala: un solo Trainium2 puede realizar billones de operaciones por segundo sobre los cálculos matriciales (tensores) que demandan los grandes modelos. Project Rainier no junta unos pocos, sino centenares de miles y los orquesta como una única “máquina lógica” para entrenar modelos más grandes, más rápido y con secuencias de entrada más largas.

¿Cómo está construido?

- UltraServers: cada unidad agrupa 4 servidores físicos, y cada servidor integra 16 chips Trainium2. En total, 64 chips por UltraServer.

- NeuronLink (cables azules): enlaces de alta velocidad que conectan los 64 chips dentro del UltraServer como si fueran un único bloque de cómputo, reduciendo latencias internas.

- EFA (cables amarillos): tecnología de red Elastic Fabric Adapter que une miles de UltraServers entre sí y a través de varios edificios, formando un UltraCluster que se comporta como un superordenador distribuido.

Este diseño en dos niveles de comunicación —rápido dentro de cada “caja” y flexible entre “cajas”— permite escalar sin que el tráfico se convierta en el cuello de botella.

¿Para qué servirá toda esta potencia?

Entrenar y desplegar las próximas generaciones de modelos de Claude, con más parámetros, más contexto y más tareas a la vez. A grandes rasgos, cuanta más computación dediques a un modelo de frontera, más puede aprender y mejorar su precisión. Con Rainier, Anthropic puede:

- Probar arquitecturas y tamaños que antes eran inviables.

- Acelerar ciclos de entrenamiento (menos meses por versión).

- Escalar la inferencia (responder a más usuarios con modelos más grandes).

Por qué importa (aunque no seas ingeniero)

- Modelos más capaces: asistentes que entienden contextos más largos (documentos enteros), razonan mejor y se adaptan a tareas complejas.

- Innovación transversal: desde medicina hasta energía o cambio climático, más cálculo implica simulaciones y análisis que antes no eran posibles.

- Competencia y costes: al fabricar sus propios chips (Trainium2) e integrar todo el stack, AWS busca abaratar y controlar el coste por entrenamiento, a la vez que compite con las opciones tradicionales del mercado.

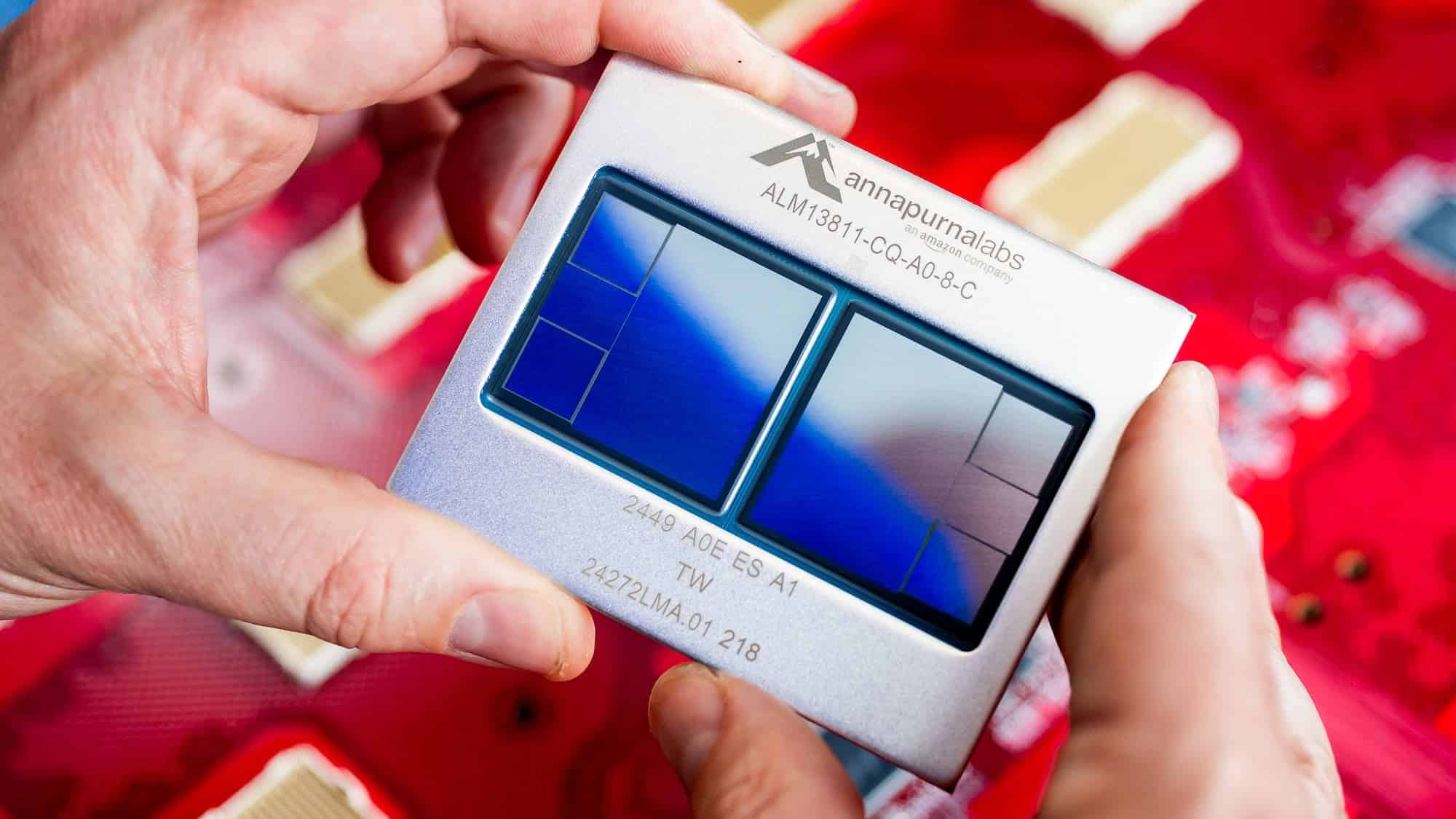

¿Qué es Trainium2? (explicado simple)

- Es un chip especializado en IA, diseñado por AWS para multiplicar el rendimiento en operaciones de matrices y tensores.

- Usa memoria HBM3 de altísimo ancho de banda, para que los datos lleguen a los núcleos sin cuellos de botella.

- No sustituye a tu CPU o GPU de uso general; es un motor específico para entrenar y ejecutar grandes modelos de IA en la nube.

Control del “palo a la rueda”: fiabilidad a esa escala

Mover datos y coordinar decenas de miles de servidores plantea desafíos de fiabilidad. AWS insiste en que su integración vertical —diseña desde el chip, pasando por el sistema, hasta el centro de datos— le permite optimizar y diagnosticar en todos los niveles:

- Ajustes en entrega de energía y refrigeración.

- Cambios en el software de orquestación para exprimir el hardware.

- Diseños de rack y red a medida para reducir latencias y fallos.

El objetivo: que toda esa capacidad esté disponible para clientes reales y no se pierda en tiempos muertos o cuellos de botella.

Energía y agua: la otra cara del “hiperescala”

La pregunta inevitable: ¿y el consumo? AWS asegura que en 2023 y 2024 igualó el 100 % de su consumo eléctrico con energías renovables y que mantiene su hoja de ruta para ser cero emisiones netas en 2040.

En uso de agua, cita una WUE (Water Usage Effectiveness) de 0,15 litros por kWh, más de dos veces mejor que la media del sector (0,375 L/kWh, según el Laboratorio Nacional Lawrence Berkeley) y un 40 % mejor que en 2021.

Además, la compañía está invirtiendo en energía nuclear, almacenamiento en baterías y proyectos renovables a gran escala, y rediseñando componentes de centro de datos (alimentación, refrigeración por aire, materiales de menor huella) para reducir consumo mecánico y carbono incorporado. En climas fríos o templados, parte del año los centros no usan agua para enfriar, recurriendo a free cooling con aire exterior.

Traducción práctica: montar un “Rainier” exige mucha energía y buen diseño térmico. Amazon defiende que está compensando con renovables y técnicas de eficiencia para contener el impacto mientras escala.

¿Qué cambia para los usuarios?

A corto plazo, no verás un botón “Rainier” en tu móvil. Lo que sí notarás (progresivamente) es que los modelos de IA mejoran: respuestas más útiles, contextos más largos (resúmenes de informes enteros, hilos de correo extensos, código grande), traducciones más finas y menor latencia incluso con modelos más pesados.

Para empresas y desarrolladores que usan AWS, la llegada de Rainier significa más opciones para entrenar y desplegar modelos propios o de terceros con potencia y coste más predecibles, apoyándose en Trainium2 además de las GPUs habituales.

En una mirada

- Rainier ya está activo: ~500.000 chips Trainium2 en varios centros de datos conectados como un UltraCluster.

- Anthropic escala Claude hasta >1.000.000 de chips de aquí a finales de 2025 (entrenamiento e inferencia).

- Arquitectura: UltraServers (64 chips por nodo) con NeuronLink (intra-nodo) y EFA (entre nodos/edificios).

- Objetivo: >5× computación respecto a generaciones previas, para acelerar entrenamientos y probar modelos gigantes.

- Sostenibilidad: WUE 0,15 L/kWh, 100 % de electricidad igualada con renovables (2023–2024) y plan de cero neto 2040.

Lo que queda por ver

- Ritmo real de adopción: cuánta de esta capacidad se llena con trabajo productivo y con qué eficiencia de coste.

- Competencia: cómo responden otros hyperscalers y fabricantes de chips de IA.

- Transparencia ambiental: evolución anual de intensidad de carbono y uso de agua por región y tipo de carga.

- Impacto en la investigación abierta: si parte de esta potencia se destina a ciencia, salud o clima más allá de los modelos comerciales.

Conclusión: Project Rainier es, para AWS, algo más que un logro de ingeniería: es una apuesta por dictar el ritmo de la carrera de la IA desde su propia pila tecnológica. Para el público, no es un producto que se descarga, pero sí el “motor invisible” que hará posibles modelos más capaces y aplicaciones que hoy todavía nos parecen ciencia ficción.

vía: Amazon