Amazon ha dejado claro en AWS re:Invent 2025 que no piensa quedarse atrás en la guerra del hardware para inteligencia artificial. La compañía ha presentado sus nuevos servidores Trainium3 UltraServers y ha adelantado detalles de la próxima generación Trainium4, dos apuestas que refuerzan su estrategia: depender cada vez menos de GPUs de terceros y construir una plataforma propia de cómputo para modelos de IA a escala masiva.

Trainium3 UltraServers: hasta 144 chips y 4,4 veces más rendimiento

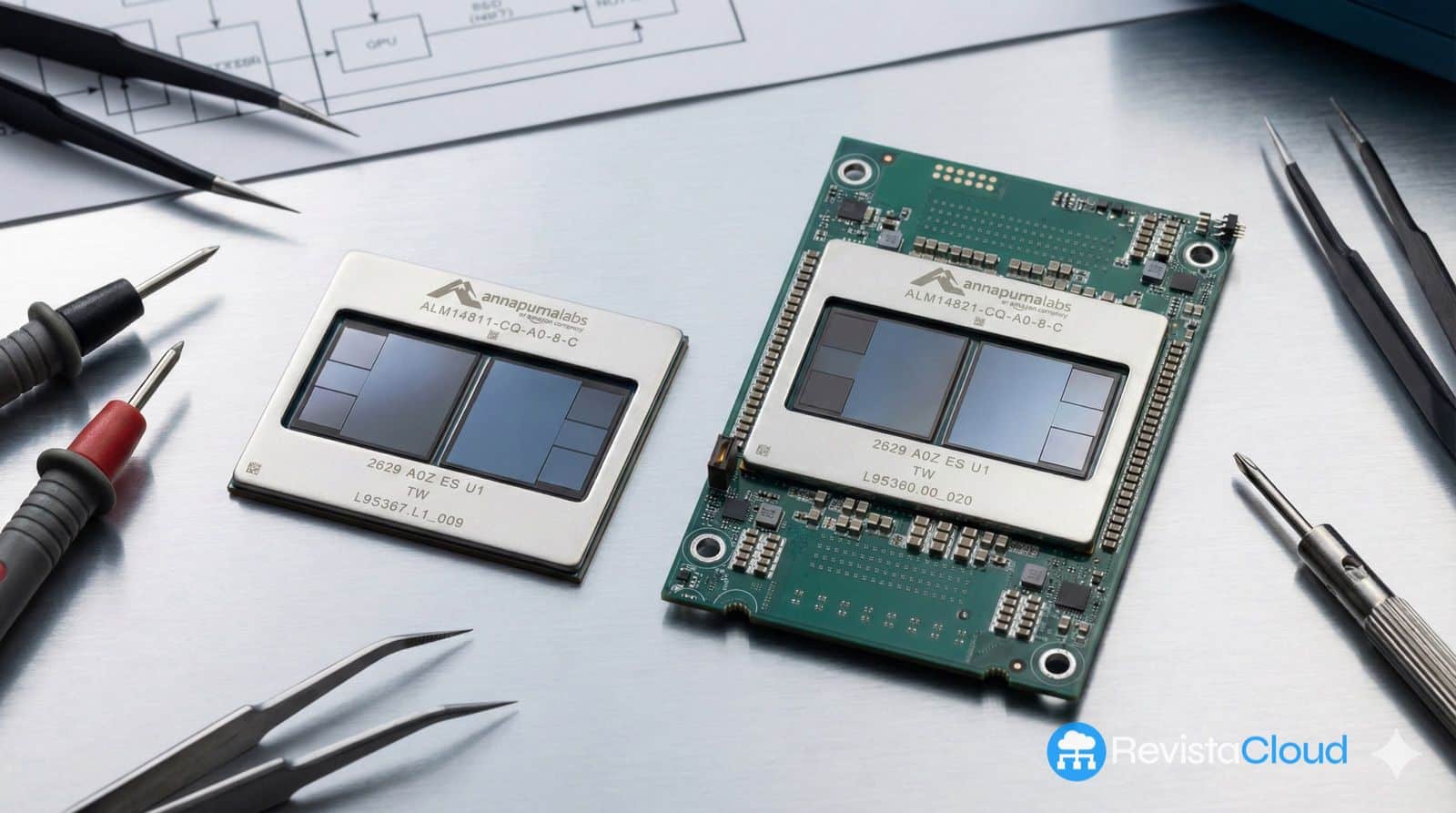

La gran novedad comercial son los Amazon EC2 Trn3 UltraServers, sistemas integrados que empaquetan hasta 144 chips Trainium3 en un único “super-servidor” pensado específicamente para entrenar y ejecutar modelos de IA de gran tamaño. Según AWS, estos UltraServers ofrecen:

- Hasta 4,4 veces más rendimiento de cálculo que la generación anterior (Trainium2 UltraServers).

- Aproximadamente 4 veces más eficiencia energética.

- Casi 4 veces más ancho de banda de memoria, clave para mover datos de manera masiva sin crear cuellos de botella.

En términos prácticos, esto significa reducir entrenamientos que duraban meses a unas pocas semanas, servir muchas más peticiones de inferencia con la misma infraestructura y, sobre todo, bajar el coste por consulta para servicios como chatbots, agentes de IA o generación de vídeo e imagen en tiempo real.

AWS habla de hasta 362 PFLOPS en FP8 por sistema cuando se exprime la configuración completa de Trainium3, una cifra que sitúa a estos racks entre la liga de la supercomputación más avanzada, pero empaquetada como un servicio en la nube.

Redes a medida: NeuronSwitch-v1 y UltraClusters 3.0

El chip es solo la mitad de la historia. El gran reto en IA ya no es solo “tener muchos FLOPS”, sino conectar miles de chips sin que la red se convierta en el cuello de botella.

Para eso, Amazon ha diseñado una infraestructura de red específica:

- NeuronSwitch-v1, un nuevo conmutador que duplica el ancho de banda interno dentro de cada UltraServer.

- Un tejido de red Neuron Fabric mejorado que baja la latencia de comunicación entre chips a menos de 10 microsegundos, una cifra crítica para entrenamientos distribuidos de modelos gigantes.

Además, los EC2 UltraClusters 3.0 permiten encadenar miles de estos UltraServers hasta alcanzar clusters de hasta 1 millón de chips Trainium, diez veces más que la generación anterior. Sobre ese tipo de infraestructura se sitúan los llamados “frontier models”, modelos fundacionales multimodales con billones de parámetros y datasets de billones de tokens, que solo unas pocas empresas del mundo pueden entrenar.

Resultados reales: menos coste y más velocidad

Amazon no se ha quedado en las diapositivas. Empresas como Anthropic, Karakuri, Metagenomi, NetoAI, Ricoh o Splash Music ya están utilizando Trainium para entrenar y ejecutar sus modelos, con ahorros de hasta un 50 % en costes frente a alternativas basadas en GPU, según AWS.

Un caso llamativo es el de Decart, un laboratorio centrado en vídeo generativo en tiempo real, que afirma lograr 4 veces más velocidad de inferencia a la mitad de coste en generación de vídeo respecto a soluciones basadas en GPU tradicionales. Eso abre la puerta a aplicaciones hasta ahora prohibitivas: experiencias interactivas en vivo, simulaciones en tiempo real o asistentes gráficos que respondan sin latencia perceptible.

La propia Amazon Bedrock, la plataforma gestionada de modelos fundacionales de AWS, ya está sirviendo cargas de producción sobre Trainium3, lo que indica que el chip no es un experimento de laboratorio, sino una pieza central de la oferta comercial de la compañía.

Mirando al futuro: Trainium4 y la alianza con NVIDIA

Lejos de conformarse con Trainium3, Amazon ha adelantado su hoja de ruta con Trainium4, la próxima generación de ASIC de IA:

- Al menos 6 veces más rendimiento en FP4 (formato de precisión ultrabaja pensado para inferencia masiva).

- 3 veces más rendimiento en FP8, el formato que se está consolidando como estándar para entrenar grandes modelos equilibrando precisión y eficiencia.

- 4 veces más ancho de banda de memoria, para alimentar modelos aún más grandes sin estrangular el chip.

Lo más interesante es que Trainium4 se integrará con NVIDIA NVLink Fusion y con racks MGX compatibles, lo que permitirá combinar servidores con GPU NVIDIA y servidores Trainium dentro de la misma infraestructura de alta velocidad. Es decir, no se trata de “o NVIDIA, o Trainium”, sino de un entorno heterogéneo donde cada chip se use para lo que mejor sabe hacer.

La apuesta estratégica de Amazon: menos dependencia, más control

El movimiento de Amazon hay que leerlo en el contexto de una carrera en la que Google (TPU), Microsoft, Meta y otras grandes tecnológicas compiten por diseñar sus propios chips de IA para reducir dependencia de terceros, controlar mejor costes y adaptar el hardware a sus casos de uso más críticos.

Con Trainium3, los UltraServers y la hoja de ruta de Trainium4, AWS manda varios mensajes claros:

- “Silicon-first”: la infraestructura de IA de la próxima década se definirá tanto por el software como por el silicio.

- Democratización relativa: aunque estos sistemas sigan estando solo al alcance de grandes empresas y proveedores cloud, el hecho de ofrecerlos como servicio EC2 permite a más compañías trabajar con capacidades que antes quedaban reservadas a un puñado de gigantes.

- Optimización total: ya no basta con tener muchos chips; hay que exprimir cada vatio y cada bit de ancho de banda para que los costes no se disparen con cada nuevo modelo de IA.

¿Qué significa para empresas y desarrolladores?

Para la mayoría de empresas, todo esto se traduce en algo muy concreto:

- Entrenamientos más rápidos: pasar de meses a semanas permite iterar más, probar más modelos y llegar antes al mercado.

- Inferencia más barata: si el coste por petición baja, se pueden desplegar asistentes, agentes y servicios de IA a más usuarios sin que la factura explote.

- Más opciones de arquitectura: combinar Trainium con GPUs NVIDIA en la misma red de alta velocidad permite diseñar infraestructuras híbridas muy ajustadas a cada caso (entrenar en una plataforma, inferir en otra, etc.).

- Menos lock-in “de facto” de la GPU clásica: cuantas más alternativas reales existan para entrenar e inferir, más margen habrá para negociar precios y arquitecturas.

No es una revolución inmediata para el usuario final, pero sí una pieza clave del “lado invisible” de la IA: el hardware de los centros de datos que hace posible que un chatbot responda en segundos, que un vídeo se genere en tiempo real o que un agente inteligente tome decisiones en milisegundos.

En la carrera por el cómputo de IA, Amazon acaba de dejar claro que va en serio. Y si algo demuestra Trainium3 con sus UltraServers y el agresivo diseño de Trainium4 es que la próxima batalla no será solo por el mejor modelo, sino por quién tiene la infraestructura más rápida, eficiente y flexible para ejecutarlo a escala planetaria.

Preguntas frecuentes sobre Trainium3 y Trainium4 de Amazon

¿Qué es exactamente un Trainium3 UltraServer de AWS?

Es un sistema integrado de AWS que agrupa hasta 144 chips Trainium3 en un único servidor lógico, diseñado específicamente para entrenar y ejecutar modelos de IA de gran tamaño. Ofrece hasta 4,4 veces más rendimiento de cómputo y 4 veces más eficiencia energética que la generación anterior (Trainium2 UltraServers).

¿En qué se diferencia Trainium de las GPUs tradicionales para IA?

Trainium es un ASIC (chip de propósito específico) optimizado para operaciones típicas de IA, mientras que las GPUs son procesadores más generales. En teoría, Trainium puede ofrecer mejor rendimiento por vatio y menor coste por token entrenado o inferido, a costa de ser menos versátil para otros tipos de cargas de trabajo.

¿Pueden las empresas usar Trainium si ya tienen infraestructura con GPU NVIDIA?

Sí. AWS ya permite combinar instancias con GPU y con Trainium, y con Trainium4 está trabajando en compatibilidad con NVLink Fusion y racks MGX de NVIDIA, lo que facilitará aún más integrar ambos mundos en una misma arquitectura de alto rendimiento.

¿Es relevante Trainium para pymes o solo para grandes tecnológicas?

El diseño está claramente orientado a modelos muy grandes y cargas masivas, pero al ofrecerlo como servicio en AWS, cualquier empresa o startup puede acceder a esta infraestructura bajo demanda. Lo relevante es que reduce la barrera de entrada a capacidades de cómputo que antes solo estaban al alcance de quienes podían construir su propio superordenador de IA.

vía: About Amazon