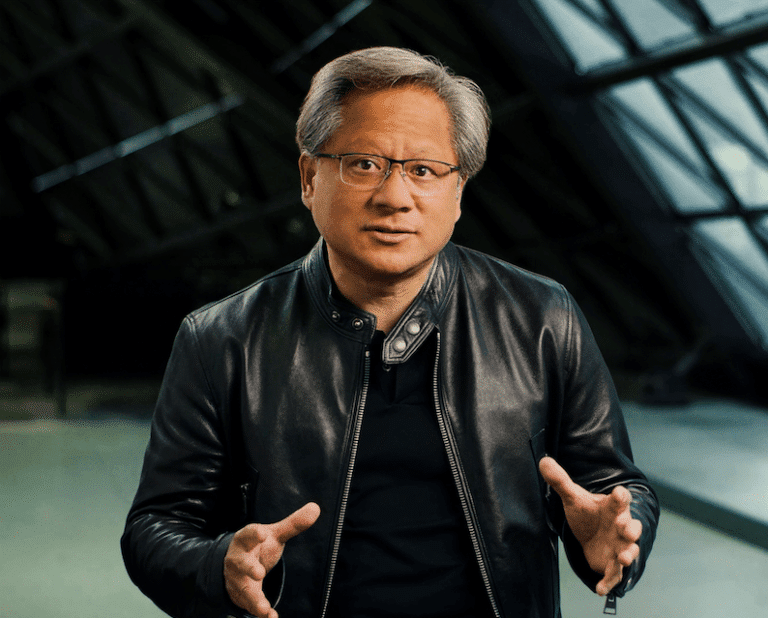

Jensen Huang podría cobrar un bonus de 4 millones si Nvidia cumple objetivos

Nvidia ha aprobado un bonus en efectivo de 4 millones de dólares para su consejero delegado, Jensen Huang, dentro de su plan de retribución variable para el ejercicio fiscal 2027. No se trata de un pago automático ni de un aumento directo de sueldo, sino de un incentivo condicionado a que la compañía alcance determinadas metas financieras antes del 31 de enero de 2027. La cifra ha llamado la atención por una razón evidente: afecta al fundador y máximo responsable de una de las empresas más valiosas del mundo. Sin embargo, más allá del titular, el movimiento encaja bastante bien en la lógica de Wall Street y de las grandes tecnológicas cotizadas. Nvidia no está regalando una prima extraordinaria a