Durante años, el debate sobre la refrigeración en centros de datos se resolvía con un mantra sencillo: si el aire aguanta, no toques nada. Pero 2025 ha cambiado el guion. La expansión de la Inteligencia Artificial —con GPUs y aceleradores cada vez más densos— ha empujado a muchos operadores a un punto incómodo: el calor ya no es un problema técnico aislado, sino un factor que condiciona capacidad, plazos de entrega y, en última instancia, la rentabilidad.

La tendencia se explica por una suma de presiones. Por un lado, la demanda eléctrica de los centros de datos sigue creciendo y los reguladores europeos han empezado a exigir más transparencia, obligando a reportar indicadores y prácticas energéticas en instalaciones a partir de cierto umbral de potencia. Por otro, la carrera por desplegar infraestructura de IA multiplica la densidad térmica dentro de los racks, elevando el listón de lo que la refrigeración por aire puede sostener con garantías.

Consolidación: cuando el mercado decide comprar know-how en vez de inventarlo desde cero

En este nuevo contexto, 2025 también ha sido un año de compras. La refrigeración líquida ha pasado de ser un “complemento” a un eje estratégico, y eso se ha notado en la actividad corporativa. Uno de los movimientos más representativos ha sido el acuerdo de Eaton para adquirir el negocio Boyd Thermal por 9.500 millones de dólares, con el objetivo explícito de reforzar su cartera de refrigeración líquida para centros de datos. En paralelo, otras operaciones y adquisiciones en el sector apuntan a la misma idea: quien controle la cadena de potencia y refrigeración, tendrá ventaja en el despliegue de IA a gran escala.

La lógica es fácil de entender: el mercado se está llenando de soluciones parecidas, muchas nacidas como nicho, y la consolidación permite a los grandes actores integrar producto, soporte global, fabricación y capacidad de entrega. En un entorno donde los clientes piden plazos y garantías, la escala vuelve a importar.

De los kilovatios a los megavatios: la era de los CDUs “de verdad”

El síntoma más visible de esta madurez técnica es el salto de capacidad en los CDU (cooling distribution units), las unidades que distribuyen el refrigerante en arquitecturas de liquid cooling. En 2025 han empezado a normalizarse CDUs preparados para 2 MW, y el listón ya ha subido más: Schneider Electric y Motivair presentaron un CDU capaz de gestionar 2,5 MW, mientras que Flex y JetCool mostraron un enfoque modular que puede “coserse” para llegar a 1,8 MW. Incluso operadores como Switch han defendido sistemas híbridos (aire + líquido) con capacidad equivalente, vistos ya en producción.

Este cambio no es cosmético. Hablar de megavatios en un CDU es reconocer que el cuello de botella ya no está solo en cuántos servidores caben en una sala, sino en cuánta potencia térmica se puede extraer de forma estable, segura y operable. En otras palabras: el mercado está diseñando la refrigeración para soportar racks y pods de IA que, hace poco, parecían ciencia ficción.

Estándares abiertos: Google pone el listón y el sector copia la receta

La otra gran señal de “industrialización” llega con los estándares. En 2025, Google ha empujado el concepto de especificaciones abiertas al poner a disposición de la comunidad de Open Compute Project (OCP) los detalles de su diseño interno de CDU, Project Deschutes. Ese gesto importa porque reduce fricción: si el sector converge en arquitecturas de referencia, fabricantes, integradores y operadores pueden desplegar más rápido y con menos riesgo.

Y Google no solo ha hablado de planos: en el OCP Europe Summit (Dublín), la compañía detalló el alcance de sus despliegues de refrigeración líquida, indicando que alrededor de la mitad de su huella global ya tiene liquid cooling habilitado y/o desplegado, con cerca de 1 GW de capacidad repartida en 2.000 pods basados en sus TPUs, y con un objetivo de disponibilidad del 99,999 %.

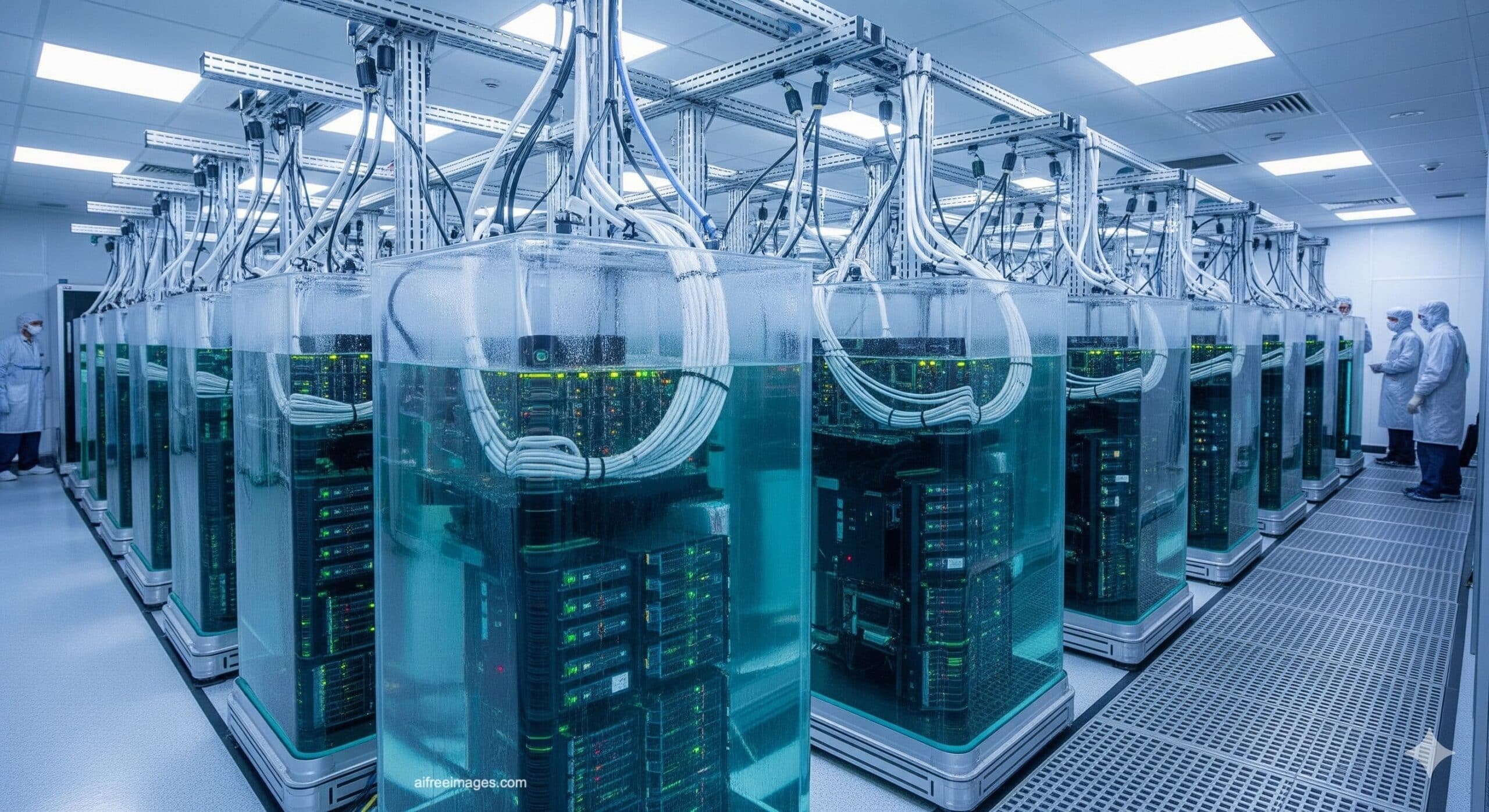

Inmersión, microcanales y “baterías de hielo”: la innovación se abre en abanico

Aunque el direct-to-chip (líquido a placa fría) se ha convertido en el camino más adoptado, la refrigeración por inmersión sigue ganando espacio como alternativa. En 2025, Submer firmó un memorando de entendimiento con el gobierno de Madhya Pradesh para desarrollar hasta 1 GW de centros de datos de IA refrigerados por líquido, mientras otros actores han presentado pods de inmersión y acuerdos de desarrollo de nuevas plataformas.

En paralelo, han surgido enfoques aún más radicales. Microsoft y la startup suiza Corintis han trabajado en refrigeración microfluídica “dentro del chip”, haciendo circular el refrigerante por canales microscópicos grabados en el silicio. Según lo comunicado y recogido por distintos medios, esta aproximación puede mejorar la extracción de calor frente a placas frías convencionales, y Corintis ha captado financiación para acelerar el despliegue industrial.

La eficiencia energética también ha inspirado soluciones menos visibles, pero potencialmente decisivas para la operación: desde “baterías de hielo” (almacenamiento térmico) para desplazar consumo de refrigeración a horas valle —con proveedores defendiendo que pueden hacer flexible hasta un 40 % de la carga pico— hasta tecnologías para reutilizar calor residual.

Calor residual: de promesa de marketing a exigencia social (y regulatoria)

La reutilización del calor se está convirtiendo en un tema incómodo para quien no lo tenga resuelto. Comunidades locales y administraciones presionan para que el excedente térmico no se pierda, y la UE ha activado esquemas de reporte y métricas que, en la práctica, empujan a profesionalizar la conversación: medir, comparar, justificar y —cuando sea viable— reutilizar. Proyectos anunciados en 2025 incluyen pilotos de district heating en Alemania, acuerdos para calentar instalaciones industriales y planes para aprovechar el calor de supercomputadores para calefactar decenas de edificios.

En este panorama, la refrigeración deja de ser una línea en el presupuesto de facilities para convertirse en una pieza central del negocio digital: determina cuánta IA se puede desplegar, a qué velocidad, con qué consumo, y bajo qué nivel de aceptación social y política.

Preguntas frecuentes

¿Qué es un CDU y por qué se habla de CDUs de 2 MW en centros de datos de IA?

Un CDU (Cooling Distribution Unit) distribuye el refrigerante hacia racks o pods. La referencia a 2 MW refleja el salto de densidad térmica: se necesita infraestructura capaz de mover y controlar grandes caudales de refrigeración para cargas de IA a gran escala.

¿Cuándo deja de ser suficiente la refrigeración por aire en un centro de datos?

Cuando la densidad por rack y la concentración de aceleradores hacen que el aire no pueda extraer calor con estabilidad o eficiencia. En esos escenarios, el líquido ofrece mejor transferencia térmica y permite escalar potencia sin disparar el riesgo operativo.

¿Qué diferencias prácticas hay entre refrigeración líquida direct-to-chip e inmersión?

Direct-to-chip enfría componentes concretos mediante placas frías y circuito de líquido; inmersión sumerge servidores en un fluido dieléctrico. La primera suele integrarse más fácilmente con diseños estándar; la segunda puede ofrecer ventajas en densidades extremas, pero exige cambios operativos y de cadena de suministro.

¿Por qué la reutilización de calor residual está ganando importancia en Europa?

Porque aumenta la presión social y regulatoria para justificar el impacto energético de los centros de datos. Reutilizar calor (por ejemplo, en redes de calefacción urbana o procesos industriales) mejora eficiencia global y puede facilitar licencias y aceptación local.